Solr5.5高级应用(基于tomcat9)

一.配置solr

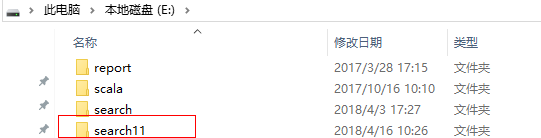

1.配置

注意:要是想放到其它路径下,可以修改此路径下的web.xml配置文件

修改内容如下:

<!-- 将solrhome的绝对路径写入env-entry-value -->

<env-entry>

<env-entry-name>solr/home</env-entry-name>

<!--例如:E:/search11/solr/server/solr-->

<env-entry-value>你的core的上级路径</env-entry-value>

<env-entry-type>java.lang.String</env-entry-type>

</env-entry>

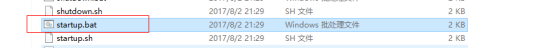

2.点击tomcat的bin目录下的startup.bat启动

3.在浏览器上输入http://你的ip:8080/solr/index.html#/ 查看

4.选择test-core,执行查看

二.配置HanLP分词器

1. 配置配置文件

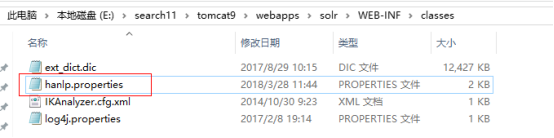

从下载的HanLP中获取hanlp.properties配置文件,放置到下面的路径中。

2. 导入HanLP词典

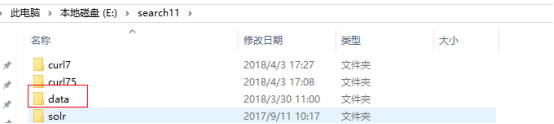

从下载的HanLP中拷贝data到下图目录下,该data包含Hanlp中提供的词库和模型。

3. 导入jar包

把HanLP中的hanlp-1.5.0.jar和hanlp-1.5.0.sources.jar放到tomcat的该目录下

4. 修改hanlp.properties中的,改成data的上级目录

一、配置HanLP分词器

1.配置分词器

在使用该分词器的core中的managed-schema文件中添加

<fieldType name="text_cn" class="solr.TextField">

<analyzer type="index">

<tokenizer class="com.hankcs.lucene.HanLPTokenizerFactory"

enableIndexMode="true" enablePlaceRecognize="true" enableOrganizationRecognize="true" customDictionaryPath="E:\search11\data\dictionary\custom\自定义词典.txt"/>

<filter class="solr.StopFilterFactory" ignoreCase="true" words="stopwords.txt" />

<filter class="solr.LowerCaseFilterFactory"/>

</analyzer>

<analyzer type="query">

<!-- 切记不要在query中开启index模式 -->

<tokenizer class="com.hankcs.lucene.HanLPTokenizerFactory"

enableIndexMode="false" enablePlaceRecognize="true" enableOrganizationRecognize="true" customDictionaryPath="E:\search11\data\dictionary\custom\自定义词典.txt"/>

<filter class="solr.StopFilterFactory" ignoreCase="true" words="stopwords.txt" />

<filter class="solr.SynonymFilterFactory" synonyms="synonyms.txt"

ignoreCase="true" expand="true"/>

<filter class="solr.LowerCaseFilterFactory"/>

</analyzer>

</fieldType>

2.修改使用该分词器的字段

3.结果

三.配置Tika文档提取器

1. 首先在core中添加tika文档搜索

<requestHandler name="/update/extract" class="org.apache.solr.handler.extraction.ExtractingRequestHandler" startup="lazy">

<lst name="defaults">

<!-- All the main content goes into "text"... if you need to return

the extracted text or do highlighting, use a stored field. -->

<str name="fmap.content">text</str>

<str name="lowernames">false</str>

<str name="uprefix">ignored_</str>

<!-- capture link hrefs but ignore div attributes -->

</lst>

</requestHandler>

2. 配置tika解析文档的分类字段

<!-- Tika字段 -->

<field name="PK" type="string" indexed="true" stored="true" required="true" multiValued="false"/>

<field name="BT" type="string" indexed="true" stored="true" termVectors="true" multiValued="false"/>

<field name="ZZ" type="string" indexed="true" stored="true" multiValued="true"/>

<field name="NR" type="text_cn" indexed="true" stored="true" termVectors="true" termPositions="true" termOffsets="true"/>

<field name="CJSJ" type="date" indexed="true" stored="true" />

3. 修改tomcat的server.xml配置

<Connector port="8080" protocol="HTTP/1.1"

connectionTimeout="20000"

redirectPort="8443"

maxHttpHeaderSize ="104857600" maxPostSize="0" />

注意:

maxHttpHeaderSize :设置最大上传头大小

maxPostSize:解除post提交大小限制

4. 结果

四.配置HTML及相关样式过滤器

<fieldType name="text_general" class="solr.TextField" positionIncrementGap="100">

<analyzer type="index">

<tokenizer class="solr.StandardTokenizerFactory"/>

<!-- 清除\n样式 -->

<charFilter class="solr.MappingCharFilterFactory"

mapping="mapping-FoldToASCII.txt"/>

<charFilter class="solr.HTMLStripCharFilterFactory"/><!-- 清除HTML样式 -->

<filter class="solr.StopFilterFactory" ignoreCase="true" words="stopwords.txt" />

<filter class="solr.LowerCaseFilterFactory"/>

</analyzer>

<analyzer type="query">

<tokenizer class="solr.StandardTokenizerFactory"/>

<charFilter class="solr.HTMLStripCharFilterFactory"/><!-- 清除HTML样式 -->

<filter class="solr.StopFilterFactory" ignoreCase="true" words="stopwords.txt" />

<filter class="solr.SynonymFilterFactory" synonyms="synonyms.txt"

ignoreCase="true" expand="true"/>

<filter class="solr.LowerCaseFilterFactory"/>

</analyzer>

</fieldType>

五.配置MLT文档相识度搜索

1.添加配置

<!-- Solr More like this 文件相似度搜索用到此配置 -->

<requestHandler name="/mlt" class="solr.MoreLikeThisHandler">

<lst name="defaults">

<!-- wt即writer type,即返回的数据的MIME类型,如json,xml等等 -->

<str name="wt">json</str>

<str name="fl">

ZSYBS,ZSYWT,ZSYDA,ZSBS,XH,ZSDZT,CZRBS,ZZBM,DQBM,FJFZBS,

SCJBS,ZSYWB,YXQ,YDHS,GDMB,ZSLX,CZSJ,CJSJ</str><!-- 需要返回的字段 -->

<str name="mlt.qf"> <!-- 设置 mlt.fl中的各个字段的权重 -->

ZSYWT^2.0 ZSYWB^1.0

</str>

<str name="mlt.fl">ZSYWT,ZSYWB</str><!-- 指定用于判断是否相似的字段 -->

<str name="mlt.match.include">true</str>

<!-- 指定最小的分词频率,小于此频率的分词将不会被计算在内 -->

<str name="mlt.mintf">1</str>

<!-- 指定最小的文档频率,分词所在文档的个数小于此值的话将会被忽略 -->

<str name="mlt.mindf">1</str>

<!-- 指定分词的最小长度,小于此长度的单词将被忽略。 -->

<str name="mlt.minwl">2</str>

<!-- 默认值5. 设置返回的相似的文档数 -->

<int name="mlt.count">10</int>

<str name="df">ZSYBS</str>

<str name="q.op">AND</str>

</lst>

</requestHandler>

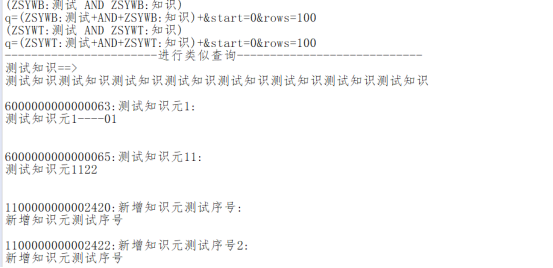

2.测试结果

六.配置SolrJ高亮展示

1. 高亮的默认配置

<!-- Highlighting defaults -->

<str name="hl">on</str>

<str name="hl.fl">content features title name</str>

<str name="hl.preserveMulti">true</str>

<str name="hl.encoder">html</str>

<str name="hl.simple.pre"><b></str>

<str name="hl.simple.post"></b></str>

<str name="f.title.hl.fragsize">0</str>

<str name="f.title.hl.alternateField">title</str>

<str name="f.name.hl.fragsize">0</str>

<str name="f.name.hl.alternateField">name</str>

<str name="f.content.hl.snippets">3</str>

<str name="f.content.hl.fragsize">200</str>

<str name="f.content.hl.alternateField">content</str>

<str name="f.content.hl.maxAlternateFieldLength">750</str>

2. 启用高亮

SolrQuery solrQuery = new SolrQuery();

solrQuery.setQuery("ZSYWT:交易电价"); //设置查询关键字

solrQuery.setHighlight(true); //开启高亮

solrQuery.addHighlightField("ZSYWT"); //高亮字段

solrQuery.addHighlightField("ZSYWB"); //高亮字段

solrQuery.setHighlightSimplePre("<font color='red'>"); //高亮单词的前缀

solrQuery.setHighlightSimplePost("</font>"); //高亮单词的后缀

solrQuery.setParam("hl.fl", "ZSYWT");

七.配置搜索关键词自动补全(汉字,拼音)

添加配置

<searchComponent name="suggest" class="solr.SuggestComponent">

<lst name="suggester">

<str name="name">mySuggester</str>

<str name="lookupImpl">FuzzyLookupFactory</str>

<str name="dictionaryImpl">DocumentDictionaryFactory</str>

<str name="field">ZSYWT_PINYIN</str><!--匹配字段,可以使用copyField实现多列-->

<!--权重,用于排序-->

<!--<str name="weightField">ZSYWB</str>-->

<str name="suggestAnalyzerFieldType">text_cn</str>

</lst>

</searchComponent>

<requestHandler name="/suggest" class="solr.SearchHandler" startup="lazy">

<lst name="defaults">

<str name="suggest">true</str>

<str name="suggest.build">true</str>

<str name="suggest.dictionary">mySuggester</str><!--与上面保持一致-->

<str name="suggest.count">10</str>

</lst>

<arr name="components">

<str>suggest</str>

</arr>

</requestHandler>

2.设置搜索字段

<!-- 设置自动补全 -->

<field name="ZSYWT_PINYIN" type="text_cn" indexed="true"

stored="true" multiValued="true"/>

<copyField source="PINYIN" dest="ZSYWT_PINYIN"/>

<copyField source="ZSYWT" dest="ZSYWT_PINYIN"/>

3.测试结果

八.搜索关键词自动纠错

代码实现:

public Collection<List<String>> getAutomaticErrorCorrection(String content)

throws SolrServerException, IOException {

HttpSolrServer server = new HttpSolrServer(url);

SolrQuery params = new SolrQuery();

params.set("qt", "/suggest");

//全部转换为拼音

StringBuilder sb = new StringBuilder();

char[] array = content.toCharArray();

for(int j=0;j<array.length;j++){

if(isChineseByBlockStyle(array[j])){

List<Pinyin> pinyinMidList = HanLP.convertToPinyinList(""+array[j]);

for (Pinyin pinyin : pinyinMidList)

{

sb.append(pinyin.getPinyinWithoutTone());

}

}else{

sb.append(array[j]);

}

}

params.setQuery(sb.toString());

QueryResponse response = null;

response = server.query(params);

SuggesterResponse suggest = response.getSuggesterResponse();

Collection<List<String>> collection = suggest.getSuggestedTerms().values();

server.close();

return collection;

}

Solr5.5高级应用(基于tomcat9)的更多相关文章

- ASP.NET MVC 随想录——探索ASP.NET Identity 身份验证和基于角色的授权,中级篇

在前一篇文章中,我介绍了ASP.NET Identity 基本API的运用并创建了若干用户账号.那么在本篇文章中,我将继续ASP.NET Identity 之旅,向您展示如何运用ASP.NET Ide ...

- ASP.NET Identity 身份验证和基于角色的授权

ASP.NET Identity 身份验证和基于角色的授权 阅读目录 探索身份验证与授权 使用ASP.NET Identity 身份验证 使用角色进行授权 初始化数据,Seeding 数据库 小结 在 ...

- Azure 标准与高级托管磁盘存储的相互转换

托管磁盘提供两种存储选项:高级(基于 SSD)和标准(基于 HDD). 它允许基于性能需求在这两个选项之间轻松切换,并保障最短停机时间. 非托管磁盘不具备此功能. 但可以轻松转换为托管磁盘,以便在这两 ...

- Apache Spark 2.2中基于成本的优化器(CBO)(转载)

Apache Spark 2.2最近引入了高级的基于成本的优化器框架用于收集并均衡不同的列数据的统计工作 (例如., 基(cardinality).唯一值的数量.空值.最大最小值.平均/最大长度,等等 ...

- ip route rule 路由策略 高级路由 捆绑 网桥

http://lwfs.net/2005/11/28/10/ #!/bin/bash IP0= IP1= GW0= GW1= NET0= NET1= DEV0=eth0 DEV1=eth1 # com ...

- OpenGL的学习资源

OpenGL是3D图形接口工业标准,使用上非常简单,所有API不过上百个函数,但理解OpenGL就没那么简单,本文总结OpenGL的学习资源,包括官方资料.网上教程.示例程序等. Wikipedia: ...

- Python学习手册(1入门知识-数据类型)

UNIX env查找技巧 在一些UNIX系统上,可以用这样一种方法避免硬编码Python解释器的路径,在文件的特定的第一行注释中写上这样一句话. #! usr/bin/env/ python...sc ...

- Android开发工具之Dash

作为一名死coder,每天最常见的动作就是查看各种API文档,你一定也有过同时打开N个窗口(HTML.PDF.CHM),不停的在编辑器与文档之间切换的感受吧?怎么说呢,其实我很讨厌这种枯燥无味的动作, ...

- Dash

作为一名死coder,每天最常见的动作就是查看各种API文档,你一定也有过同时打开N个窗口(HTML.PDF.CHM),不停的在编辑器与文档之间切换的感受吧?怎么说呢,其实我很讨厌这种枯燥无味的动作, ...

随机推荐

- 导入项目的时候报错Error:Could not find com.android.support.constraint:constraint-layout:1.0.0-alpha7

问题描述 今天在导入项目的时候报错: Error:Could not find com.android.support.constraint:constraint-layout:1.0.0-alpha ...

- 搭建企业级PPTP服务器

本文收录在企业项目实战系列 一.VPN 介绍 1.介绍 虚拟私人网络(英语:Virtual Private Network,缩写为VPN)是一种常用于连接中.大型企业或团体与团体间的私人网络的通讯方法 ...

- 【Vue.js】vue项目目录作用

1. build文件夹:打包配置的文件夹 1.1 webpack.base.conf.js :打包的核心配置 1.2 build.js:构建生产版本,项目开发完成之后,通过build.js打包(加 ...

- Java反射,注解,以及动态代理

Java反射,注解,以及动态代理 基础 最近在准备实习面试,被学长问到了Java反射,注解和动态代理的内容,发现有点自己有点懵,这几天查了很多资料,就来说下自己的理解吧[如有错误,望指正] Java ...

- HTTP协议学习(一)

一.HTTP报文的组成 请求报文由 请求行.请求头.请求空行.请求实体四部分组成.其中,请求行和请求头共同组成 请求报文头部 请求行:一行,依次由 请求方法.URI(或者应该说是域名?).HTTP协议 ...

- Go 包依赖管理工具 —— govendor

govendor 是一个基于 vendor 机制实现的 Go 包依赖管理命令行工具.与原生 vendor 无侵入性融合,也支持从其他依赖管理工具迁移,可以很方便的实现同一个包在不同项目中不同版本.以及 ...

- java当中的强引用,软引用,弱引用,虚引用

强引用,软引用,弱引用,虚引用:不同的引用类型主要体现在GC上 强引用:如果一个对象具有强引用,它就不会被垃圾回收器回收.即使当前内存空间不足,JVM也不会回收它,而是抛出 OutOfMemoryEr ...

- shell编程基础(五): 正则表达式及其使用

正则表达式 1.前情提要 以前我们用grep在一个文件中找出包含某些字符串的行,比如在头文件中找出一个宏定义.其实grep还可以找出符合某个模式(Pattern)的一类字符串.例如找出所有符合xxxx ...

- Spring Boot搭建Web项目常用功能

搭建WEB项目过程中,哪些点需要注意: 1.技术选型: 前端:freemarker.vue 后端:spring boot.spring mvc 2.如何包装返回统一结构结果数据? 首先要弄清楚为什么要 ...

- SQL Server 本地数据库登录不上 解决方法

sql本地数据库登录不了的话.先看看自己计算机 服务 SQL server (MSSQLSERVER) 没有打开的话,请打开. 今天说的情景模式是 你误删了windows登录:禁用了sa登录:s ...