自动化运维之SaltStack实践

自动化运维之SaltStack实践

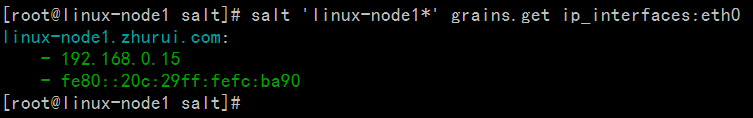

| linux-node1(master服务端) | 192.168.0.15 |

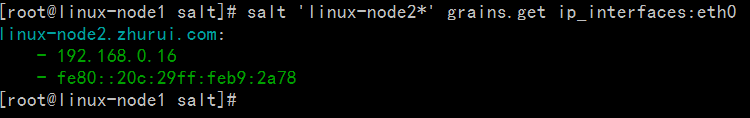

| linux-node2(minion客户端) | 192.168.0.16 |

| Local | 本地 |

| Master/Minion | 传统运行方式(server端跟agent端) |

| Salt SSH | SSH |

[root@linux-node1 yum.repos.d]# ping linux-node1.zhurui.comPING linux-node1.zhurui.com (192.168.0.15)56(84) bytes of data.64 bytes from linux-node1.zhurui.com (192.168.0.15): icmp_seq=1 ttl=64 time=0.087 ms64 bytes from linux-node1.zhurui.com (192.168.0.15): icmp_seq=2 ttl=64 time=0.060 ms64 bytes from linux-node1.zhurui.com (192.168.0.15): icmp_seq=3 ttl=64 time=0.053 ms64 bytes from linux-node1.zhurui.com (192.168.0.15): icmp_seq=4 ttl=64 time=0.060 ms64 bytes from linux-node1.zhurui.com (192.168.0.15): icmp_seq=5 ttl=64 time=0.053 ms64 bytes from linux-node1.zhurui.com (192.168.0.15): icmp_seq=6 ttl=64 time=0.052 ms64 bytes from linux-node1.zhurui.com (192.168.0.15): icmp_seq=7 ttl=64 time=0.214 ms64 bytes from linux-node1.zhurui.com (192.168.0.15): icmp_seq=8 ttl=64 time=0.061 ms

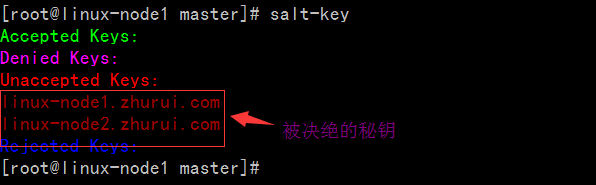

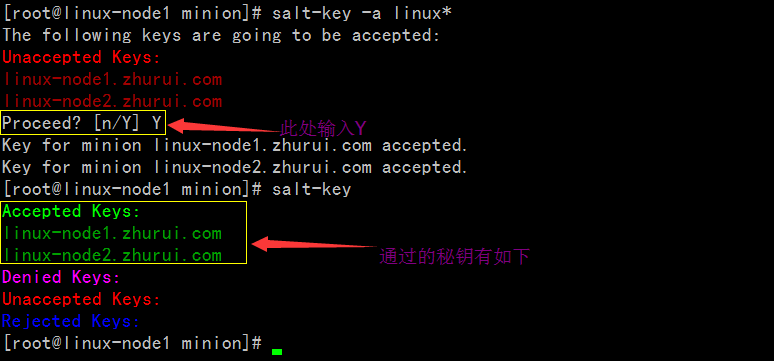

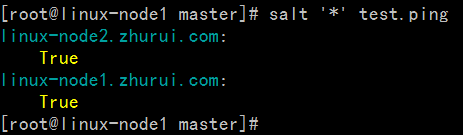

[root@linux-node1 minion]# salt-key -a linux*The following keys are going to be accepted:UnacceptedKeys:linux-node1.zhurui.comlinux-node2.zhurui.comProceed?[n/Y] YKeyfor minion linux-node1.zhurui.com accepted.Keyfor minion linux-node2.zhurui.com accepted.[root@linux-node1 minion]# salt-keyAcceptedKeys:linux-node1.zhurui.comlinux-node2.zhurui.comDeniedKeys:UnacceptedKeys:RejectedKeys:

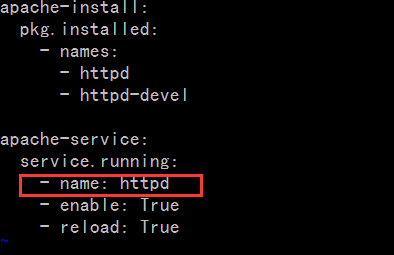

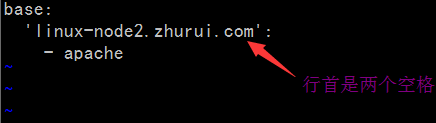

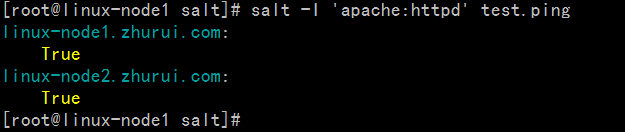

[root@linux-node1 salt]# salt '*' state.sls apachelinux-node2.zhurui.com:----------ID: apache-installFunction: pkg.installedName: httpdResult:TrueComment:Package httpd is already installed.Started:22:38:52.954973Duration:1102.909 msChanges:----------ID: apache-installFunction: pkg.installedName: httpd-develResult:TrueComment:Package httpd-devel is already installed.Started:22:38:54.058190Duration:0.629 msChanges:----------ID: apache-serviceFunction: service.runningName: httpdResult:TrueComment:Service httpd has been enabled, and is runningStarted:22:38:54.059569Duration:1630.938 msChanges:----------httpd:TrueSummary------------Succeeded:3(changed=1)Failed:0------------Total states run:3linux-node1.zhurui.com:----------ID: apache-installFunction: pkg.installedName: httpdResult:TrueComment:Package httpd is already installed.Started:05:01:17.491217Duration:1305.282 msChanges:----------ID: apache-installFunction: pkg.installedName: httpd-develResult:TrueComment:Package httpd-devel is already installed.Started:05:01:18.796746Duration:0.64 msChanges:----------ID: apache-serviceFunction: service.runningName: httpdResult:TrueComment:Service httpd has been enabled, and is runningStarted:05:01:18.798131Duration:1719.618 msChanges:----------httpd:TrueSummary------------Succeeded:3(changed=1)Failed:0------------Total states run:3[root@linux-node1 salt]#

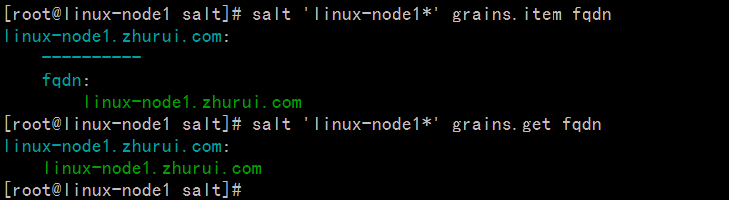

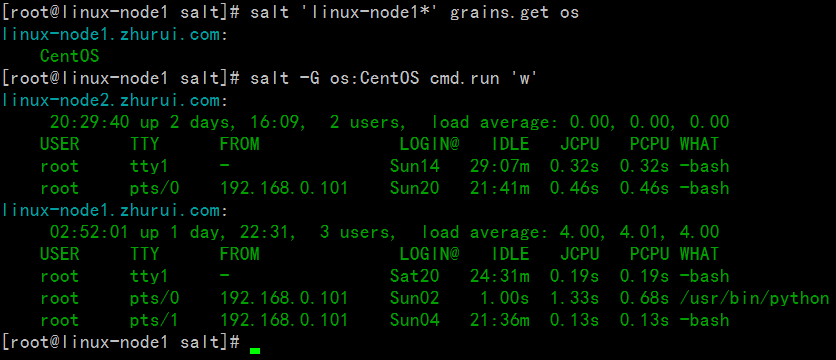

[root@linux-node1 salt]# salt 'linux-node1*' grains.lslinux-node1.zhurui.com:-SSDs- biosreleasedate- biosversion- cpu_flags- cpu_model- cpuarch- domain- fqdn- fqdn_ip4- fqdn_ip6- gpus- host- hwaddr_interfaces- id- init- ip4_interfaces- ip6_interfaces- ip_interfaces- ipv4- ipv6- kernel- kernelrelease- locale_info- localhost- lsb_distrib_codename- lsb_distrib_id- lsb_distrib_release- machine_id- manufacturer- master- mdadm- mem_total- nodename- num_cpus- num_gpus- os- os_family- osarch- oscodename- osfinger- osfullname- osmajorrelease- osrelease- osrelease_info- path- productname- ps- pythonexecutable- pythonpath- pythonversion- saltpath- saltversion- saltversioninfo- selinux- serialnumber- server_id- shell- virtual- zmqversion[root@linux-node1 salt]#

[root@linux-node1 salt]# salt 'linux-node1*' grains.itemslinux-node1.zhurui.com:----------SSDs:biosreleasedate:07/31/2013biosversion:6.00cpu_flags:- fpu- vme- de- pse- tsc- msr- pae- mce- cx8- apic- sep- mtrr- pge- mca- cmov- pat- pse36- clflush- dts- mmx- fxsr- sse- sse2- ss- syscall- nx- rdtscp- lm- constant_tsc- up- arch_perfmon- pebs- bts- xtopology- tsc_reliable- nonstop_tsc- aperfmperf- unfair_spinlock- pni- ssse3- cx16- sse4_1- sse4_2- x2apic- popcnt- hypervisor- lahf_lm- arat- dtscpu_model:Intel(R)Core(TM) i3 CPU M 380@2.53GHzcpuarch:x86_64domain:zhurui.comfqdn:linux-node1.zhurui.comfqdn_ip4:-192.168.0.15fqdn_ip6:gpus:|_----------model:SVGA II Adaptervendor:unknownhost:linux-node1hwaddr_interfaces:----------eth0:00:0c:29:fc:ba:90lo:00:00:00:00:00:00id:linux-node1.zhurui.cominit:upstartip4_interfaces:----------eth0:-192.168.0.15lo:-127.0.0.1ip6_interfaces:----------eth0:- fe80::20c:29ff:fefc:ba90lo:-::1ip_interfaces:----------eth0:-192.168.0.15- fe80::20c:29ff:fefc:ba90lo:-127.0.0.1-::1ipv4:-127.0.0.1-192.168.0.15ipv6:-::1- fe80::20c:29ff:fefc:ba90kernel:Linuxkernelrelease:2.6.32-573.el6.x86_64locale_info:----------defaultencoding:UTF8defaultlanguage:en_USdetectedencoding:UTF-8localhost:linux-node1.zhurui.comlsb_distrib_codename:Finallsb_distrib_id:CentOSlsb_distrib_release:6.7machine_id:da5383e82ce4b8d8a76b5a3e00000010manufacturer:VMware,Inc.master:192.168.0.15mdadm:mem_total:556nodename:linux-node1.zhurui.comnum_cpus:1num_gpus:1os:CentOSos_family:RedHatosarch:x86_64oscodename:Finalosfinger:CentOS-6osfullname:CentOSosmajorrelease:6osrelease:6.7osrelease_info:-6-7path:/sbin:/usr/sbin:/bin:/usr/binproductname:VMwareVirtualPlatformps:ps -efHpythonexecutable:/usr/bin/python2.6pythonpath:-/usr/bin-/usr/lib64/python26.zip-/usr/lib64/python2.6-/usr/lib64/python2.6/plat-linux2-/usr/lib64/python2.6/lib-tk-/usr/lib64/python2.6/lib-old-/usr/lib64/python2.6/lib-dynload-/usr/lib64/python2.6/site-packages-/usr/lib64/python2.6/site-packages/gtk-2.0-/usr/lib/python2.6/site-packagespythonversion:-2-6-6- final-0saltpath:/usr/lib/python2.6/site-packages/saltsaltversion:2015.5.10saltversioninfo:-2015-5-10-0selinux:----------enabled:Trueenforced:Permissiveserialnumber:VMware-564d8f43912d3a99-eb c4 3b a9 34 fc ba 90server_id:295577080shell:/bin/bashvirtual:VMwarezmqversion:3.2.5

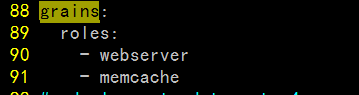

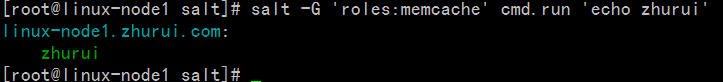

| 名称 | 存储位置 | 数据类型 | 数据采集更新方式 | 应用 |

| Grains | minion端 | 静态数据 | minion启动时收集,也可以使用saltutil.sync_grains进行刷新。 | 存储minion基本数据,比如用于匹配minion,自身数据可以用来做资产管理等。 |

| Pillar | master端 | 动态数据 | 在master端定义,指定给对应的minion,可以使用saltutil.refresh_pillar刷新 | 存储Master指定的数据,只有指定的minion可以看到,用于敏感数据保存。 |

自动化运维之SaltStack实践的更多相关文章

- 1、自动化运维之SaltStack实践

自动化运维之SaltStack实践 1.1.环境 linux-node1(master服务端) 192.168.0.15 linux-node2(minion客户端) 192.168.0.16 1.2 ...

- saltstack自动化运维系列⑧SaltStack实践配置管理安装nginx-1.10.3

saltstack自动化运维系列⑧SaltStack实践配置管理安装nginx-1.10.3 安装nginx-1.10.3.tar.gz # mkdir -p /srv/salt/prod/pkg / ...

- saltstack自动化运维系列⑦SaltStack实践配置管理安装zabbix

saltstack自动化运维系列⑥SaltStack实践配置管理安装zabbix 1.添加管理zabbix的sls文件# vim /srv/salt/base/init/zabbix_agent.sl ...

- saltstack自动化运维系列⑥SaltStack实践安装配置HAproxy的Keepalived

saltstack自动化运维系列⑥SaltStack实践安装配置HAproxy的Keepalived 安装配置Keepalived 1.编写功能模块 #创建keepalived目录# mkdir -p ...

- saltstack自动化运维系列⑥SaltStack实践安装配置HAproxy

saltstack自动化运维系列⑥SaltStack实践安装配置HAproxy 下载haproxy1.6.2.tar.gz下载地址:http://www.haproxy.org/download/1. ...

- 自动化运维之Saltstack

第三十八课 自动化运维之Saltstack 目录 一.自动化运维介绍 二. saltstack安装 三. 启动saltstack服务 四. saltstack配置认证 五. saltstack远程执行 ...

- saltstack自动化运维系列⑩SaltStack二次开发初探

saltstack自动化运维系列⑩SaltStack二次开发初探 1.当salt运行在公网或者网络环境较差的条件下,需要配置timeout时间vim /etc/salt/master timeout: ...

- 自动化运维工具 SaltStack 搭建

原文地址:https://www.ibm.com/developerworks/cn/opensource/os-devops-saltstack-in-cloud/index.html#N10072 ...

- 自动化运维工具SaltStack详细部署【转】

==========================================================================================一.基础介绍==== ...

随机推荐

- 【并发编程】Java中的原子操作

什么是原子操作 原子操作是指一个或者多个不可再分割的操作.这些操作的执行顺序不能被打乱,这些步骤也不可以被切割而只执行其中的一部分(不可中断性).举个列子: //就是一个原子操作 int i = 1; ...

- 发送大数据时,PDU的问题?

昨天发现通过 Ice发送请求传递一个大块数据时,当请求的体积大于1.2M后,直接抛出异常Connection Lost,对方peer或是断开了.通过防火墙配置排查,以及对同一网络同一机器的php服务p ...

- AE10.0在Visual Studio 2012下安装没有模板(转)

转自百度经验: VS2012中丢失ArcGIS模板的解决方法 由于ArcGIS10.0(for .NET)默认是用VS2010作为开发工具的,所以在先安装VS2012后装ArcGIS10.0 桌面版及 ...

- 新闻实时分析系统 SQL快速离线数据分析

1.Spark SQL概述1)Spark SQL是Spark核心功能的一部分,是在2014年4月份Spark1.0版本时发布的. 2)Spark SQL可以直接运行SQL或者HiveQL语句 3)BI ...

- python中return和print的区别

之前遇到这个问题,就试着对比几种不同的结果,总结啦一下return和print的区别. 总结: return的作用之一是返回计算的值print的作用是输出数据到控制端 在第一个结果中什么都没有输出:在 ...

- 使用centos7安装PXE教程

PXE是一种电脑无盘(即没有硬盘)技术. 预启动执行环境(PXE)指的是那些使得IBM兼容计算机(经常是运行Windows系统)不需要硬盘或是启动软盘就能启动的方法. 通俗点讲就是配置好PXE以后可以 ...

- Prometheus 【目录】

正在陆续更新,内容大体包括: rule.标签重置.cAdversior.自动发现(File 自动发现.DNS自动发现.k8s环境自动发现)等... 目录: prometheus[第一篇] Promet ...

- 【黑客基础】Windows PowerShell 脚本学习(上)

视频地址:[黑客基础]Windows PowerShell 脚本学习 2019.12.05 学习笔记 1.$PSVersionTable :查看PowerShell的版本信息. 2.PowerShel ...

- 小白学 Python 爬虫(12):urllib 基础使用(二)

人生苦短,我用 Python 前文传送门: 小白学 Python 爬虫(1):开篇 小白学 Python 爬虫(2):前置准备(一)基本类库的安装 小白学 Python 爬虫(3):前置准备(二)Li ...

- jsp html 实现隐藏输入框,点击可以取消隐藏&&弹出输入框

jsp代码: <script language="javascript" type="text/javascript"> function chg ...