prometheus学习系列三:node_exporter安装部署

node_exporter简介

node_exporter安装部署

[root@node00 ~]# cd /usr/src/

[root@node00 src]# wget https://github.com/prometheus/node_exporter/releases/download/v0.18.1/node_exporter-0.18.1.linux-amd64.tar.gz

[root@node00 src]# mkdir /usr/local/exporter -pv

mkdir: created directory ‘/usr/local/exporter’

[root@node00 src]# tar xf node_exporter-0.18..linux-amd64.tar.gz -C /usr/local/exporter/

[root@node00 src]# cd /usr/local/exporter/

[root@node00 exporter]# ls

node_exporter-0.18..linux-amd64

[root@node00 exporter]# ln -s node_exporter-0.18..linux-amd64/ node_exporter

node_exporter启动

[root@node00 node_exporter]# ./node_exporter

INFO[] Starting node_exporter (version=0.18., branch=HEAD, revision=3db77732e925c08f675d7404a8c46466b2ece83e) source="node_exporter.go:156"

INFO[] Build context (go=go1.12.5, user=root@b50852a1acba, date=-::) source="node_exporter.go:157"

INFO[] Enabled collectors: source="node_exporter.go:97"

# 中间输出省略

INFO[] Listening on : source="node_exporter.go:170"

测试node_exporter

[root@node00 ~]# curl 127.0.0.1:9100/metrics

# 这里可以看到node_exporter暴露出来的数据。

配置node_exporter开机自启

[root@node00 system]# cd /usr/lib/systemd/system

# 准备systemd文件

[root@node00 systemd]# cat node_exporter.service

[Unit]

Description=node_exporter

After=network.target [Service]

User=prometheus

Group=prometheus

ExecStart=/usr/local/exporter/node_exporter/node_exporter\

--web.listen-address=:\

--collector.systemd\

--collector.systemd.unit-whitelist=(sshd|nginx).service\

--collector.processes\

--collector.tcpstat\

--collector.supervisord

[Install]

WantedBy=multi-user.target

# 启动

[root@node00 exporter]# systemctl restart node_exporter

# 查看状态

[root@node00 exporter]# systemctl status node_exporter

● node_exporter.service - node_exporter

Loaded: loaded (/usr/lib/systemd/system/node_exporter.service; enabled; vendor preset: disabled)

Active: active (running) since Fri -- :: EDT; 5s ago

Main PID: (node_exporter)

CGroup: /system.slice/node_exporter.service

└─ /usr/local/exporter/node_exporter/node_exporter --collector.systemd --collector.systemd.unit-whitelist=(sshd|nginx).service Sep :: node00 node_exporter[]: time="2019-09-20T22:43:09-04:00" level=info msg=" - stat" source="node_exporter.go:104"

Sep :: node00 node_exporter[]: time="2019-09-20T22:43:09-04:00" level=info msg=" - systemd" source="node_exporter.go:104"

Sep :: node00 node_exporter[]: time="2019-09-20T22:43:09-04:00" level=info msg=" - textfile" source="node_exporter.go:104"

Sep :: node00 node_exporter[]: time="2019-09-20T22:43:09-04:00" level=info msg=" - time" source="node_exporter.go:104"

Sep :: node00 node_exporter[]: time="2019-09-20T22:43:09-04:00" level=info msg=" - timex" source="node_exporter.go:104"

Sep :: node00 node_exporter[]: time="2019-09-20T22:43:09-04:00" level=info msg=" - uname" source="node_exporter.go:104"

Sep :: node00 node_exporter[]: time="2019-09-20T22:43:09-04:00" level=info msg=" - vmstat" source="node_exporter.go:104"

Sep :: node00 node_exporter[]: time="2019-09-20T22:43:09-04:00" level=info msg=" - xfs" source="node_exporter.go:104"

Sep :: node00 node_exporter[]: time="2019-09-20T22:43:09-04:00" level=info msg=" - zfs" source="node_exporter.go:104"

Sep :: node00 node_exporter[]: time="2019-09-20T22:43:09-04:00" level=info msg="Listening on :9100" source="node_exporter.go:170" # 开机自启

[root@node00 exporter]# systemctl enable node_exporter

配置prometheus采集node信息

修改配置文件

[root@node00 prometheus]# cd /usr/local/prometheus/prometheus

[root@node00 prometheus]# vim prometheus.yml

# 在scrape_configs中加入job node ,最终scrape_configs如下配置

scrape_configs:

# The job name is added as a label `job=<job_name>` to any timeseries scraped from this config.

- job_name: 'prometheus' # metrics_path defaults to '/metrics'

# scheme defaults to 'http'. static_configs:

- targets: ['localhost:9090']

- job_name: "node"

static_configs:

- targets:

- "192.168.100.10:20001" [root@node00 prometheus]# systemctl restart prometheus

[root@node00 prometheus]# systemctl status prometheus

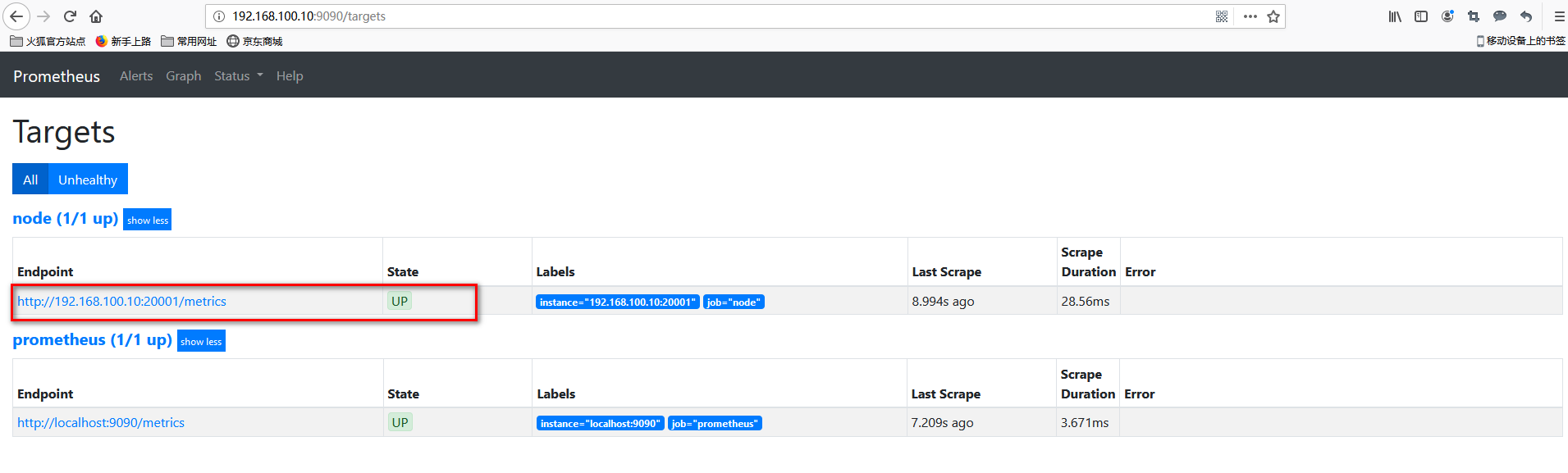

查看集成

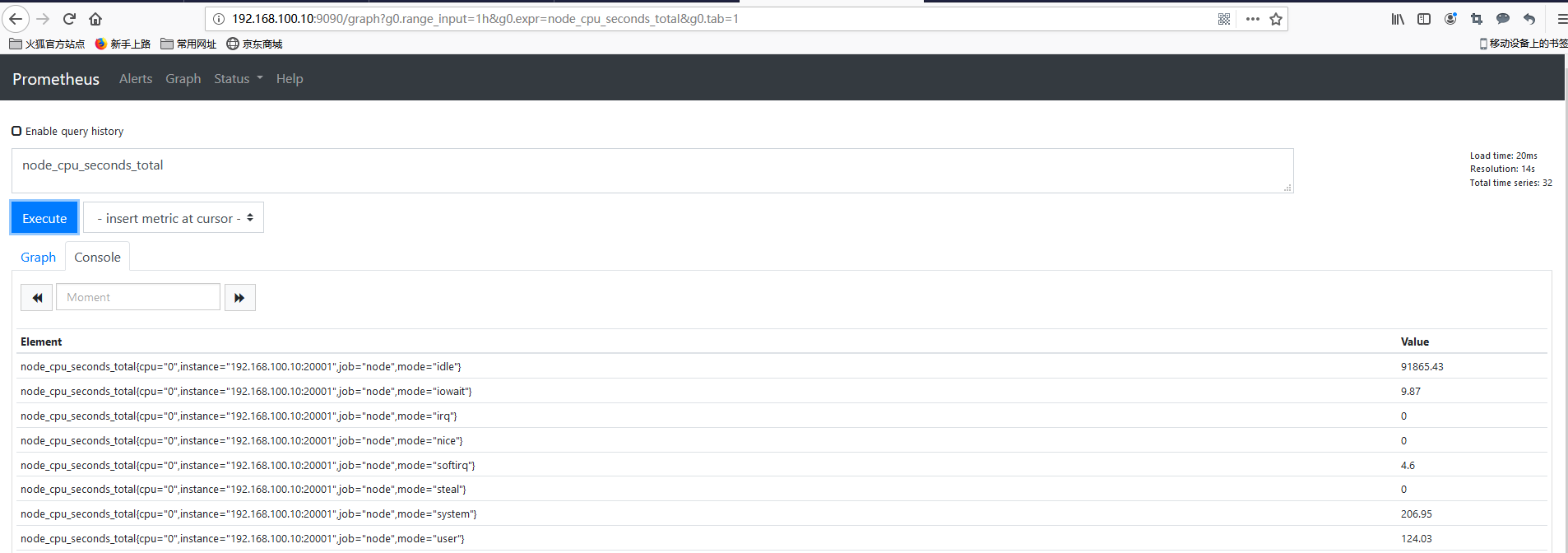

样例查询

prometheus学习系列三:node_exporter安装部署的更多相关文章

- scrapy爬虫学习系列三:scrapy部署到scrapyhub上

系列文章列表: scrapy爬虫学习系列一:scrapy爬虫环境的准备: http://www.cnblogs.com/zhaojiedi1992/p/zhaojiedi_python_00 ...

- RabbitMQ学习系列三-C#代码接收处理消息

RabbitMQ学习系列三:.net 环境下 C#代码订阅 RabbitMQ 消息并处理 http://www.80iter.com/blog/1438251320680361 http://www. ...

- kubernetes系列03—kubeadm安装部署K8S集群

本文收录在容器技术学习系列文章总目录 1.kubernetes安装介绍 1.1 K8S架构图 1.2 K8S搭建安装示意图 1.3 安装kubernetes方法 1.3.1 方法1:使用kubeadm ...

- .net reactor 学习系列(三)---.net reactor代码自动操作相关保护功能

原文:.net reactor 学习系列(三)---.net reactor代码自动操作相关保护功能 接上篇,上篇已经学习了界面的各种功能以及各种配置,这篇准备学习下代码控制许可证. ...

- MyBatis学习系列三——结合Spring

目录 MyBatis学习系列一之环境搭建 MyBatis学习系列二——增删改查 MyBatis学习系列三——结合Spring MyBatis在项目中应用一般都要结合Spring,这一章主要把MyBat ...

- DocX开源WORD操作组件的学习系列三

DocX学习系列 DocX开源WORD操作组件的学习系列一 : http://www.cnblogs.com/zhaojiedi1992/p/zhaojiedi_sharp_001_docx1.htm ...

- Identity Server4学习系列三

1.简介 在Identity Server4学习系列一和Identity Server4学习系列二之令牌(Token)的概念的基础上,了解了Identity Server4的由来,以及令牌的相关知识, ...

- RabbitMQ学习系列三:.net 环境下 C#代码订阅 RabbitMQ 消息并处理

上一篇已经讲了Rabbitmq如何在Windows平台安装 不懂请移步: RabbitMQ学习系列二:.net 环境下 C#代码使用 RabbitMQ 消息队列 一.理论 .net环境下,C#代码订阅 ...

- C# Redis学习系列三:Redis配置主从

Redis配置主从 主IP :端口 192.168.0.103 6666 从IP:端口 192.168.0.108 3333 配置从库 (1)安装服务: redis-server ...

随机推荐

- PATA1028 List Sorting

Excel can sort records according to any column. Now you are supposed to imitate this function. Input ...

- SCDM导入点数据

我们有时候需要把外部的点导入SCDM当中,但是SCDM没有像ICEM或者DM那样直接提供点导入的选项,是不是SCDM就无法导入点的数据了呢?答案当然是否定的.把点导入SCDM中的方法总结如下(示例数据 ...

- 使用stunnle加密传输

Stunnel是一个可以用SSL对任意 TCP 连接加密的程序.它可以运行在多种UNIX和Windows上,它是基于 OpenSSL的,所以它要求已经安装了 OpenSSL,并进行了正确的配置.——来 ...

- windows下SVN使用 Add指令、Undo Add指令

前几天,使用SVN的Add指令添加了一个文件,后不使用直接删除了,每次提交都存在,解决后记录方法,希望帮到大家,此外如果大家有好的方法,希望可以回复. 问题:使用Add添加文件后直接删除了文件,每次提 ...

- Spring(或者SpringBoot)整合Spring-Session实现共享session

传统Spring 先引入依赖 <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http: ...

- 给定一个数组,求如果排序后,相邻两个元素的最大差值,要求时间复杂度为O(N)

第一种方法: 计数排序后,然后找出两两之间的最大差值 计数排序的时间复杂度是O(N) public class CountSort { public static void main(String[] ...

- 桥接(Bridge)模式

桥接模式又称为柄体模式或接口模式.桥接模式的用意就是"将抽象化与实现化解耦,使得二者可以独立变化". 抽象化: 存在于多个实体中的共同的概念性联系,就是抽象化.作为一个过程,抽象化 ...

- Linux低延迟服务器系统调优

最近做了一些系统和网络调优相关的测试,达到了期望的效果,有些感悟.同时,我也发现知乎上对Linux服务器低延迟技术的讨论比较欠缺(满嘴高并发现象):或者对现今cpu + 网卡的低延迟潜力认识不足(动辄 ...

- docker封装mysql镜像

一.概述 直接使用官方的镜像 docker pull mysql:5.7 但是mysqld.cnf并没有优化,还是默认的. 二.封装镜像 创建目录 # dockerfile目录 mkdir -p /o ...

- SQL系列(一)—— SQL简介

在说到SQL之前需要了解一些关于数据库的概念: 数据库(database):是一个以某种有组织的方式存储的数据集合.存储数据的仓库,不过是以一定的组织方式进行存储. DBMS:数据库管理系统.经常遇到 ...