【python】一篇文章里的词频统计

一、环境

1.python3.6

2.windows系统

3.安装第三方模块

pip install wordcloud #词云展示库

pip install jieba #结巴分词

pip install matplotlib #图像展示库

二、需求

统计article.txt里的文章的词频

三、代码

import collections #词库统计库,自带模块

import re #正则表达式 自带模块

import wordcloud #词云展示库,pip install wordcloud

import jieba #结巴分词,pip install jieba

import matplotlib.pyplot as plt #图像展示库 pip install matplotlib #读取文件

fn = open('article.txt',encoding='utf-8') #打开文件

string_data = fn.read() #读取整个文件

fn.close() #关闭文件 #文本预处理

pattern = re.compile(u'\t|\n|\.|-|:|;|\)|\(|\?|"') #定义正则表达式匹配模式

string_data = re.sub(pattern,'',string_data) #将符合模式的字符去除

print(string_data)

#文本分词

seg_list_exact = jieba.cut(string_data,cut_all=False) #精确模式分词

object_list = []

remove_words = [u'的',u',',u'。',u'“',u'”',u'能',u'如果',u'通常',u'我们',u'需要',u'随着',u' ',u'在',u'了',u'、',u'是',u'上',u'有',u'从'] #自定义去除词库

# print(seg_list_exact) for word in seg_list_exact: #循环读出每个分词

if word not in remove_words: #如果不在去除词库中

object_list.append(word) #分词追加到列表

# print(object_list) # # 词频统计

word_counts = collections.Counter(object_list) #对分词做词频统计

word_counts_top10 = word_counts.most_common(10) #获取前10最高频的词

print(word_counts_top10) #输出检查

#

# # 词频展示

wc = wordcloud.WordCloud(background_color="black", # 设置背景颜色

max_words=200, # 设置最大显示的字数

font_path="FZSTK.TTF", # 设置中文字体,词云默认字体是“DroidSansMono.ttf字体库”,不支持中文

max_font_size=50, # 设置字体最大值

random_state=30, # 设置有多少种随机生成状态,即有多少种配色方案

)

#

wc.generate_from_frequencies(word_counts) #从字典生成词云

plt.imshow(wc) #显示词云

plt.axis('off') #关闭坐标轴

plt.show() #显示图像

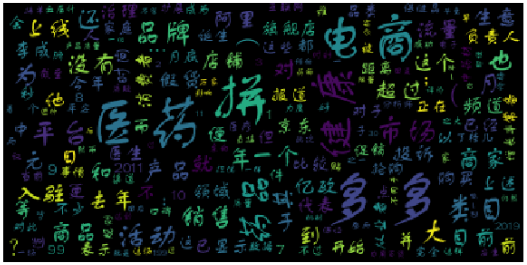

四、结果展示

【python】一篇文章里的词频统计的更多相关文章

- python复合数据类型以及英文词频统计

这个作业的要求来自于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/2753. 1.列表,元组,字典,集合分别如何增删改查及遍历. 列 ...

- python瓦登尔湖词频统计

#瓦登尔湖词频统计: import string path = 'D:/python3/Walden.txt' with open(path,'r',encoding= 'utf-8') as tex ...

- python英文与中文的词频统计

1.统计英文单词, # 1.准备utf-8编码的文本文件file(已在文件夹中定义了 一个名叫“head.txt.rtf”文本文件,详情请见截图) def getTxt(): #3对文本预处理(包括) ...

- Python数据分析之文本处理词频统计

1.项目背景: 原本计划着爬某房产网站的数据做点分析, 结果数据太烂了,链家网的数据干净点, 但都是新开楼盘,没有时间维度,分析意义不大. 学习的步伐不能ting,自然语言处理还的go on 2.分析 ...

- python jieba分词小说与词频统计

1.知识点 """ 1)cut() a) codecs.open() 解决编码问题 b) f.readline() 读取一行,也可以使用f.readlines()读取多行 ...

- 一篇文章让你学透Linux系统中的more命令

Linux 下有很多实用工具可以让你在终端界面查看文本文件.其中一个就是 more. more 跟我之前另一篇文章里写到的工具 —— less 很相似.它们之间的主要不同点在于 more 只允许你向前 ...

- spark ---词频统计(二)

利用python来操作spark的词频统计,现将过程分享如下: 1.新建项目:(这里是在已有的项目中创建的,可单独创建wordcount项目) ①新建txt文件: wordcount.txt (文件内 ...

- 一篇文章图文并茂地带你轻松学完 JavaScript 设计模式(一)

JavaScript 设计模式(一) 本文需要读者至少拥有基础的 ES6 知识,包括 Proxy, Reflect 以及 Generator 函数等. 至于这次为什么分了两篇文章,有损传统以及标题的正 ...

- Python之利用jieba库做词频统计且制作词云图

一.环境以及注意事项 1.windows10家庭版 python 3.7.1 2.需要使用到的库 wordcloud(词云),jieba(中文分词库),安装过程不展示 3.注意事项:由于wordclo ...

随机推荐

- 【mybatis】JdbcType 与Oracle、MySql数据类型对应关系

- 产品上线后,出现BUG的处理流程

根据bug的大小,如果影响业务逻辑及用户提醒及时处理,如果只是一些状态.文案等等对业务无重大影响可以跟版本迭代走 很严重的bug必然要回滚,想都不要想赶紧去着手安排做. 检查回滚版本是否会丢失数据,如 ...

- 模拟赛 T1 费马小定理+质因数分解+exgcd

求:$a^{bx \%p}\equiv 1(\mod p)$ 的一个可行的 $x$. 根据欧拉定理,我们知道 $a^{\phi(p)}\equiv 1(\mod p)$ 而在 $a^x\equiv 1 ...

- Trie字典树(超详细!!!)

介绍 字典树,也称Trie.字母树,指的是某个字符串集合对应的形如下图的有根树.树的每条边上对应有恰好一个字符,每个顶点代表从根到该节点的路径所对应的字符串(将所有经过的边上的字符按顺序连接起来).有 ...

- 一个sh脚本 同时运行 多个sh脚本

问题: 原来的启动方式 cd /opt/OpenIMSCore ./pcscf.sh ./icscf.sh ./scscf.sh cd /opt/OpenIMSCore/FHoSS/deploy ./ ...

- 《Linux就该这么学》培训笔记_ch09_使用ssh服务管理远程主机

<Linux就该这么学>培训笔记_ch09_使用ssh服务管理远程主机 文章最后会post上书本的笔记照片. 文章主要内容: 配置网络服务 远程控制服务 不间断会话服务 书本笔记 配置网络 ...

- python 在cmd时执行celery -A tasks worker --loglevel=info报错:failed to create process怎么解决

在cmd命令前加 : python -m 命令(如:python -m celery -A tasks worker --loglevel=info) -m: 将库中的python模块用作脚本去运行, ...

- [转帖]智能合约和 DApp

智能合约和 DApp https://www.jianshu.com/p/5e7df3902957 2018.10.08 19:50:41字数 3,403阅读 9,819 2017年11月份和2018 ...

- 存储过程中的BeginEnd

存储过程中的BeginEnd和其它语言中的花括号,本身没有事务作用,主要有两个作用1.使语句结果清晰2.语句块作用,比如在 if 后面使用.

- 第十二节:Asp.Net Core 之分布式缓存(SQLServer和Redis)

一. 整体说明 1. 说明 分布式缓存通常是指在多个应用程序服务器的架构下,作为他们共享的外部服务共享缓存,常用的有SQLServer.Redis.NCache. 特别说明一下:这里的分布式是 ...