SOTA激活函数学习

除了之前较为流行的RELU激活函数,最近又新出了几个效果较好的激活函数

一、BERT激活函数 - GELU(gaussian error linear units)高斯误差线性单元

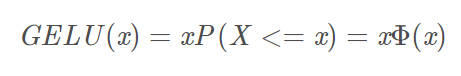

数学公式如下:

X是服从标准正态分布的变量。

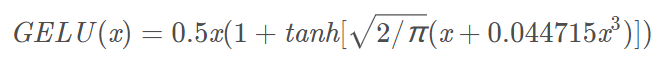

近似的数学计算公式如下:

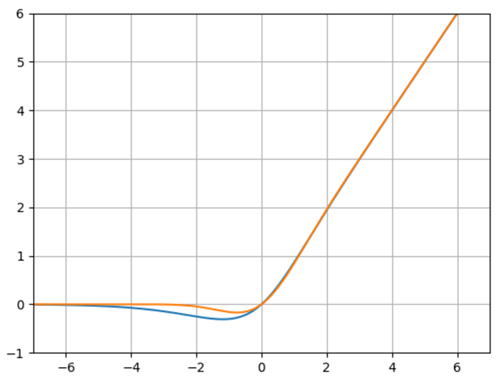

函数图如下:

橙色曲线为:GELU

蓝色曲线为:Mish函数

特性:当输入x减小的时候,输入会有一个更高的概率被dropout掉,这样的激活变换就会随机依赖于输入了,在激活中引入了随机正则的思想,是一种对神经元输入的概率描述。但是其实GELU相比Mish函数就要差一点,首先在大于0阶段,Mish函数的梯度是要略大于GELU,在负轴阶段Mish函数比GELU要晚一点趋近于0,也就是神经元能够晚一点死掉。

- import math

- import numpy as np

- from matplotlib import pyplot as plt

- def mish(x):

- return x * math.tanh(math.log(1+math.exp(x)))

- def GELU(x):

- return 0.5*x*(1+math.tanh(math.sqrt(2/math.pi)*(x+0.044715*x**3)))

- x = np.linspace(-10,10,1000)

- y=[]

- z=[]

- for i in x:

- y.append(mish(i))

- z.append(GELU(i))

- plt.plot(x,y)

- plt.plot(x,z)

- plt.grid()

- plt.ylim(-1,6)

- plt.xlim(-7,7)

- plt.show()

二、Mish激活函数

公式如下:

函数图如下:

橙色曲线为:ln(1+e^(x))

蓝色曲线为:Mish函数

- import math

- import numpy as np

- from matplotlib import pyplot as plt

- def mish(x):

- return x * math.tanh(math.log(1+math.exp(x)))

- def ln_e(x):

- return math.log(1+math.exp(x))

- x = np.linspace(-10,10,1000)

- y=[]

- z=[]

- for i in x:

- y.append(mish(i))

- z.append(ln_e(i))

- plt.plot(x,y)

- plt.plot(x,z)

- plt.grid()

- plt.show()

SOTA激活函数学习的更多相关文章

- Mish:一个新的SOTA激活函数,ReLU的继任者

Mish:一个新的SOTA激活函数,ReLU的继任者 CVer 昨天 以下文章来源于AI公园 ,作者ronghuaiyang AI公园 专注分享干货的AI公众号,图像处理,NLP,深度学习,机器学 ...

- ML激活函数使用法则

sigmoid .tanh .ReLu tanh 函数或者双曲正切函数是总体上都优于 sigmoid 函数的激活函数. 基本已经不用 sigmoid 激活函数了,tanh 函数在所有场合都优于 sig ...

- deeplearning.ai课程学习(3)

第三周:浅层神经网络(Shallow neural networks) 1.激活函数(Activation functions) sigmoid函数和tanh函数两者共同的缺点是,在z特别大或者特别小 ...

- 吴恩达《深度学习》-第一门课 (Neural Networks and Deep Learning)-第三周:浅层神经网络(Shallow neural networks) -课程笔记

第三周:浅层神经网络(Shallow neural networks) 3.1 神经网络概述(Neural Network Overview) 使用符号$ ^{[

- [C1W3] Neural Networks and Deep Learning - Shallow neural networks

第三周:浅层神经网络(Shallow neural networks) 神经网络概述(Neural Network Overview) 本周你将学习如何实现一个神经网络.在我们深入学习具体技术之前,我 ...

- 论文阅读 | Text Processing Like Humans Do: Visually Attacking and Shielding NLP Systems

[code&data] [pdf] 主要工作 文章首先证明了对抗攻击对NLP系统的影响力,然后提出了三种屏蔽方法: visual character embeddings adversaria ...

- 《Neural Networks and Deep Learning》课程笔记

Lesson 1 Neural Network and Deep Learning 这篇文章其实是 Coursera 上吴恩达老师的深度学习专业课程的第一门课程的课程笔记. 参考了其他人的笔记继续归纳 ...

- [DeeplearningAI笔记]神经网络与深度学习3.2_3.11(激活函数)浅层神经网络

觉得有用的话,欢迎一起讨论相互学习~Follow Me 3.2 神经网络表示 对于一个由输入层,隐藏层,输出层三层所组成的神经网络来说,输入层,即输入数据被称为第0层,中间层被称为第1层,输出层被称为 ...

- 【深度学习】深入理解ReLU(Rectifie Linear Units)激活函数

论文参考:Deep Sparse Rectifier Neural Networks (很有趣的一篇paper) Part 0:传统激活函数.脑神经元激活频率研究.稀疏激活性 0.1 一般激活函数有 ...

随机推荐

- TEE(Trusted Execution Environment)简介【转】

转自:https://blog.csdn.net/fengbingchun/article/details/78657188 TEE(Trusted Execution Environment),可信 ...

- uwsgi + nginx 发布

下载uwsgi 基于pip 若是没有下载 yum install -y python2-pip pip install uwsgi 出上面的错 ,安装python的development包 yum i ...

- 201871010101- 陈来弟《面向对象程序设计(java)》第6-7周学习总结

201871010101- 陈来弟<面向对象程序设计(java)>第6-7周学习总结 项目 内容 这个作业属于哪个课程 https://www.cnblogs.com/nwnu-daizh ...

- 201871010104-陈园园 《面向对象程序设计(java)》第八周学习总结

201871010104-陈园园 <面向对象程序设计(java)>第八周学习总结 项目 内容 这个作业属于哪个课程 https://www.cnblogs.com/nwnu-daizh/ ...

- python字典基本操作

字典是python中五中基本数据类型之一,虽然它的赋值稍微麻烦点,但用起来真的是很方便.它用键值对来存放数据,所谓键值对,就是一个键,对应一个值,如果后面对前面的键再次赋值,第一次的值就被覆盖掉.像是 ...

- day9_7.9 函数的定义

一.基础 1.什么是函数? 函数就是工具,方便开发人员开发软件,非常简洁的工具. 函数的关键字是def 在函数的编写阶段,只检验其语法是否正确,不检验代码. 在函数的调用阶段,可以通过函数名+()来调 ...

- OpenCV随机颜色,用于画图调试

static Scalar randomColor(int64 seed) { RNG rng(seed); int icolor = (unsigned)rng; return Scalar(ico ...

- MySQL8 修改密码验证插件

MySQL8 修改密码验证插件 查看当前用户使用的密码验证插件 mysql> show variables like '%auth%'; +--------------------------- ...

- 批处理简单命令 start

start 命令 调用外部程序,所有的DOS命令和命令行程序都可以由start命令来调用. 如:start calc.exe 即可打开Windows的计算器. 常用参数: MIN 开始时窗口最小化 S ...

- 了解html表单

html表单 表单的根标签:form form标签属性 action:处理表单业务的后台代码的位置(URL) method:提交方式 post get 默认值 enctype:encode type ...