机器学习 Hidden Markov Models 3

Viterbi Algorithm

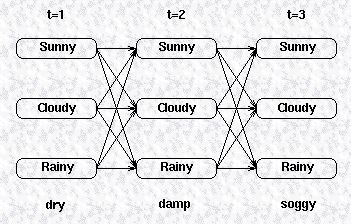

前面我们提到过,HMM的第二类问题是利用HMM模型和可观察序列寻找最有可能生成该观察序列的隐藏变量的序列。简单来说,第一类问题是通过模型计算生成观察序列的概率,而第二类问题通过观察序列计算最有可能生成该观察序列的的隐藏变量的序列。我们还是先来看如下一张图:

我们希望找到生成该观察序列的概率最高的一个隐藏变量的序列。换句话说,我们想要最大化如下的式子:

一种简单直观的方法是将所有可能的隐藏变量的序列全部列出,然后求出它们生成可观察序列的概率,然后挑出概率最大的一个隐藏变量序列,这种穷举法无疑是非常低效而且耗时的。与之前介绍的forward算法类似,我们可以借助状态转换矩阵以及confusion矩阵来减低运算的复杂度。

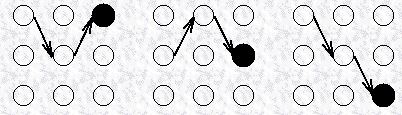

我们还是利用递归的方式去选择这样一条最优的隐藏变量序列,我们先定义一个局部概率Pσ,它表示某一路径到达某一中间状态的概率,这里的局部概率与forward算法里面提到的局部概率有点不一样,forward算法里的局部概率是所有路径到达某一中间状态的概率之和,而这里的局部概率,表示一条最优路径到达某一中间状态的概率。先来看如下的一张图:

对于上图所示的各个路径,无论是到达中间时序的状态,还是到达最终时序的状态,都存在一条最优的路径,比如下图所示分别给出了到达最终时序的三个状态的路径,我们把这些路径称为局部最佳路径,每一个这样的局部最佳路径都有一个概率,称为局部概率,这个定义与forward算法里的局部概率不一样,这里的局部概率表示最佳路径的局部概率。

因此,Pσ(i,t),表示所有在t时刻到达状态i的路径中,最佳的一条局部路径的概率,很显然,对于任何的t,i这样的最佳路径和最大局部概率都是存在的。因此在最终时刻t=T,每一个状态都应该有一个局部最佳路径和最大局部概率,那么全局最佳路径就是选择局部概率最大所对应的那条路径。

对应初始状态的局部概率,其定义和在forward算法中的一样,由初始概率和confusion矩阵决定,如下式所示:

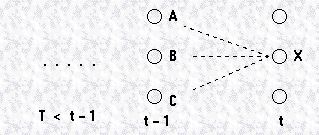

我们接下来将要计算t时刻的局部概率,同样地利用递归的方法,我们可以通过t−1时刻的局部概率计算t时刻的局部概率,我们先看下面的一张图。为了找到在t时刻到达X状态的最佳路径,我们知道,只有三条路径可以选择,就是从t−1时刻的状态A,B,C中的一个选择一条最佳路径,

之前我们介绍过马尔科夫假设,即一个状态发生的概率只与之前的状态有关,而且对于一阶的马尔科夫过程,当前状态只和前一个状态有关,如果我们要计算状态A到状态X的概率,可以由下式表示:

因此,t时刻到达状态X的最佳路径,应该满足如下的表达式:

上式右边的第一项是t−1时刻的局部概率,第二项由状态转换矩阵决定,第三项由confusion矩阵决定。因此,在t时刻给定观察变量,而推出隐藏变量的状态为i的概率为:

现在我们已经知道如何求解到达隐藏变量中间状态和最终状态的局部概率Pσ(i,t), 但是,我们的目标是通过观察变量的一个序列找到对应的最有可能生成该观察序列的一个隐藏变量序列。

我们已经知道,为了计算时刻t的某一状态的局部概率,我们只要知道t−1时刻的局部概率,一旦计算出局部概率,我们就能确定系统t−1时刻最有可能的状态,我们可以用一个表达式来表示这个选择的过程:

注意到这个表达式和计算局部概率的表达式很像,唯一的区别在于这个表达式没有用到confusion矩阵,也就是没有隐藏变量与观察变量的转换概率。因为这里要找的是隐藏变量的前一个状态,所以与观察变量没有关系。通过这个表达式,我们可以确定到达当前状态i的前一状态j。

下面,我们对这个算法做一个总结,对于有n个隐藏状态的HMM模型,对于每个隐藏状态i,i=1,2,...n,假设存在一组时序长度为T的观察序列:

隐藏状态的初始局部概率,即t=1时刻的概率,Pσ(i,t=1),可以由转换矩阵和confusion矩阵以及观察序列和隐藏状态的初始概率得到。对于t=2,3,...T以及

i=1,2,...n。我们有:

假设

我们可以知道在t=T时刻,即最终时刻,哪个状态的局部概率最大。对于t=T−1,...1,我们有:

所以,通过上式进行回溯,一旦回到初始时刻,那么序列i1,i2,...iT记录的就是最有可能生成观察序列的一个隐藏变量序列。

最后,我们做个小结,对于一个特定的HMM模型,Viterbi Algorithm用来寻找最有可能生成一组观察变量序列的隐藏变量序列,这个算法记录了每一个隐藏状态的局部概率Pσ以及每一个隐藏状态的回溯点ϕ,隐藏状态的局部概率就是通过回溯点到达该状态的概率。

Forward-backward algorithm

前面我们介绍了两类问题,并且介绍了相应的两种算法。第一类问题是用来评估模型的,我们介绍了forward算法;第二类问题是寻找最佳的隐藏变量序列的,我们利用的

是Viterbi算法,这两类问题都要用到已知的模型,转换矩阵,confusion矩阵,观察变量的序列等等。而第三类问题比前两类要复杂地多,它们没有现成的模型,我们需要

估计一个可行的模型,这属于学习问题,这类问题要用Forward-backward算法来解决,这个算法要比前面介绍的两种算法更加复杂,这里就不再详细介绍了。有兴趣的可以

参考下面的文献:

L R Rabiner and B H Juang, `An introduction to HMMs’, IEEE ASSP Magazine, 3, 4-16.

参考来源:

http://www.comp.leeds.ac.uk/roger/HiddenMarkovModels/html_dev/main.html

机器学习 Hidden Markov Models 3的更多相关文章

- 机器学习 Hidden Markov Models 1

Introduction 通常,我们对发生在时间域上的事件希望可以找到合适的模式来描述.考虑下面一个简单的例子,比如有人利用海草来预测天气,民谣告诉我们说,湿漉漉的海草意味着会下雨,而干燥的海草意味着 ...

- 机器学习 Hidden Markov Models 2

Hidden Markov Models 下面我们给出Hidden Markov Models(HMM)的定义,一个HMM包含以下几个要素: ∏=(πi)表示初始状态的向量.A={aij}状态转换矩阵 ...

- 隐马尔科夫模型(Hidden Markov Models)

链接汇总 http://www.csie.ntnu.edu.tw/~u91029/HiddenMarkovModel.html 演算法笔记 http://read.pudn.com/downloads ...

- PRML读书会第十三章 Sequential Data(Hidden Markov Models,HMM)

主讲人 张巍 (新浪微博: @张巍_ISCAS) 软件所-张巍<zh3f@qq.com> 19:01:27 我们开始吧,十三章是关于序列数据,现实中很多数据是有前后关系的,例如语音或者DN ...

- 隐马尔科夫模型(Hidden Markov Models) 系列之三

转自:http://blog.csdn.net/eaglex/article/details/6418219 隐马尔科夫模型(Hidden Markov Models) 定义 隐马尔科夫模型可以用一个 ...

- [Bayesian] “我是bayesian我怕谁”系列 - Markov and Hidden Markov Models

循序渐进的学习步骤是: Markov Chain --> Hidden Markov Chain --> Kalman Filter --> Particle Filter Mark ...

- Hidden Markov Models笔记

Andrew Ng CS229 讲义: https://pan.baidu.com/s/12zMYBY1NLzkluHNeMNO6MQ HMM模型常用于NLP.语音等领域. 马尔科夫模型(Markov ...

- 隐马尔科夫模型(Hidden Markov Models) 系列之五

转自:http://blog.csdn.net/eaglex/article/details/6458541 维特比算法(Viterbi Algorithm) 找到可能性最大的隐藏序列 通常我们都有一 ...

- 隐马尔科夫模型(Hidden Markov Models) 系列之四

转自:http://blog.csdn.net/eaglex/article/details/6430389 前向算法(Forward Algorithm) 一.如果计算一个可观察序列的概率? 1 ...

随机推荐

- Android 之 下拉框(Spinner)的使用-转

下拉列表 Spinner. Spinner的使用,可以极大提高用户的体验性.当需要用户选择的时候,可以提供一个下拉列表将所有可选的项列出来.供用户选择. Demo如下,可以留作参考 一.使用数组作为数 ...

- nginx配置 location root alias

语法规则: location [=|~|~*|^~] /uri/ { … } = 开头表示精确匹配 ^~ 开头表示uri以某个常规字符串开头,理解为匹配 url路径即可.nginx不对url做编码,因 ...

- 关于xshell无法连接到centos的问题

1.xshell无法连接到centos:拒绝连接(无线网) 在xshell ping centos出现: 解决方法: 1. 2.重启下网卡: [root@localhost ~]# /etc/init ...

- luogu P2296 寻找道路

题目描述 在有向图G 中,每条边的长度均为1 ,现给定起点和终点,请你在图中找一条从起点到终点的路径,该路径满足以下条件: 1 .路径上的所有点的出边所指向的点都直接或间接与终点连通. 2 .在满足条 ...

- Netty入门教程:Netty拆包粘包技术讲解

Netty编解码技术是什么意思呢?所谓的编解码技术,说白了就是java序列化技术.序列化有两个目的: 1.进行网络传输2.对象持久化 虽然我们可以使用java进行序列化,Netty去传输.但是java ...

- How to fill the background with image in landscape in IOS? 如何使image水平铺满屏幕

UIImageView *backgroundImage = [[UIImageView alloc] initWithFrame:self.view.frame]; [backgroundIm ...

- CVE-2014-4114 和 CVE-2014-3566

这两天关注安全的人员都会特别留意这两个新披露的漏洞:CVE-2014-4114 和 CVE-2014-3566.以下我们就针对这两个漏洞最一些简要说明. CVE-2014-4114------- ...

- 【转载】TCP的三次握手(建立连接)和四次挥手(关闭连接)

建立连接: 理解:窗口和滑动窗口TCP的流量控制 TCP使用窗口机制进行流量控制 什么是窗口? 连接建立时,各端分配一块缓冲区用来存储接收的数据,并将缓冲区的尺寸发送给另一端 接收方发送的确认信息中包 ...

- 【DataStructure】Description and Introduction of Tree

[Description] At ree is a nonlinear data structure that models a hierarchical organization. The char ...

- 拒绝干扰 解决Wi-Fi的最大问题

本文转载至:http://www.ciotimes.com/net/rdjs/WI-FI/201006301920.html 射频干扰英文:RFI,(Radio Frequency Interfere ...