Storm集成Siddhi

《Siddhi初探》中我们介绍了Siddhi的基本使用方法,并表示我们将把Siddhi集成到Storm中作为流任务处理引擎。本文将用《Storm初探》中的例子讲解如何集成Siddhi。

《Storm初探》中的例子把名字字符串进行分割与输出,我们将增加一个SIddhiBolt进行名字过滤,过滤规则是筛选出小于50岁的人的名字。

对于输出:刘备 49 关羽 50 张飞 51,曹操 49 郭嘉 50 荀彧 51。我们将过滤出刘备,曹操两个名字。代码如下:

package com.coshaho.learn.storm; import java.util.ArrayList;

import java.util.List;

import java.util.Map; import org.wso2.siddhi.core.SiddhiAppRuntime;

import org.wso2.siddhi.core.SiddhiManager;

import org.wso2.siddhi.core.event.Event;

import org.wso2.siddhi.core.query.output.callback.QueryCallback;

import org.wso2.siddhi.core.stream.input.InputHandler; import backtype.storm.task.OutputCollector;

import backtype.storm.task.TopologyContext;

import backtype.storm.topology.IRichBolt;

import backtype.storm.topology.OutputFieldsDeclarer;

import backtype.storm.tuple.Fields;

import backtype.storm.tuple.Tuple; /**

*

* NamesFilterSiddhiBolt.java Create on 2017年6月26日 下午11:08:45

*

* 类功能说明: 根据年龄过滤名称

*

* Copyright: Copyright(c) 2013

* Company: COSHAHO

* @Version 1.0

* @Author coshaho

*/

public class NamesFilterSiddhiBolt implements IRichBolt

{

private static final long serialVersionUID = 1L; private OutputCollector collector; private InputHandler inputHandler; @SuppressWarnings("rawtypes")

public void prepare(Map stormConf, TopologyContext context,

OutputCollector collector)

{

this.collector = collector;

init();

} private void init()

{

SiddhiManager siddhiManager = new SiddhiManager(); String siddhiApp = "" +

"define stream namesStream (name string, age int, streamid String); " +

"" +

"@info(name = 'namefilter') " +

"from namesStream[age < 50] " +

"select name,streamid,age " +

"insert into outputStream ;"; SiddhiAppRuntime siddhiAppRuntime = siddhiManager.createSiddhiAppRuntime(siddhiApp); siddhiAppRuntime.addCallback("namefilter", new QueryCallback()

{

@Override

public void receive(long timeStamp, Event[] inEvents, Event[] removeEvents)

{

for(Event event : inEvents)

{

String name = event.getData(0) + "";

String streamId = event.getData(1) + "";

String age = event.getData(2) + "";

List<Object> splitList = new ArrayList<Object>();

splitList.add(name);

System.out.println(name + " 年龄为 " + age);

collector.emit(streamId, splitList);

}

}

}); inputHandler = siddhiAppRuntime.getInputHandler("namesStream");

siddhiAppRuntime.start();

} public void execute(Tuple input)

{

String name = input.getString(0);

int age = input.getInteger(1);

String inputStream = input.getSourceStreamId();

try

{

inputHandler.send(new Object[]{name, age, inputStream});

}

catch (InterruptedException e)

{

e.printStackTrace();

} collector.ack(input);

} public void cleanup()

{

} public void declareOutputFields(OutputFieldsDeclarer declarer)

{

declarer.declare(new Fields("name"));

} public Map<String, Object> getComponentConfiguration()

{

return null;

}

}

需要简单的修改一下名称切割Bolt,增加age字段输出

public void execute(Tuple input)

{

// 打印线程号用于追踪Storm的分配策略

Thread current = Thread.currentThread();

String names = input.getString(0);

System.out.println("准备拆分" + names + "。当前线程号是" + current.getId() + "。");

List<Tuple> inputList = new ArrayList<Tuple>();

inputList.add(input);

String[] nameArray = names.split(" ");

int age = 49;

for(String name : nameArray)

{

List<Object> splitList = new ArrayList<Object>();

splitList.add(name);

splitList.add(age);

collector.emit(inputList, splitList);

age++;

}

collector.ack(input);

}

Topo发布时增加Siddhi过滤节点

public static void main(String[] args) throws InterruptedException

{

TopologyBuilder builder = new TopologyBuilder();

builder.setSpout("names-reader", new NamesReaderSpout());

// 启动两个名字分割Task,名字列表随机分配给一个Task

builder.setBolt("names-spliter", new NamesSpliterBolt(), 2)

.shuffleGrouping("names-reader");

builder.setBolt("names-filter", new NamesFilterSiddhiBolt(), 1)

.shuffleGrouping("names-spliter");

// 启动两个Hello World Task,相同名字发送到同一个Task

builder.setBolt("hello-world", new HelloWorldBolt(), 2)

.fieldsGrouping("names-filter", new Fields("name")); Config conf = new Config();

LocalCluster cluster = new LocalCluster();

cluster.submitTopology("storm-test", conf, builder.createTopology());

}

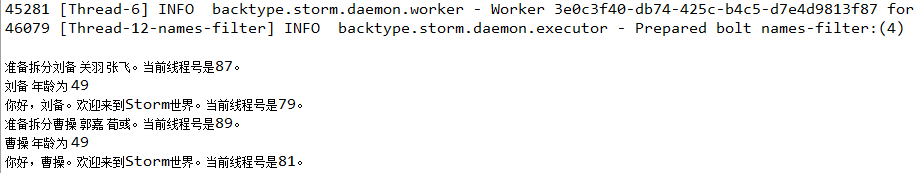

输出如下

Storm集成Siddhi的更多相关文章

- Storm集成Kafka应用的开发

我们知道storm的作用主要是进行流式计算,对于源源不断的均匀数据流流入处理是非常有效的,而现实生活中大部分场景并不是均匀的数据流,而是时而多时而少的数据流入,这种情况下显然用批量处理是不合适的,如果 ...

- storm集成kafka的应用,从kafka读取,写入kafka

storm集成kafka的应用,从kafka读取,写入kafka by 小闪电 0前言 storm的主要作用是进行流式的实时计算,对于一直产生的数据流处理是非常迅速的,然而大部分数据并不是均匀的数据流 ...

- Storm 学习之路(八)—— Storm集成HDFS和HBase

一.Storm集成HDFS 1.1 项目结构 本用例源码下载地址:storm-hdfs-integration 1.2 项目主要依赖 项目主要依赖如下,有两个地方需要注意: 这里由于我服务器上安装的是 ...

- Storm 系列(八)—— Storm 集成 HDFS 和 HBase

一.Storm集成HDFS 1.1 项目结构 本用例源码下载地址:storm-hdfs-integration 1.2 项目主要依赖 项目主要依赖如下,有两个地方需要注意: 这里由于我服务器上安装的是 ...

- storm集成kafka

kafkautil: import java.util.Properties; import kafka.javaapi.producer.Producer; import kafka.produce ...

- Storm集成Kafka的Trident实现

原本打算将storm直接与flume直连,发现相应组件支持比较弱,topology任务对应的supervisor也不一定在哪个节点上,只能采用统一的分布式消息服务Kafka. 原本打算将结构设 ...

- Storm集成Kafka编程模型

原创文章,转载请注明: 转载自http://www.cnblogs.com/tovin/p/3974417.html 本文主要介绍如何在Storm编程实现与Kafka的集成 一.实现模型 数据流程: ...

- Storm 学习之路(七)—— Storm集成 Redis 详解

一.简介 Storm-Redis提供了Storm与Redis的集成支持,你只需要引入对应的依赖即可使用: <dependency> <groupId>org.apache.st ...

- Storm 系列(七)—— Storm 集成 Redis 详解

一.简介 Storm-Redis 提供了 Storm 与 Redis 的集成支持,你只需要引入对应的依赖即可使用: <dependency> <groupId>org.apac ...

随机推荐

- python nose测试框架全面介绍三

三.nose的测试工具集 nose.tools模块提供了一系列的小工具,包括测试执行时间.异常输出及unittest框架中所有的assert功能. 为了使写用例更加容易,nose.tools提供了部分 ...

- 处理 Java Tomcat 的“Cannot allocate memory”错误

参考:https://www.cnblogs.com/rabbitpei/p/6738671.html 启动tomcat报错如下 临时生效 echo 1 > /proc/sys/vm/overc ...

- System.Web.UI.Page.Cache 页面 缓存 清除

这个也是网上查询到方法,不错记录一下! /// <summary> /// 清空所有的Cache /// </summary> public static void Clear ...

- firmware 固件

COMPPUTER SCIENCE AN OVERVIEW 11th Edition firmware 固件 boot loader 引导程序 device driver 设备驱动程序 Basic I ...

- 记录一下自己的.tmux.conf,.vimrc

~/.tmux.conf set -g default-terminal "screen-256color" set -g prefix C-a bind C-a send-pre ...

- 洛谷P3209平面图判定 [HNOI2010] 2-sat

正解:2-sat(并茶几/强连通分量 解题报告: 传送门w 难受死了,连WA5次,正确率又-=INF了QAQ 然后先说下这题怎么做再来吐槽自己QAQ 首先这题其实和NOIp2010的关押罪犯挺像的,然 ...

- 单调栈&单调队列学习笔记!

ummm,,,都是单调系列就都一起学了算了思想应该都差不多呢qwq 其实感觉这俩没有什么可说的鸭QAQ就是维护一个单调的东西,区别在于单调栈是一段进一段出然后单调队列是一段进另一段出?没了 好趴辣重点 ...

- CentOS 6 网络设置

系统配置: 系统硬件:vmware workstation 系统版本:Centos-6.6-x86_64 路由器网关:192.168.1.1 linux系统网络设置须知: 1.主机所有网卡信息配置文件 ...

- 01_Python 基础课程安排

Python 基础课程安排 目标 明确基础班课程内容 课程清单 序号 内容 目标 01 Linux 基础 让大家对 Ubuntu 的使用从很 陌生 达到 灵活操作 02 Python 基础 涵盖 Py ...

- CentOS工作内容(七)禁用IPV6

CentOS工作内容(七)禁用IPV6 用到的快捷键 tab 自动补齐(有不知道的吗) ctrl+a 移动到当前行的开头(a ahead) ctrl+e 移动到当前行的开头(e end) ctrl+u ...