激活函数sigmoid、tanh、relu、Swish

激活函数的作用主要是引入非线性因素,解决线性模型表达能力不足的缺陷

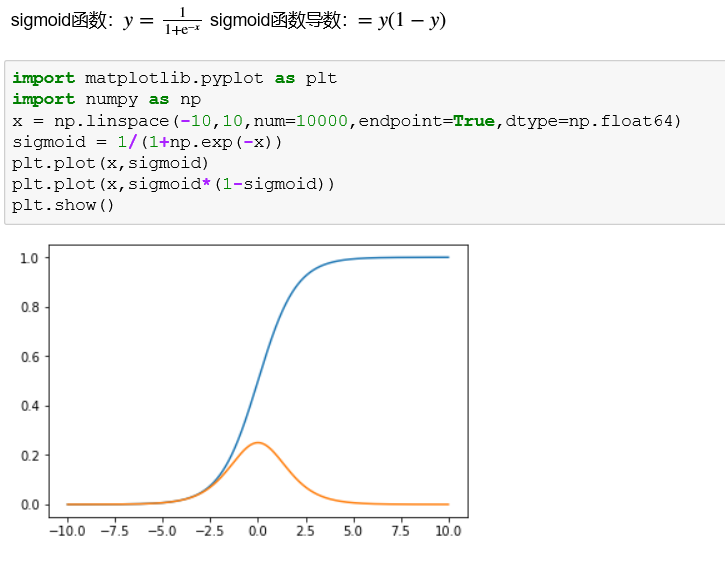

sigmoid函数可以从图像中看出,当x向两端走的时候,y值越来越接近1和-1,这种现象称为饱和,饱和意味着当x=100和x=1000的映射结果是一样的,这种转化相当于将1000大于100的信息丢失了很多,所以一般需要归一化数据。

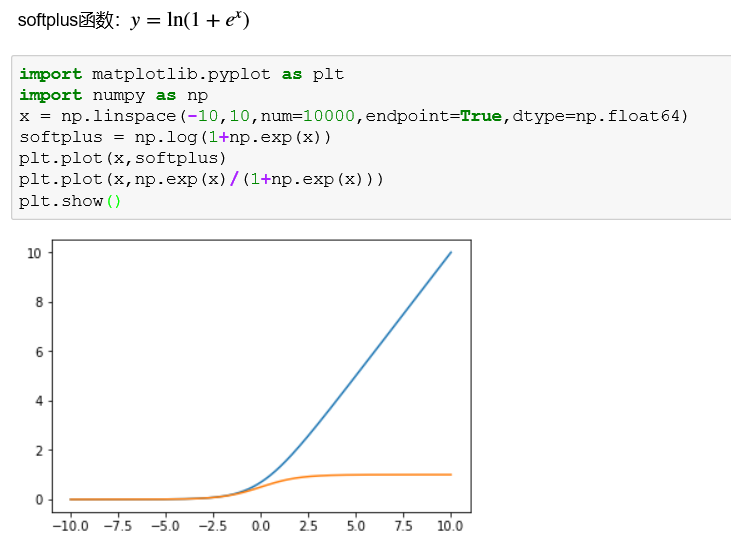

softplus函数相比于relu函数更加平滑,会保存部分小于零的函数,但是计算量也更大了。

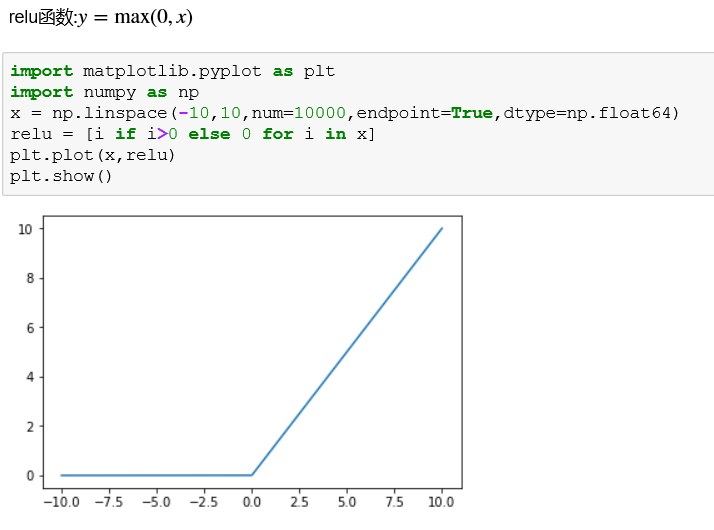

relu函数在信号响应上有很多优势,但是仅仅在正向传播中,由于其对负值全部舍去很容易使模型输出全零而无法训练。例如:随机初始化的w中存在负值,其对应的正值输入特征也就被全部屏蔽了,同理对应的负值输入反而被激活了。因此,一些relu变种被开发,此处不详细讲解。

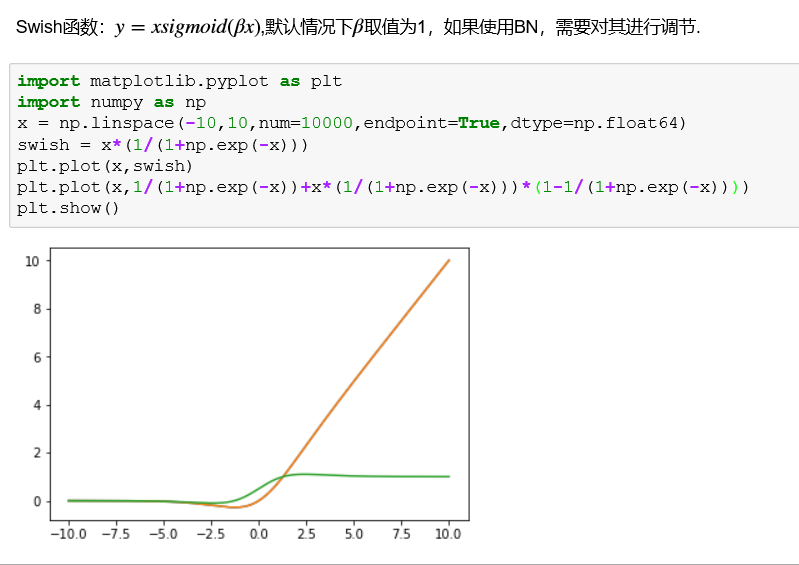

Swish是谷歌公司发现一个效果更优于relu的激活函数:

神经网络激活函数总结:

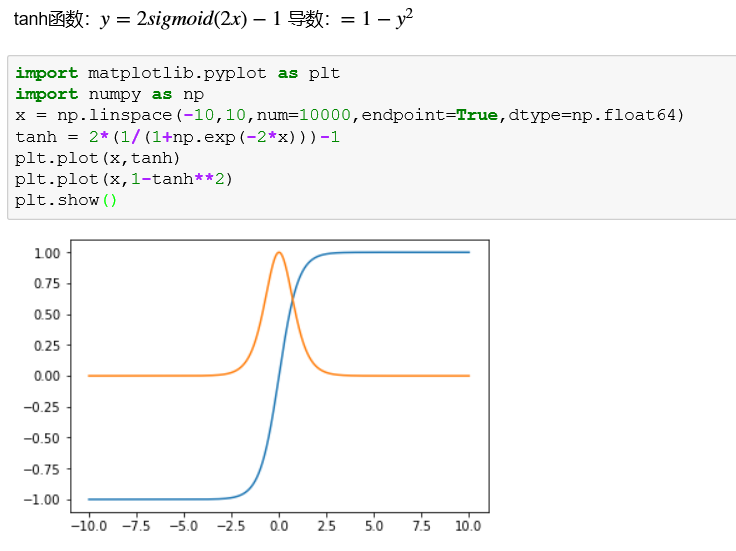

tanh函数适用于特征相差明显时的效果会很好,在循环中会不断扩大特征效果并将其显示出来。但当特征之间相差比较复杂没有明显的区别,或者特征间的相差不是特别大需要细微的分类判断时,sigmoid函数的效果会更好。relu函数的优势在于经过处理后的数据具有很好的稀疏性。

keras中自定义激活函数:

- from keras import backend as K

- from keras.models import Sequential,Model

- from keras.layers import Dense

- import numpy as np

- def Swish(x):

- return x*K.sigmoid(1.0*x)

- model = Sequential()

- model.add(Dense(32,activation="relu",input_dim=100))

- model.add(Dense(16,activation="relu",name="Dense_1"))

- model.add(Dense(1, activation=Swish,name="Dense_2"))

- model.compile(optimizer='rmsprop',loss='binary_crossentropy',metrics=['accuracy'])

- #假设训练和测试使用同一组数据

- data = np.random.random((1000, 100))

- labels = np.random.randint(2, size=(1000, 1))

- model.fit(data,labels,epochs=10,batch_size=32)

- model.predict(data)

激活函数sigmoid、tanh、relu、Swish的更多相关文章

- 深度学习原理与框架-神经网络架构 1.神经网络构架 2.激活函数(sigmoid和relu) 3.图片预处理(减去均值和除标准差) 4.dropout(防止过拟合操作)

神经网络构架:主要时表示神经网络的组成,即中间隐藏层的结构 对图片进行说明:我们可以看出图中的层数分布: input layer表示输入层,维度(N_num, input_dim) N_num表示输 ...

- 激活函数Sigmoid、Tanh、ReLu、softplus、softmax

原文地址:https://www.cnblogs.com/nxf-rabbit75/p/9276412.html 激活函数: 就是在神经网络的神经元上运行的函数,负责将神经元的输入映射到输出端. 常见 ...

- 神经网络激活函数sigmoid relu tanh 为什么sigmoid 容易梯度消失

https://blog.csdn.net/danyhgc/article/details/73850546 什么是激活函数 为什么要用 都有什么 sigmoid ,ReLU, softmax 的比较 ...

- 激活函数(ReLU, Swish, Maxout)

神经网络中使用激活函数来加入非线性因素,提高模型的表达能力. ReLU(Rectified Linear Unit,修正线性单元) 形式如下: \[ \begin{equation} f(x)= \b ...

- 【机器学习】激活函数(ReLU, Swish, Maxout)

https://blog.csdn.net/ChenVast/article/details/81382939 神经网络中使用激活函数来加入非线性因素,提高模型的表达能力. ReLU(Rectifie ...

- 激活函数——sigmoid函数(理解)

0 - 定义 $Sigmoid$函数是一个在生物学中常见的S型函数,也称为$S$型生长曲线.在信息科学中,由于其单增以及反函数单增等性质,$Sigmoid$函数常被用作神经网络的阈值函数,将变量映射到 ...

- TensorFlow(2)Softmax Regression

Softmax Regression Chapter Basics generate random Tensors Three usual activation function in Neural ...

- 激活函数:Sigmod&tanh&Softplus&Relu详解

什么是激活函数? 激活函数(Activation functions)对于人工神经网络模型去学习.理解非常复杂和非线性的函数来说具有十分重要的作用. 它们将非线性特性引入到我们的网络中.其主要目的是将 ...

- 激活函数,Batch Normalization和Dropout

神经网络中还有一些激活函数,池化函数,正则化和归一化函数等.需要详细看看,啃一啃吧.. 1. 激活函数 1.1 激活函数作用 在生物的神经传导中,神经元接受多个神经的输入电位,当电位超过一定值时,该神 ...

随机推荐

- Tomcat服务器启动失败:Could not publish server configuration for Tomcat v8.0 Server at localhost. Multiple Contexts have a path of

在eclipse中使用Tomcat8.0时,出现了如下错误: 解决办法: 在建立Tomcat服务时,eclipse会自动生成一个Servers的项目. 在这个项目中,找到你部署项目的服务文件夹. 在这 ...

- bootstrap在iframe框架中实现由子页面在顶级页面打开模态框(modal)

我需要完成的效果: 1.在顶级页面打开模态框,并且遮罩层也要再顶级页面 2.单击遮罩层部分,模态框不关闭 问题描述: 不知为什么,可能是bootstrap前端框架添加遮罩层的一些问题.通过子页面在顶级 ...

- 深度分析:Android中Mms设置页面更改短信中心号码流程

相关控件初始化方法:showSmscPref private void showSmscPref() { int count = MSimTelephonyManager.getDef ...

- 结合P2P软件使用Ansible分发大文件

一 应用场景描述 现在我需要向50+数量的服务器分发Logstash新版本的rpm包,大概220MB左右,直接使用Ansible的copy命令进行传输,命令如下: 1 ansible all -m ...

- Android 获取联系人和电话号码

获取联系人和电话号码 private void queryContactPhoneNumber() { String[] cols = {ContactsContract.PhoneLookup.DI ...

- JMeter中各种请求格式--aduocd的博客

背景:1.在JMeter的HTTP请求的测试中,经常会使用到不同的请求格式.常用的格式如,json,form-data,x-www-form-urlencoded,multipart/form-dat ...

- UIWebView UITextView

// // ViewController.m // 网页 // #import "ViewController.h" @interface ViewController ()< ...

- 【java规则引擎】《Drools7.0.0.Final规则引擎教程》第4章 4.3 日历

日历 日历可以单独应用于规则中,也可以和timer结合使用在规则中使用.通过属性calendars来定义日历.如果是多个日历,则不同日历之间用逗号进行分割. 在Drools中,日历的概念只是将日历属性 ...

- day8 python学习 集合 深浅拷贝

1.内存地址: 字符串在20位以内,没有空格,没有特殊字符的情况下,同样的字符串内存地址是一样的 2.元组中:在只有一个值的时在后边加逗号和没有逗号的区别 t1=(1) 不加逗号这个值是什么类型就打印 ...

- hasura graphql-engine v1.0.0-alpha26 版本新功能

hasura 发布了graphql-engine v1.0.0-alpha26 版本,有一些破坏的变动,以及方便的新特性 破坏性变动 order_by 从 order_by: id_asc 为 ord ...