Spark-自定义排序

一、自定义排序规则-封装类

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext} /**

* 实现自定义的排序

*/

object MySort1 {

def main(args: Array[String]): Unit = {

//1.spark程序的入口

val conf: SparkConf = new SparkConf().setAppName("MySort1").setMaster("local[2]")

val sc: SparkContext = new SparkContext(conf) //2.创建数组

val girl: Array[String] = Array("Mary,18,80","Jenny,22,100","Joe,30,80","Tom,18,78") //3.转换RDD

val grdd1: RDD[String] = sc.parallelize(girl) //4.切分数据

val grdd2: RDD[Girl] = grdd1.map(line => {

val fields: Array[String] = line.split(",") //拿到每个属性

val name = fields(0)

val age = fields(1).toInt

val weight = fields(2).toInt //元组输出

//(name, age, weight)

new Girl(name, age, weight)

}) // val sorted: RDD[(String, String, Int)] = grdd2.sortBy(t => t._2, false)

// val r: Array[(String, String, Int)] = sorted.collect()

// println(r.toBuffer) val sorted: RDD[Girl] = grdd2.sortBy(s => s)

val r = sorted.collect()

println(r.toBuffer)

sc.stop()

}

} //自定义类 scala Ordered

class Girl(val name: String, val age: Int, val weight: Int) extends Ordered[Girl] with Serializable {

override def compare(that: Girl): Int = {

//如果年龄相同 体重重的往前排

if(this.age == that.age){

//如果正数 正序 负数 倒序

-(this.weight - that.weight)

}else{

//年龄小的往前排

this.age - that.age

} }

override def toString: String = s"名字:$name,年龄:$age,体重:$weight"

}

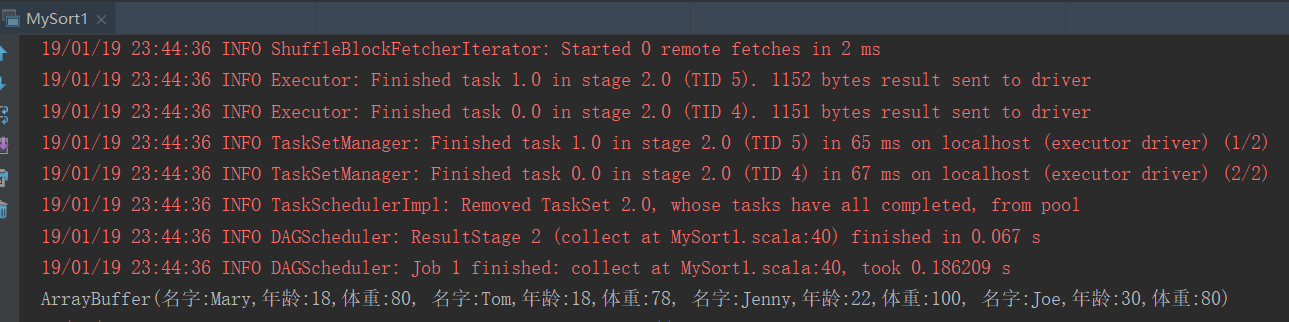

结果:

二、

二、

二、自定义排序规则-模式匹配

import org.apache.spark.{SparkConf, SparkContext}

import org.apache.spark.rdd.RDD

object MySort2 {

def main(args: Array[String]): Unit = {

//1.spark程序的入口

val conf: SparkConf = new SparkConf().setAppName("MySort2").setMaster("local[2]")

val sc: SparkContext = new SparkContext(conf)

//2.创建数组

val girl: Array[String] = Array("Mary,18,80","Jenny,22,100","Joe,30,80","Tom,18,78")

//3.转换RDD

val grdd1: RDD[String] = sc.parallelize(girl)

//4.切分数据

val grdd2: RDD[(String, Int, Int)] = grdd1.map(line => {

val fields: Array[String] = line.split(",")

//拿到每个属性

val name = fields(0)

val age = fields(1).toInt

val weight = fields(2).toInt

//元组输出

(name, age, weight)

})

//5.模式匹配方式进行排序

val sorted = grdd2.sortBy(s => Girl2(s._1, s._2, s._3))

val r = sorted.collect()

println(r.toBuffer)

sc.stop()

}

}

//自定义类 scala Ordered

case class Girl2(val name: String, val age: Int, val weight: Int) extends Ordered[Girl2] {

override def compare(that: Girl2): Int = {

//如果年龄相同 体重重的往前排

if(this.age == that.age){

//如果正数 正序 负数 倒序

-(this.weight - that.weight)

}else{

//年龄小的往前排

this.age - that.age

}

}

override def toString: String = s"名字:$name,年龄:$age,体重:$weight"

}

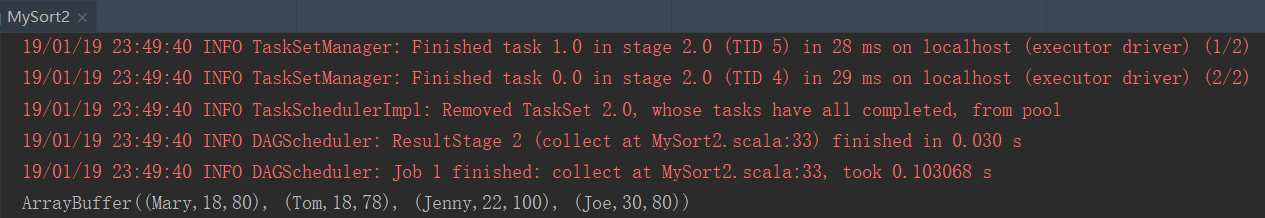

结果:

三、

三、

三、自定义排序规则-隐式转换

import org.apache.spark.{SparkConf, SparkContext}

import org.apache.spark.rdd.RDD

//定义一个专门处理隐式的类

object ImplicitRules {

//定义隐式规则

implicit object OrderingGirl extends Ordering[Girl1]{

override def compare(x: Girl1, y: Girl1): Int = {

if(x.age == y.age){

//体重重的往前排

-(x.weight - y.weight)

}else{

//年龄小的往前排

x.age - y.age

}

}

}

}

object MySort3 {

def main(args: Array[String]): Unit = {

//1.spark程序的入口

val conf: SparkConf = new SparkConf().setAppName("MySort3").setMaster("local[2]")

val sc: SparkContext = new SparkContext(conf)

//2.创建数组

val girl: Array[String] = Array("Mary,18,80","Jenny,22,100","Joe,30,80","Tom,18,78")

//3.转换RDD

val grdd1: RDD[String] = sc.parallelize(girl)

//4.切分数据

val grdd2 = grdd1.map(line => {

val fields: Array[String] = line.split(",")

//拿到每个属性

val name = fields(0)

val age = fields(1).toInt

val weight = fields(2).toInt

//元组输出

(name, age, weight)

})

import ImplicitRules.OrderingGirl

val sorted = grdd2.sortBy(s => Girl1(s._1, s._2, s._3))

val r = sorted.collect()

println(r.toBuffer)

sc.stop()

}

}

//自定义类 scala Ordered

case class Girl1(val name: String, val age: Int, val weight: Int)

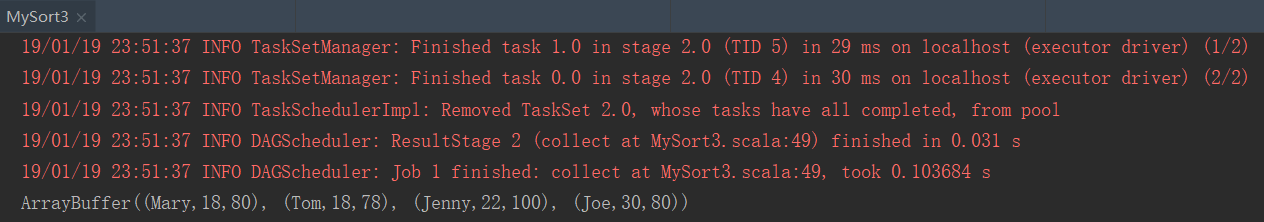

结果:

Spark-自定义排序的更多相关文章

- Spark(三)【RDD中的自定义排序】

在RDD中默认的算子sortBy,sortByKey只能真的值类型数据升序或者降序 现需要对自定义对象进行自定义排序. 一组Person对象 /** * Person 样例类 * @param nam ...

- 大数据学习day22------spark05------1. 学科最受欢迎老师解法补充 2. 自定义排序 3. spark任务执行过程 4. SparkTask的分类 5. Task的序列化 6. Task的多线程问题

1. 学科最受欢迎老师解法补充 day21中该案例的解法四还有一个问题,就是当各个老师受欢迎度是一样的时候,其排序规则就处理不了,以下是对其优化的解法 实现方式五 FavoriteTeacher5 p ...

- Spark基础排序+二次排序(java+scala)

1.基础排序算法 sc.textFile()).reduceByKey(_+_,).map(pair=>(pair._2,pair._1)).sortByKey(false).map(pair= ...

- spark高级排序彻底解秘

排序,真的非常重要! RDD.scala(源码) 在其,没有罗列排序,不是说它不重要! 1.基础排序算法实战 2.二次排序算法实战 3.更高级别排序算法 4.排序算法内幕解密 1.基础排序算法实战 启 ...

- 大数据学习day29-----spark09-------1. 练习: 统计店铺按月份的销售额和累计到该月的总销售额(SQL, DSL,RDD) 2. 分组topN的实现(row_number(), rank(), dense_rank()方法的区别)3. spark自定义函数-UDF

1. 练习 数据: (1)需求1:统计有过连续3天以上销售的店铺有哪些,并且计算出连续三天以上的销售额 第一步:将每天的金额求和(同一天可能会有多个订单) SELECT sid,dt,SUM(mone ...

- Java集合框架实现自定义排序

Java集合框架针对不同的数据结构提供了多种排序的方法,虽然很多时候我们可以自己实现排序,比如数组等,但是灵活的使用JDK提供的排序方法,可以提高开发效率,而且通常JDK的实现要比自己造的轮子性能更优 ...

- DataTable自定义排序

使用JQ DataTable 的时候,希望某列数据可以进行自定义排序,操作如下:(以中文排序和百分比排序为例) 1:定义排序类型: //百分率排序 jQuery.fn.dataTableExt.oSo ...

- 干货之UICollectionViewFlowLayout自定义排序和拖拽手势

使用UICollectionView,需要使用UICollectionViewLayout控制UICollectionViewCell布局,虽然UICollectionViewLayout提供了高度自 ...

- DataGridView 绑定List集合后实现自定义排序

这里只贴主要代码,dataList是已添加数据的全局变量,绑定数据源 datagridview1.DataSource = dataList,以下是核心代码. 实现点击列表头实现自定义排序 priva ...

- 【转】c++中Vector等STL容器的自定义排序

如果要自己定义STL容器的元素类最好满足STL容器对元素的要求 必须要求: 1.Copy构造函数 2.赋值=操作符 3.能够销毁对象的析构函数 另外: 1. ...

随机推荐

- ClamAV病毒软件的安装和使用

ClamAV 杀毒是Linux平台最受欢迎的杀毒软件,ClamAV属于免费开源产品,支持多种平台,如:Linux/Unix.MAC OS X.Windows.OpenVMS.ClamAV是基于病毒扫描 ...

- Android Studio 修改Logcat的颜色

在Android Studio里面默认的logcat显示颜色是灰色的,不同等级的log是没有颜色分别的,如图 这一点远不如Eclipse好看,但是Android Studio的logcat的颜色其实也 ...

- 【摘】50个jQuery代码段帮助你成为一个更好的JavaScript开发者

今 天的帖子会给你们展示50个jQuery代码片段,这些代码能够给你的JavaScript项目提供帮助.其中的一些代码段是从jQuery1.4.2才 开始支持的做法,另一些则是真正有用的函数或方法,他 ...

- Android对touch事件的拦截,在View Tree上的传递顺序

当发生touch事件时,系统会产生一个MotionEvent并且沿着View Tree开始传递.首先获取MotionEvent是View Tree的根节点,根节点通常是一个ViewGroup,View ...

- 【转载】6种.net分布式缓存解决方案

. 使用内置ASP.NET Cache (System.Web.Caching) : https://msdn.microsoft.com/en-us/library/system.web.cachi ...

- Qt编写的RTSP播放器+视频监控(ffmpeg版本)

记得四年前就写了个简易版本的,当时写得非常粗糙,代码实在惨不忍睹,时隔多年后,重新写了个版本,同时还解决了以前不支持6画面8画面切换等异形布局的问题.1:可以用过目录下的rtsp.txt设置要显示的视 ...

- JS - 兼容到ie7的自定义样式的滚动条封装

demo: html: <!DOCTYPE html> <html lang="en"> <head> <meta charset=&qu ...

- css笔记 - transition学习笔记(二)

开始把7,8月份学的css整理一下 transition过渡 1. CSS transition transition过渡 :用于当元素 从一种样式变换为另一种样式 时为元素添加效果. 2. tran ...

- SharpGL学习笔记(六) 裁剪变换

在OpenGL中,除了视景体定义的6个裁剪平面(上下左右前后)外, 用户还可以定义一个或者多个附加的裁剪平面,以去掉场景中无关的目标. 附加平面裁剪函数原型如下: ClipPlane(OpenGL.G ...

- 阿里云ubuntu14.4上部署gogs

以前曾经在centos上部署了gitlab,但因为买的配置比较低,实际效果并不理想,经常卡机.而且,gitlab配置相当麻烦,需要依赖很多被墙包支持.最近在用golang搞开发,顺道发现了gogs这款 ...