Keras GRU 文字识别

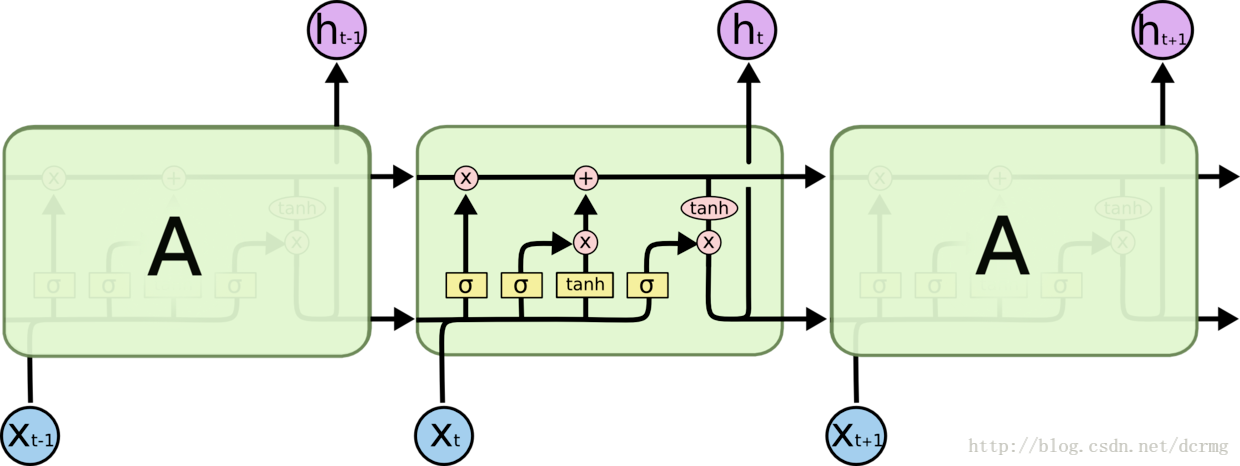

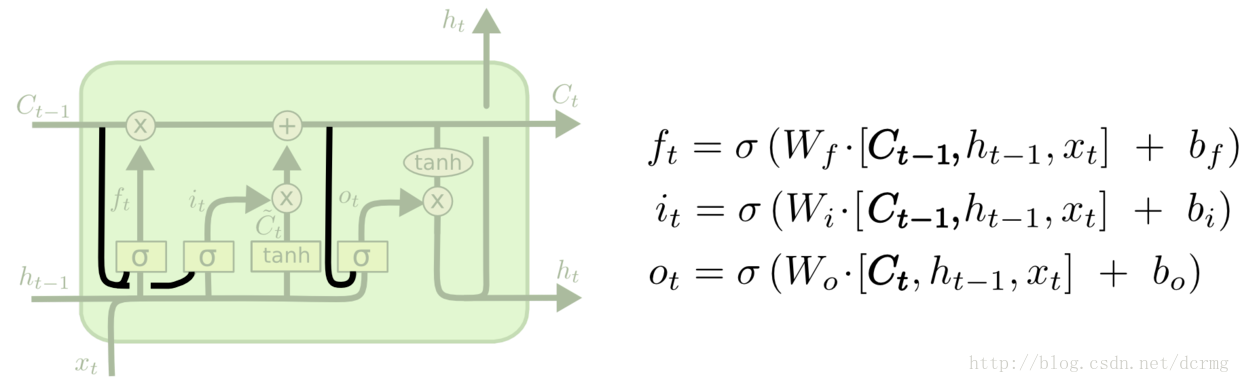

GRU(Gated Recurrent Unit)是LSTM的一个变体,也能克服RNN无法很好处理远距离依赖的问题。

GRU的结构跟LSTM类似,不过增加了让三个门层也接收细胞状态的输入,是常用的LSTM变体之一。

LSTM核心模块:

这一核心模块在GRU中变为:

CTC网络结构定义:

def get_model(height,nclass):

input = Input(shape=(height,None,1),name='the_input')

m = Conv2D(64,kernel_size=(3,3),activation='relu',padding='same',name='conv1')(input)

m = MaxPooling2D(pool_size=(2,2),strides=(2,2),name='pool1')(m)

m = Conv2D(128,kernel_size=(3,3),activation='relu',padding='same',name='conv2')(m)

m = MaxPooling2D(pool_size=(2,2),strides=(2,2),name='pool2')(m)

m = Conv2D(256,kernel_size=(3,3),activation='relu',padding='same',name='conv3')(m)

m = Conv2D(256,kernel_size=(3,3),activation='relu',padding='same',name='conv4')(m)

m = ZeroPadding2D(padding=(0,1))(m)

m = MaxPooling2D(pool_size=(2,2),strides=(2,1),padding='valid',name='pool3')(m)

m = Conv2D(512,kernel_size=(3,3),activation='relu',padding='same',name='conv5')(m)

m = BatchNormalization(axis=1)(m)

m = Conv2D(512,kernel_size=(3,3),activation='relu',padding='same',name='conv6')(m)

m = BatchNormalization(axis=1)(m)

m = ZeroPadding2D(padding=(0,1))(m)

m = MaxPooling2D(pool_size=(2,2),strides=(2,1),padding='valid',name='pool4')(m)

m = Conv2D(512,kernel_size=(2,2),activation='relu',padding='valid',name='conv7')(m)

m = Permute((2,1,3),name='permute')(m)

m = TimeDistributed(Flatten(),name='timedistrib')(m)

m = Bidirectional(GRU(rnnunit,return_sequences=True),name='blstm1')(m)

m = Dense(rnnunit,name='blstm1_out',activation='linear')(m)

m = Bidirectional(GRU(rnnunit,return_sequences=True),name='blstm2')(m)

y_pred = Dense(nclass,name='blstm2_out',activation='softmax')(m)

basemodel = Model(inputs=input,outputs=y_pred)

labels = Input(name='the_labels', shape=[None,], dtype='float32')

input_length = Input(name='input_length', shape=[1], dtype='int64')

label_length = Input(name='label_length', shape=[1], dtype='int64')

loss_out = Lambda(ctc_lambda_func, output_shape=(1,), name='ctc')([y_pred, labels, input_length, label_length])

model = Model(inputs=[input, labels, input_length, label_length], outputs=[loss_out])

sgd = SGD(lr=0.001, decay=1e-6, momentum=0.9, nesterov=True, clipnorm=5)

#model.compile(loss={'ctc': lambda y_true, y_pred: y_pred}, optimizer='adadelta')

model.compile(loss={'ctc': lambda y_true, y_pred: y_pred}, optimizer=sgd)

model.summary()

return model,basemodel____________________________________________________________________________________________________

Layer (type) Output Shape Param # Connected to

====================================================================================================

the_input (InputLayer) (None, 32, None, 1) 0

____________________________________________________________________________________________________

conv1 (Conv2D) (None, 32, None, 64) 640 the_input[0][0]

____________________________________________________________________________________________________

pool1 (MaxPooling2D) (None, 16, None, 64) 0 conv1[0][0]

____________________________________________________________________________________________________

conv2 (Conv2D) (None, 16, None, 128) 73856 pool1[0][0]

____________________________________________________________________________________________________

pool2 (MaxPooling2D) (None, 8, None, 128) 0 conv2[0][0]

____________________________________________________________________________________________________

conv3 (Conv2D) (None, 8, None, 256) 295168 pool2[0][0]

____________________________________________________________________________________________________

conv4 (Conv2D) (None, 8, None, 256) 590080 conv3[0][0]

____________________________________________________________________________________________________

zero_padding2d_1 (ZeroPadding2D) (None, 8, None, 256) 0 conv4[0][0]

____________________________________________________________________________________________________

pool3 (MaxPooling2D) (None, 4, None, 256) 0 zero_padding2d_1[0][0]

____________________________________________________________________________________________________

conv5 (Conv2D) (None, 4, None, 512) 1180160 pool3[0][0]

____________________________________________________________________________________________________

batch_normalization_1 (BatchNorm (None, 4, None, 512) 16 conv5[0][0]

____________________________________________________________________________________________________

conv6 (Conv2D) (None, 4, None, 512) 2359808 batch_normalization_1[0][0]

____________________________________________________________________________________________________

batch_normalization_2 (BatchNorm (None, 4, None, 512) 16 conv6[0][0]

____________________________________________________________________________________________________

zero_padding2d_2 (ZeroPadding2D) (None, 4, None, 512) 0 batch_normalization_2[0][0]

____________________________________________________________________________________________________

pool4 (MaxPooling2D) (None, 2, None, 512) 0 zero_padding2d_2[0][0]

____________________________________________________________________________________________________

conv7 (Conv2D) (None, 1, None, 512) 1049088 pool4[0][0]

____________________________________________________________________________________________________

permute (Permute) (None, None, 1, 512) 0 conv7[0][0]

____________________________________________________________________________________________________

timedistrib (TimeDistributed) (None, None, 512) 0 permute[0][0]

____________________________________________________________________________________________________

blstm1 (Bidirectional) (None, None, 512) 1181184 timedistrib[0][0]

____________________________________________________________________________________________________

blstm1_out (Dense) (None, None, 256) 131328 blstm1[0][0]

____________________________________________________________________________________________________

blstm2 (Bidirectional) (None, None, 512) 787968 blstm1_out[0][0]

____________________________________________________________________________________________________

blstm2_out (Dense) (None, None, 5531) 2837403 blstm2[0][0]

____________________________________________________________________________________________________

the_labels (InputLayer) (None, None) 0

____________________________________________________________________________________________________

input_length (InputLayer) (None, 1) 0

____________________________________________________________________________________________________

label_length (InputLayer) (None, 1) 0

____________________________________________________________________________________________________

ctc (Lambda) (None, 1) 0 blstm2_out[0][0]

the_labels[0][0]

input_length[0][0]

label_length[0][0]

====================================================================================================

Total params: 10,486,715

Trainable params: 10,486,699

模型: 模型包含5500个中文字符,包括常用汉字、大小写英文字符、标点符号、特殊符号(@、¥、&)等,可以在现有模型基础上继续训练。

训练: 样本保存在data文件夹下,使用LMDB格式; train.py是训练文件,可以选择保存模型权重或模型结构+模型权重,训练结果保存在models文件夹下。

测试: test.py是中文OCR测试文件

识别效果:

济南华富锻造有限公司

夺得铜牌后,福民爱流下了激动的泪水。“石川

Itturnedoutthat328girswerenamedAbcdeintheUnitedstates

工程(含训练模型)地址: http://download.csdn.net/download/dcrmg/10248818

Keras GRU 文字识别的更多相关文章

- 图像文字识别(OCR)用什么算法小结

说明:主要考虑深度学习的方法,传统的方法不在考虑范围之内. 1.文字识别步骤 1.1detection:找到有文字的区域(proposal). 1.2classification:识别区域中的文字. ...

- emgucv文字识别

今天讲如何通过emgucv中的函数来实现文字识别.总体的过程可以分为以下几步: 1.读取要识别的图片 2.对图片进行灰度变换 3.调用emgu.cv.ocr的类tessract中的recognize方 ...

- tesseract ocr文字识别Android实例程序和训练工具全部源代码

tesseract ocr是一个开源的文字识别引擎,Android系统中也可以使用.可以识别50多种语言,通过自己训练识别库的方式,可以大大提高识别的准确率. 为了节省大家的学习时间,现将自己近期的学 ...

- 斯坦福第十八课:应用实例:图片文字识别(Application Example: Photo OCR)

18.1 问题描述和流程图 18.2 滑动窗口 18.3 获取大量数据和人工数据 18.4 上限分析:哪部分管道的接下去做 18.1 问题描述和流程图

- 怎么给OCR文字识别软件重编文档页面号码

ABBYY FineReader Pro for Mac OCR文字识别软件处理文档时,在FineReader文档中,页面的加载顺序即是页面的导入顺序,完成导入之后,文档的所有页面均会被编号,各编号会 ...

- 对OCR文字识别软件的扫描选项怎么设置

说到OCR文字识别软件,越来越多的人选择使用ABBYY FineReader识别和转换文档,然而并不是每个人都知道转换质量取决于源图像的质量和所选的扫描选项,今天就给大家普及一下这方面的知识. ABB ...

- 给OCR文字识别软件添加图像的方法

ABBYY FineReader 12是一款OCR图片文字识别软件,而且强大的它现在还可使用快速扫描窗口中的快速打开.扫描并保存为图像或任务自动化任务,在没有进行预处理和OCR的ABBYY FineR ...

- 怎么提高OCR文字识别软件的识别正确率

在OCR文字识别软件当中,ABBYY FineReader是比较好用的程序之一,但再好的识别软件也不能保证100%的识别正确率,用户都喜欢软件的正确率高一些,以减轻识别后修正的负担,很多用户也都提过这 ...

- OCR文字识别软件许可文件被误删了怎么办

使用任何一款软件,都会有误操作的情况发生,比如清理文件时一不小心删除了许可文件,对于ABBYY FineReader 12这样一款OCR文字识别软件,因失误错误删除了许可文件该怎么办呢?今天就来给大家 ...

随机推荐

- IE10、火狐浏、谷歌浏览器 KindEditor无法获取textarea值

http://e-mailwu.blog.163.com/blog/static/651040362013311160913/ 在IE10.火狐浏览器.谷歌浏览器下后台KindEditor在线编辑器无 ...

- c#的yield return

4.1 迭代器块 一个迭代器块(iterator block)是一个能够产生有序的值序列的块.迭代器块和普通语句块的区别就是其中出现的一个或多个yield语句. yield return语句产生迭代的 ...

- MongoDB win32-bit 安装

一念起: 由于本人 用的电脑比较老旧,所以一直用的 是win7 32bit 的操作系统,但是在学习MongoDB的时候 遇到了起步的第一个问题,按照目前 官网最新版MongoDB 3.4.3,已不支持 ...

- Forward Proxy vs Reverse Proxy

Overview We've talked about reverse proxy servers and how they can really be good at protecting the ...

- [国家集训队] Crash 的文明世界(第二类斯特林数)

题目 [国家集训队] Crash 的文明世界 前置 斯特林数\(\Longrightarrow\)斯特林数及反演总结 做法 \[\begin{aligned} ans_x&=\sum\limi ...

- Mysql:实现分组查询拼接未分组同一字段字符group_concat()

Mysql:实现分组查询拼接未分组同一字段字符group_concat() MySQL中,如果想实现将分组之后的多个数据合并到一列,可以使用group_concat函数,如下图所示: 在oralce中 ...

- 配置nginx,Tomcat日志记录请求耗时

由于公司的业务比较特殊,对速度比较在意,客户最近反应我们的平台时间比较久,处理一个请求十秒左右才返回,领导要求找出原因,我想让nginx日志记录请求处理用了多长时间,后端处理用了多长时间,总共用了多长 ...

- [Android]AndFix使用说明

AndFix使用说明 AndFix,全称是Android hot-fix.是阿里开源的一个热补丁框架,允许APP在不重新发布版本的情况下修复线上的bug.支持Android 2.3 到 6.0,并且支 ...

- MySQL的索引实现原理

MySQL数据库索引总结使用索引的原由数据结构Hash.平衡二叉树.B树.B+树区别机械硬盘.固态硬盘区别Myisam与Innodb B+树的区别MySQL中的索引什么数据结构B+树中的节点到底存放多 ...

- 初入Spring-boot(三)

Spring boot 的运行原理 Spring boot关于自动配置的源码在spring-boot-autoconfigure-xxxx.jar内. 一.可以通过下面三种方式查看当前项目中已启用和未 ...