spark集成hbase与hive数据转换与代码练习

帮一个朋友写个样例,顺便练手啦~一直在做平台的各种事,但是代码后续还要精进啊。。。

import java.util.Date import org.apache.hadoop.hbase.HBaseConfiguration

import org.apache.hadoop.hbase.client.{Put, Scan, Result}

import org.apache.hadoop.hbase.io.ImmutableBytesWritable

import org.apache.hadoop.hbase.mapred.TableOutputFormat

import org.apache.hadoop.hbase.mapreduce.TableInputFormat

import org.apache.hadoop.hbase.util.Bytes

import org.apache.hadoop.mapred.JobConf

import org.apache.log4j.{Level, Logger}

import org.apache.spark.rdd.RDD

import org.apache.spark.sql.DataFrame

import org.apache.spark.sql.hive.HiveContext

import org.apache.spark.{SparkContext, SparkConf} /**

* Created by ysy on 2/10/17.

*/

object test { case class ysyTest(LS_certifier_no: String,loc: String,LS_phone_no: String) def main (args: Array[String]) {

val sparkConf = new SparkConf().setMaster("local").setAppName("ysy").set("spark.executor.memory", "1g")

val sc = new SparkContext(sparkConf)

val sqlContext = new HiveContext(sc)

sqlContext.sql("drop table pkq")

val columns = "LS_certifier_no,LS_location,LS_phone_no"

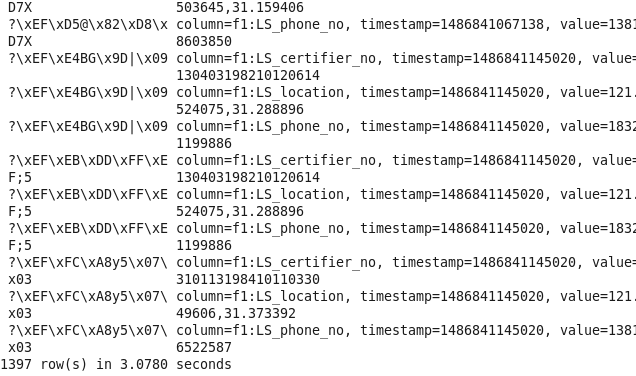

val hbaseRDD = dataInit(sc,"EVENT_LOG_LBS",columns).map(data =>{

val id =Bytes.toString(data._2.getValue("f1".getBytes, "LS_certifier_no".getBytes))

val loc = Bytes.toString(data._2.getValue("f1".getBytes, "LS_location".getBytes))

val phone = Bytes.toString(data._2.getValue("f1".getBytes, "LS_phone_no".getBytes))

(id,loc,phone)

})

val showData = hbaseRDD.foreach(println)

val datas = hbaseRDD.filter(_._1 != null).filter(_._2 != null).filter(_._3 != null)

val hiveDF = initHiveTableFromHbase(sc:SparkContext,sqlContext,datas)

writeHiveTableToHbase(sc,hiveDF) } def initHiveTableFromHbase(sc:SparkContext,sqlContext: HiveContext,hiveRDD:RDD[(String,String,String)]) : DataFrame = {

val hRDD = hiveRDD.map(p => ysyTest(p._1,p._2,p._3))

val hiveRDDSchema = sqlContext.createDataFrame(hiveRDD)

hiveRDDSchema.registerTempTable("pkq")

hiveRDDSchema.show(10)

hiveRDDSchema

} def dataInit(sc : SparkContext,tableName : String,columns : String) : RDD[(ImmutableBytesWritable,Result)] = {

val configuration = HBaseConfiguration.create()

configuration.addResource("hbase-site.xml")

configuration.set(TableInputFormat.INPUT_TABLE,tableName )

val scan = new Scan

val column = columns.split(",")

for(columnName <- column){

scan.addColumn("f1".getBytes(),columnName.getBytes())

}

val hbaseRDD = sc.newAPIHadoopRDD(configuration,classOf[TableInputFormat],classOf[org.apache.hadoop.hbase.io.ImmutableBytesWritable],classOf[org.apache.hadoop.hbase.client.Result])

System.out.println(hbaseRDD.count())

hbaseRDD

} def writeHiveTableToHbase(sc : SparkContext,hiveDF : DataFrame) = {

val configuration = HBaseConfiguration.create()

configuration.addResource("hbase-site.xml ")

configuration.set(TableOutputFormat.OUTPUT_TABLE,"EVENT_LOG_LBS")

val jobConf = new JobConf(configuration)

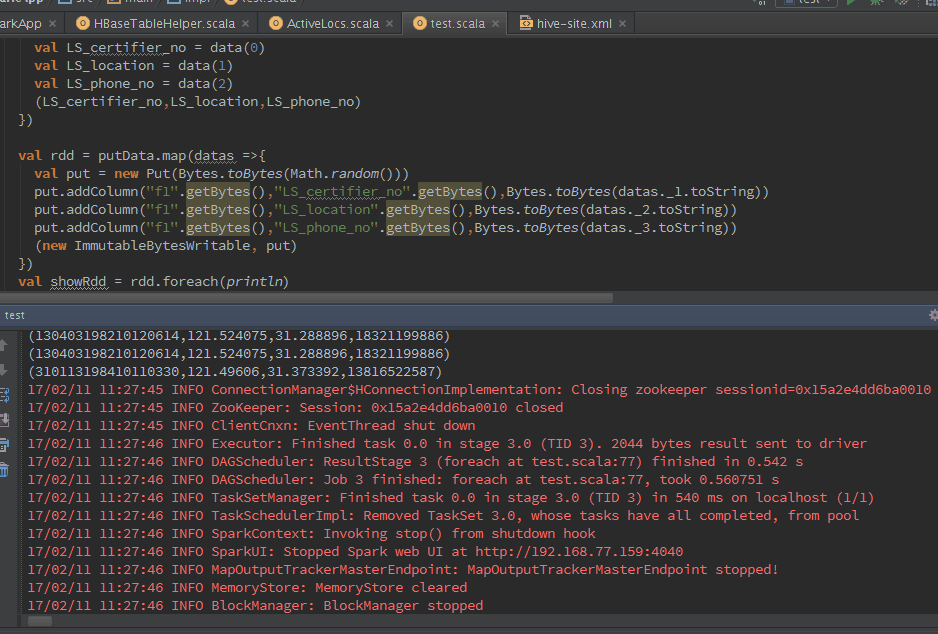

jobConf.setOutputFormat(classOf[TableOutputFormat]) val putData = hiveDF.map(data =>{

val LS_certifier_no = data(0)

val LS_location = data(1)

val LS_phone_no = data(2)

(LS_certifier_no,LS_location,LS_phone_no)

}) val rdd = putData.map(datas =>{

val put = new Put(Bytes.toBytes(Math.random()))

put.addColumn("f1".getBytes(),"LS_certifier_no".getBytes(),Bytes.toBytes(datas._1.toString))

put.addColumn("f1".getBytes(),"LS_location".getBytes(),Bytes.toBytes(datas._2.toString))

put.addColumn("f1".getBytes(),"LS_phone_no".getBytes(),Bytes.toBytes(datas._3.toString))

(new ImmutableBytesWritable, put)

})

val showRdd = rdd.foreach(println)

rdd.saveAsHadoopDataset(jobConf)

} }

spark集成hbase与hive数据转换与代码练习的更多相关文章

- 大数据学习系列之八----- Hadoop、Spark、HBase、Hive搭建环境遇到的错误以及解决方法

前言 在搭建大数据Hadoop相关的环境时候,遇到很多了很多错误.我是个喜欢做笔记的人,这些错误基本都记载,并且将解决办法也写上了.因此写成博客,希望能够帮助那些搭建大数据环境的人解决问题. 说明: ...

- Spark整合HBase,Hive

背景: 场景需求1:使用spark直接读取HBASE表 场景需求2:使用spark直接读取HIVE表 场景需求3:使用spark读取HBASE在Hive的外表 摘要: 1.背景 2.提交脚本 内容 场 ...

- spark集成hive遭遇mysql check失败的问题

问题: spark集成hive,启动spark-shell或者spark-sql的时候,报错: INFO MetaStoreDirectSql: MySQL check failed, assumin ...

- 大数据学习系列之九---- Hive整合Spark和HBase以及相关测试

前言 在之前的大数据学习系列之七 ----- Hadoop+Spark+Zookeeper+HBase+Hive集群搭建 中介绍了集群的环境搭建,但是在使用hive进行数据查询的时候会非常的慢,因为h ...

- HBASE与hive对比使用以及HBASE常用shell操作。与sqoop的集成

2.6.与 Hive 的集成2.6.1.HBase 与 Hive 的对比1) Hive(1) 数据仓库Hive 的本质其实就相当于将 HDFS 中已经存储的文件在 Mysql 中做了一个双射关系,以方 ...

- 大数据技术之_11_HBase学习_02_HBase API 操作 + HBase 与 Hive 集成 + HBase 优化

第6章 HBase API 操作6.1 环境准备6.2 HBase API6.2.1 判断表是否存在6.2.2 抽取获取 Configuration.Connection.Admin 对象的方法以及关 ...

- Hbase与hive集成与对比

HBase与Hive的对比 1.Hive (1) 数据仓库 Hive的本质其实就相当于将HDFS中已经存储的文件在Mysql中做了一个双射关系,以方便使用HQL去管理查询. (2) 用于数据分析.清洗 ...

- hbase与Hive的集成

1 HBase与Hive的对比 1.Hive (1) 数据仓库 Hive的本质其实就相当于将HDFS中已经存储的文件在Mysql中做了一个双射关系,以方便使用HQL去管理查询. (2) 用于数据分析. ...

- Hive集成HBase;安装pig

Hive集成HBase 配置 将hive的lib/中的HBase.jar包用实际安装的Hbase的jar包替换掉 cd /opt/hive/lib/ ls hbase-0.94.2* rm -rf ...

随机推荐

- vue-cli的webpack模版项目配置解析-build/dev-server.js

我们在使用vue-cli搭建vuejs项目(Vuejs实例-01使用vue-cli脚手架搭建Vue.js项目)的时候,会自动生成一系列文件,其中就包含webpack配置文件.我们现在来看下,这些配置到 ...

- ObjectiveC 深浅拷贝学习

在ObjC中,什么是深浅拷贝? 深浅拷贝分别指深拷贝和浅拷贝,即mutableCopy和copy方法. copy复制一个不可变对象,而mutableCopy复制一个mutable可变对象. 什么时候用 ...

- linux的nvme驱动参数调优

nvme的设备,可以调优的参数比较少,相关的代码如下: blk_sysfs.c static struct queue_sysfs_entry queue_requests_entry = { .at ...

- mybatis实战教程三:mybatis和springmvc整合

一.搭建maven环境,引入相关jar 参考demo 二.写web.xml <?xml version="1.0" encoding="UTF-8"?&g ...

- linux批量添加10个用户并将其随机密码和用户名写入文件

需求: 批量新建10个测试用户,并且让其密码随机,把用户名和密码写入一个文件,并有创建时间和创建者 #!/usr/bin/python # -*- coding: utf-8 -*- import o ...

- CentOS如何把deb转为rpm

说明:可以转换,但不一定可用,可以根据报错提示,安装需要的依赖. 1 安装alien工具,下载地址http://ftp.de.debian.org/debian/pool/main/a/alien/ ...

- finally中关闭资源

对finally中关闭资源是否还要使用try...catch老是感到迷惑,现在存个例子,省的忘了 public StringBuilder readTxtFile(File file){ String ...

- ClearCase config_spec

1.使用分支前要在vob创建branch type,Config_Spec不能自动创建branch type: 2.如果可能,最好在以前确定的label上进行新的工作,避免维护复杂的config_s ...

- Spring MVC 基础笔记

spring mvc功能: 以Controller为中心完成对系统流程的控制管理 从请求中搜集数据 对传入的参数进行验证 将结果返回给视图 针对不同的视图提供不同的解决方案 针对jsp视图技术提供标签 ...

- C# Linq基本常用用法

1.什么是Linq? Lanaguage Interated Query(语言集成查询),Linq 是集成C# 和VB这些语言中用于提供数据查询能力的一个新特性. 这里只介绍两种基本常用用法. 学习方 ...