SpringCloud学习之SpringCloudStream&集成kafka

一、关于Spring-Cloud-Stream

Spring Cloud Stream本质上就是整合了Spring Boot和Spring Integration,实现了一套轻量级的消息驱动的微服务框架。通过使用Spring Cloud Stream,可以有效地简化开发人员对消息中间件的使用复杂度,让系统开发人员可以有更多的精力关注于核心业务逻辑的处理。

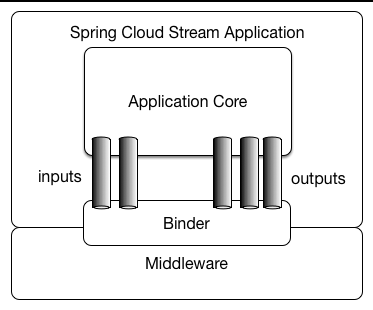

在这里我先放一张官网的图:

应用程序通过Spring Cloud Stream注入到输入和输出通道与外界进行通信。根据此规则我们很容易的实现消息传递,订阅消息与消息中转。并且当需要切换消息中间件时,几乎不需要修改代码,只需要变更配置就行了。

在用例图中 Inputs代表了应用程序监听消息 、outputs代表发送消息、binder的话大家可以理解为将应用程序与消息中间件隔离的抽象,类似于三层架构下利用dao屏蔽service与数据库的实现的原理。

springcloud默认提供了rabbitmq与kafka的实现。

二、springcloud集成kafka

1、添加gradle依赖:

dependencies{

compile('org.springframework.cloud:spring-cloud-stream')

compile('org.springframework.cloud:spring-cloud-stream-binder-kafka')

compile('org.springframework.kafka:spring-kafka')

}

2、定义一个接口:

spring-cloud-stream已经给我们定义了最基本的输入与输出接口,他们分别是 Source,Sink, Processor

Sink接口:

package org.springframework.cloud.stream.messaging; import org.springframework.cloud.stream.annotation.Input;

import org.springframework.messaging.SubscribableChannel; public interface Sink {

String INPUT = "input"; @Input("input")

SubscribableChannel input();

}

Source接口:

package org.springframework.cloud.stream.messaging; import org.springframework.cloud.stream.annotation.Output;

import org.springframework.messaging.MessageChannel; public interface Source {

String OUTPUT = "output"; @Output("output")

MessageChannel output();

}

Processor接口:

package org.springframework.cloud.stream.messaging;

public interface Processor extends Source, Sink {

}

这里面Processor这个接口既定义输入通道又定义了输出通道。同时我们也可以自己定义通道接口,代码如下:

package com.bdqn.lyrk.shop.channel; import org.springframework.cloud.stream.annotation.Input;

import org.springframework.cloud.stream.annotation.Output;

import org.springframework.messaging.MessageChannel;

import org.springframework.messaging.SubscribableChannel; public interface ShopChannel { /**

* 发消息的通道名称

*/

String SHOP_OUTPUT = "shop_output"; /**

* 消息的订阅通道名称

*/

String SHOP_INPUT = "shop_input"; /**

* 发消息的通道

*

* @return

*/

@Output(SHOP_OUTPUT)

MessageChannel sendShopMessage(); /**

* 收消息的通道

*

* @return

*/

@Input(SHOP_INPUT)

SubscribableChannel recieveShopMessage(); }

3、定义服务类

package com.bdqn.lyrk.shop.server; import com.bdqn.lyrk.shop.channel.ShopChannel;

import org.springframework.cloud.stream.annotation.StreamListener;

import org.springframework.messaging.Message;

import org.springframework.messaging.MessageChannel;

import org.springframework.messaging.support.MessageBuilder;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RestController; import javax.annotation.Resource; @RestController

public class ShopService { @Resource(name = ShopChannel.SHOP_OUTPUT)

private MessageChannel sendShopMessageChannel; @GetMapping("/sendMsg")

public String sendShopMessage(String content) {

boolean isSendSuccess = sendShopMessageChannel.

send(MessageBuilder.withPayload(content).build());

return isSendSuccess ? "发送成功" : "发送失败";

} @StreamListener(ShopChannel.SHOP_INPUT)

public void receive(Message<String> message) {

System.out.println(message.getPayload());

}

}

这里面大家注意 @StreamListener。这个注解可以监听输入通道里的消息内容,注解里面的属性指定我们刚才定义的输入通道名称,而MessageChannel则可以通过

输出通道发送消息。使用@Resource注入时需要指定我们刚才定义的输出通道名称

4、定义启动类

package com.bdqn.lyrk.shop; import com.bdqn.lyrk.shop.channel.ShopChannel;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.stream.annotation.EnableBinding; @SpringBootApplication

@EnableBinding(ShopChannel.class)

public class ShopServerApplication { public static void main(String[] args) {

SpringApplication.run(ShopServerApplication.class, args);

}

}

注意@EnableBinding注解,这个注解指定刚才我们定义消息通道的接口名称,当然这里也可以传多个相关的接口

5、定义application.yml文件

spring:

application:

name: shop-server

cloud:

stream:

bindings:

#配置自己定义的通道与哪个中间件交互

shop_input: #ShopChannel里Input和Output的值

destination: zhibo #目标主题

shop_output:

destination: zhibo

default-binder: kafka #默认的binder是kafka

kafka:

bootstrap-servers: localhost:9092 #kafka服务地址

consumer:

group-id: consumer1

producer:

key-serializer: org.apache.kafka.common.serialization.ByteArraySerializer

value-serializer: org.apache.kafka.common.serialization.ByteArraySerializer

client-id: producer1

server:

port: 8100

这里是重头戏,我们必须指定所有通道对应的消息主题,同时指定默认的binder为kafka,紧接着定义Spring-kafka的外部化配置,在这里指定producer的序列化类为ByteArraySerializer

启动程序成功后,我们访问 http://localhost:8100/sendMsg?content=2 即可得到如下结果

SpringCloud学习之SpringCloudStream&集成kafka的更多相关文章

- springcloud 集成kafka问题记录,发消息报错:ERROR o.s.kafka.support.LoggingProducerListener - Exception thrown when sending a message with key='null' and payload='{-1,

在springcloud集成kafka,发送消息时报错: 2018-08-15 16:01:34.159 [http-nio-8081-exec-1] INFO org.apache.kafka.c ...

- springcloud集成kafka

项目名称:布控预警 水平拆分出来的项目,作为一个单独的可以对外提供服务的项目 项目设计:springcloud,可以集成各个不同平台的一个作为对外提供的微服务项目 项目功能:实现各个平台和本平台之间的 ...

- SpringCloud学习之Ribbon

一.负载均衡与Ribbon 负载均衡,在集群中是很常见的一个“名词”,顾名思义是根据一定的算法将请求分摊至对应的服务节点上,常见的算法有如下几种: 轮询法:所有请求被依次分发到每台应用服务器上,每台服 ...

- springCloud学习总览

写完最后一篇特意去看了看第一篇是什么时候写的---2018/11/19,到现在三个月多一点,总的来说这三个月通过<Spring 微服务实战>这本书,算是对微服务进行了一次扫盲学习. ...

- SpringCloud学习心得—1.3—Eureka与REST API

SpringCloud学习心得—1.3—Eureka与REST API Eureka的REST API接口 API的基本访问 Eureka REST APIEureka 作为注册中心,其本质是存储 ...

- SpringCloudStream(RabbitMQ&Kafka)&Spring-Kafka配置使用

目录 是什么 解决问题 使用方式 创建生产者项目 pom yml 生产消息方法 接口 实现 创建消费者项目 pom yml 接收消息方法 重复消费 消费者yml 持久化 消费者负载个性配置(预拉取) ...

- Storm集成Kafka应用的开发

我们知道storm的作用主要是进行流式计算,对于源源不断的均匀数据流流入处理是非常有效的,而现实生活中大部分场景并不是均匀的数据流,而是时而多时而少的数据流入,这种情况下显然用批量处理是不合适的,如果 ...

- Windows phone 8 学习笔记(9) 集成

原文:Windows phone 8 学习笔记(9) 集成 本节整理了之前并没有提到的Windows phone 8 系统相关集成支持,包括选择器.锁定屏幕的.联系人的访问等.选择器列举了若干内置应用 ...

- SpringCloud学习之feign

一.关于feigin feigin是一种模板化,声明式的http客户端,feign可以通过注解绑定到接口上来简化Http请求访问.当然我们也可以在创建Feign对象时定制自定义解码器(xml或者jso ...

随机推荐

- JVM笔记7-内存分配与回收策略

1.对象优先在Eden分配 大多数情况下,对象在新生代Eden区中分配.当Eden区中没有足够空间分配时,虚拟机将发起一次Minor GC.虚拟机提供了-XX:PrintGCDetails 这个收集器 ...

- linux 下 nc 命令的使用

netcat被誉为网络安全界的'瑞士军刀',一个简单而有用的工具,透过使用TCP或UDP协议的网络连接去读写数据.它被设计成一个稳定的后门工具,能够直接由其它程序和脚本轻松驱动.同时,它也是一个功能强 ...

- JAVA_SE基础——31.this关键字

黑马程序员入学blog... 也算是学习笔记体会. this的通俗解释: 有一个A类,一个B方法,一个C变量,其中B和C都在类A中 this.B()就是调用A类中的B方法 this.C=1(假设C是一 ...

- Win7添加php环境变量.

1) "我的电脑"右键"属性"->高级系统设置->环境变量->系统变量->Path->编辑 2) 将PHP的执行路径的目录&quo ...

- [2]十道算法题【Java实现】

前言 清明不小心就拖了两天没更了-- 这是十道算法题的第二篇了-上一篇回顾:十道简单算法题 最近在回顾以前使用C写过的数据结构和算法的东西,发现自己的算法和数据结构是真的薄弱,现在用Java改写一下, ...

- Java Class文件格式详解

magic[4字节] 魔数,用来判断是否可以被虚拟机使用.固定值为0xCAFEBABE(咖啡宝贝)minor_version[2字节] 次版本号major_version[2字节] 主版本号,低版本的 ...

- Codeforces Round #441 (Div. 2, by Moscow Team Olympiad) A. Trip For Meal

http://codeforces.com/contest/876/problem/A 题意: 一个人一天要吃n次蜂蜜,他有3个朋友,他第一次总是在一个固定的朋友家吃蜂蜜,如果说没有吃到n次,那么他就 ...

- spark算子:partitionBy对数据进行分区

def partitionBy(partitioner: Partitioner): RDD[(K, V)] 该函数根据partitioner函数生成新的ShuffleRDD,将原RDD重新分区. s ...

- ps图层的基本使用

图层的使用 图层的基本使用一:复制,选择多个,背景图上添加图片,同时移动多个图层 复制图层:图层里的内容位置会变化,而拷贝的图层,图层里的位置不变,跟原来的图层一样 选择多个图层:shift选中多个图 ...

- FTP下载文件

linux命令方式下载 step1: >>ftp ip port 根据提示输入用户名 根据提示输入用户密码 >>cd 目录(重要:一定要进入文件所在的目录) >>g ...