zpar使用方法之Chinese Word Segmentation

第一步在这里:

http://people.sutd.edu.sg/~yue_zhang/doc/doc/qs.html

你可以找到这句话,

所以在命令行中分别敲入

make zpar

make zpar.zh(中文)

make zpar.en(英文)

这时会生成一个dist文件夹 在里面你可以找到(如果做了英文的 还会有一个zpar.en)

之后进http://people.sutd.edu.sg/~yue_zhang/doc/doc/segmentor.html

这里做的是分词

第二步如何编译:

如何编译:敲入make segmentor

你将在dist目录下看到生成一个文件夹segmentor

在这里会有

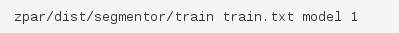

这两个文件 train是用来训练模型的 segmentor是用来用训练好的模型做分词的

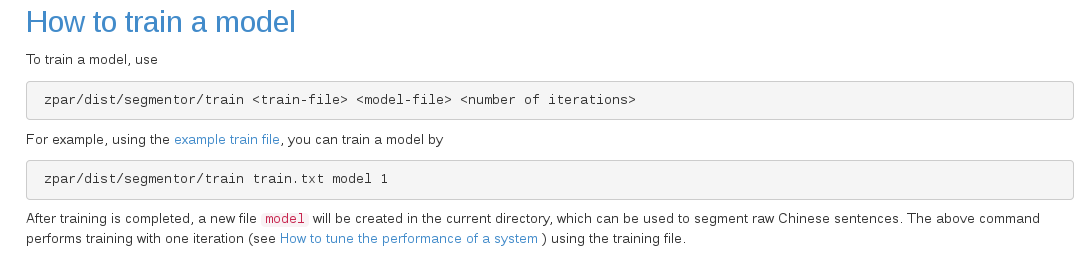

第三步那么如何训练模型呢?

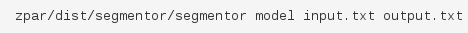

由于train 和segmentor是两个可执行文件 所以要进入到所生成他们的目录下给定好输入文本的位置 生成模型的位置以及名称 和迭代次数

这里model就是所生成模型的名称,当然也可以起别的名字,这不是一个关键字。后面的1就是迭代次数

这里的train.txt好像要utf-8编码。。。反正我直接从 下载的文本。

下载的文本。

训练结束你可以找到

例子中没给路径就应该是在zpar底下

第四步如何分词:

敲入:

这里的model就是你训练出来的模型,如果你不是放在zpar下记得写出路径

太罗嗦了 就是记得把他们的路径写对

输入的文本也可以从an example input下载

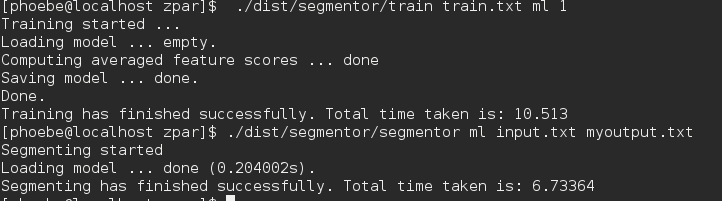

这时你就可以找到你的output.txt了

应该是分好词的

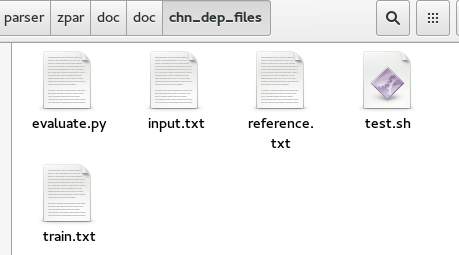

第五步评估;

记得去下载evaluate.py这个脚本还有reference.txt

然后执行这个脚本

然后你能看到准确率 召回率 和F-score

F-score其实很简单

两个最常见的衡量指标是“准确率(precision)”(你给出的结果有多少是正确的)和“召回率(recall)”(正确的结果有多少被你给出了)

这

两个通常是此消彼长的(trade

off),很难兼得。很多时候用参数来控制,通过修改参数则能得出一个准确率和召回率的曲线(ROC),这条曲线与x和y轴围成的面积就是AUC(ROC

Area)。AUC可以综合衡量一个预测模型的好坏,这一个指标综合了precision和recall两个指标。

但AUC计算很麻烦,有人用简单的F-score来代替。F-score计算方法很简单:

F-score=(2*precision*recall)/(precision+recall)

即使不是算数平均,也不是几何平均。可以理解为几何平均的平方除以算术平均。

第六步写脚本

终于到了最后一步了。。。你去这个目录下看test.sh你会发现什么???自己去看吧。要是运行不出来这个脚本就发动你的智慧稍微改动一下。相信你能运行出来的

zpar使用方法之Chinese Word Segmentation的更多相关文章

- 长短时间记忆的中文分词 (LSTM for Chinese Word Segmentation)

翻译学长的一片论文:Long Short-Term Memory Neural Networks for Chinese Word Segmentation 传统的neural Model for C ...

- Solution for automatic update of Chinese word segmentation full-text index in NEO4J

Solution for automatic update of Chinese word segmentation full-text index in NEO4J 1. Sample data 2 ...

- onvif规范的实现:onvif开发常用调试方法 和常见的segmentation fault错误

在前几篇中,虽然已经实现了rtsp视频流的对接,但是还要做的工作还非常多,onvif本来就是一个覆盖面非常广的一个协议,每一个功能都要填充大量的函数.而且稍不注意就会出现segmentation fa ...

- Chinese word segment based on character representation learning 论文笔记

论文名和编号 摘要/引言 相关背景和工作 论文方法/模型 实验(数据集)及 分析(一些具体数据) 未来工作/不足 是否有源码 问题 原因 解决思路 优势 基于表示学习的中文分词 编号:1001-908 ...

- 论文阅读及复现 | Effective Neural Solution for Multi-Criteria Word Segmentation

主要思想 这篇文章主要是利用多个标准进行中文分词,和之前复旦的那篇文章比,它的方法更简洁,不需要复杂的结构,但比之前的方法更有效. 方法 堆叠的LSTM,最上层是CRF. 最底层是字符集的Bi-LST ...

- ANSJ中文分词使用方法

一.前言 之前做solr索引的时候就使用了ANSJ进行中文分词,用着挺好,然而当时没有写博客记录的习惯.最近又尝试了好几种JAVA下的中文分词库,个人感觉还是ANSJ好用,在这里简单总结之. 二.什么 ...

- 11大Java开源中文分词器的使用方法和分词效果对比,当前几个主要的Lucene中文分词器的比较

本文的目标有两个: 1.学会使用11大Java开源中文分词器 2.对比分析11大Java开源中文分词器的分词效果 本文给出了11大Java开源中文分词的使用方法以及分词结果对比代码,至于效果哪个好,那 ...

- ES-自然语言处理之中文分词器

前言 中文分词是中文文本处理的一个基础步骤,也是中文人机自然语言交互的基础模块.不同于英文的是,中文句子中没有词的界限,因此在进行中文自然语言处理时,通常需要先进行分词,分词效果将直接影响词性.句法树 ...

- nlp总结

中科院nlpir和海量分词(http://www.hylanda.com/)是收费的. hanlp:推荐基于CRF的模型的实现~~要看语料,很多常用词会被分错,所以需要词库支撑.目前最友好的开源工具包 ...

随机推荐

- shipyard 中文版安装 -- Docker web管理

#本文使用markdown文档格式 #Docker web管理平台 #shipyard 中文版安装 #hipyard可对容器.镜像.仓库.docker节点进行管理的web系统 #+++++++++++ ...

- Cache与主存之间的全相联映射,直接映射和组相联映射的区别

2017-02-22 注:本文并非原创,来自百度文库,只是觉得写得较好,故分享之.若是某人的知识产权,望告知!谢谢 1.高速缓冲存储器的功能.结构与工作原理 高速缓冲存储器是存在于主存与CPU之间的一 ...

- servlet实现多文件打包下载

当用户一次下载多个文件时.普通情况是,每下载一个文件,均要弹出一个下载的对话框.这给用户造成了非常大不便. 比較理想的情况是,用户选择多个文件后.server后端直接将多个文件打包为zip.以下贴出实 ...

- 前端 Dom 直接选择器

文档对象模型(Document Object Model,DOM)是一种用于HTML和XML文档的编程接口.它给文档提供了一种结构化的表示方法,可以改变文档的内容和呈现方式.我们最为关心的是,DOM把 ...

- SSH secure shell 原理与运用

转: http://www.ruanyifeng.com/blog/2011/12/ssh_remote_login.html 作者: 阮一峰 日期: 2011年12月21日 SSH是每一台Linux ...

- 《Oracle RAC性能优化》

一 RAC环境 RAC架构,2节点信息 节点1 SQL> show parameter instance NAME TYPE ...

- Oracle优化-SQL_TRACE

思维导图 Oracle优化10-SQL_TRACE解读 Oracle优化11-10046事件 概述 当我们想了解一条SQL或者是PL/SQL包的运行情况时,特别是当他们的性能非常差时,比如有的时候看起 ...

- 转载SQL_trace 和10046使用

SQL_TRACE是Oracle提供的用于进行SQL跟踪的手段,是强有力的辅助诊断工具.在日常的数据库问题诊断和解决中,SQL_TRACE是非常常用的方法.本文就SQL_TRACE的使用作简单探讨,并 ...

- Jquery each循环用法小结

var str = res.ZhaoPian; var piclist = str.substring(0, str.length - 1).split(','); $.each(piclist, f ...

- 开源一款android 偷拍 app【静拍】豌豆荚、flyme商店已经上线

首先先花3秒时间,预览下下app的大概是做啥的,解决啥痛点的:) app: 本地下载地址 需求点: 1:音量键可以拍照 2:没有快门声.闪光灯 3:锁屏下.或者是在其他程序界面都可以拍照 思路: 1: ...