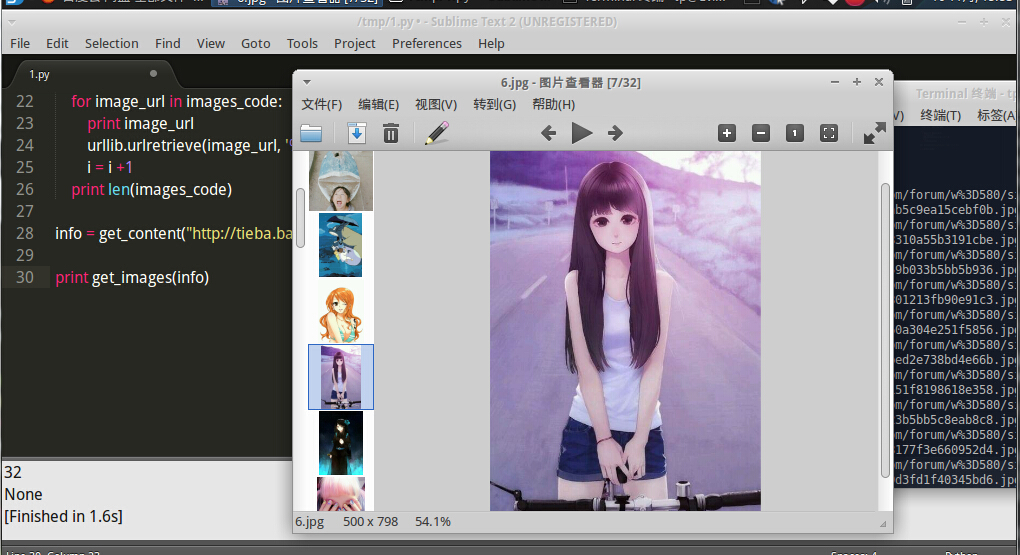

Python 爬虫学习 网页图片下载

- 使用正则表达式匹配

# coding:utf-8 import re

import urllib def get_content(url):

""" Evilxr, """

html = urllib.urlopen(url)

content = html.read()

html.close()

return content def get_images(info):

"""" Download Baidu pictures.

<img class="BDE_Image" src="http:*****">

"""

regex = r' class="BDE_Image" src="(.+?\.jpg)" '

pat = re.compile(regex)

images_code = re.findall(pat, info) i = 0

for image_url in images_code:

print image_url

urllib.urlretrieve(image_url, '%s.jpg' % i)

i = i +1

print len(images_code) info = get_content("http://tieba.baidu.com/p/2299704181")

print get_images(info)

- 使用第三方库BeautifulSoup匹配

# 安装 sudo pip install beautifulsoup4

# coding:utf-8 import urllib

from bs4 import BeautifulSoup def get_content(url):

""" Evilxr, """

html = urllib.urlopen(url)

content = html.read()

html.close()

return content def get_images(info):

"""

使用BeautifulSoup在网页源码中匹配图片地址

"""

soup = BeautifulSoup(info)

all_img = soup.find_all('img', class_="BDE_Image" ) i = 1 for img in all_img:

print img['src']

urllib.urlretrieve(img['src'], '%s.jpg' % i)

i = i +1

print "一共下载了 ", len(all_img), "张图片" info = get_content("http://tieba.baidu.com/p/3368845086") print get_images(info)

Python 爬虫学习 网页图片下载的更多相关文章

- Python爬虫之网页图片抓取

一.引入 这段时间一直在学习Python的东西,以前就听说Python爬虫多厉害,正好现在学到这里,跟着小甲鱼的Python视频写了一个爬虫程序,能实现简单的网页图片下载. 二.代码 __author ...

- python爬虫学习(1) —— 从urllib说起

0. 前言 如果你从来没有接触过爬虫,刚开始的时候可能会有些许吃力 因为我不会从头到尾把所有知识点都说一遍,很多文章主要是记录我自己写的一些爬虫 所以建议先学习一下cuiqingcai大神的 Pyth ...

- Python实战:美女图片下载器,海量图片任你下载

Python应用现在如火如荼,应用范围很广.因其效率高开发迅速的优势,快速进入编程语言排行榜前几名.本系列文章致力于可以全面系统的介绍Python语言开发知识和相关知识总结.希望大家能够快速入门并学习 ...

- Python实战:Python爬虫学习教程,获取电影排行榜

Python应用现在如火如荼,应用范围很广.因其效率高开发迅速的优势,快速进入编程语言排行榜前几名.本系列文章致力于可以全面系统的介绍Python语言开发知识和相关知识总结.希望大家能够快速入门并学习 ...

- python爬虫学习视频资料免费送,用起来非常666

当我们浏览网页的时候,经常会看到像下面这些好看的图片,你是否想把这些图片保存下载下来. 我们最常规的做法就是通过鼠标右键,选择另存为.但有些图片点击鼠标右键的时候并没有另存为选项,或者你可以通过截图工 ...

- Python爬虫学习:四、headers和data的获取

之前在学习爬虫时,偶尔会遇到一些问题是有些网站需要登录后才能爬取内容,有的网站会识别是否是由浏览器发出的请求. 一.headers的获取 就以博客园的首页为例:http://www.cnblogs.c ...

- python爬虫学习笔记(一)——环境配置(windows系统)

在进行python爬虫学习前,需要进行如下准备工作: python3+pip官方配置 1.Anaconda(推荐,包括python和相关库) [推荐地址:清华镜像] https://mirrors ...

- python爬虫学习01--电子书爬取

python爬虫学习01--电子书爬取 1.获取网页信息 import requests #导入requests库 ''' 获取网页信息 ''' if __name__ == '__main__': ...

- python爬虫抓网页的总结

python爬虫抓网页的总结 更多 python 爬虫 学用python也有3个多月了,用得最多的还是各类爬虫脚本:写过抓代理本机验证的脚本,写过在discuz论坛中自动登录自动发贴的脚本,写过自 ...

随机推荐

- for_each使用方法详解[转]

for_each使用方法详解[转] Abstract之前在(原創) 如何使用for_each() algorithm? (C/C++) (STL)曾經討論過for_each(),不過當時功力尚淺,只談 ...

- SVN+Apache域用户认证配置方法_Windows(转,重新排版,部分内容更新优化)

欢迎和大家交流技术相关问题: 邮箱: jiangxinnju@163.com 博客园地址: http://www.cnblogs.com/jiangxinnju GitHub地址: https://g ...

- Python爬虫:一些常用的爬虫技巧总结

爬虫在开发过程中也有很多复用的过程,这里总结一下,以后也能省些事情. 1.基本抓取网页 get方法 import urllib2 url = "http://www.baidu.com&qu ...

- Mac 安装mysql

下载mysql-5.7.14-osx10.11-x86_64.tar # 移动解压后的二进制包到安装目录 sudo mv mysql-5.6.24-osx10.9-x86_64 /usr/local/ ...

- 【转】Image Cyborg 一键下载存储网页所有图片

下午仿照网上例子写了个抓取网页中图片并保存到本地的Python的例子,好奇就google了下是否有类似的在线抓取图片的外挂工具. 接着就找到了Pseric写的这篇文章 - Image Cyborg 一 ...

- 数组的sort方法

今天在看<JavaScript高级程序设计第三版>时,学到了数组的sort方法.知道这个方法,但是一直没仔细研究过,这次发现,它是把数组内的值用toSting()变为字符串再进行比较,这样 ...

- Java数据库操作

一.JDBC 1.JDBC Java数据库连接,用于Java程序中实现数据库操作功能,java.sql包中提供了执行SQL语句,访问各种数据库的方法,并为各种不同的数据库提供统一的操作接口及类. 2. ...

- PDF 补丁丁 0.4.2.1023 测试版发布:新增旋转页面功能

新的测试版发布啦.此版本增加了旋转页面的功能. 在“PDF文档选项”对话框的“页面设置”选项卡中,可设置需要旋转的页面(输入页码范围),以及旋转角度. 此外,还修复了统一页面尺寸功能的小问题.

- JS 百度地图导航

上一篇文章中我们就简单的学习了HTML5 地理定位,那么今天告诉大家我在项目中遇到的一个问题吧,就是怎么实现点击一个按钮就可以调到百度地图,并且获取到你当前的位置,并且导航到指定的地方去. 不想看步骤 ...

- HTTP 超时

TWinHTTPTimeouts = class(TPersistent) private FConnectTimeout, FReceiveTimeout, FSendTimeout: DWord; ...