Hadoop基础-HDFS数据清理过程之校验过程代码分析

Hadoop基础-HDFS数据清理过程之校验过程代码分析

作者:尹正杰

版权声明:原创作品,谢绝转载!否则将追究法律责任。

想称为一名高级大数据开发工程师,不但需要了解hadoop内部的运行机制,还需要掌握hadoop在写入过程中的报文分析。当然代码的调试步骤是一个开发必须得会的技能!想要掌握这三个技能,我们就可以拿HDFS写入过程来练练手,了解一下平时就几行的代码在它的内部是如何帮我们实现数据传输的。

一.Idea代码调试简介

1>.编写测试代码

/*

@author :yinzhengjie

Blog:http://www.cnblogs.com/yinzhengjie/tag/Hadoop%E8%BF%9B%E9%98%B6%E4%B9%8B%E8%B7%AF/

EMAIL:y1053419035@qq.com

*/

package cn.org.yinzhengjie.hdfs; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils; import java.io.FileInputStream;

import java.io.IOException; public class WriterToHdfs {

public static void main(String[] args) throws IOException {

//设置访问hdfs的用户名为“yinzhengjie”

System.setProperty("HADOOP_USER_NAME","yinzhengjie");

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

//定义需要在hdfs中写入的路径,别忘记把core-site.xml文件放在resources目录下哟!并fs.defaultFS的值设置为"hdfs://s101:8020"

Path p = new Path("/yinzhengjie.sql");

//通过fs对象create方法创建一个输出流,第一个参数是hdfs路径,第二个参数表示当hdfs中存在时是否覆盖

FSDataOutputStream fos = fs.create(p,true);

FileInputStream fis = new FileInputStream("D:\\10.Java\\IDE\\yhinzhengjieData\\MyHadoop\\yinzhengjie.sql");

//通过hadoop提供的IOUtils工具类对拷数据

IOUtils.copyBytes(fis,fos,1024);

fis.close();

fos.close();

}

}

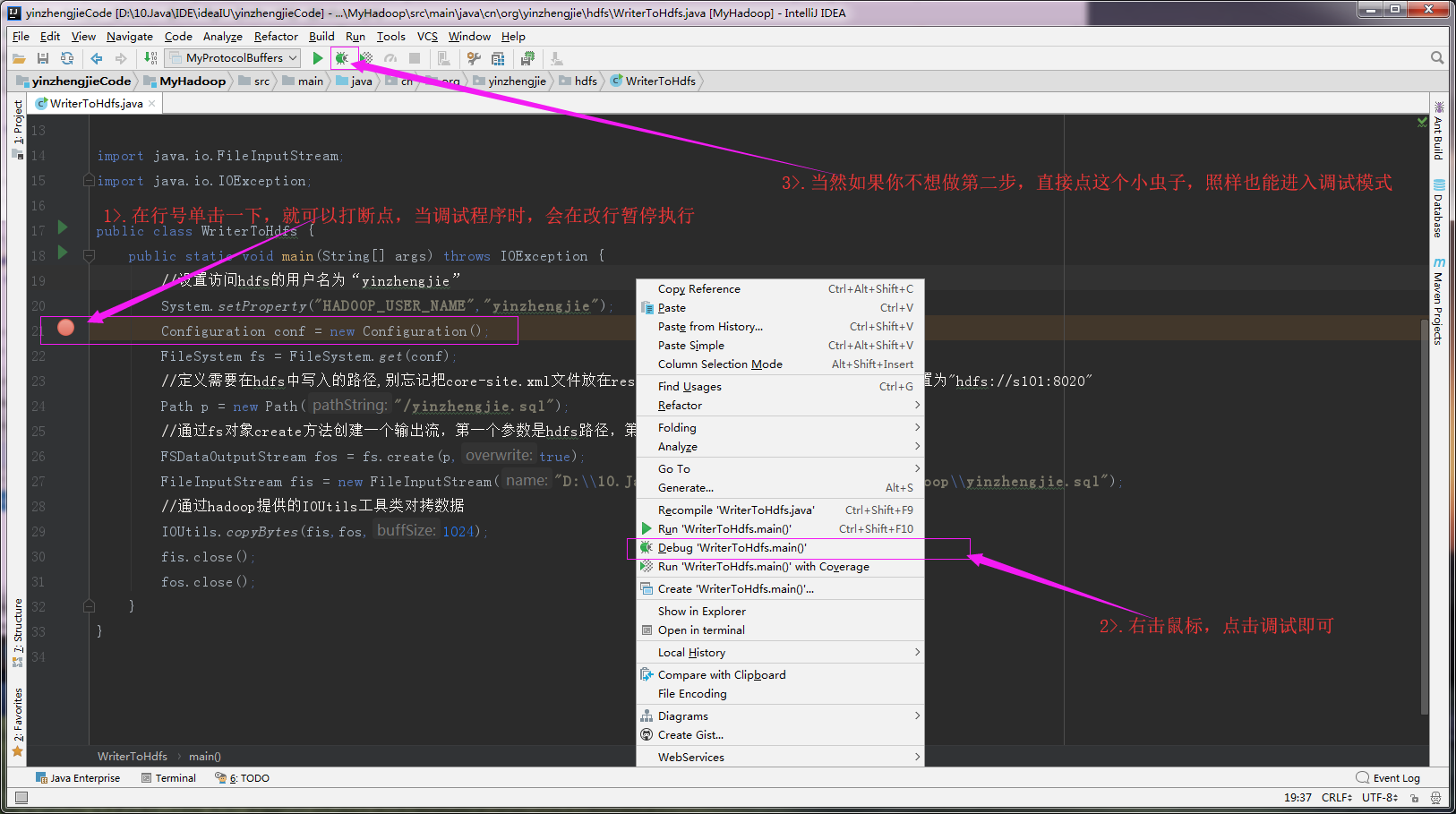

2>.进入调试模式

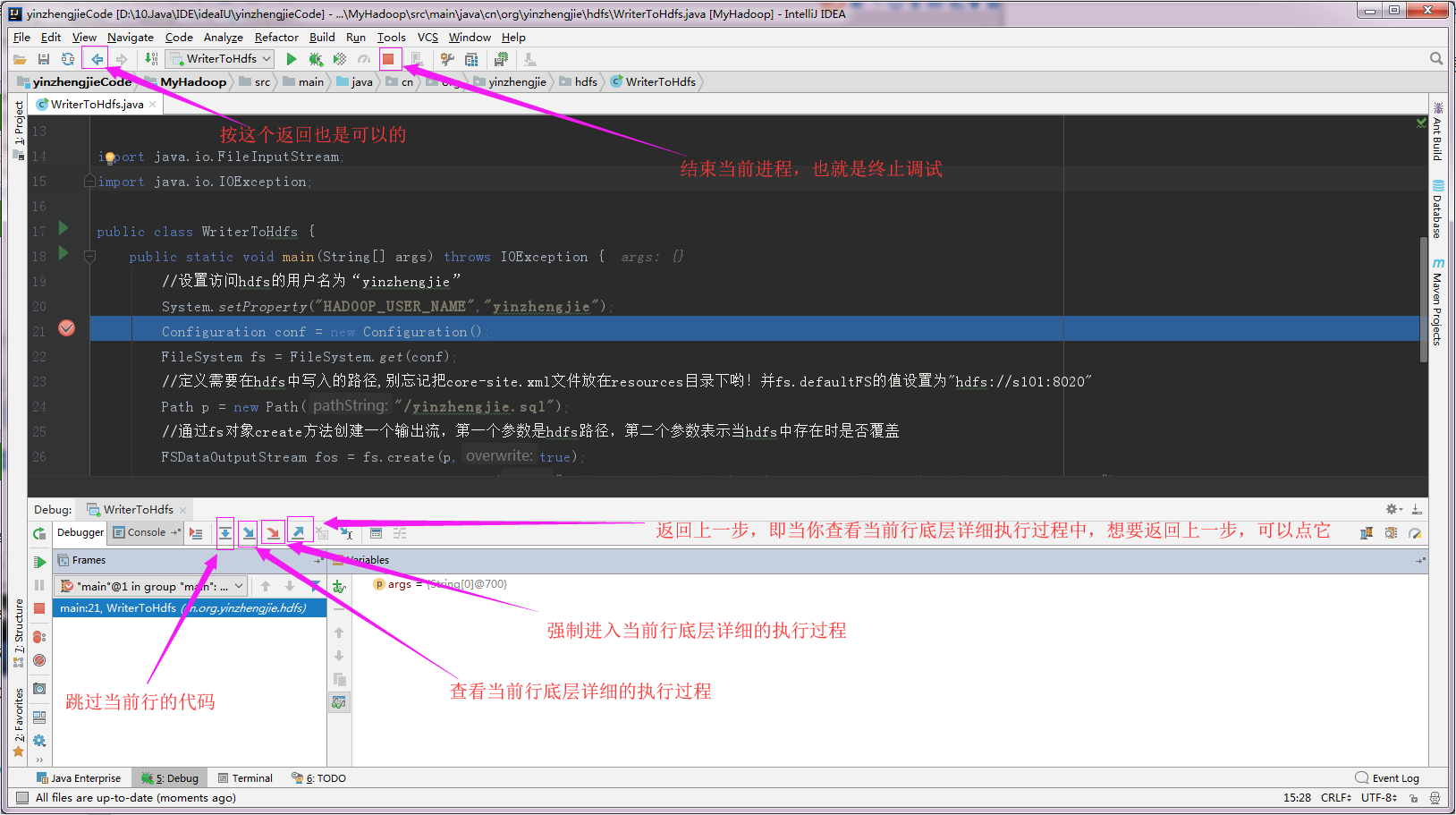

3>.查看源码执行过程,流程控制按键介绍:

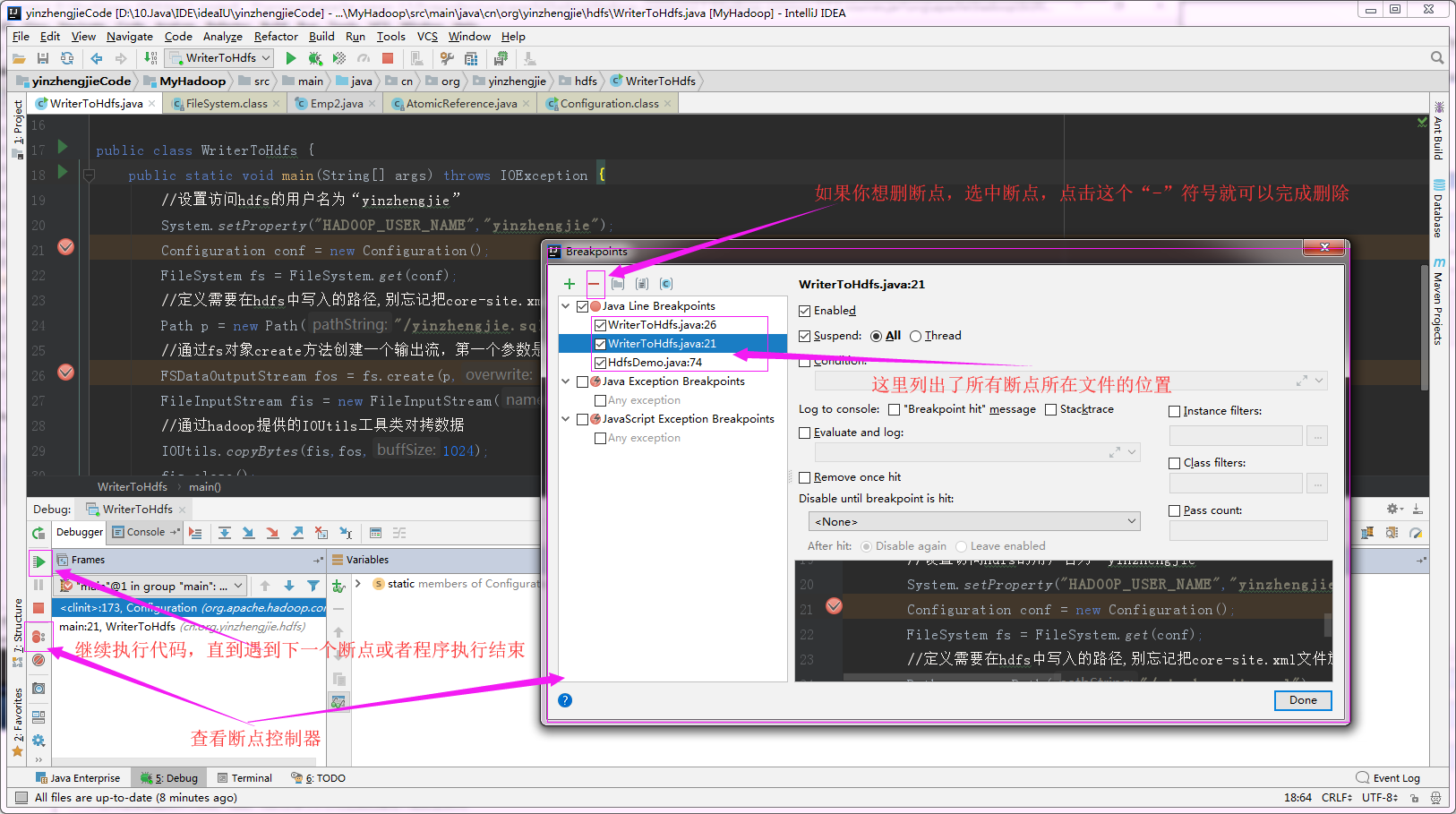

4>.断点列表管理

二.查看 “FileSystem fs = FileSystem.get(conf)” 的由来

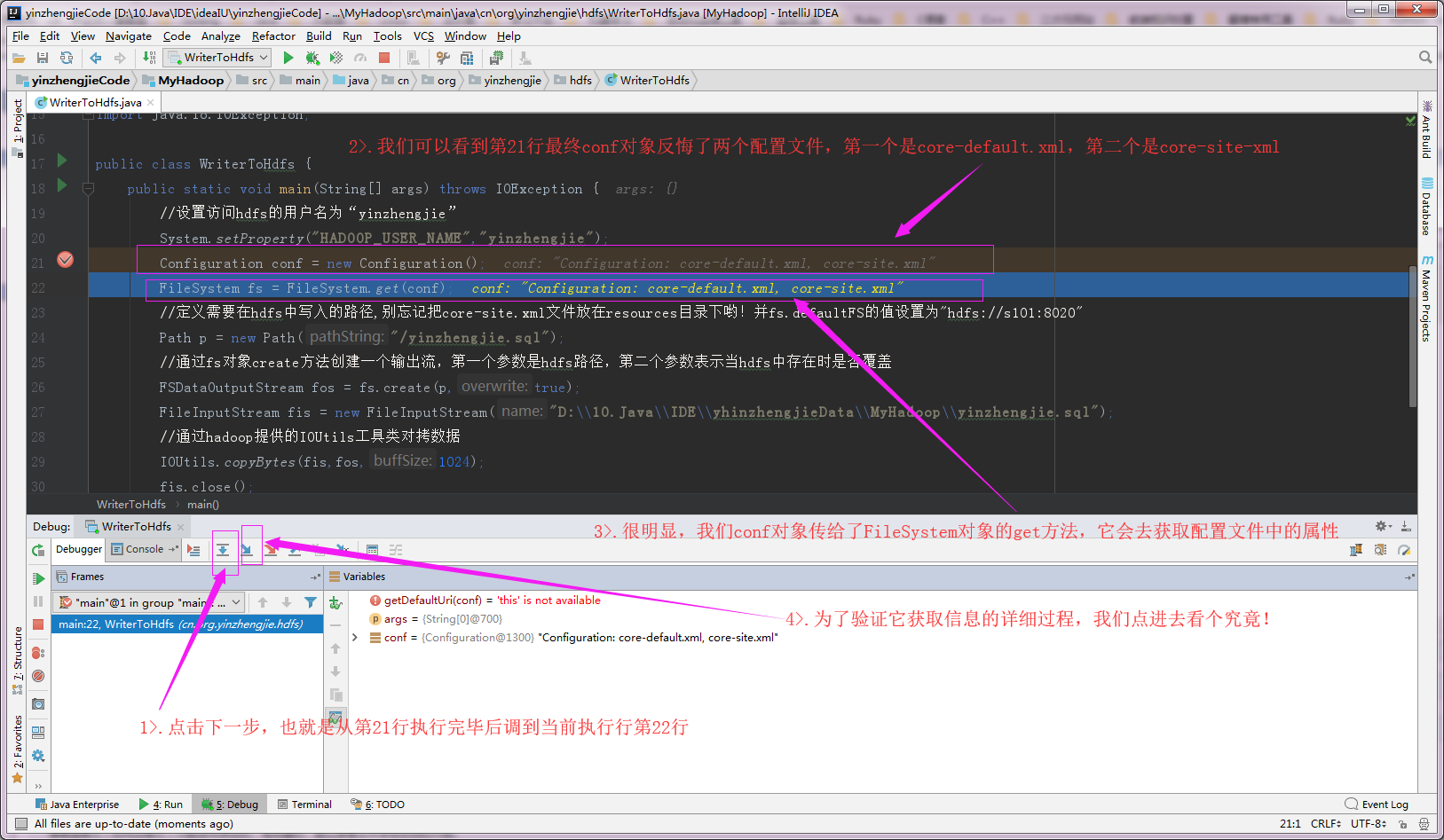

1>.查看conf的返回值

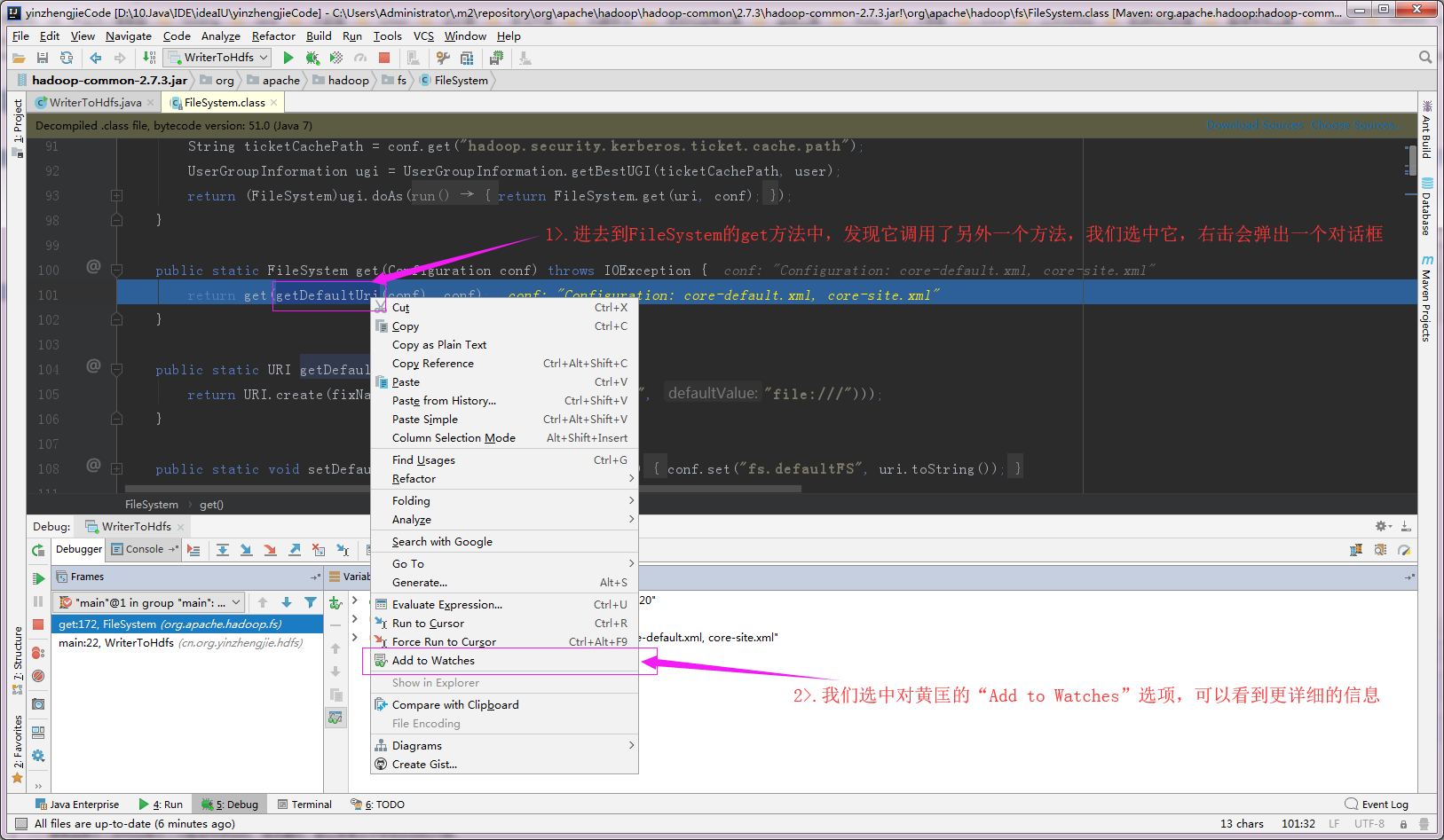

2>.进入“FileSystem.get”方法(我们需要在return那一行右击就可以弹出图中的对话框,其实不用刻意去选中getDefaultUri)

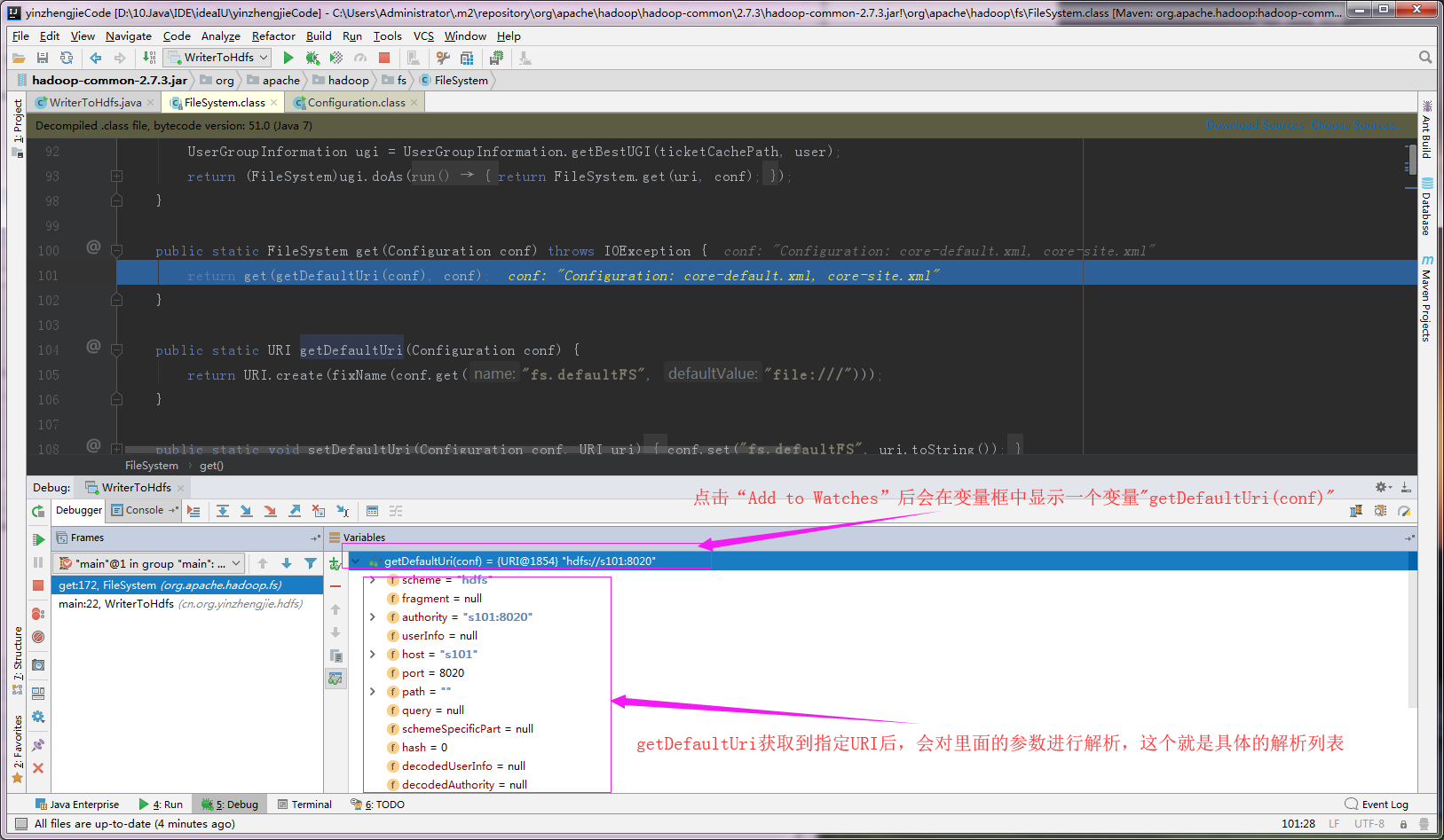

3>.查看“getDefaultUri(conf)”返回的参数

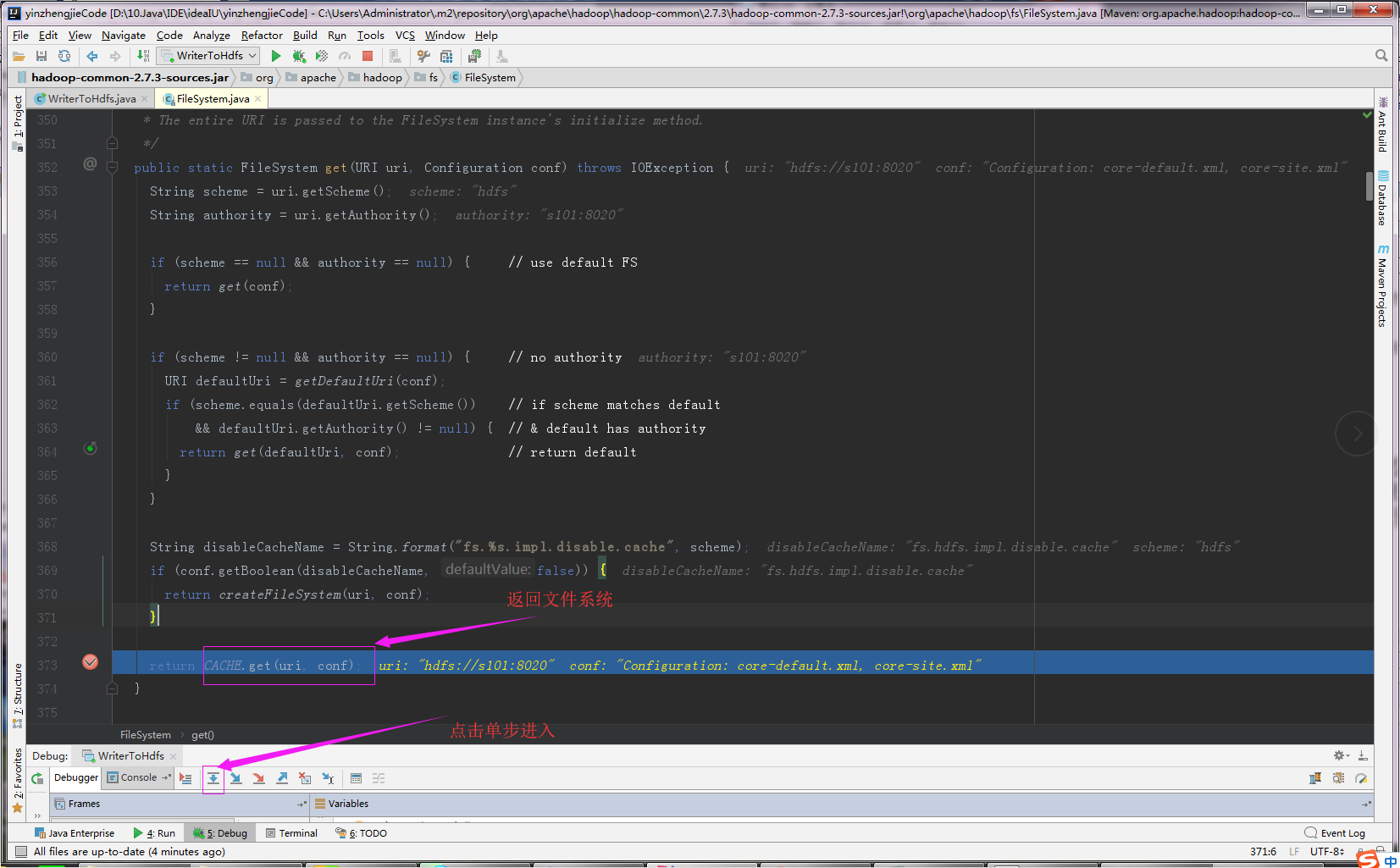

4>.通过“CACHE.get(uri, conf)”返回文件系统

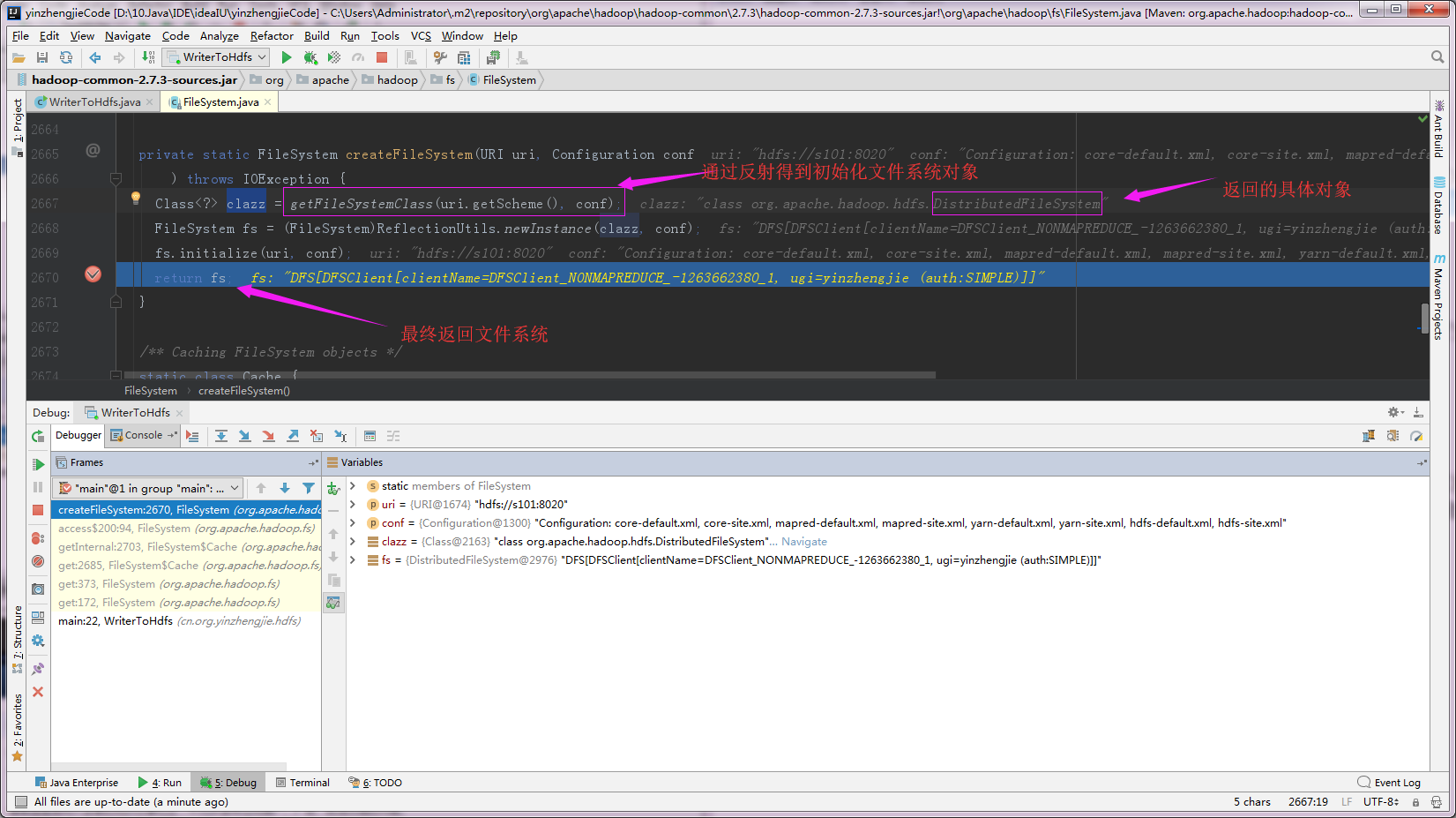

5>.返回文件系统

三.查看“fs.create(p, true)”创建流的详细过程

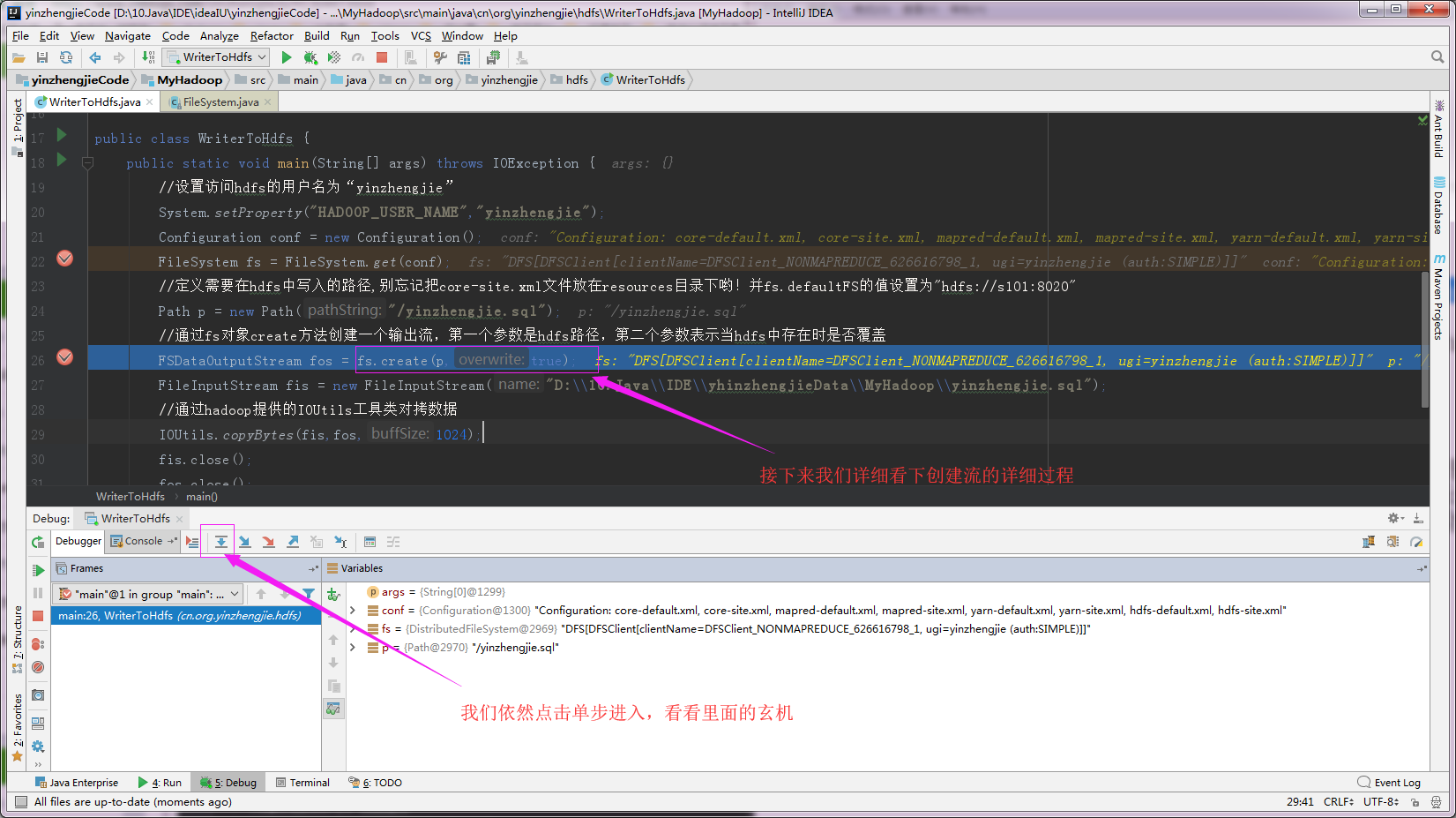

1>.单步进入“fs.create(p, true)”创建流

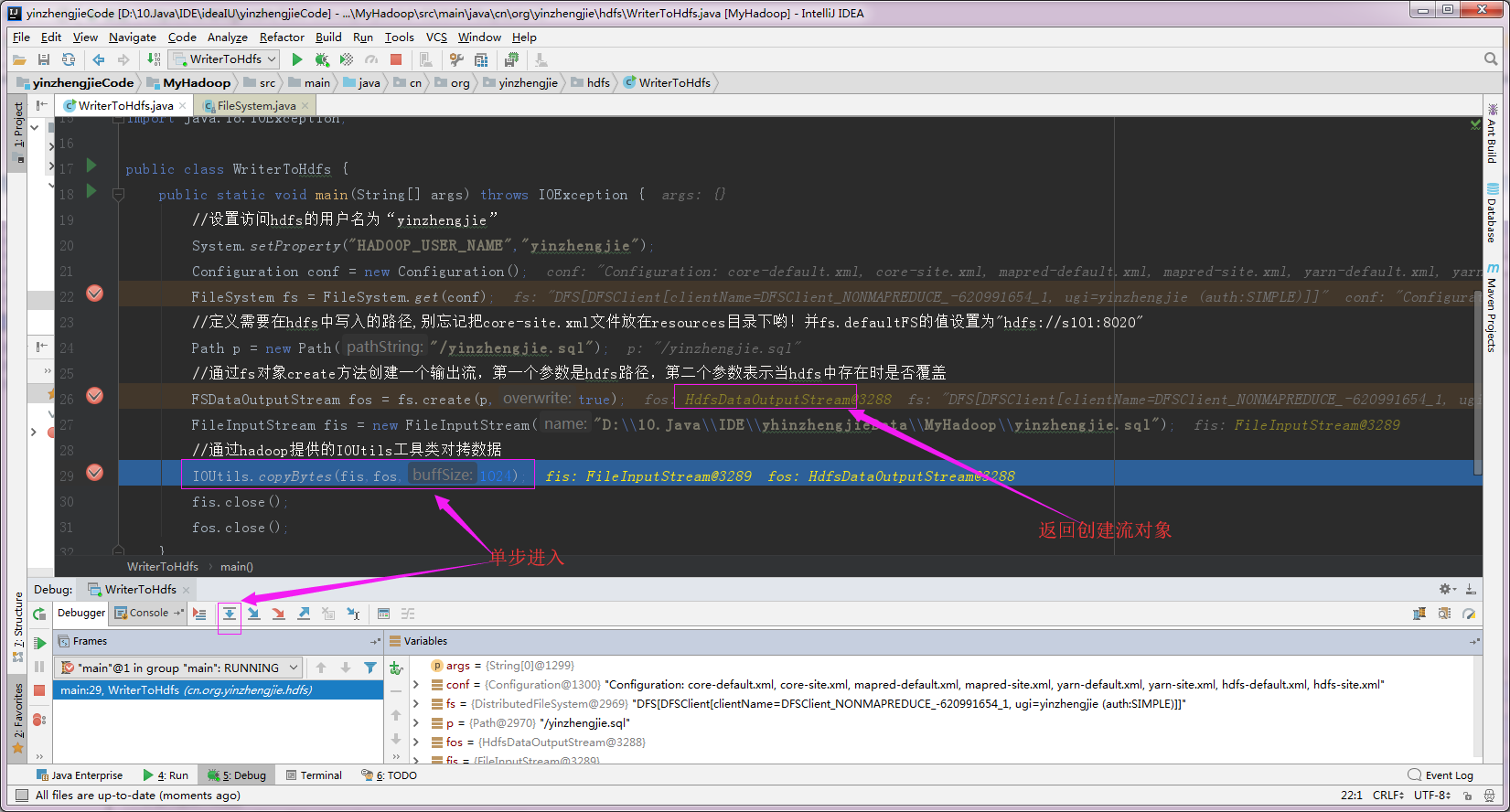

2>.经过断电跟踪,发现最后返回的是HDFSOutputStream,也就是创建流,此时还没有真正的写入数据

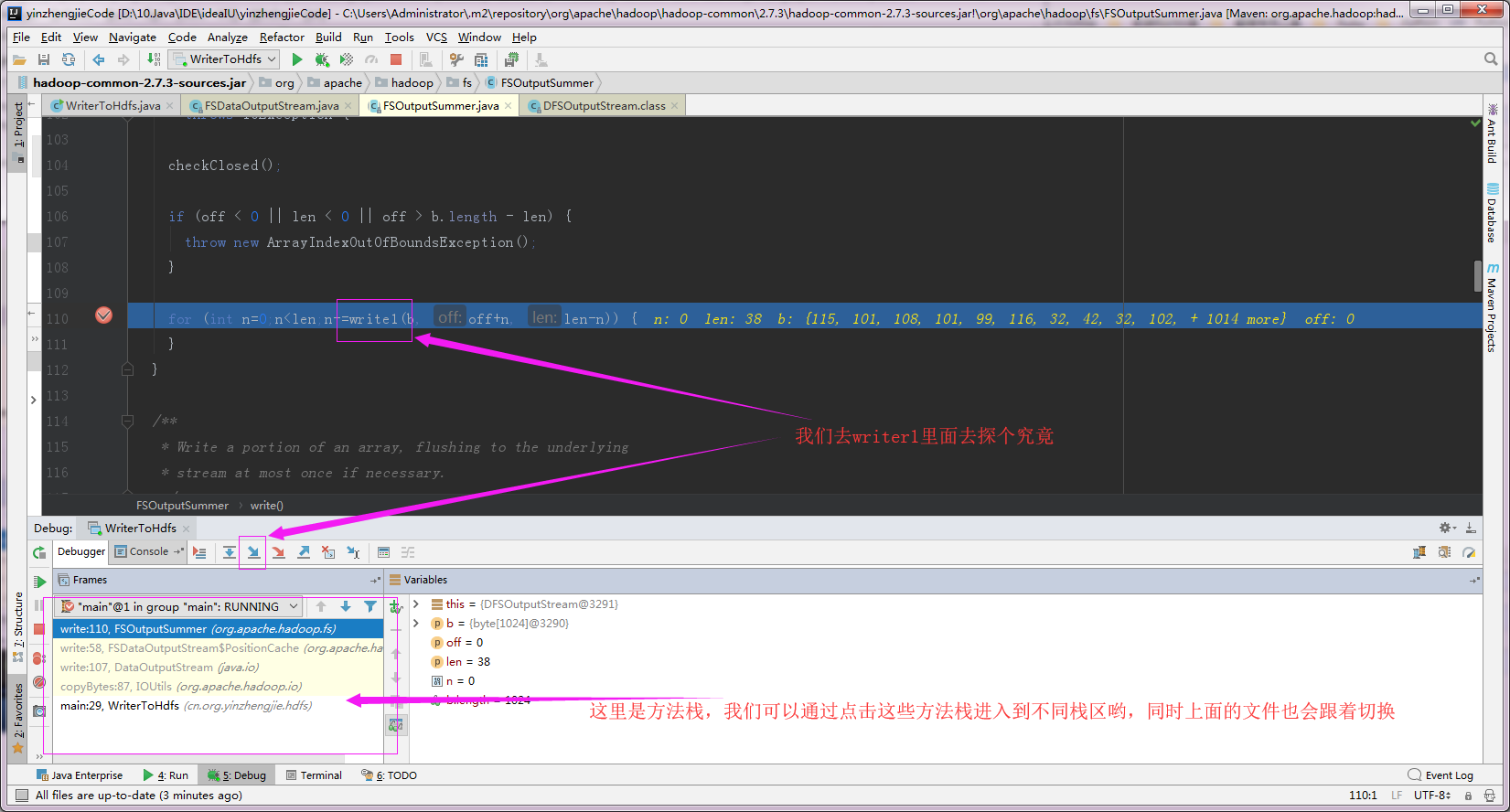

3>.在写入过程中进入到write1方法

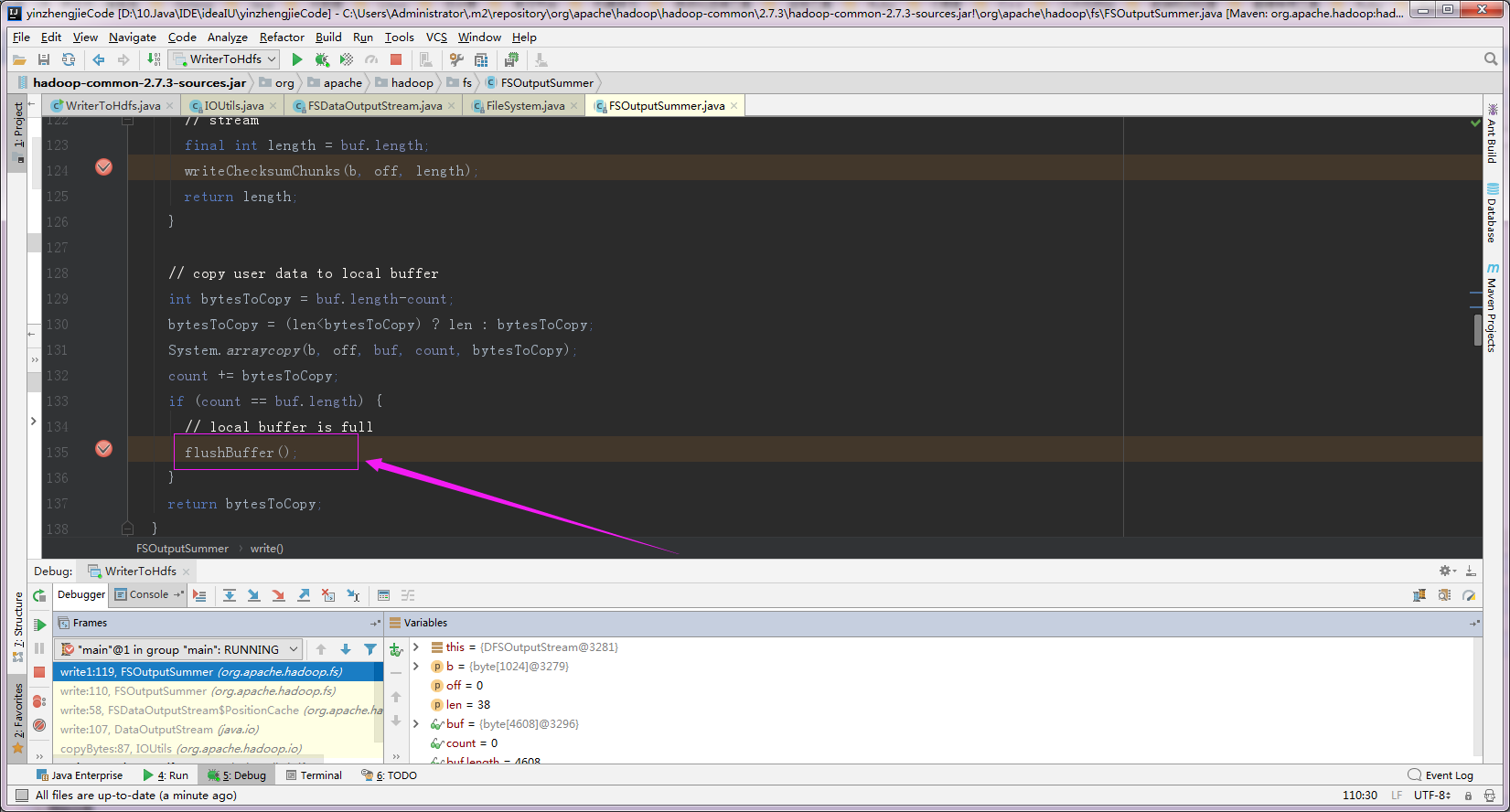

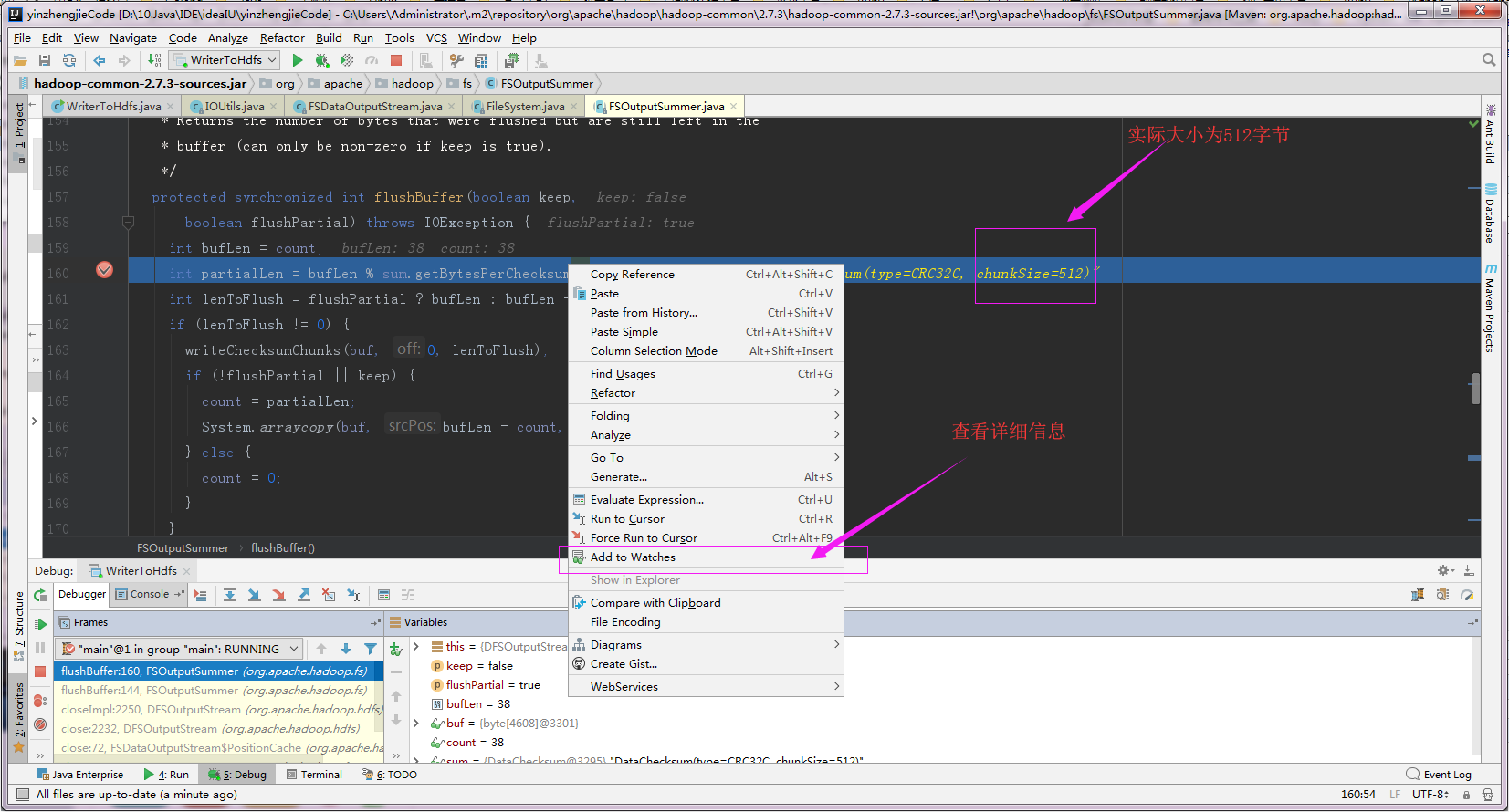

4>.再进入到FlushBuffer,目的是清理chunk

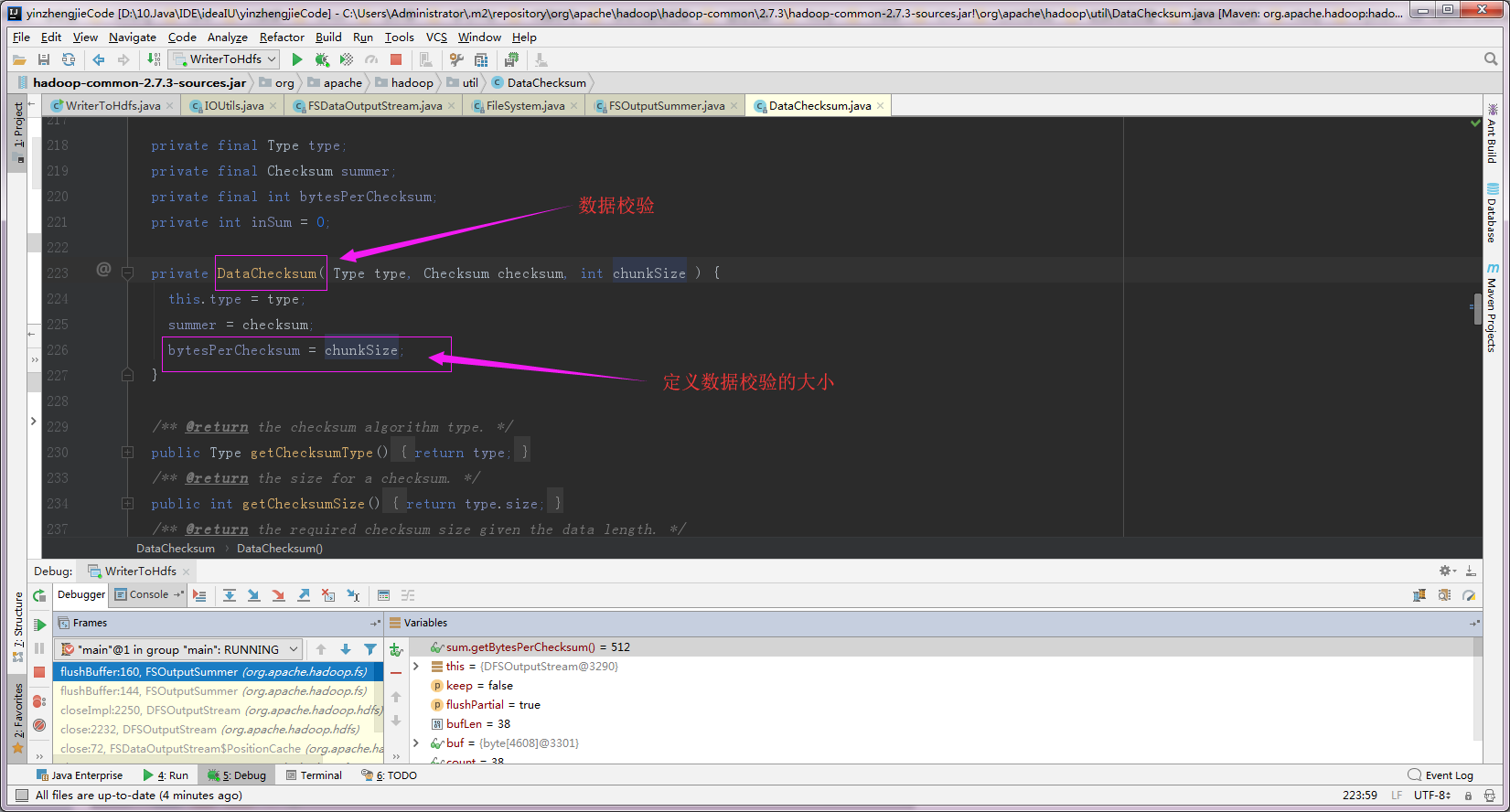

5>.验证chunk大小为512字节

6>.我们通过打断点的方式查出来chunk的大小为512字节,这个大小意思的是每个512字节就会进行一次校验。

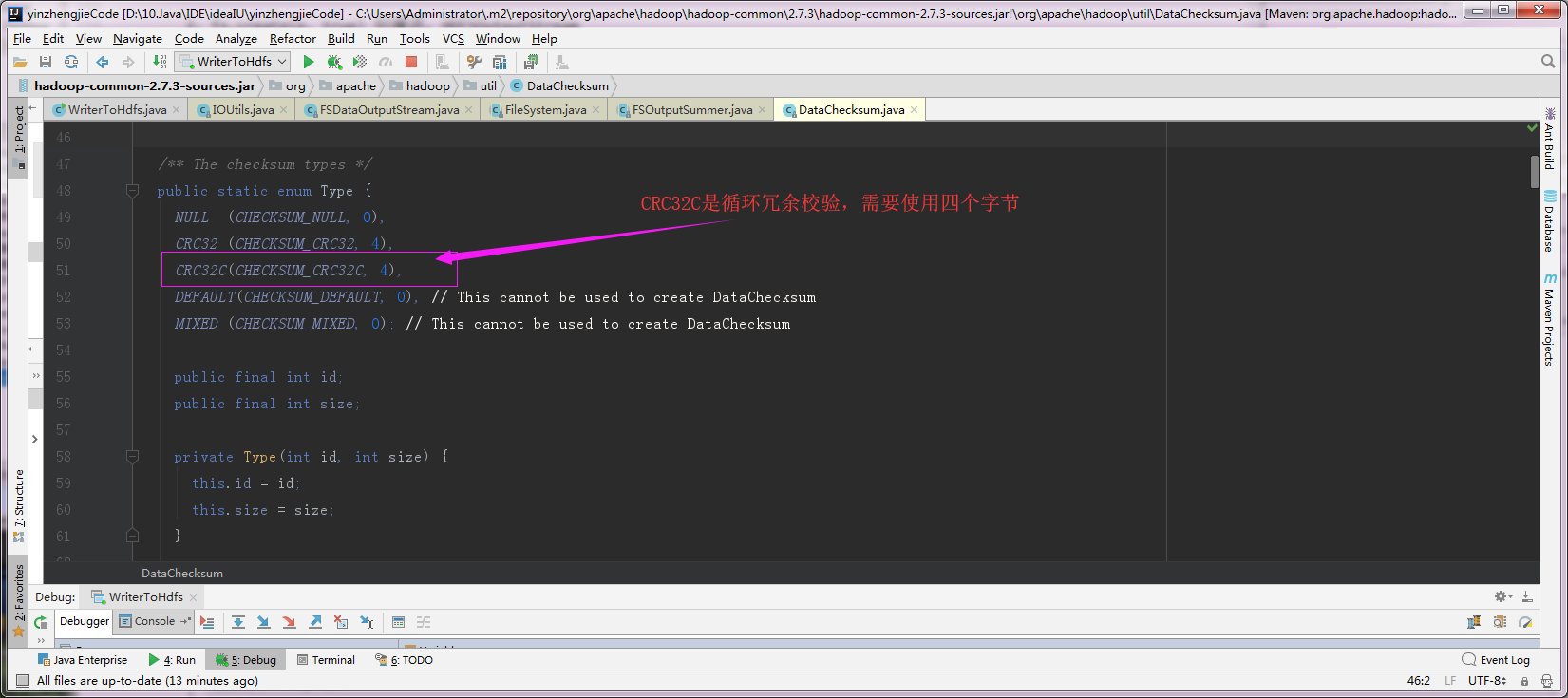

7>.使用“sum.calculateChunkedSums”来计算校验和,使用循环冗余校验(CRC32C),大小4个字节

四.知识点小结

1>.chunk数据块

第一:通过断点调试估计大家也知道chunk的做作用了,它就是数据块,512字节,在上面调试代码中看到的"sum.getBytesChecksum()"的大小就是512,它的意思就是每个512字节进行依次校验;

第二:上图调试中的"sum.caculateChunkedSums"是来计算校验和的,使用 循环冗余校验(CRC32C),占用4个字节;

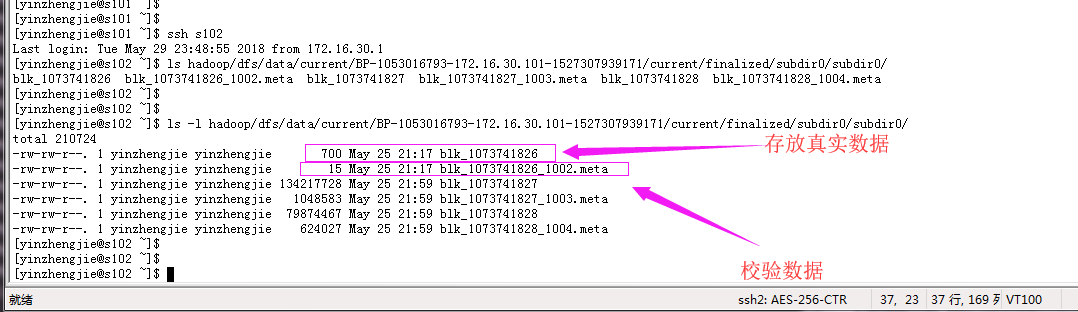

2>.data数据

数据包括两个方面,估计你也猜到了,没错,就是真实数据和校验数据。校验数据大小 = 7字节头 + 检验和个数(每512字节进行依次校验) x 4

不管你信不信,反转我是信了,我们举个例子,如下:

比如上面的“blk_1073741826”大小是700字节,将其除以512字节,商为2(如果有余数的话商要加1)。那么校验大小就应该是"7 + 4 x 2 = 15",即校验和为15字节,

Hadoop基础-HDFS数据清理过程之校验过程代码分析的更多相关文章

- Hadoop基础-HDFS集群中大数据开发常用的命令总结

Hadoop基础-HDFS集群中大数据开发常用的命令总结 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本盘博客仅仅列出了我们在实际生成环境中常用的hdfs命令,如果想要了解更多, ...

- Hadoop基础-Hdfs各个组件的运行原理介绍

Hadoop基础-Hdfs各个组件的运行原理介绍 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.NameNode工作原理(默认端口号:50070) 1>.什么是NameN ...

- Hadoop基础-HDFS的读取与写入过程剖析

Hadoop基础-HDFS的读取与写入过程剖析 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本篇博客会简要介绍hadoop的写入过程,并不会设计到源码,我会用图和文字来描述hdf ...

- Hadoop基础-HDFS的读取与写入过程

Hadoop基础-HDFS的读取与写入过程 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 为了了解客户端及与之交互的HDFS,NameNode和DataNode之间的数据流是什么样 ...

- Hadoop基础-HDFS的API实现增删改查

Hadoop基础-HDFS的API实现增删改查 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本篇博客开发IDE使用的是Idea,如果没有安装Idea软件的可以去下载安装,如何安装 ...

- Hadoop基础-HDFS的API常见操作

Hadoop基础-HDFS的API常见操作 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本文主要是记录一写我在学习HDFS时的一些琐碎的学习笔记, 方便自己以后查看.在调用API ...

- Hadoop基础-HDFS安全管家之Kerberos实战篇

Hadoop基础-HDFS安全管家之Kerberos实战篇 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 我们都知道hadoop有很多不同的发行版,比如:Apache Hadoop ...

- Hadoop基础-HDFS分布式文件系统的存储

Hadoop基础-HDFS分布式文件系统的存储 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.HDFS数据块 1>.磁盘中的数据块 每个磁盘都有默认的数据块大小,这个磁盘 ...

- Hadoop基础-HDFS递归列出文件系统-FileStatus与listFiles两种方法

Hadoop基础-HDFS递归列出文件系统-FileStatus与listFiles两种方法 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. fs.listFiles方法,返回Loc ...

随机推荐

- TeamWork#3,Week5,The First Meeting of Our Team

sixsix第一次会议记录 [会议时间]2014年10月23日星期四19:00-20:00 [会议形式]小组讨论 [会议地点]5号公寓 [会议主持]高雅智 [会议记录]张志浩 会议整体流程 一.签到 ...

- bata5

目录 组员情况 组员1(组长):胡绪佩 组员2:胡青元 组员3:庄卉 组员4:家灿 组员5:恺琳 组员6:翟丹丹 组员7:何家伟 组员8:政演 组员9:黄鸿杰 组员10:刘一好 组员11:何宇恒 展示 ...

- 寒假学习计划&进度

学习计划 c语言查缺:这方面的查缺,我觉得我不需要花较多时间,因为老师上课讲的也足够详细,自己学的也自认为没有太多疏漏,所以我假期学习的中心放在了c++上面. c++学习:开始我先看了几集师爷的视频, ...

- AttributeError: module ‘tensorflow.python.ops.nn’ has no attribute ‘leaky_relu’

#AttributeError: module 'tensorflow.python.ops.nn' has no attribute 'leaky_relu' 的原因主要是版本的问题 解决方法是更新 ...

- mabatis报错 Result Maps collection already contains value for gamedataserver.dao.one.ChargeRecordMapper.BaseResultMap

1.解决这种报错看看英文"already ",也就是已经存在,其实是因为存在了两个id相同的返回,以下可以看看,根据这种例子看看自己项目是不是这种问题

- 3、第一个Python程序

现在,了解了如何启动和退出Python的交互式环境,我们就可以正式开始编写Python代码了. 在写代码之前,请千万不要用“复制”-“粘贴”把代码从页面粘贴到你自己的电脑上.写程序也讲究一个感觉,你需 ...

- HighCharts点击柱形或饼块等加URL或Click事件

我们在做图表的时候,有时候需要在单个数据上加链接或点击事件,是在plotOptions里的events里设置的: 如下代码: plotOptions: { pie: { cursor: 'pointe ...

- Enterprise Library 5.0 参考源码索引

http://www.projky.com/entlib/5.0/Microsoft/Practices/EnterpriseLibrary/Caching/BackgroundScheduler.c ...

- IDEA小插件之快速修改Maven多模块的工程版本

Github:https://github.com/zwjlpeng/versions 问题在Maven构建的多模块块程中,如果我们需要修改工程的版本号,会怎么操作呢example例如工程A包括了A- ...

- IIS8.5 的环境下添加配置WCF服务!!!!!

添加步骤: 1.打开iis8.5,先部署wcf服务. 2.首先添加MIME类型 扩展名:“.svc” MIME类型:“application/octet-stream” 3.添加 处理程序映射 请求路 ...