Python 自动爬取B站视频

文件名自定义(文件格式为.py),脚本内容:

#!/usr/bin/env python

#-*-coding:utf-8-*-

import requests

import random

import time

def get_json(url):

headers = {

'User-Agent':

'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.100 Safari/537.36'

}

params = {

'page_size': 10,

'next_offset': str(num),

'tag': '今日热门',

'platform': 'pc'

}

try:

html = requests.get(url,params=params,headers=headers)

return html.json()

except BaseException:

print('request error')

pass

def download(url,path):

start = time.time() # 开始时间

size = 0

headers = {

'User-Agent':

'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.100 Safari/537.36'

}

response = requests.get(url,headers=headers,stream=True) # stream属性必须带上

chunk_size = 1024 # 每次下载的数据大小

content_size = int(response.headers['content-length']) # 总大小

if response.status_code == 200:

print('[文件大小]:%0.2f MB' %(content_size / chunk_size / 1024)) # 换算单位

with open(path,'wb') as file:

for data in response.iter_content(chunk_size=chunk_size):

file.write(data)

size += len(data) # 已下载的文件大小

if __name__ == '__main__':

for i in range(10):

url = 'http://api.vc.bilibili.com/board/v1/ranking/top?'

num = i*10 + 1

html = get_json(url)

infos = html['data']['items']

for info in infos:

title = info['item']['description'] # 小视频的标题

video_url = info['item']['video_playurl'] # 小视频的下载链接

print(title)

# 为了防止有些视频没有提供下载链接的情况

try:

download(video_url,path='videos/%s.mp4' %title)

print('成功下载一个!')

except BaseException:

print('凉凉,下载失败')

pass

time.sleep(int(format(random.randint(2,8)))) # 设置随机等待时间

爬取效果如下:

爬取的文件:

生成一个windows平台可执行exe程序

工具安装:pip install PyInstaller

生成exe程序:

pyinstaller -i test.ico -F Grasp.py

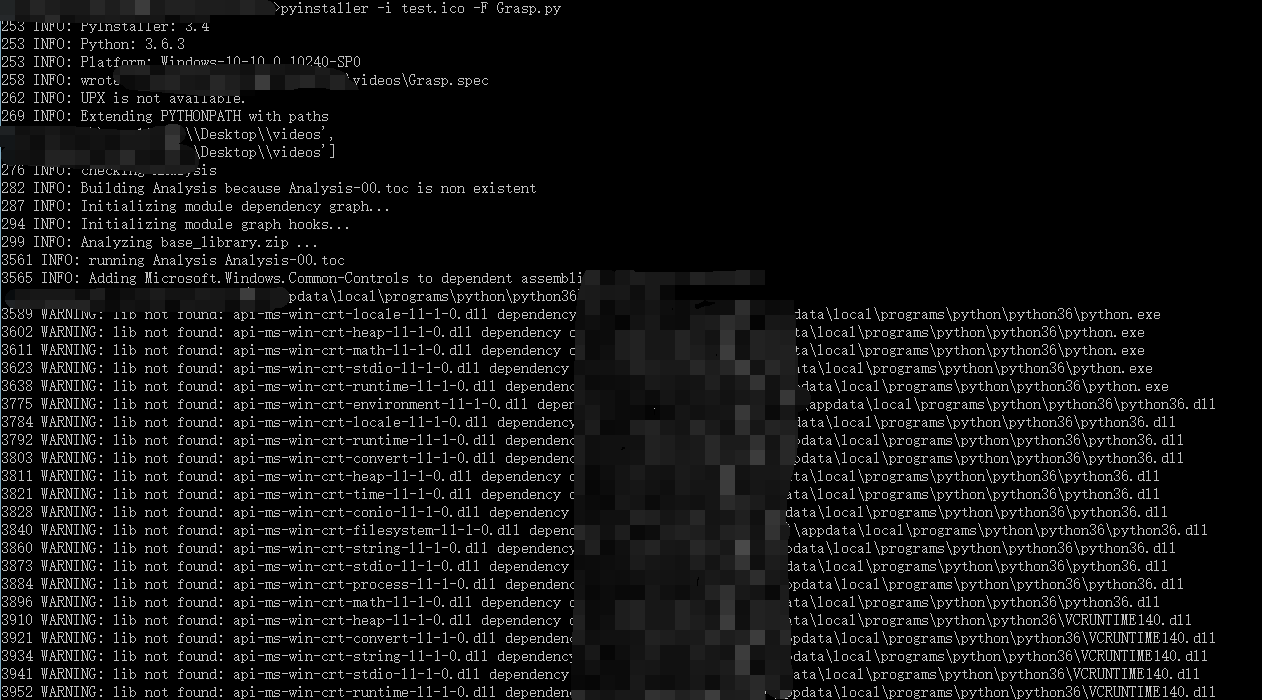

打包过程:

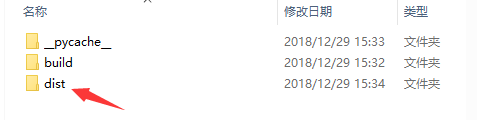

打包好的文件:

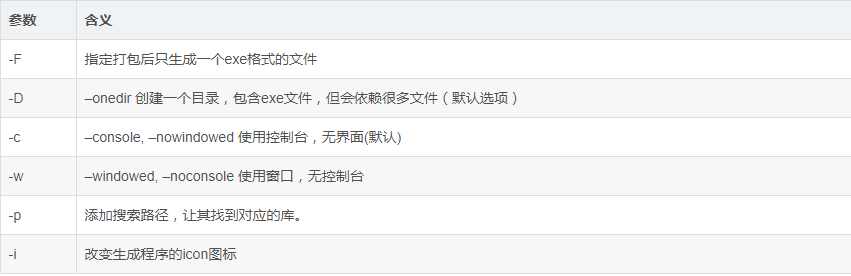

参数含义:

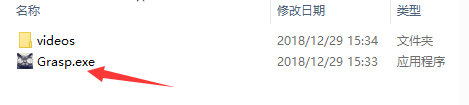

程序:

百度云下载链接

链接:百度云

提取码:hqhr

脚本内容收集自互联网,不保证生成的程序时效

Python 自动爬取B站视频的更多相关文章

- 如何手动写一个Python脚本自动爬取Bilibili小视频

如何手动写一个Python脚本自动爬取Bilibili小视频 国庆结束之余,某个不务正业的码农不好好干活,在B站瞎逛着,毕竟国庆嘛,还让不让人休息了诶-- 我身边的很多小伙伴们在朋友圈里面晒着出去游玩 ...

- 爬虫之爬取B站视频及破解知乎登录方法(进阶)

今日内容概要 爬虫思路之破解知乎登录 爬虫思路之破解红薯网小说 爬取b站视频 Xpath选择器 MongoDB数据库 爬取b站视频 """ 爬取大的视频网站资源的时候,一 ...

- Python爬取B站视频信息

该文内容已失效,现已实现scrapy+scrapy-splash来爬取该网站视频及用户信息,由于B站的反爬封IP,以及网上的免费代理IP绝大部分失效,无法实现一个可靠的IP代理池,免费代理网站又是各种 ...

- python爬虫:爬取慕课网视频

前段时间安装了一个慕课网app,发现不用注册就可以在线看其中的视频,就有了想爬取其中的视频,用来在电脑上学习.决定花两天时间用学了一段时间的python做一做.(我的新书<Python爬虫开发与 ...

- 从0实现python批量爬取p站插画

一.本文编写缘由 很久没有写过爬虫,已经忘得差不多了.以爬取p站图片为着手点,进行爬虫复习与实践. 欢迎学习Python的小伙伴可以加我扣群86七06七945,大家一起学习讨论 二.获取网页源码 爬取 ...

- python爬取B站视频弹幕分析并制作词云

1.分析网页 视频地址: www.bilibili.com/video/BV19E… 本身博主同时也是一名up主,虽然已经断更好久了,但是不妨碍我爬取弹幕信息来分析呀. 这次我选取的是自己 唯一的爆款 ...

- python 爬取B站视频弹幕信息

获取B站视频弹幕,相对来说很简单,需要用到的知识点有requests.re两个库.requests用来获得网页信息,re正则匹配获取你需要的信息,当然还有其他的方法,例如Xpath.进入你所观看的视频 ...

- 爬取B站视频

先安装you_get pip install you_get 爬取代码,爬了个ASMR的,学习困了自我催眠 import sys from you_get import common as you_g ...

- python爬虫——爬取B站用户在线人数

国庆期间想要统计一下bilibili网站的在线人数变化,写了一个简单的爬虫程序.主要是对https://api.bilibili.com/x/web-interface/online返回的参数进行分析 ...

随机推荐

- Java反射学习三

反射与数组 java.lang.Array类提供了动态创建和访问数组元素的各种静态方法. 例程ArrayTester1类的main()方法创建了一个长度为10的字符串数组,接着把索引位置为5的元素设为 ...

- python 编码规范起源:PEP8 编码规范中文版

PEP: 8 标题: Python代码的样式指南 版: c451868df657 最后修改: 2016-06-08 10:43:53 -0400(2016年6月8日星期三) 作者: Guido van ...

- Kafka设计解析(十六)Kafka 0.11消息设计

转载自 huxihx,原文链接 [原创]Kafka 0.11消息设计 目录 一.Kafka消息层次设计 1. v1格式 2. v2格式 二.v1消息格式 三.v2消息格式 四.测试对比 Kafka 0 ...

- [NOIp2016]蚯蚓 (队列)

#\(\color{red}{\mathcal{Description}}\) LInk 这道题是个\(zz\)题 #\(\color{red}{\mathcal{Solution}}\) 我们考虑如 ...

- HDU 1171 (01背包问题)

题目链接: http://acm.hdu.edu.cn/showproblem.php?pid=1171 分析: 例如数据 3 10 2 20 1 30 1 获得这样一个降序的数组: ...

- 初次接触ARM开发,理清这四个开发思路很重要!

初次接触ARM开发,理清这四个开发思路很重要! 由于涉及编程,学习ARM单片机系统对于从事电子电路的设计者来说是有些困难的,学习知识不难,难的是理清其中的开发思路,找到一个好的起点.本文就将从这一步入 ...

- 【vue】vue依赖安装如vue-router、vue-resource、vuex等

方式一: 最直接的方式为在 package.json中添加如图依赖配置,然后项目 cnpm install即可 方式二: 根据vue项目的搭建教程,接下来记录下如何在Vue-cli创建的项目中安装vu ...

- PHP分行打印数组-php输出数组方法大全

我们都知道php有两种方式可以打印数组 $arr = array( "a"=>"orange", "b"=>"bana ...

- Android ViewPager设置监听注意事项

首先 implements View.OnClickListener 因为Item比较多用这个方便 设置监听要注意地方,如果在 onCreate 直接 findViewById布局里的ID是会出错的 ...

- 基于Verilog的CRC-CCITT校验

由于笔者在自己设计CRC模块时遇到很多问题,在网上并未找到一篇具有实际指导意义的文章,在经过多次仿真修改再仿真之后得到了正确的结果,故愿意在本文中为大家提供整个设计流程供大家快速完成设计.本文章主要针 ...