利用Jsoup爬取新冠疫情数据并存至数据库

需要用到的jar包(用来爬取的jsoup,htmlunit-2.37.0-bin以及连接数据库中的mysql.jar)

链接:https://pan.baidu.com/s/1VlylWmlhjd8Ka8VTruQEnA 提取码:dxeq

爬取的原网站为:https://wp.m.163.com/163/page/news/virus_report/index.html?_nw_=1&_anw_=1

Paqu.java

package control;

import java.io.IOException;

import java.text.SimpleDateFormat;

import java.util.ArrayList;

import java.util.Date;

import java.util.List; import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements; import com.gargoylesoftware.htmlunit.BrowserVersion;

import com.gargoylesoftware.htmlunit.WebClient;

import com.gargoylesoftware.htmlunit.html.HtmlInput;

import com.gargoylesoftware.htmlunit.html.HtmlPage;

import com.gargoylesoftware.htmlunit.html.HtmlSubmitInput; import Dao.AddService; public class Paqu { public static void main(String args[]) {

// TODO Auto-generated method stub

String sheng="";

String xinzeng="";

String leiji="";

String zhiyu="";

String siwang="";

String url = "https://wp.m.163.com/163/page/news/virus_report/index.html?_nw_=1&_anw_=1"; int i=0; try {

//构造一个webClient 模拟Chrome 浏览器

WebClient webClient = new WebClient(BrowserVersion.CHROME);

//支持JavaScript

webClient.getOptions().setJavaScriptEnabled(true);

webClient.getOptions().setCssEnabled(false);

webClient.getOptions().setActiveXNative(false);

webClient.getOptions().setCssEnabled(false);

webClient.getOptions().setThrowExceptionOnScriptError(false);

webClient.getOptions().setThrowExceptionOnFailingStatusCode(false);

webClient.getOptions().setTimeout(8000);

HtmlPage rootPage = webClient.getPage(url);

//设置一个运行JavaScript的时间

webClient.waitForBackgroundJavaScript(6000);

String html = rootPage.asXml();

Document doc = Jsoup.parse(html);

//System.out.println(doc);

Element listdiv1 = doc.select(".wrap").first();

Elements listdiv2 = listdiv1.select(".province");

for(Element s:listdiv2) {

Elements span = s.getElementsByTag("span");

Elements real_name=span.select(".item_name");

Elements real_newconfirm=span.select(".item_newconfirm");

Elements real_confirm=span.select(".item_confirm");

Elements real_dead=span.select(".item_dead");

Elements real_heal=span.select(".item_heal");

sheng=real_name.text();

xinzeng=real_newconfirm.text();

leiji=real_confirm.text();

zhiyu=real_heal.text();

siwang=real_dead.text();

//System.out.println(sheng+" 新增确诊:"+xinzeng+" 累计确诊:"+leiji+" 累计治愈:"+zhiyu+" 累计死亡:"+siwang);

Date currentTime=new Date();

SimpleDateFormat formatter = new SimpleDateFormat("yyyy-MM-dd HH:mm");

String time = formatter.format(currentTime);//获取当前时间

AddService dao=new AddService();

dao.add("myinfo", sheng, xinzeng, leiji, zhiyu, siwang,time);//将爬取到的数据添加至数据库

} } catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

System.out.println("爬取失败");

}

} }

AddService.java:

package Dao; import java.sql.Connection;

import java.sql.Statement; import utils.DBUtils; public class AddService {

public void add(String table,String sheng,String xinzeng,String leiji,String zhiyu,String dead,String time) {

String sql = "insert into "+table+" (Province,Newconfirmed_num ,Confirmed_num,Cured_num,Dead_num,Time) values('" + sheng + "','" + xinzeng +"','" + leiji +"','" + zhiyu + "','" + dead+ "','" + time+ "')";

System.out.println(sql);

Connection conn = DBUtils.getConn();

Statement state = null;

int a = 0;

try {

state = conn.createStatement();

a=state.executeUpdate(sql);

} catch (Exception e) {

e.printStackTrace();

} finally {

DBUtils.close(state, conn);

}

}

}

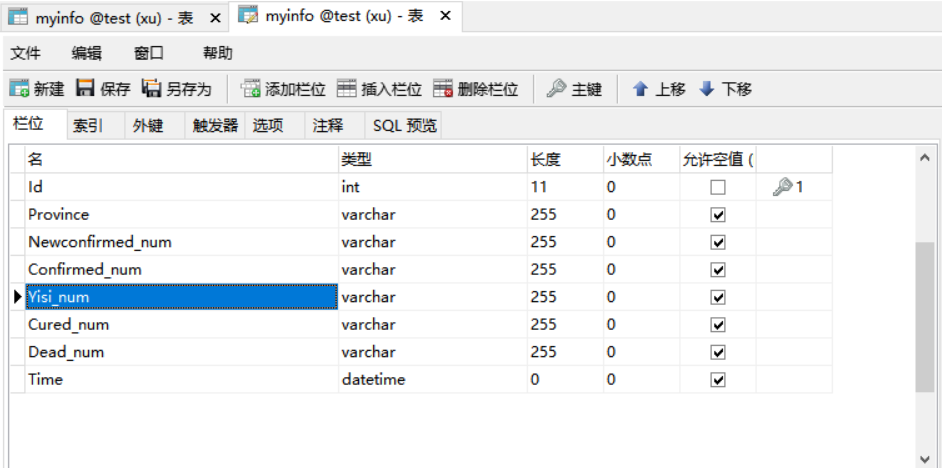

数据库建表如下:

遇到的问题

一开始的数据是动态加载的,无法获取确定的数据,最后在代码中添加了一段js内容来获取动态数据。

其中还尝试过爬取其他的网站上的数据,但doc并不能很好的输出,只能输出网站的大框架,无法获取具体到内容。

利用Jsoup爬取新冠疫情数据并存至数据库的更多相关文章

- 利用python爬取58同城简历数据

利用python爬取58同城简历数据 利用python爬取58同城简历数据 最近接到一个工作,需要获取58同城上面的简历信息(http://gz.58.com/qzyewu/).最开始想到是用pyth ...

- jsoup爬取某网站安全数据

jsoup爬取某网站安全数据 package com.vfsd.net; import java.io.IOException; import java.sql.SQLException; impor ...

- 利用Crawlspider爬取腾讯招聘数据(全站,深度)

需求: 使用crawlSpider(全站)进行数据爬取 - 首页: 岗位名称,岗位类别 - 详情页:岗位职责 - 持久化存储 代码: 爬虫文件: from scrapy.linkextractors ...

- python爬取新浪股票数据—绘图【原创分享】

目标:不做蜡烛图,只用折线图绘图,绘出四条线之间的关系. 注:未使用接口,仅爬虫学习,不做任何违法操作. """ 新浪财经,爬取历史股票数据 ""&q ...

- Java爬取丁香医生疫情数据并存储至数据库

1.通过页面的url获取html代码 // 根URL private static String httpRequset(String requesturl) throws IOException { ...

- java 利用jsoup 爬取知乎首页问题

今天学了下java的爬虫,首先要下载jsoup的包,然后导入,导入过程:首先右击工程:Build Path ->configure Build Path,再点击Add External JARS ...

- 利用jsoup爬取百度网盘资源分享连接(多线程)

突然有一天就想说能不能用某种方法把百度网盘上分享的资源连接抓取下来,于是就动手了.知乎上有人说过最好的方法就是http://pan.baidu.com/wap抓取,一看果然链接后面的uk值是一串数字, ...

- Python:爬取全国各省疫情数据并在地图显示

代码: import requests import pymysql import json from pyecharts import options as opts from pyecharts. ...

- 5分钟python爬虫案例,手把手教爬取国内外最新疫情历史数据

俗话说的好,“授之以鱼不如授之以渔”,所以小编今天就把爬疫情历史数据的方法分享给你们. 基本思路:分析腾讯新闻“抗肺炎”版块,采用“倒推法”找到疫情数据接口,然后用python模拟请求,进而保存疫情历 ...

随机推荐

- CTF_show平台 web题解 part1

web3 题目描述: 方法一:RFI 使用url实现php远程文件包含 在服务器上构造1.txt <?php $a = "<?php eval(\$_POST['123'])?& ...

- 数据可视化之powerBI基础(十九)学会使用Power BI的参数,轻松搞定动态分析

https://zhuanlan.zhihu.com/p/55295072 静态的分析经常不能满足实际分析的需要,还需要引入动态分析,通过调节某个维度的增减变化来观察对分析结果的影响.在PowerBI ...

- 数据可视化实例(五): 气泡图(matplotlib,pandas)

https://datawhalechina.github.io/pms50/#/chapter2/chapter2 关联 (Correlation) 关联图表用于可视化2个或更多变量之间的关系. 也 ...

- 机器学习实战---决策树CART回归树实现

机器学习实战---决策树CART简介及分类树实现 一:对比分类树 CART回归树和CART分类树的建立算法大部分是类似的,所以这里我们只讨论CART回归树和CART分类树的建立算法不同的地方.首先,我 ...

- 性能测试必备知识(2)- 查看 Linux 的 CPU 相关信息

做性能测试的必备知识系列,可以看下面链接的文章哦 https://www.cnblogs.com/poloyy/category/1806772.html 查看系统 CPU 信息 cat /proc/ ...

- EF中延迟加载的那些事

延迟加载又称懒加载,通俗一点就是关联了一个对象,不用的时候不去查这个对象,当调用的时候再组织sql去查出这个对象的相关内容. 一.在使用EF时,我们会发现借助于框架生成的实体类中的的导航属性通常是标记 ...

- C++语法小记---开篇

几句闲话 由于C++的语法非常的复杂,但是实际使用的过程中,经常使用的语法也就那么一些,还有比较多的语法很少被使用,时间一长就容易忘记,因此“C++语法小记”主要是将C++中不经常使用和容易忘记的语法 ...

- 【requests库】七个主要方法

本文主要介绍requests库访问http的七个主要方法:get.head.post.put.patch.delete. requests.get()方法 get方法用于获取指定url的HTML网页, ...

- python-闭包和装饰器-01-闭包(closure)

闭包(closure) 闭包就是在一个函数定义的内部再定义一个函数,并且这个函数用到了外边函数的变量,那么将这个函数以及用到的一些变量称之为闭包,如: def line(a, b): def cal( ...

- Head First HTML与CSS(第2版)PDF高清完整版免费下载|百度云盘

百度云盘:Head First HTML与CSS(第2版)PDF高清完整版免费下载 提取码:i8q4 内容简介 是不是已经厌倦了那些深奥的HTML书?你可能在抱怨,只有成为专家之后才能读懂那些书.那么 ...