阿里云Centos7.6上面部署基于redis的分布式爬虫scrapy-redis将任务队列push进redis

Scrapy是一个比较好用的Python爬虫框架,你只需要编写几个组件就可以实现网页数据的爬取。但是当我们要爬取的页面非常多的时候,单个服务器的处理能力就不能满足我们的需求了(无论是处理速度还是网络请求的并发数),这时候分布式爬虫的优势就显现出来。

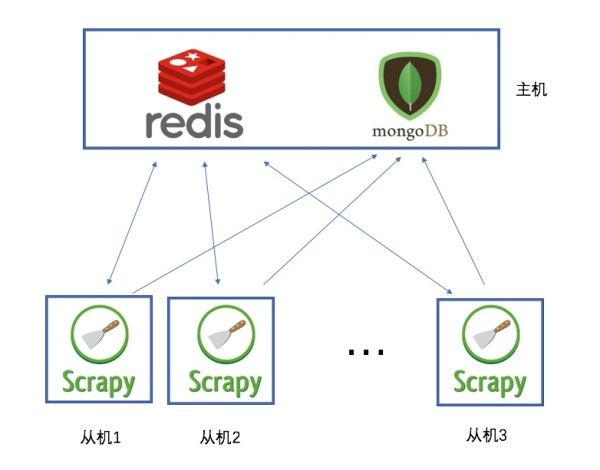

而Scrapy-Redis则是一个基于Redis的Scrapy分布式组件。它利用Redis对用于爬取的请求(Requests)进行存储和调度(Schedule),并对爬取产生的项目(items)存储以供后续处理使用。scrapy-redi重写了scrapy一些比较关键的代码,将scrapy变成一个可以在多个主机上同时运行的分布式爬虫。

说白了,就是使用redis来维护一个url队列,然后scrapy爬虫都连接这一个redis获取url,且当爬虫在redis处拿走了一个url后,redis会将这个url从队列中清除,保证不会被2个爬虫拿到同一个url,即使可能2个爬虫同时请求拿到同一个url,在返回结果的时候redis还会再做一次去重处理,所以这样就能达到分布式效果,我们拿一台主机做redis 队列,然后在其他主机上运行爬虫.且scrapy-redis会一直保持与redis的连接,所以即使当redis 队列中没有了url,爬虫会定时刷新请求,一旦当队列中有新的url后,爬虫就立即开始继续爬

首先分别在主机和从机上安装需要的爬虫库

pip3 install requests scrapy scrapy-redis redis

在主机中安装redis

#安装redis

yum install redis 启动服务

systemctl start redis 查看版本号

redis-cli --version 设置开机启动

systemctl enable redis.service

修改redis配置文件 vim /etc/redis.conf 将保护模式设为no,同时注释掉bind,为了可以远程访问,另外需要注意阿里云安全策略也需要暴露6379端口

改完配置后,别忘了重启服务才能生效

systemctl restart redis

然后分别新建爬虫项目

scrapy startproject myspider

在项目的spiders目录下新建test.py

#导包

import scrapy

import os

from scrapy_redis.spiders import RedisSpider #定义抓取类

#class Test(scrapy.Spider):

class Test(RedisSpider): #定义爬虫名称,和命令行运行时的名称吻合

name = "test" #定义redis的key

redis_key = 'test:start_urls' #定义头部信息

haders = {

'User-Agent': 'Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Ubuntu Chromium/73.0.3683.86 Chrome/73.0.3683.86 Safari/537.36'

} def parse(self, response):

print(response.url)

pass

然后修改配置文件settings.py,增加下面的配置,其中redis地址就是在主机中配置好的redis地址:

BOT_NAME = 'myspider' SPIDER_MODULES = ['myspider.spiders']

NEWSPIDER_MODULE = 'myspider.spiders' #设置中文编码

FEED_EXPORT_ENCODING = 'utf-8' # scrapy-redis 主机地址

REDIS_URL = 'redis://root@39.106.228.179:6379'

#队列调度

SCHEDULER = "scrapy_redis.scheduler.Scheduler"

#不清除缓存

SCHEDULER_PERSIST = True

#通过redis去重

DUPEFILTER_CLASS = "scrapy_redis.dupefilter.RFPDupeFilter"

#不遵循robots

ROBOTSTXT_OBEY = False

最后,可以在两台主机上分别启动scrapy服务

scrapy crawl test

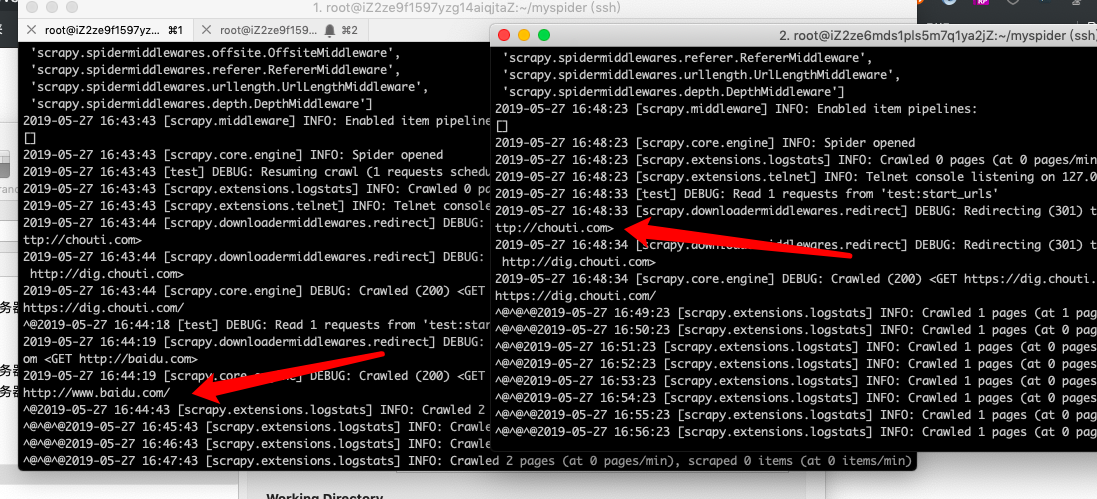

此时,服务已经起来了,只不过redis队列中没有任务,在等待状态

进入主机的redis

redis-cli

将任务队列push进redis

lpush test:start_urls http://baidu.com

lpush test:start_urls http://chouti.com

可以看到,两台服务器的爬虫服务分别领取了队列中的任务进行抓取,同时利用redis的特性,url不会重复抓取

爬取任务结束之后,可以通过flushdb命令来清除地址指纹,这样就可以再次抓取历史地址了。

阿里云Centos7.6上面部署基于redis的分布式爬虫scrapy-redis将任务队列push进redis的更多相关文章

- 在阿里云Centos7.6上面部署基于Redis的分布式爬虫Scrapy-Redis

原文转载自「刘悦的技术博客」https://v3u.cn/a_id_83 Scrapy是一个比较好用的Python爬虫框架,你只需要编写几个组件就可以实现网页数据的爬取.但是当我们要爬取的页面非常多的 ...

- 在阿里云Centos7.6中部署nginx1.16+uwsgi2.0.18+Django2.0.4

上次在网上找了一个在阿里云Centos7.6中部署nginx1.16+uwsgi2.0.18+Django2.0.4的文档,可能是这个文档不是最新版的,安装的时候遇到了很多问题, 最后跟一个大神要了一 ...

- 阿里云Centos7.6中部署nginx1.16+uwsgi2.0.18+Django2.0.4

当你购买了阿里云的ecs,涉及ecs的有两个密码,一定要搞清楚,一个密码是远程链接密码,也就是通过浏览器连接服务器的密码,另外一个是实例密码,这个密码就是ecs的root密码,一般情况下,我们经常用到 ...

- 【Docker】 使用Docker 在阿里云 Centos7 部署 MySQL 和 Redis (二)

系列目录: [Docker] CentOS7 安装 Docker 及其使用方法 ( 一 ) [Docker] 使用Docker 在阿里云 Centos7 部署 MySQL 和 Redis (二) [D ...

- 新手之首次部署阿里云centos7+mysql+asp.net mvc core应用之需要注意的地方

先来几个字,坑坑坑. 自己业余爱好者,签名一直捣鼓net+mssql,前阵买了阿里云esc,自己尝试做个博客,大体架子都打好了,本地安装了mysql,测试了也没问题. 部署到阿里云centos7,结果 ...

- 阿里云CentOS7部署ASP.NET Core

本文主要介绍了阿里云CentOS7下如何成功的发布ASP.Core应用并使用nginx进行代理, 并对所踩的坑加以记录; 环境.工具.准备工作 服务器:阿里云64位CentOS 7.4.1708版本; ...

- 阿里云服务器安装Docker并部署nginx、jdk、redis、mysql

阿里云服务器安装Docker并部署nginx.jdk.redis.mysql 一.安装Docker 1.安装Docker的依赖库 yum install -y yum-utils device-map ...

- 阿里云CentOS7部署MySql8.0

本文主要介绍了阿里云CentOS7如何安装MySql8.0,并对所踩的坑加以记录; 环境.工具.准备工作 服务器:阿里云CentOS 7.4.1708版本; 客户端:Windows 10; SFTP客 ...

- 阿里云CentOS7.3服务器通过Docker安装Nginx

前言 小编环境: 阿里云CentOS7.3服务器 docker 下面分享一次小编在自己的阿里云CentOS7.3服务器上使用Docker来安装Nginx的一次全过程 温馨小提示: 如果只是希望单纯使用 ...

随机推荐

- jenkins 中邮件发送

1.安装插件 jenkins中安装邮件插件,选择Email Extension 2.开启smtp服务,每个客户端的设置不一样,下图是qq邮箱,仅供参考 3.设置邮件服务 3.1系统设置 3.2 在任务 ...

- Xcode6在ios7上编译framework报错

错误描述: dyld: Symbol not found: _OBJC_CLASS_$_UIPresentationController Referenced from: /var/mobile/Ap ...

- Spring Boot第一天

1.首先在idea中创建一个maven项目,创建成功后在pom.xml中添加SpringBoot相关的依赖 <!--引入SpringBoot相关的依赖--> <parent> ...

- Python GUI之Tkiner实战

前言 Tkinter 是 Python 的标准 GUI 库.Python 使用 Tkinter 可以快速的创建 GUI 应用程序. 由于 Tkinter 是内置到 python 的安装包中.只要安装好 ...

- docker 中的mysql启动端口号总是被占用解决

解决: 1 查 netstat -lnp|grep 3306 2 杀 kill -9 3819 3 再查 netstat -lnp|grep 3306 4 发现还有,杀不尽 5 重启docker 6 ...

- CSS3 学习笔记(上)

一.CSS简介 CSS(Cascading Style Sheets)层叠样式表.其中,样式定义为如何显示HTML元素,它通常储存在样式表,将样式添加到HTML中,能够解决内容与表现分离的问题.由于网 ...

- C语言讲义——变量(variable)

变量(variable) 变量用于存放数据 变量是供程序操作的存储区的名字 变量有类型,该类型决定了变量占用内存的大小 字节→ C语言有以下6种简单变量类型: 类型细分: 变量在内存中需要占据空间,内 ...

- MySQL replace into那些隐藏的风险

目录 replace into时存在主键冲突 replace into时存在唯一索引冲突 replace into时存在主键冲突&唯一索引冲突 存在问题 结论 MySQL中 replace i ...

- python之切片操作,实现一个trim()函数,去除字符串首尾的空格.

# -*- coding: utf-8 -*- def trim(s): if len(s)==0: return '' if s[:1]==' ': return trim(s[1:]) elif ...

- 跳表(SkipList)原理篇

1.什么是跳表? 维基百科:跳表是一种数据结构.它使得包含n个元素的有序序列的查找和插入操作的平均时间复杂度都是 O(logn),优于数组的 O(n)复杂度.快速的查询效果是通过维护一个多层次的链表实 ...