吴裕雄--天生自然PYTHON爬虫:用API爬出天气预报信息

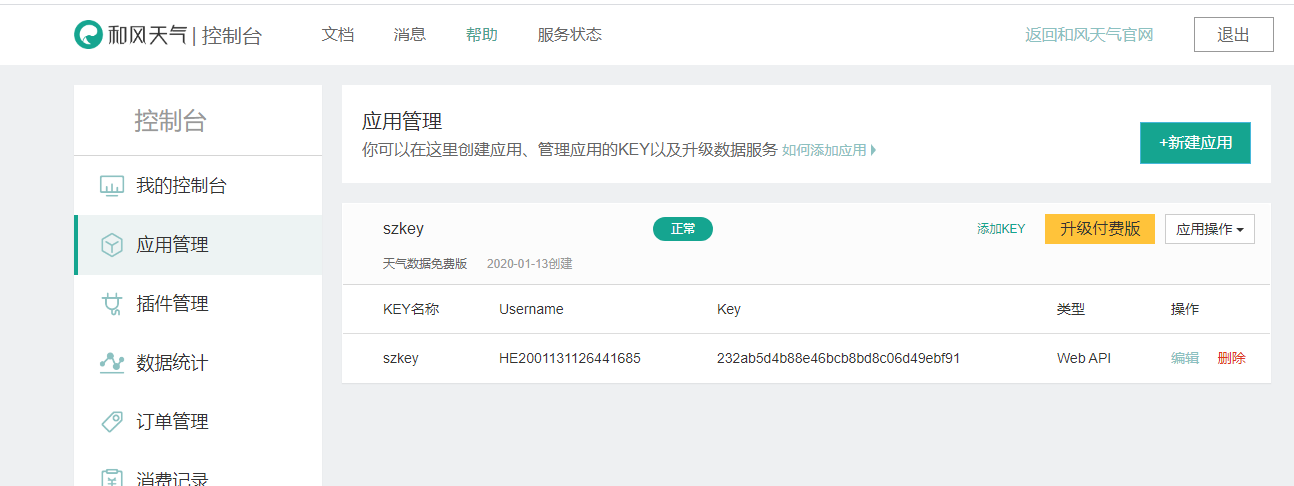

天气预报网址:https://id.heweather.com/,这个网站是需要注册获取一个个人认证后台密钥key的,并且每个人都有访问次数的限制,这个key就是访问API的钥匙。

这个key现在是要自己创建的,名称自己写,key值可以不写,创建的时候会自动生成。

接下来就是要阅读这个API文档。

包括上面怎么创建获取这个key这个API文档也有介绍的。

选择API这部分来阅读。

接口地址:

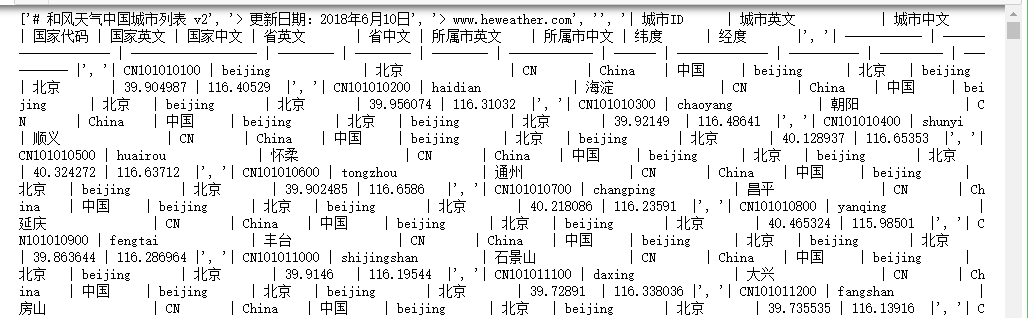

- #获取城市列表

- import requests

- url = 'https://cdn.heweather.com/china-city-list.txt'

- response = requests.get(url)

- response.encoding='utf8'

- data = response.text

- data_1 = data.split('\n')

- print(data_1)

- for i in range(3):

- data_1.remove(data_1[0])

- for item in data_1:

- print(item[0:11])

获取城市ID后,下一步就是调用接口获取数据。

- #获取城市数据

- import time

- import requests

- url = 'https://cdn.heweather.com/china-city-list.txt'

- response = requests.get(url)

- response.encoding='utf8'

- data = response.text

- data_1 = data.split('\n')

- for i in range(3):

- data_1.remove(data_1[0])

- for item in data_1:

- url = 'https://free-api.heweather.net/s6/weather/forecast?location='+item[1:13]+'&key=232ab5d4b88e46bcb8bd8c06d49ebf91'

- strhtml = requests.get(url)

- time.sleep(3)

- print(strhtml.text)

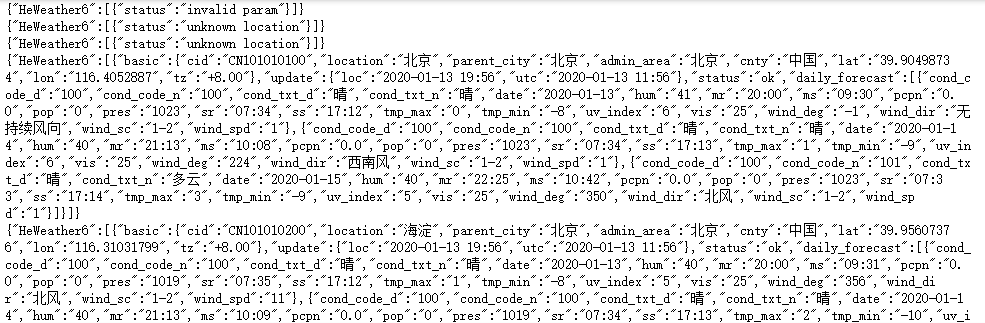

可以看到数据是以json数据格式返回的。如果要将返回的数据解析出来可以使用for循环。

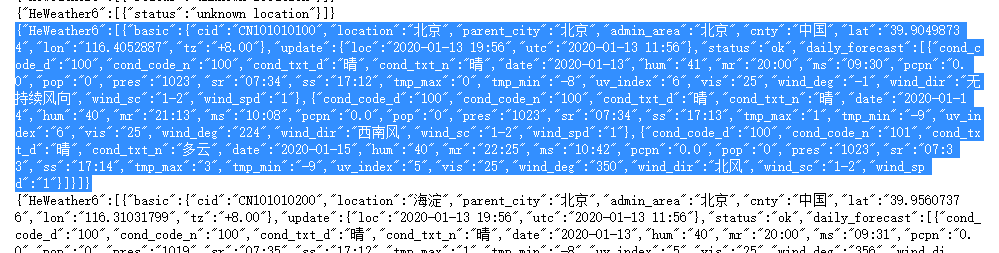

可以使用JSON在线结构化的工具观察数据结构,网址:http://www.json.org.cn/tools/JSONEditorOnline/index.htm

上图左边是原Json数据,右边显示的是它的保存数据的结构。

- #获取城市数据

- import os

- import time

- import requests

- url = 'https://cdn.heweather.com/china-city-list.txt'

- response = requests.get(url)

- response.encoding='utf8'

- data = response.text

- data_1 = data.split('\n')

- for i in range(3):

- data_1.remove(data_1[0])

- temp = 1

- for item in data_1:

- url = 'https://free-api.heweather.net/s6/weather/forecast?location='+item[1:13]+'&key=232ab5d4b88e46bcb8bd8c06d49ebf91'

- strhtml = requests.get(url)

- time.sleep(3)

- dic = strhtml.json()

- if(temp>3):

- #获取风向值

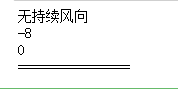

- print(dic['HeWeather6'][0]['daily_forecast'][0]['wind_dir'])

- #获取最低气温

- print(dic['HeWeather6'][0]['daily_forecast'][0]['tmp_min'])

- #获取最高气温

- print(dic['HeWeather6'][0]['daily_forecast'][0]['tmp_max'])

- print('================')

- else:

- temp+=1

吴裕雄--天生自然PYTHON爬虫:用API爬出天气预报信息的更多相关文章

- 吴裕雄--天生自然PYTHON爬虫:使用Selenium爬取大型电商网站数据

用python爬取动态网页时,普通的requests,urllib2无法实现.例如有些网站点击下一页时,会加载新的内容,但是网页的URL却没有改变(没有传入页码相关的参数),requests.urll ...

- 吴裕雄--天生自然PYTHON爬虫:爬取某一大型电商网站的商品数据(效率优化以及代码容错处理)

这篇博文主要是对我的这篇https://www.cnblogs.com/tszr/p/12198054.html爬虫效率的优化,目的是为了提高爬虫效率. 可以根据出发地同时调用多个CPU,每个CPU运 ...

- 吴裕雄--天生自然PYTHON爬虫:使用Scrapy抓取股票行情

Scrapy框架它能够帮助提升爬虫的效率,从而更好地实现爬虫.Scrapy是一个为了抓取网页数据.提取结构性数据而编写的应用框架,该框架是封装的,包含request异步调度和处理.下载器(多线程的Do ...

- 吴裕雄--天生自然PYTHON爬虫:爬虫攻防战

我们在开发者模式下不仅可以找到URL.Form Data,还可以在Request headers 中构造浏览器的请求头,封装自己.服务器识别浏览器访问的方法就是判断keywor是否为Request h ...

- 吴裕雄--天生自然PYTHON爬虫:安装配置MongoDBy和爬取天气数据并清洗保存到MongoDB中

1.下载MongoDB 官网下载:https://www.mongodb.com/download-center#community 上面这张图选择第二个按钮 上面这张图直接Next 把bin路径添加 ...

- 吴裕雄--天生自然PYTHON爬虫:使用BeautifulSoup解析中国旅游网页数据

import requests from bs4 import BeautifulSoup url = "http://www.cntour.cn/" strhtml = requ ...

- 吴裕雄--天生自然python爬虫:使用requests模块的get和post方式抓取中国旅游网站和有道翻译网站翻译内容数据

import requests url = 'http://www.cntour.cn/' strhtml = requests.get(url) print(strhtml.text) URL='h ...

- 吴裕雄--天生自然python学习笔记:爬取我国 1990 年到 2017年 GDP 数据并绘图显示

绘制图形所需的数据源通常是不固定的,比如,有时我们会需要从网页抓取, 也可能需从文件或数据库中获取. 利用抓取网页数据技术,把我国 1990 年到 2016 年的 GDP 数据抓取出来 ,再利用 Ma ...

- 吴裕雄--天生自然python学习笔记:Python3 错误和异常

语法错误 Python 的语法错误或者称之为解析错,是初学者经常碰到的,如下实例 >>>while True print('Hello world') File "< ...

随机推荐

- 更改yii框架入口文件位置,修改前后端访问路径

将frontend/web/index.php复制到项目根目录,修改为: <?php defined('YII_DEBUG') or define('YII_DEBUG', true); def ...

- python加密算法及其相关模块的学习(hashlib,RSA,random,string,math)

加密算法介绍 一,HASH Hash,一般翻译做“散列”,也有直接音译为”哈希”的,就是把任意长度的输入(又叫做预映射,pre-image),通过散列算法,变换成固定长度的输出,该输出就是散列值.这种 ...

- python开发基础作业01:模拟登陆系统

随老男孩学习python mark 作业要求及提示:编写登录接口 ''' 练习程序:编写登录接口 1. 输入用户名和密码 2. 认证成功后显示欢迎信息 3. 输错三次后锁定 输入三次后退出,下次同样用 ...

- 无刷新的批量图片上传插件.NET版

啥都不说,先上效果图: 这是一个网上的第三方组件,原版是php的,我用.NET重写了图片上传的处理,下面贴上代码 using System; using System.Collections.Gene ...

- ubuntu---查看、安装、切换内核

首先可以查看一下内核列表:sudo dpkg --get-selections | grep linux-image 查看Linux中安装了哪些内核: dpkg --get-selection ...

- 指令——mdadm

Mdadm命令详解 Linux内核中有一个md(multiple devices)模块在底层管理RAID设备,它会在应用层给我们提供一个应用程序的工具mdadm ,mdadm是linux下用于创建和管 ...

- inode节点使用率过大处理

当发现某个分区下的inode使用率过大时,需要找到该分区下的某些目录里有哪些文件可以清理. 查找某个目录下一个月或两个月之前的文件,然后删除# find . -type f -mtime +30 |w ...

- [idea] 解决 idea 复制进项目的文件运行时无法找到的问题

解决方法一: Rebuild后,重启项目 解决方法二:

- 「JSOI2014」支线剧情2

「JSOI2014」支线剧情2 传送门 不难发现原图是一个以 \(1\) 为根的有根树,所以我们考虑树形 \(\text{DP}\). 设 \(f_i\) 表示暴力地走完以 \(i\) 为根的子树的最 ...

- fiddler 保存请求数据并发送到自己的服务器接口

通过Rules菜单打开 Customize Rules 搜索 OnBeforeResponse 方法,再方法后面添加如下代码: if (oSession.fullUrl.Contains(" ...