kafka创建topic,生产和消费指定topic消息

启动zookeeper和Kafka之后,进入kafka目录(安装/启动kafka参考前面一章:https://www.cnblogs.com/cici20166/p/9425613.html)

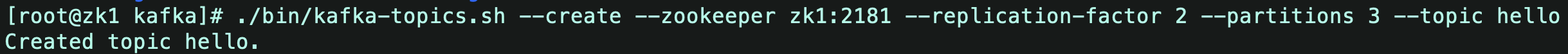

1.创建Topic

1)运行命令: ./bin/kafka-topics.sh --create --zookeeper zk1:2181 --replication-factor 2 --partitions 3 --topic hello

replication-factor:副本数,包含主节点,不能大于机器数

partitions:分区数,可以大于机器数

同一台机器不能包含两个相同的partition:hello-1/hello-1

但是可以有两个不同的分区:hello-2/hello-3

图示为创建成功:

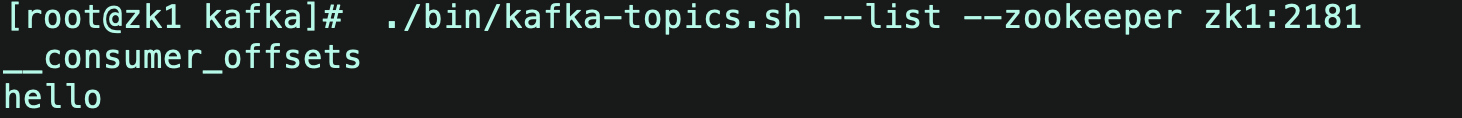

2.查看Topic

1)运行命令查看所有的topic: ./bin/kafka-topics.sh --list --zookeeper zk1:2181

结果如下图,表示共有test和test1两个topic:

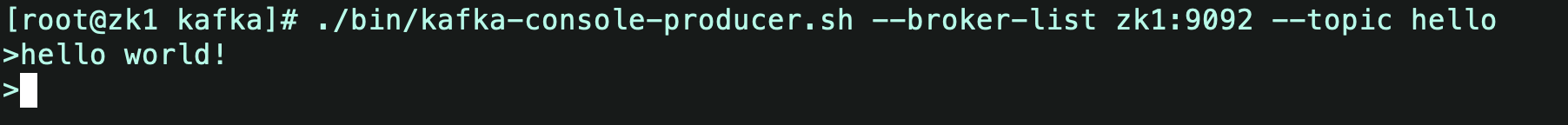

3.用Kafka的console-producer在topic hello 生产消息

新建终端窗口,到kafka目录,运行命令:./bin/kafka-console-producer.sh --broker-list zk1:9092 --topic hello

然后输入想要产生的消息内容(如 hello world),回车:

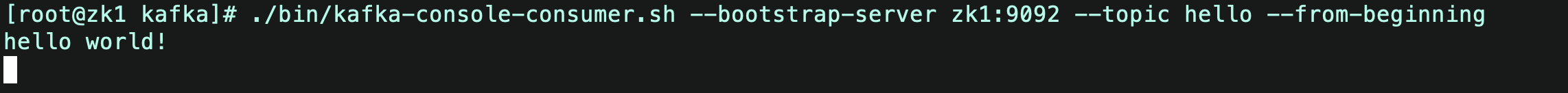

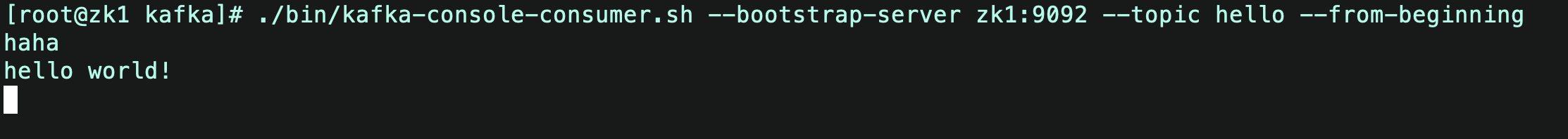

4.用Kafka的console-consumer 消费topic hello的消息

新建终端窗口,到kafka目录,

运行命令:./bin/kafka-console-consumer.sh --bootstrap-server zk1:9092 --topic hello --from-beginning

(9092是kafka单机启动的端口;--bootstrap-server 新旧kafka版本不一样,这个是新版本的命令)

ps. 1)若producer 和 consumer 两个窗口同时打开,在producer输入信息,consumer会立即消费信息并打印在终端

{{uploading-image-892112.png(uploading...)}}

{{uploading-image-443812.png(uploading...)}}

2)新开一个终端,去消费同一个topic,刚刚已经消费过的消息还会被新终端继续消费。也就是说,消息被消费过后不会立即被删除。(不同的groupid消费重新计算offset)

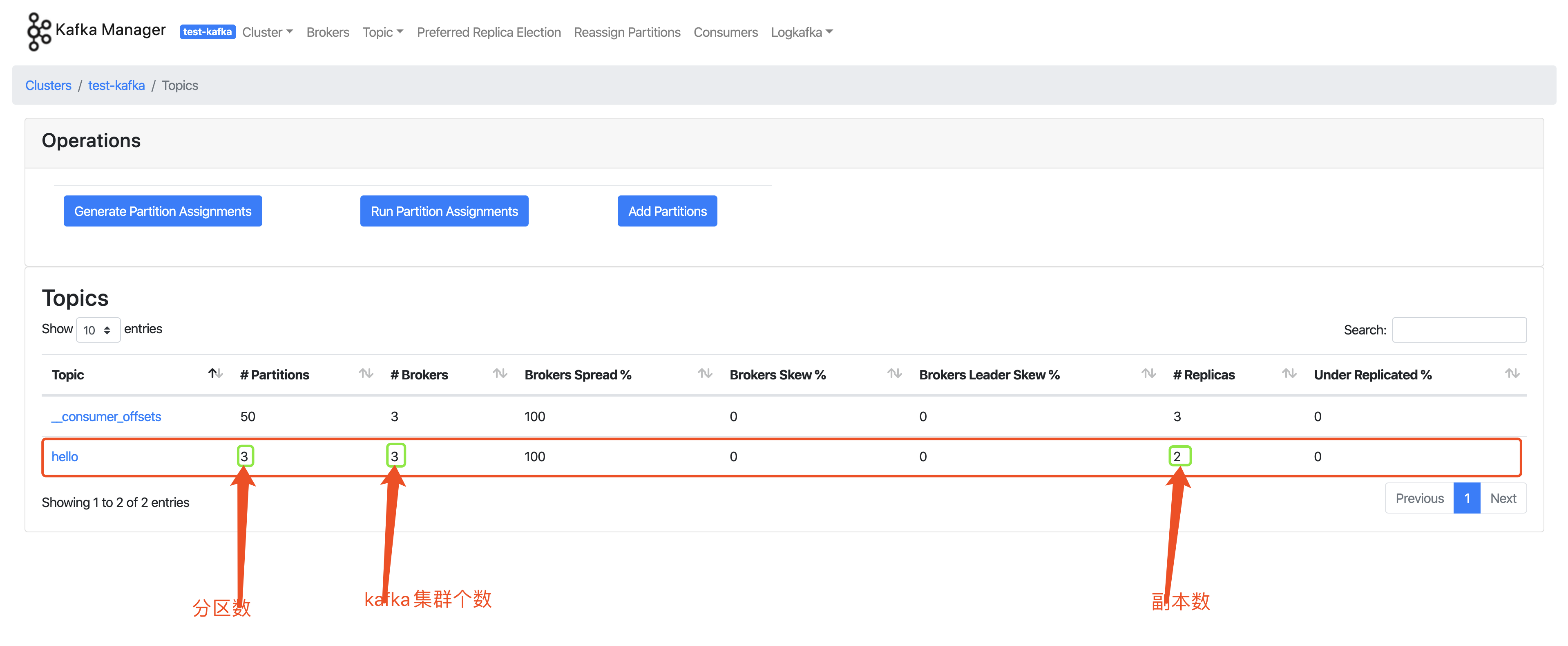

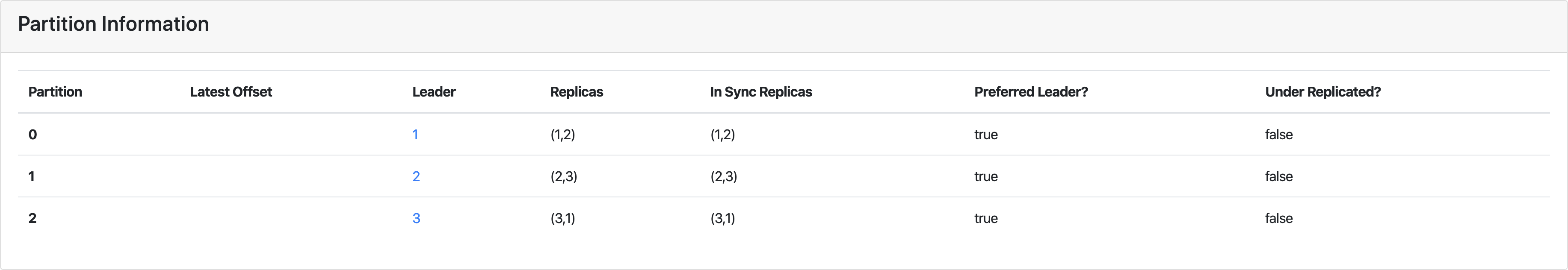

5.kafka-manager可以看到上述操作记录产生的影响

新增了一个topic

三个kafka-broker

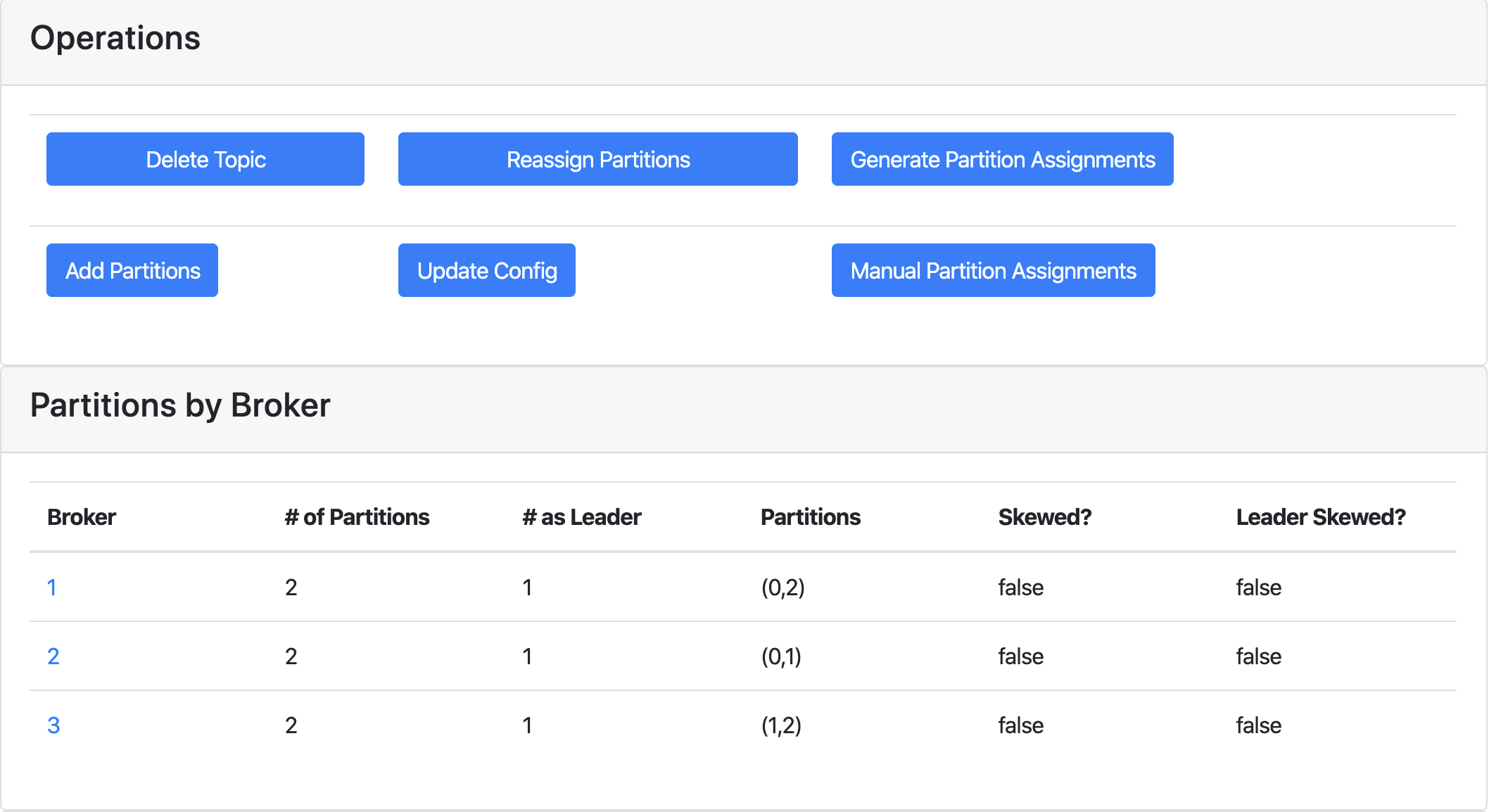

具体topic详情

kafka创建topic,生产和消费指定topic消息的更多相关文章

- Kafka创建&查看topic,生产&消费指定topic消息

启动zookeeper和Kafka之后,进入kafka目录(安装/启动kafka参考前面一章:https://www.cnblogs.com/cici20166/p/9425613.html) 1.创 ...

- docker搭建kafka环境&&Golang生产和消费

docker 搭建kafka环境 version: '2' services: zk1: image: confluentinc/cp-zookeeper:latest hostname: zk1 c ...

- Kafka 消费者是否可以消费指定分区消息?

Kafa consumer消费消息时,向broker发出fetch请求去消费特定分区的消息,consumer指定消息在日志中的偏移量(offset),就可以消费从这个位置开始的消息,customer拥 ...

- kafka消费者客户端启动之后消费不到消息的原因分析

如果你发现你的一个消费者客户端A已经启动了,但是就是不消费消息,此时你应该检查一下该消费者所在的组中(ConsumerGroup)是否还有其他的消费者,topic的分区可能被组中其他的消费者线程抢走( ...

- c语言使用librdkafka库实现kafka的生产和消费实例(转)

关于librdkafka库的介绍,可以参考kafka的c/c++高性能客户端librdkafka简介,本文使用librdkafka库来进行kafka的简单的生产.消费 一.producer librd ...

- 广播消费:允许一个 Group ID 所标识的所有 Consumer 都会各自消费某条消息一次。

什么是消息队列 RocketMQ?_消息队列 RocketMQ-阿里云 https://help.aliyun.com/document_detail/29532.html 2019-01-30 16 ...

- kafka查看Topic列表及消费状态等常用命令

环境 本文中的操作均基于kafka_1.3.3.0,且所有命令经过实际验证. 常用工具 新建Topic ./kafka-topics --zookeeper 166.188.xx.xx --creat ...

- kafka消费者如何才能从头开始消费某个topic的全量数据

消费者要从头开始消费某个topic的全量数据,需要满足2个条件(spring-kafka): (1)使用一个全新的"group.id"(就是之前没有被任何消费者使用过); (2)指 ...

- kafka2.x常用命令笔记(一)创建topic,查看topic列表、分区、副本详情,删除topic,测试topic发送与消费

接触kafka开发已经两年多,也看过关于kafka的一些书,但一直没有怎么对它做总结,借着最近正好在看<Apache Kafka实战>一书,同时自己又搭建了三台kafka服务器,正好可以做 ...

随机推荐

- 【AOP】在Aspect中无法获取实现类方法的注解

问题 MethodSignature methodSignature = (MethodSignature) (joinPoint.getSignature()); Method method = m ...

- js原型链。。fuck

function Person(name){ this.name = name; }; function Mother(){ }; //给mother提供公有的属性 Mother.prototype ...

- 程序启动:Serialize奋斗史

1.前方高能 在这电子与数据风驰电掣的世界里,人们一刻不停歇的工作着. 但是我却是一个被冷落的人, 因为我做的工作最近用的人太少了.大多数时候,我只能羡慕的看着线程.反射.注解.集合.泛型这些明星员工 ...

- hadoop常用的操作指令

-help:查看帮助 hadoop fs -help rm -rm [-f] [-r|-R] [-skipTrash] <src> ... : Delete all files that ...

- 仿有道词典App开发

最近在学习HCoder提供的仿有道词典App项目,该项目采用MUI为前端框架,服务端采用PHP,底层采用了H5+.

- python3列表操作

1.Python列表脚本操作符 2.Python列表截取 切片的公式:[start : end : step] 1)切片的取值: list1 = [1, 4, 9, 16, 25] print(lis ...

- WebAPI实例

@{ ViewBag.Title = "About"; } @*<script src="~/Scripts/jquery-1.7.1.min.js"&g ...

- rem布局js脚本代码

目前代码在750屏幕分辨率下是十倍 基本上使用iphone是375宽度 所以就是20倍 图片背景可以使用二倍图 (function (doc, win) { var docEl = doc.docum ...

- JAVA开源爬虫列表及简介

本文列举了一些较为常用的JAVA开源爬虫框架: 1.Apache Nutch 官方网站:http://nutch.apache.org/ 是否支持分布式:是 可扩展性:中.Apache Nutch并不 ...

- 机器学习中 为何要使用 独热编码 one-hot

背景 接触tensorflow时,学习到mnist,发现处理数据的时候采取one-hot编码,想起以前搞FPGA状态机遇到过格雷码与独热码. 解析: 将离散型特征使用one-hot编码,确实会让特征之 ...