Spark文档阅读之一:Spark Overview

1. spark的几种执行方式

1)交互式shell:bin/spark-shell

2)python: bin/pyspark & bin/spark-submit xx.py

3)R:bin/sparkR & bin/spark-submit xx.R

2. 任务的提交

bin/spark-submit \

--class <main-class> \ # 任务入口

--master <master-url> \ # 支持多种cluster manager

--deploy-mode <deploy-mode> \ # cluster / client,默认为client

--conf <key>=<value> \

... # other options,如--supervise(非0退出立即重启), --verbose(打印debug信息), --jars xx.jar(上传更多的依赖,逗号分隔,不支持目录展开)

<application-jar> \ # main-class来自这个jar包,必须是所有节点都可见的路径,hdfs://或file://

[application-arguments] # 入口函数的参数 bin/spark-submit \

--master <master-url> \

<application-python> \

[application-arguments]

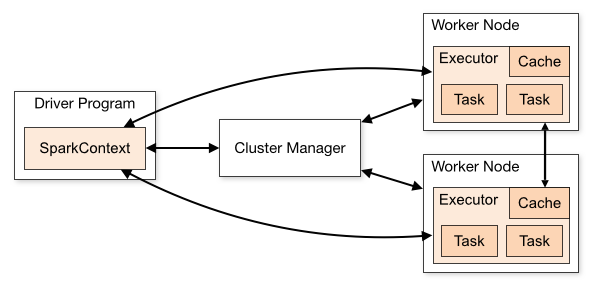

3. cluster模式

术语表

|

术语

|

含义

|

|

Application

|

任务,用户的spark程序,包含位于集群的一个driver和多个executors

|

|

Application jar

|

一个包含用户spark任务和依赖的jar包,不应包含hadoop或spark库

|

|

Driver program

|

任务main()函数和SparkContext所在的进程

|

|

Cluster manager

|

获取集群资源的外部服务

|

|

Deploy mode

|

用来区分driver进程在cluster还是client(即非cluster机器)上执行

|

|

Worker node

|

任何可以跑任务代码的节点

|

|

Executor

|

在worker node上载入并运行了用户任务的一个进程,它执行了tasks并且在内存或存储中保存数据,每个application独占它自己的executors

|

|

Task

|

一组被发送到一个executor的工作

|

|

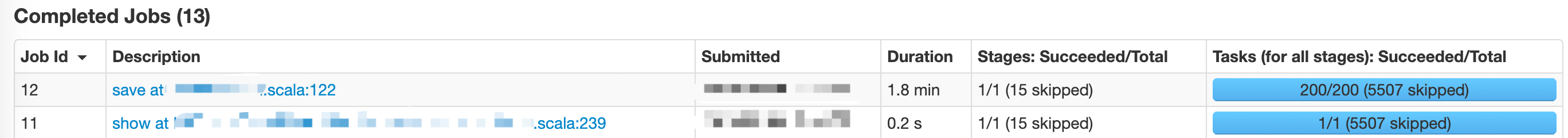

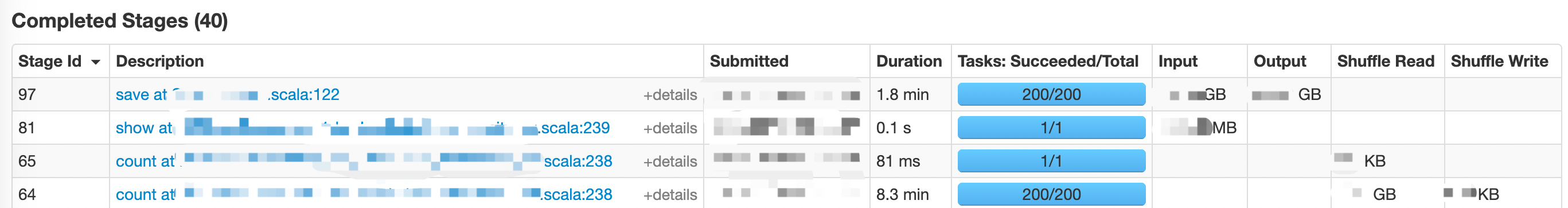

Job

|

一个多tasks的并行计算单元,对应一个spark操作(例如save, collect)

|

|

Stage

|

每个job可以划分成的更小的tasks集合,类似MapReduce中的map/reduce,stages相互依赖

|

Spark文档阅读之一:Spark Overview的更多相关文章

- Spark文档阅读之二:Programming Guides - Quick Start

Quick Start: https://spark.apache.org/docs/latest/quick-start.html 在Spark 2.0之前,Spark的编程接口为RDD (Resi ...

- 转:苹果Xcode帮助文档阅读指南

一直想写这么一个东西,长期以来我发现很多初学者的问题在于不掌握学习的方法,所以,Xcode那么好的SDK文档摆在那里,对他们也起不到什么太大的作用.从论坛.微博等等地方看到的初学者提出的问题,也暴露出 ...

- Django文档阅读-Day1

Django文档阅读-Day1 Django at a glance Design your model from djano.db import models #数据库操作API位置 class R ...

- Django文档阅读-Day3

Django文档阅读-Day3 Writing your first Django app, part 3 Overview A view is a "type" of Web p ...

- Node.js的下载、安装、配置、Hello World、文档阅读

Node.js的下载.安装.配置.Hello World.文档阅读

- 我的Cocos Creator成长之路1环境搭建以及基本的文档阅读

本人原来一直是做cocos-js和cocos-lua的,应公司发展需要,现转型为creator.会在自己的博客上记录自己的成长之路. 1.文档阅读:(cocos的官方文档) http://docs.c ...

- Keras 文档阅读笔记(不定期更新)

目录 Keras 文档阅读笔记(不定期更新) 模型 Sequential 模型方法 Model 类(函数式 API) 方法 层 关于 Keras 网络层 核心层 卷积层 池化层 循环层 融合层 高级激 ...

- Django文档阅读-Day2

Django文档阅读 - Day2 Writing your first Django app, part 1 You can tell Django is installed and which v ...

- Spark Streaming + Flume整合官网文档阅读及运行示例

1,基于Flume的Push模式(Flume-style Push-based Approach) Flume被用于在Flume agents之间推送数据.在这种方式下,Spark Stre ...

随机推荐

- LightOJ1336

题目大意: 给你一个 n ,求出 1 到 n 中有多少个数的因数和为偶数. 解题思路: 可以先求出因数和为奇数的数字的个数. 由算术基本定理我们可以得到:N=P1a1P2a2P3a3 … Pnan, ...

- Excel日期转换为PHP时间戳

PHP 的时间函数是从1970-1-1日开始计算的,单位是秒数.但是 EXCEL的是从1900-1-1日开始算的单位是天数. 如果只计算1970以后的时间的话,就好处理了. 先获得 EXCEL中 19 ...

- PHP cookie基本操作

PHP中Cookie的使用---添加/更新/删除/获取Cookie 及 自动填写该用户的用户名和密码和判断是否第一次登陆 什么是cookie 服务器在客户端保存用户的信息,比如登录名,密码等 这些数据 ...

- npm执行清理缓存失败npm cache clean

C:\Users\you name>npm cache cleannpm ERR! As of npm@5, the npm cache self-heals from corruption i ...

- Mac配置Jenkins(构建Allure模板报告)

通过jenkins.pkg程序安装 1.修改环境配置 编辑 vi ~/.bash_profile,添加命令别名: alias jk_start="sudo launchctl load /L ...

- ASP.NET Core WebAPI实现本地化(单资源文件)

在Startup ConfigureServices 注册本地化所需要的服务AddLocalization和 Configure<RequestLocalizationOptions> p ...

- 【朝夕Net社区技术专刊】Core3.1 WebApi集群实战专题---WebApi环境搭建运行发布部署篇

欢迎大家阅读<朝夕Net社区技术专刊>第1期 原文是我在知乎发表的,现在在这里分享! 我们致力于.NetCore的推广和落地,为更好的帮助大家学习,方便分享干货,特创此刊!很高兴你能成为首 ...

- git可视化打包更新文件

每次当我们修改了项目代码的时候,总需要理出来一个更新包发给测试部门或者给客户更新.当我们一次的修改的代码多了之后,我们就很难按照文件夹一个一个的去提交出来哪些的更新的,哪些是未修改的.于是乎就在度娘能 ...

- SpringBoot学习笔记(十五:OAuth2 )

@ 目录 一.OAuth 简介 1.什么是OAuth 2.OAuth 角色 3.OAuth 授权流程 4.OAuth授权模式 4.1.授权码 4.2.隐藏式 4.3.密码式 4.4.凭证式 二.实践 ...

- 容器技术之Dockerfile(二)

前文我们聊到了什么是dockerfile,它的主要作用以及dockerfile的一些基本指令的使用方法,回顾请参考https://www.cnblogs.com/qiuhom-1874/p/13019 ...