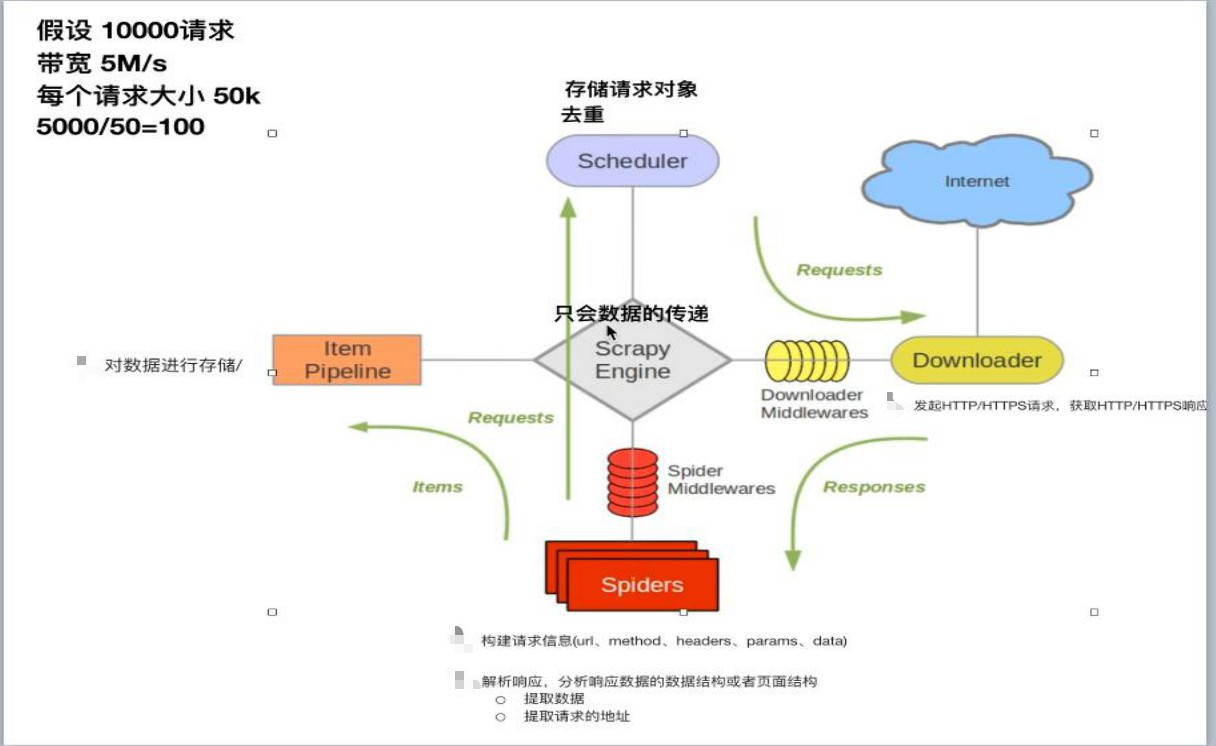

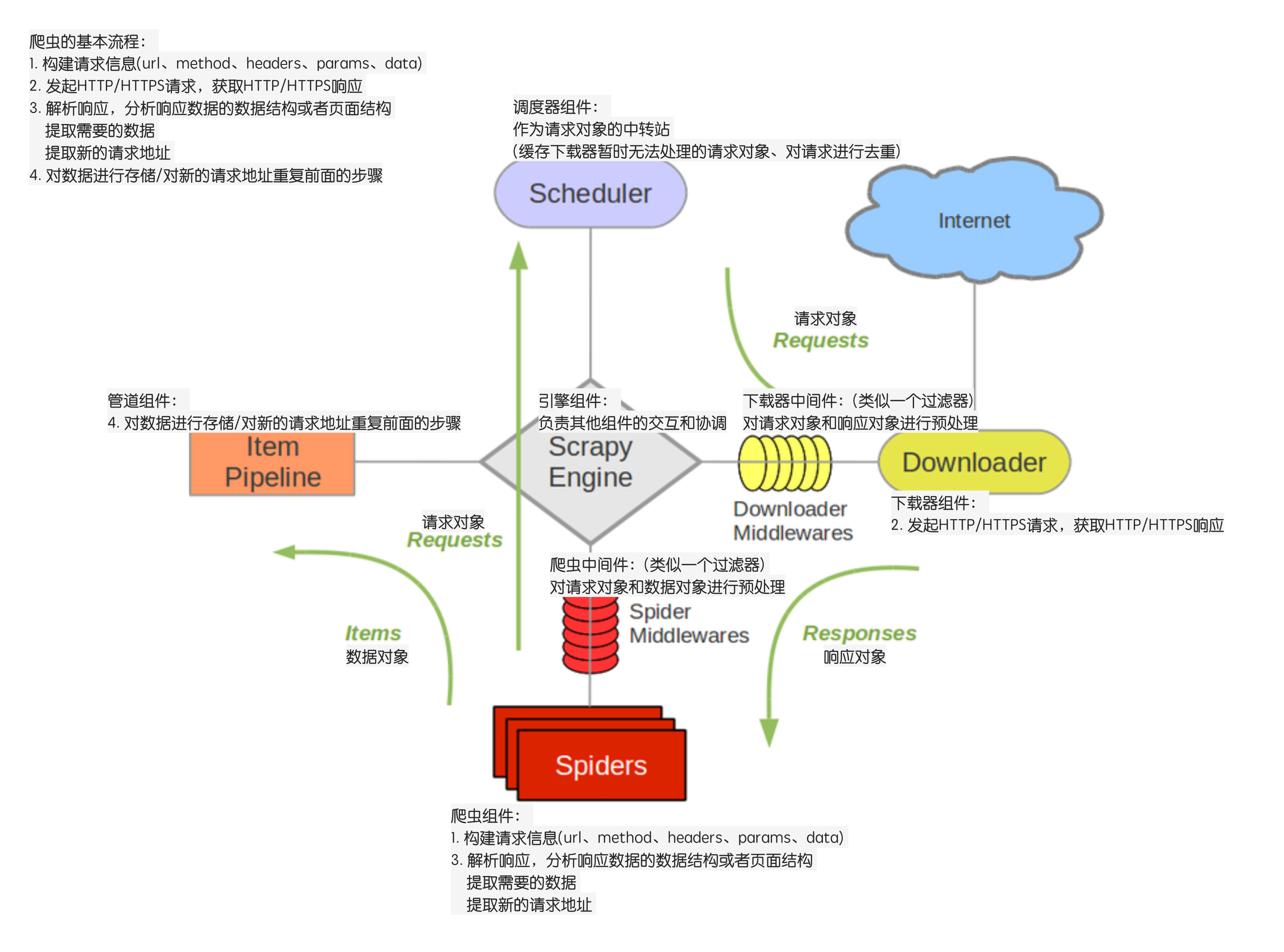

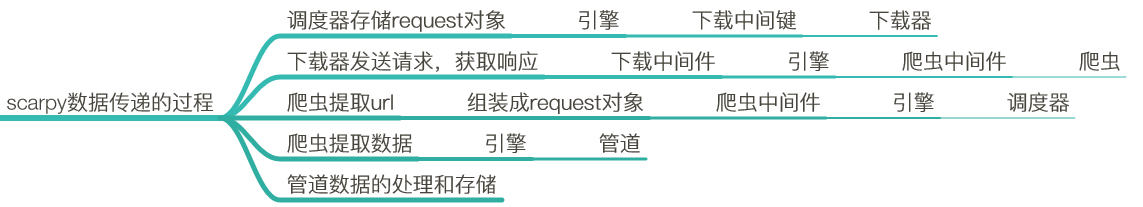

scrapy爬取数据的基本流程及url地址拼接

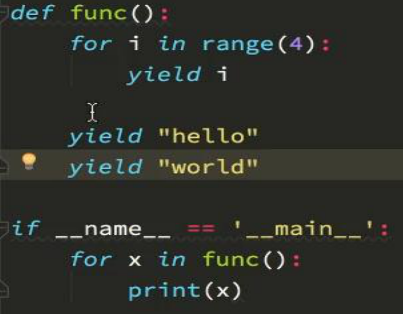

上面的代码应该改成:yield item

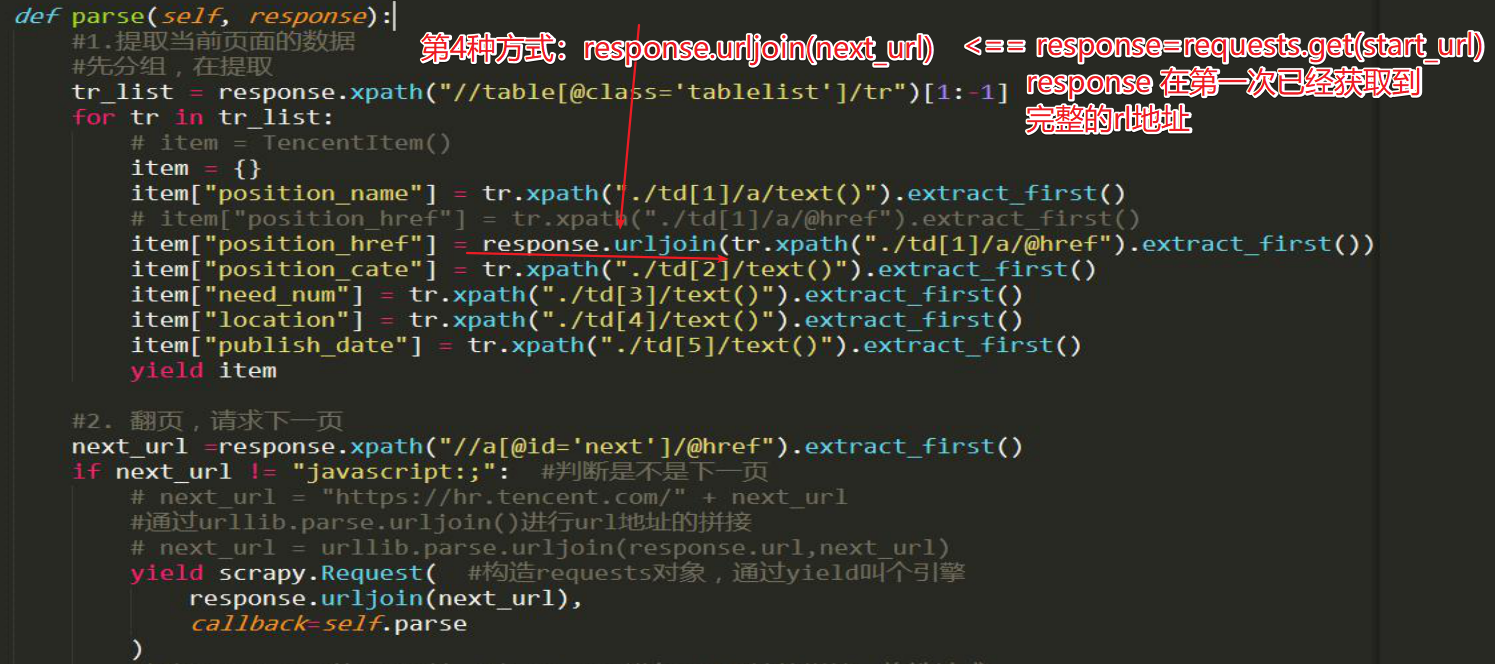

#主站链接 用来拼接

base_site = 'https://www.jpdd.com' def parse(self,response):

book_urls = response.xpath('//table[@class="p-list"]//a/@href').extract() for book_url in book_urls:

url = self.base_site + book_url

yield scrapy.Request(url, callback=self.getInfo) #获取下一页

next_page_url = self.base_site + response.xpath(

'//table[@class="p-name"]//a[contains(text(),"下一页")]/@href'

).extract()[0] yield scrapy.Request(next_page_url, callback=self.parse)

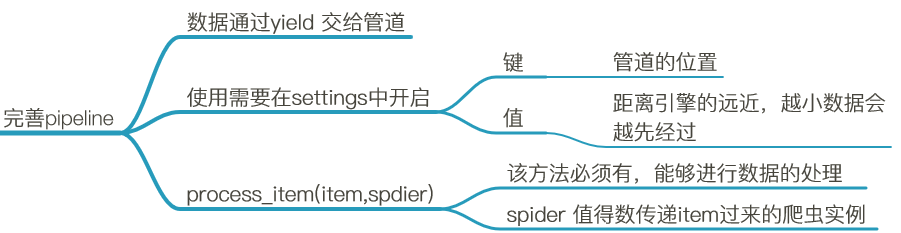

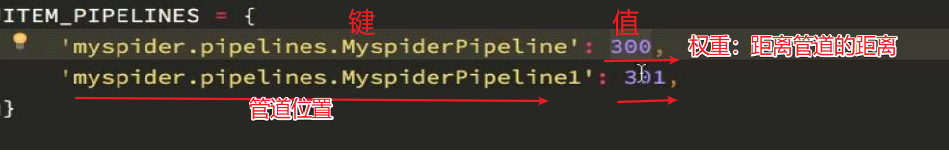

------数字越小,表示离引擎越近,数据越先经过处理,反之 。

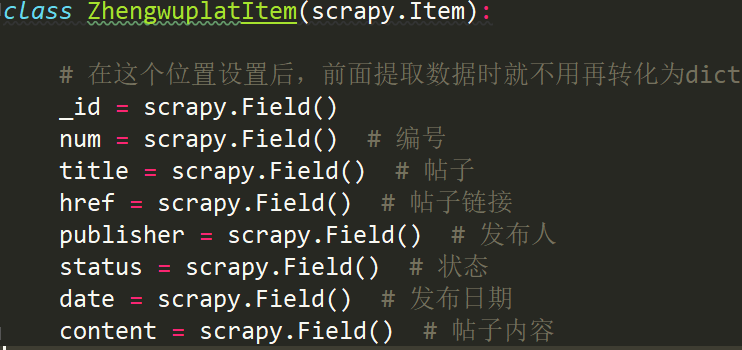

from yanguan.items import YanguanItem

item = YanguanItem() #实例化

参数说明:

括号中的参数为可选参数

callback:表示当前的url的响应交给哪个函数去处理

meta:实现数据在不同的解析函数中传递,meta默认带有部分数据,比如下载延迟,请求深度等

dont_filter:默认会过滤请求的url地址,即请求过的url地址不会继续被请求,对需要重复请求的url地址可以把它设置为Ture,比如贴吧的翻页请求,页面的数据总是在变化;start_urls中的地址会被反复请求,否则程序不会启动

scrapy爬取数据的基本流程及url地址拼接的更多相关文章

- 如何提升scrapy爬取数据的效率

在配置文件中修改相关参数: 增加并发 默认的scrapy开启的并发线程为32个,可以适当的进行增加,再配置文件中修改CONCURRENT_REQUESTS = 100值为100,并发设置成了为100. ...

- 将scrapy爬取数据通过django入到SQLite数据库

1. 在django项目根目录位置创建scrapy项目,django_12是django项目,ABCkg是scrapy爬虫项目,app1是django的子应用 2.在Scrapy的settings.p ...

- python之scrapy爬取数据保存到mysql数据库

1.创建工程 scrapy startproject tencent 2.创建项目 scrapy genspider mahuateng 3.既然保存到数据库,自然要安装pymsql pip inst ...

- 42.scrapy爬取数据入库mongodb

scrapy爬虫采集数据存入mongodb采集效果如图: 1.首先开启服务切换到mongodb的bin目录下 命令:mongod --dbpath e:\data\db 另开黑窗口 命令:mongo. ...

- scrapy爬取数据进行数据库存储和本地存储

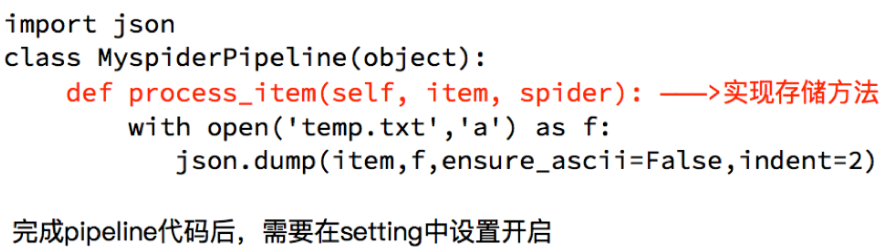

今天记录下scrapy将数据存储到本地和数据库中,不是不会写,因为小编每次都写觉得都一样,所以记录下,以后直接用就可以了-^o^- 1.本地存储 设置pipel ines.py class Ak17P ...

- scrapy爬取数据保存csv、mysql、mongodb、json

目录 前言 Items Pipelines 前言 用Scrapy进行数据的保存进行一个常用的方法进行解析 Items item 是我们保存数据的容器,其类似于 python 中的字典.使用 item ...

- Python使用Scrapy框架爬取数据存入CSV文件(Python爬虫实战4)

1. Scrapy框架 Scrapy是python下实现爬虫功能的框架,能够将数据解析.数据处理.数据存储合为一体功能的爬虫框架. 2. Scrapy安装 1. 安装依赖包 yum install g ...

- 爬虫必知必会(6)_提升scrapy框架爬取数据的效率之配置篇

如何提升scrapy爬取数据的效率:只需要将如下五个步骤配置在配置文件中即可 增加并发:默认scrapy开启的并发线程为32个,可以适当进行增加.在settings配置文件中修改CONCURRENT_ ...

- 提高Scrapy爬取效率

1.增加并发: 默认scrapy开启的并发线程为32个,可以适当进行增加.在settings配置文件中修改CONCURRENT_REQUESTS = 100值为100,并发设置成了为100. 2.降低 ...

随机推荐

- Java多线程系列 基础篇07 synchronized底层优化

转载 http://www.cnblogs.com/paddix/ 作者:liuxiaopeng http://www.infoq.com/cn/articles/java-se-16-synchro ...

- 在ubuntu怎样修改默认的编码格式

ubuntu修改系统默认编码的方法是: 1. 参考 /usr/share/i18n/SUPPORTED 编辑/var/lib/locales/supported.d/* gedit /var/lib/ ...

- poj 1469 COURSES (二分图模板应用 【*模板】 )

COURSES Time Limit: 1000MS Memory Limit: 10000K Total Submissions: 18454 Accepted: 7275 Descript ...

- CodeForces - 552E Vanya and Brackets —— 加与乘运算的组合

题目链接:https://vjudge.net/contest/224393#problem/E Vanya is doing his maths homework. He has an expres ...

- python日期格式化符号

python中时间日期格式化符号: %y 两位数的年份表示(00-99) %Y 四位数的年份表示(000-9999) %m 月份(01-12) %d 月内中的一天(0-31) %H 24小时制小时数( ...

- 金色酒类企业dedecms模板

金色酒类企业dedecms模板,网站模板,dedecms模板. 模板地址:http://www.huiyi8.com/sc/7276.html

- 企业安全建设之搭建开源SIEM平台(上)

前言 SIEM(security information and event management),顾名思义就是针对安全信息和事件的管理系统,针对大多数企业是不便宜的安全系统,本文结合作者的经验介绍 ...

- java.sql.SQLException: Access denied for user 'Administrator'@'localhost' (using password: YES)

早上在做MyBatis+Spring整合的时候爆了个奇葩的bug: 十月 19, 2017 11:18:11 上午 org.springframework.context.support.Abstra ...

- BZOJ_3550_[ONTAK2010]Vacation&&BZOJ_1283:_序列_网络流解线性规划

BZOJ_3550_[ONTAK2010]Vacation&&BZOJ_1283:_序列_网络流解线性规划 Description 给出一个长度为 的正整数序列Ci,求一个子序列,使得 ...

- ACM学习历程—HDU1028 Ignatius and the Princess(组合数学)

Ignatius and the Princess Description "Well, it seems the first problem is too easy. I w ...