CNN网络--VGGNet

- Simonyan, Karen, and Andrew Zisserman. "Very deep convolutional networks for large-scale image recognition." arXiv preprint arXiv:1409.1556 (2014). pdf (VGGNet,Neural Networks become very deep!)

- VGGNet,牛津大学计算机视觉组(Visual Geometry Group)和Google DeepMind公司一起研发,深度卷积神经网络。VGGNet反复堆叠3x3小型卷积核和2x2最大池化层,成功构筑16~19层深卷积神经网络。比state-of-the-art网络结构,错误率幅下降,取得ILSVRC 2014比赛分类第2名和定位第1名。拓展性强,迁移其他图片数据泛化性好。结构简洁,整个网络都用同样大小卷积核尺寸和最大池化尺寸。VGGNet训练后模型参数官方开源,domain specific图像分类任务再训练,提供较好初始化权重。

- 网络结构

VGGNet 5段卷积,每段2~3卷积层,每段后接最大池化层给缩小图片尺寸。每段卷积核数量一样,越后段卷积核数量越多,64-128-256-512-512。多个3x3卷积层堆叠。2个3x3卷积层串联相当1个5x5。3个3x3卷积层串联相当1个7x7。 参数更少,非线性变换更多,增强特征学习能力。

先训练级别A简单网络,再复用A网络权重初如化复杂模型,训练收敛速度更快。预测,Multi-Scale,图像scale尺寸Q,图片输入卷积网络计算。最后卷积层,滑窗分类预测,不同窗口分类结果平均,不同尺寸Q结果平均得最后结果,提高图片数据利用率,提升预测准确率。训练过程,用Multi-Scale数据增强,原始图像缩放不同尺寸S,随机裁切224x224图片,增加数据量,防止过拟合。

LRN层作用不大,越深网络效果越好,1x1卷积很有效,但大卷积核可以学习更大空间特征。

VGGNet-16网络结构,6个部分,前5段卷积网络,最后一段全连接网络。定义创建VGGNet网络结构函数inference_op。输入input_op、keep_prob(控制dropout比率,placeholder)。先初始化参数列表p。

创建第一段卷积网络,两个卷积层(conv_op),一个最大池化层(mpool_op)。卷积核大小3x3,卷积核数量(输出通道数) 64,步长1x1,全像素扫描。第一卷积层输入input_op尺寸224x224x3,输出尺寸224x224x64。第二卷积层输入输出尺寸224x224x64。最大池化层2x2,输出112x112x64。

第二段卷积网络,2个卷积层,1个最大池化层。卷积输出通道数128。输出尺寸56x56x128。

第三段卷积网络,3个卷积层,1个最大池化层。卷积输出通道数256。输出尺寸28x28x256。

第四段卷积网络,3个卷积层,1个最大池化层。卷积输出通道数512。输出尺寸14x14x512。

第五段卷积网络,3个卷积层,1个最大池化层。卷积输出通道数512。输出尺寸7x7x512。输出结果每个样本,tf.reshape 扁平化为长度7x7x512=25088一维向量。

连接4096隐含点全连接层,激活函数ReLU。连接Dropout层,训练节点保留率0.5,预测1.0。

全连接层,Dropout层。

最后连接1000隐含点全连接层,Softmax 分类输出概率。tf.argmax 输出概率最大类别。返回fc8、softmax、predictions、参数列表p。

VGGNet-16网络结构构建完成。

理解网络

通过逐步增加网络深度来提高性能,虽然看起来有一点小暴力,没有特别多取巧的,但是确实有效,很多pretrained的方法就是使用VGG的model(主要是16和19),VGG相对其他的方法,参数空间很大,最终的model有500多m,alnext只有200m,googlenet更少,所以train一个vgg模型通常要花费更长的时间,所幸有公开的pretrained model让我们很方便的使用,前面neural style文章里面就使用的pretrained的model.

减少参数的措施,对于一组(假定3个,paper里面只stack of three 33)卷积相对于77在使用3层的非线性关系(3层RELU)的同时保证参数数量为3(32C2)=27C2的,而7*7为49C2,参数约为77的81%。

去掉了LRN,减少了内存的小消耗和计算时间

虽然从A到E每一级网络逐渐变深,但是网络的参数量并没有增长很多,这是因为参数量主要都消耗在最后3个全连接层。前面的卷积部分虽然很深,但是消耗的参数量不大,不过训练比较耗时的部分依然是卷积,因其计算量比较大。这其中的D、E也就是我们常说的 VGGNet-16 和 VGGNet-19。C相比B多了几个1´1的卷积层,1´1卷积的意义主要在于线性变换,而输入通道数和输出通道数不变,没有发生降维。

采用 Pre-trained 方法利用浅层网络(A)训练参数初始化深层网络参数(D,E),加速收敛;采用 Multi-Scale 方法进行数据增强、训练、测试,提高准确率;去掉了 LRN,减少了内存的小消耗和计算时间。

虽然 VGGNet 减少了卷积层参数,但实际上其参数空间比 AlexNet 大,其中绝大多数的参数都是来自于第一个全连接层,耗费更多计算资源。在随后的 NIN 中发现将这些全连接层替换为全局平均池化,对于性能影响不大,同时显著降低了参数数量。

采用 Pre-trained 方法训练的 VGG model(主要是 D 和 E),相对其他的方法参数空间很大,所以训练一个 VGG 模型通常要花费更长的时间,所幸有公开的 Pre-trained model 让我们很方便的使用。

两个连续的3*3的卷积相当于5*5的感受野,三个相当于7*7。使用三个3*3卷积而不是一个7*7的卷积的优势有两点:一,包含三个ReLu层而不是一个,使决策函数更有判别性;二,减少了参数。比如输入输出都是C个通道,使用3*3的3个卷积层需要3(3*3*C*C)=27*C*C,使用7*7的1个卷积层需要7*7*C*C=49C*C。这可看为是对7*7卷积施加一种正则化,使它分解为3个3*3的卷积。

1*1卷积层主要是为了增加决策函数的非线性,而不影响卷积层的感受野。虽然1*1的卷积操作是线性的,但是ReLu增加了非线性。

与他人工作对比:Ciresan et al.(2011)也曾用过小的卷积,但是他的网络没有VGGNet深,而且没有在大规模的ILSVRC数据集上测试。Goodfellow使用深的卷积网络(11层)做街道数字识别,表明增加卷及网络深度可以提高性能。GoogLeNet(ILSVRC-2014分类任务冠军)与VGGNet独立发展起来,同样的是也使用了很深的卷积网络(22层)和小的卷积(5*5,3*3,1*1)。

- 训练

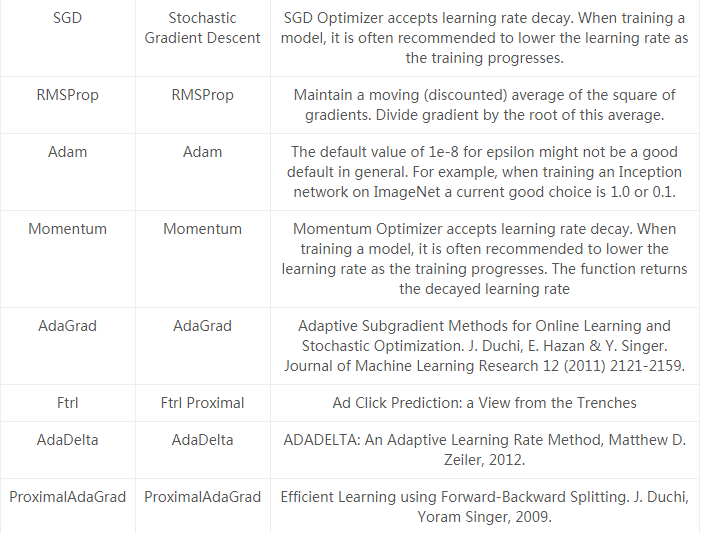

优化方法(optimizer)是含有动量的随机梯度下降SGD+momentum(0.9)。

批尺寸(batch size)是256.

正则化(regularization):采用L2正则化,weight decay是5e-4。dropout在前两个全连接层后,p=0.5。

尽管相比于AlexNet网络更深,参数更多,但是我们推测VGGNet在更少的周期内就能收敛,原因有二:一,更大的深度和更小的卷积带来隐式的正则化;二,一些层的预训练。

参数初始化:对于较浅的A网络,参数进行随机初始化,权重w从N(0,0.01)中采样,偏差bias初始化为0。然后,对于较深的网络,先用A网络的参数初始化前四个卷积层和三个全连接层。但是后来发现,不用预训练的参数而直接随机初始化也可以。

为了获得224*224的输入图像,要在每个sgd迭代中对每张重新缩放(rescale)的图像随机裁剪。为了增强数据集,裁剪的图像还要随机水平翻转和RGB色彩偏移。

- 测试

测试阶段步骤:

1,对输入图像各向同性地重缩放到一个预定义的最小图像边的尺寸Q;

2. 网络密集地应用在重缩放后的测试图像上。也就是说全连接层转化为卷积层(第一个全连接层转化为7*7的卷积层,后两个全连接层转化为1*1的卷积层) ,然后将转化后的全连接层应用在整张图像上。结果就是一个类别分数图(class score map),其通道数等于类别数量,依赖于图像尺寸,具有不同的空间分辨率。

3. 为了获得固定尺寸的类别分数向量(class score vector),对class score map进行空间平均化处理(sum-pooled)。

- tflearn_example

- TFLearn 支持不同的 optimizer; TFlearn 下还支持 vgg_network_finetuning.py,利用已经训练的 model 在自己的 dataset 上 finetune。

Reference

CNN网络--VGGNet的更多相关文章

- 【深度学习系列】用PaddlePaddle和Tensorflow实现经典CNN网络Vgg

上周我们讲了经典CNN网络AlexNet对图像分类的效果,2014年,在AlexNet出来的两年后,牛津大学提出了Vgg网络,并在ILSVRC 2014中的classification项目的比赛中取得 ...

- 【TensorFlow-windows】(七) CNN之VGG-net的测试

主要内容: 1.CNN之VGG-net的测试 2.该实现中的函数总结 平台: 1.windows 10 64位 2.Anaconda3-4.2.0-Windows-x86_64.exe (当时TF还不 ...

- Keras如何构造简单的CNN网络

1. 导入各种模块 基本形式为: import 模块名 from 某个文件 import 某个模块 2. 导入数据(以两类分类问题为例,即numClass = 2) 训练集数据data 可以看到,da ...

- [论文解读]CNN网络可视化——Visualizing and Understanding Convolutional Networks

概述 虽然CNN深度卷积网络在图像识别等领域取得的效果显著,但是目前为止人们对于CNN为什么能取得如此好的效果却无法解释,也无法提出有效的网络提升策略.利用本文的反卷积可视化方法,作者发现了AlexN ...

- 【深度学习系列】用PaddlePaddle和Tensorflow实现经典CNN网络AlexNet

上周我们用PaddlePaddle和Tensorflow实现了图像分类,分别用自己手写的一个简单的CNN网络simple_cnn和LeNet-5的CNN网络识别cifar-10数据集.在上周的实验表现 ...

- MINIST深度学习识别:python全连接神经网络和pytorch LeNet CNN网络训练实现及比较(三)

版权声明:本文为博主原创文章,欢迎转载,并请注明出处.联系方式:460356155@qq.com 在前两篇文章MINIST深度学习识别:python全连接神经网络和pytorch LeNet CNN网 ...

- 基于CNN网络的汉字图像字体识别及其原理

现代办公要将纸质文档转换为电子文档的需求越来越多,目前针对这种应用场景的系统为OCR系统,也就是光学字符识别系统,例如对于古老出版物的数字化.但是目前OCR系统主要针对文字的识别上,对于出版物的版面以 ...

- tensorflow实现一个神经网络简单CNN网络

本例子用到了minst数据库,通过训练CNN网络,实现手写数字的预测. 首先先把数据集读取到程序中(MNIST数据集大约12MB,如果没在文件夹中找到就会自动下载): mnist = input_da ...

- 数据挖掘入门系列教程(十一点五)之CNN网络介绍

在前面的两篇博客中,我们介绍了DNN(深度神经网络)并使用keras实现了一个简单的DNN.在这篇博客中将介绍CNN(卷积神经网络),然后在下一篇博客中将使用keras构建一个简单的CNN,对cifa ...

随机推荐

- python小数据池,代码块深入剖析

小数据池 目的:缓存我们字符串,整数,布尔值.在使用的时候不需要创建更多的对象 缓存:int,str,bool int:缓存范围-5~256 str: 1.长度小于等于1,直接缓存 2.长度大于 ...

- day01_04.变量

变量的命名规则 变量名由字母小写a-z,大写A-Z,_下划线,数字0-9组成,php的变量名区分大小写;python的变量名也是区分大小写的 注意: PHP变量名必须以美元$符号开始; 变量名开头可以 ...

- EOJ Monthly 2018.3

985月赛我只喜欢ECNU.jpg A. 打工时不可能打工的 Time limit per test: 2.0 seconds Memory limit: 256 megabytes 我 Ayano ...

- Jeddict:从服务器的验证过程,思考学习新事物的套路

结合一路研究Jeddict使用的过程经验来看,在这里说一下关于服务器配置的东西.在我们团队,最开始用这个插件的时候,因为公司用的应用服务器是Jboss EAP 7,所以,我们自然而然的,想当然的直接使 ...

- java web项目防止多用户重复登录解决方案

原创作品,允许转载,转载时请务必以超链接形式标明文章 原始出处 .作者信息和本人声明.否则将追究法律责任.作者:永恒の_☆ 地址:http://blog.csdn.net/chenghui031 ...

- C#递归删除进程及其子进程

/// <summary> /// 结束进程和相关的子进程 /// </summary> /// <param name="pid">需要结束的 ...

- UVa11361 Investigating Div-Sum Property

数位DP f[位数][自身模k余数][各位数字之和模k余数][当前位是否有上限]=方案数 k<10000,空间不够,如何优化? 不必优化,2^31以内,数字最多只有10位,各位数字之和最多为99 ...

- 手动创建DataTable并绑定gridview

原文发布时间为:2008-08-04 -- 来源于本人的百度文章 [由搬家工具导入] using System;using System.Data;using System.Configuration ...

- luogu 3708 koishi的数学题 递推 线性筛

题目链接 题意 输入一个整数\(n\)\((n\leq 1e6)\),设\(f(x)=\sum_{i=1}^n x\mod i\),你需要输出\(f(1),f(2)...,f(n)\). 输入输出格式 ...

- configure: error: off_t undefined; check your library configuration

configure: error: off_t undefined; check your library configuration 发生背景: 编译PHP时出现的提示,报错信息为: configu ...