Hive详解(05) - 压缩和存储

Hive详解(05) - 压缩和存储

Hadoop压缩配置

MR支持的压缩编码

|

压缩格式 |

算法 |

文件扩展名 |

是否可切分 |

|

DEFLATE |

.deflate |

否 |

|

|

Gzip |

DEFLATE |

.gz |

否 |

|

bzip2 |

bzip2 |

.bz2 |

是 |

|

LZO |

LZO |

.lzo |

是 |

|

Snappy |

Snappy |

.snappy |

否 |

为了支持多种压缩/解压缩算法,Hadoop引入了编码/解码器,如下表所示:

|

压缩格式 |

对应的编码/解码器 |

|

DEFLATE |

org.apache.hadoop.io.compress.DefaultCodec |

|

gzip |

org.apache.hadoop.io.compress.GzipCodec |

|

bzip2 |

org.apache.hadoop.io.compress.BZip2Codec |

|

LZO |

com.hadoop.compression.lzo.LzopCodec |

|

Snappy |

org.apache.hadoop.io.compress.SnappyCodec |

压缩性能的比较:

|

压缩算法 |

原始文件大小 |

压缩文件大小 |

压缩速度 |

解压速度 |

|

gzip |

8.3GB |

1.8GB |

17.5MB/s |

58MB/s |

|

bzip2 |

8.3GB |

1.1GB |

2.4MB/s |

9.5MB/s |

|

LZO |

8.3GB |

2.9GB |

49.3MB/s |

74.6MB/s |

http://google.github.io/snappy/

On a single core of a Core i7 processor in 64-bit mode, Snappy compresses at about 250 MB/sec or more and decompresses at about 500 MB/sec or more.

在64位模式的core i7处理器的单核上,Snappy以大约250 MB/秒或更高的速度压缩,并以大约500 MB/秒或更高的速度解压缩。

压缩参数配置

要在Hadoop中启用压缩,可以配置如下参数(mapred-site.xml文件中):

|

参数 |

默认值 |

阶段 |

建议 |

|

org.apache.hadoop.io.compress.DefaultCodec, org.apache.hadoop.io.compress.GzipCodec, org.apache.hadoop.io.compress.BZip2Codec, |

输入压缩 |

Hadoop使用文件扩展名判断是否支持某种编解码器 |

|

|

mapreduce.map.output.compress |

FALSE |

mapper输出 |

这个参数设为true启用压缩 |

|

mapreduce.map.output.compress.codec |

org.apache.hadoop.io.compress.DefaultCodec |

mapper输出 |

使用LZO、LZ4或snappy编解码器在此阶段压缩数据 |

|

mapreduce.output.fileoutputformat.compress |

FALSE |

reducer输出 |

这个参数设为true启用压缩 |

|

mapreduce.output.fileoutputformat.compress.codec |

org.apache.hadoop.io.compress. DefaultCodec |

reducer输出 |

使用标准工具或者编解码器,如gzip和bzip2 |

|

RECORD |

reducer输出 |

SequenceFile输出使用的压缩类型:NONE和BLOCK |

开启Map输出阶段压缩

开启map输出阶段压缩可以减少job中map和Reduce task间数据传输量。具体配置如下:

(1)开启hive中间传输数据压缩功能

hive (default)>set hive.exec.compress.intermediate=true;

(2)开启mapreduce中map输出压缩功能

hive (default)>set mapreduce.map.output.compress=true;

hive (default)>set mapreduce.map.output.compress.codec=org.apache.hadoop.io.compress.SnappyCodec;

hive (default)> select count(ename) name from emp;

开启Reduce输出阶段压缩

hive (default)>set hive.exec.compress.output=true;

hive (default)>set mapreduce.output.fileoutputformat.compress=true;

hive (default)> set mapreduce.output.fileoutputformat.compress.type=BLOCK;

文件存储格式

Hive支持的存储数据的格式主要有:TEXTFILE 、SEQUENCEFILE、ORC、PARQUET。

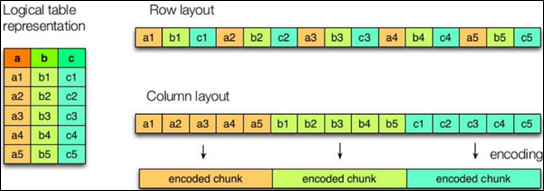

列式存储和行式存储

如图所示左边为逻辑表,右边第一个为行式存储,第二个为列式存储。

查询满足条件的一整行数据的时候,列存储则需要去每个聚集的字段找到对应的每个列的值,行存储只需要找到其中一个值,其余的值都在相邻地方,所以此时行存储查询的速度更快。

因为每个字段的数据聚集存储,在查询只需要少数几个字段的时候,能大大减少读取的数据量;每个字段的数据类型一定是相同的,列式存储可以针对性的设计更好的设计压缩算法。

TEXTFILE和SEQUENCEFILE的存储格式都是基于行存储的;

TextFile格式

默认格式,数据不做压缩,磁盘开销大,数据解析开销大。可结合Gzip、Bzip2使用,但使用Gzip这种方式,hive不会对数据进行切分,从而无法对数据进行并行操作。

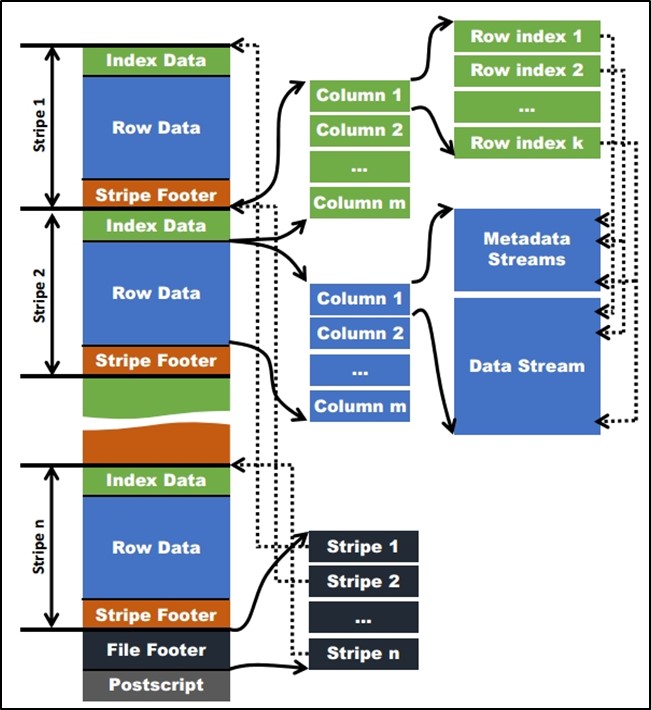

Orc格式

Orc (Optimized Row Columnar)是Hive 0.11版里引入的新的存储格式。

如下图所示可以看到每个Orc文件由1个或多个stripe组成,每个stripe一般为HDFS的块大小,每一个stripe包含多条记录,这些记录按照列进行独立存储,对应到Parquet中的row group的概念。每个Stripe里有三部分组成,分别是Index Data,Row Data,Stripe Footer:

1)Index Data:一个轻量级的index,默认是每隔1W行做一个索引。这里做的索引应该只是记录某行的各字段在Row Data中的offset。

2)Row Data:存的是具体的数据,先取部分行,然后对这些行按列进行存储。对每个列进行了编码,分成多个Stream来存储。

3)Stripe Footer:存的是各个Stream的类型,长度等信息。

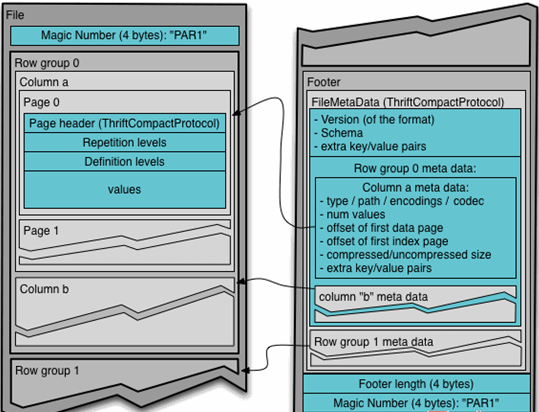

Parquet格式

Parquet文件是以二进制方式存储的,所以是不可以直接读取的,文件中包括该文件的数据和元数据,因此Parquet格式文件是自解析的。

(1)行组(Row Group):每一个行组包含一定的行数,在一个HDFS文件中至少存储一个行组,类似于orc的stripe的概念。

(2)列块(Column Chunk):在一个行组中每一列保存在一个列块中,行组中的所有列连续的存储在这个行组文件中。一个列块中的值都是相同类型的,不同的列块可能使用不同的算法进行压缩。

(3)页(Page):每一个列块划分为多个页,一个页是最小的编码的单位,在同一个列块的不同页可能使用不同的编码方式。

上图展示了一个Parquet文件的内容,一个文件中可以存储多个行组,文件的首位都是该文件的Magic Code,用于校验它是否是一个Parquet文件,Footer length记录了文件元数据的大小,通过该值和文件长度可以计算出元数据的偏移量,文件的元数据中包括每一个行组的元数据信息和该文件存储数据的Schema信息。除了文件中每一个行组的元数据,每一页的开始都会存储该页的元数据,在Parquet中,有三种类型的页:数据页、字典页和索引页。数据页用于存储当前行组中该列的值,字典页存储该列值的编码字典,每一个列块中最多包含一个字典页,索引页用来存储当前行组下该列的索引,目前Parquet中还不支持索引页。

主流文件存储格式对比实验

文件log.data数据内容共两个字段,第一个是id,第二个是数据内容,中间是一tab建分割,数据大小约18.1M,实例数据如下

1 Snappy is a compression/decompression library.

2 It does not aim for maximum compression, or compatibility with any other compression library;

3 instead, it aims for very high speeds and reasonable compression.

row format delimited fields terminated by '\t'

hive (default)> load data local inpath '/opt/module/hive/datas/log.data' into table log_text ;

hive (default)> dfs -du -h /user/hive/warehouse/log_text;

18.13 M /user/hive/warehouse/log_text/log.data

row format delimited fields terminated by '\t'

tblproperties("orc.compress"="NONE"); -- 设置orc存储不使用压缩

hive (default)> insert into table log_orc select * from log_text ;

hive (default)> dfs -du -h /user/hive/warehouse/log_orc/ ;

7.7 M /user/hive/warehouse/log_orc/000000_0

row format delimited fields terminated by '\t'

hive (default)> insert into table log_parquet select * from log_text ;

hive (default)> dfs -du -h /user/hive/warehouse/log_parquet/ ;

13.1 M /user/hive/warehouse/log_parquet/000000_0

No rows affected (10.522 seconds)

No rows affected (11.495 seconds)

No rows affected (11.445 seconds)

存储和压缩结合

测试存储和压缩

官网:https://cwiki.apache.org/confluence/display/Hive/LanguageManual+ORC

ORC存储方式的压缩:

|

Key |

Default |

Notes |

|

orc.compress |

high level compression (one of NONE, ZLIB, SNAPPY) |

|

|

orc.compress.size |

262,144 |

number of bytes in each compression chunk |

|

orc.stripe.size |

268,435,456 |

|

|

orc.row.index.stride |

10,000 |

|

|

orc.create.index |

true |

whether to create row indexes |

|

orc.bloom.filter.columns |

"" |

comma separated list of column names for which bloom filter should be created |

|

orc.bloom.filter.fpp |

0.05 |

false positive probability for bloom filter (must >0.0 and <1.0) |

注意:所有关于ORCFile的参数都是在HQL语句的TBLPROPERTIES字段里面出现

- 创建一个ZLIB压缩的ORC存储方式

(1)建表语句

create table log_orc_zlib(

id string,

line string

)

row format delimited fields terminated by '\t'

stored as orc

tblproperties("orc.compress"="ZLIB");

(2)插入数据

insert into log_orc_zlib select * from log_text;

(3)查看插入后数据

hive (default)> dfs -du -h /user/hive/warehouse/log_orc_zlib/ ;

2.78 M /user/hive/warehouse/log_orc_none/000000_0

- 创建一个SNAPPY压缩的ORC存储方式

(1)建表语句

create table log_orc_snappy(

id string,

line string

)

row format delimited fields terminated by '\t'

stored as orc

tblproperties("orc.compress"="SNAPPY");

(2)插入数据

insert into log_orc_snappy select * from log_text;

(3)查看插入后数据

hive (default)> dfs -du -h /user/hive/warehouse/log_orc_snappy/ ;

3.75 M /user/hive/warehouse/log_orc_snappy/000000_0

ZLIB比Snappy压缩的还小。原因是ZLIB采用的是deflate压缩算法。比snappy压缩的压缩率高。

- 创建一个SNAPPY压缩的parquet存储方式

(1)建表语句

create table log_parquet_snappy(

id string,

line string

)

row format delimited fields terminated by '\t'

stored as parquet

tblproperties("parquet.compression"="SNAPPY");

(2)插入数据

insert into log_parquet_snappy select * from log_text;

(3)查看插入后数据

hive (default)> dfs -du -h /user/hive/warehouse/log_parquet_snappy / ;

6.39 MB /user/hive/warehouse/ log_parquet_snappy /000000_0

存储方式和压缩总结

在实际的项目开发当中,hive表的数据存储格式一般选择:orc或parquet。压缩方式一般选择snappy,lzo。

Hive详解(05) - 压缩和存储的更多相关文章

- Hive详解

1. Hive基本概念 1.1 Hive简介 1.1.1 什么是Hive Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供类SQL查询功能. 1.1 ...

- 大数据入门第十一天——hive详解(一)入门与安装

一.基本概念 1.什么是hive The Apache Hive ™ data warehouse software facilitates reading, writing, and managin ...

- 详解mysql体系结构和存储引擎

概述 之前整理的一些mysql方面内容,适合做备忘,因为我基本不会去记这些概念性的东西,大家做个了解就可以了. 一.定义数据库和实例 1.数据库: 物理操作系统文件或其他形式文件类型的集合. 在MyS ...

- Hadoop之Hive详解

1.什么是Hive hive是基于hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表 并提供类sql查询功能 2.为什么要用Hive 1.直接使用hadoop所面临的问题 人员学 ...

- 008-Hadoop Hive sql语法详解3-DML 操作:元数据存储

一.概述 hive不支持用insert语句一条一条的进行插入操作,也不支持update操作.数据是以load的方式加载到建立好的表中.数据一旦导入就不可以修改. DML包括:INSERT插入.UPDA ...

- 大数据入门第十一天——hive详解(二)基本操作与分区分桶

一.基本操作 1.DDL 官网的DDL语法教程:点击查看 建表语句 CREATE [EXTERNAL] TABLE [IF NOT EXISTS] table_name [(col_name data ...

- Spark 性能相关参数配置详解-压缩与序列化篇

随着Spark的逐渐成熟完善, 越来越多的可配置参数被添加到Spark中来, 本文试图通过阐述这其中部分参数的工作原理和配置思路, 和大家一起探讨一下如何根据实际场合对Spark进行配置优化. 由于篇 ...

- Android内存解析(二)— 详解内存,内部存储和外部存储

总述 觉得十分有必要搞清楚内存,内部存储和外部存储的区别,还有我们在开发中真正将数据存在了手机的哪儿. 先提一个问题:手机设置的应用管理中,每个App下都有清除数据和清除缓存,清除的分别是哪里的数据? ...

- linux之文件查找find grep详解,以及压缩归档

.find linux里的实时查找工具,通过制定路径完成文件查找. find[options]...[查找路径] [查找条件] [处理动作] 查找路径:查找的位置,默认是当前文件夹. 查找条件:指定查 ...

- 一起学Hive——详解四种导入数据的方式

在使用Hive的过程中,导入数据是必不可少的步骤,不同的数据导入方式效率也不一样,本文总结Hive四种不同的数据导入方式: 从本地文件系统导入数据 从HDFS中导入数据 从其他的Hive表中导入数据 ...

随机推荐

- Oracle注入

Oracle 查询出所有的表 select * from all_tables 查询出当前用户的表 select * from user_tables 查询出所有的字段 select*from all ...

- 代码块及final关键字的使用

1.代码块的作用:用来初始化类.对象 2.代码块如果有修饰的话,只能使用static. 3.分类:静态代码块 vs 非静态代码块 4.静态代码块 内部可以有输出语句 随着类的加载而执行,而且只执行一次 ...

- MySQL 全局锁、表级锁、行级锁,你搞清楚了吗?

大家好,我是小林. 最近重新补充了<MySQL 有哪些锁>文章内容: 增加记录锁.间隙锁.net-key 锁 增加插入意向锁 增加自增锁为 innodb_autoinc_lock_mode ...

- 如何用webgl(three.js)搭建一个3D库房,3D仓库,3D码头,3D集装箱可视化孪生系统——第十五课

序 又是快两个月没写随笔了,长时间不总结项目,不锻炼文笔,一开篇,多少都会有些生疏,不知道如何开篇,如何写下去.有点江郎才尽,黔驴技穷的感觉. 写随笔,通常三步走,第一步,搭建框架,先把你要写的内容框 ...

- 每日算法3:随机生成五个不同整数,将数字转换为RMB格式

随机生成五个不同整数 点击查看代码 /* 题目解析: 1.采用Math对象的random()方法, 2.将每次生成的数跟之前的数判断相等则此次生成无效i-- */ function randomNum ...

- 笔记:Debian下为sublime text建立软链接[像vi一样到处使用]

先查询sublime-text安装路径 :~$ dpkg -L sublime-text /. /opt /opt/sublime_text ... /opt/sublime_text/sublime ...

- Day16异常1

package com.exception.demo01;public class demo01 { public static void main(String[] args) { try{new ...

- Nginx负载均衡策略的介绍与调优

工作中经常会用到nginx负载均衡这一块,下面对nginx负载均衡策略做个总结.本人在工作中最常用到的负载均衡策略是轮询策略. 在一般情况下,Web中间件最大的作用就是负责对请求进行分发,也就是我们常 ...

- Windows版CheatSheet——一键显示当前程序快捷键列表

Windows系统上的各种软件有太多的快捷键,想要记住是几乎不可能的,推荐一个一键显示当前软件快捷键的软件,在使用其他程序的时候,只要按下Ctrl+`就可以理解弹出该软件的所有快捷键列表,还支持收藏功 ...

- C#使用MathNet库来对进行曲线拟合

下面是用来求取一条直线和一条拟合曲线交点的代码 /// <summary> /// 拟合曲线所筛选的点的个数 /// </summary> const int CurveNum ...