模拟登陆并爬取Github

因为崔前辈给出的代码运行有误,略作修改和简化了。

书上例题,不做介绍。

import requests

from lxml import etree class Login(object):

def __init__(self):

self.headers = {

'Referer': 'https://github.com/',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/57.0.2987.133 Safari/537.36',

'Host': 'github.com'

}

#登陆地址

self.login_url = 'https://github.com/login'

#POST请求地址

self.post_url = 'https://github.com/session'

#使用session保持状态,并自动处理Cookies(在访问其他子网页时,可以保持登陆,爬取网页)

self.session = requests.Session() def token(self):

#获取网页数据

response = self.session.get(self.login_url, headers=self.headers)

#提取网页中我们需要的authenticity_token并返回

selector = etree.HTML(response.text)

token = selector.xpath('//input[@name="authenticity_token"]/@value')

return token def login(self, email, password):

post_data = {

'commit': 'Sign in',

'utf8': '✓',

'authenticity_token': self.token(),

'login': email,

'password': password

}

#使用post方法模拟登陆

response = self.session.post(self.post_url, data=post_data, headers=self.headers)

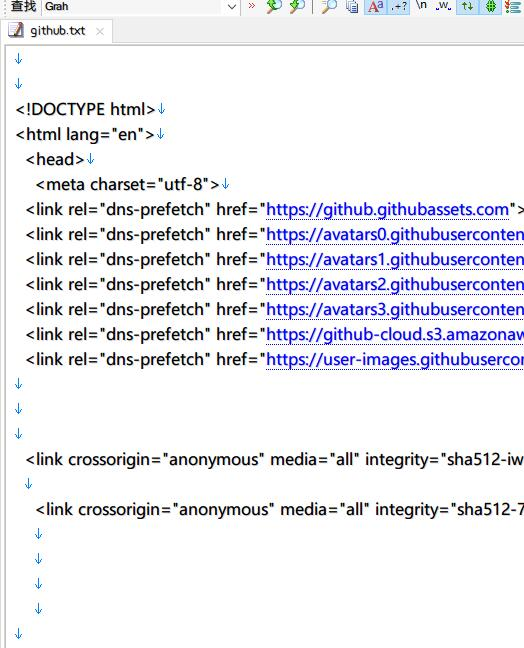

#登陆正常,输出登陆后的网页代码,并将它存储带D盘github.txt

if response.status_code == 200:

print(response.text)

with open('D:/github.txt', 'w', encoding = 'utf-8') as f:

f.write(response.text)

else:

print("Error!!!") if __name__ == "__main__":

login = Login()

login.login(email='1024593536@qq.com', password='password')#输入你自己的账户密码

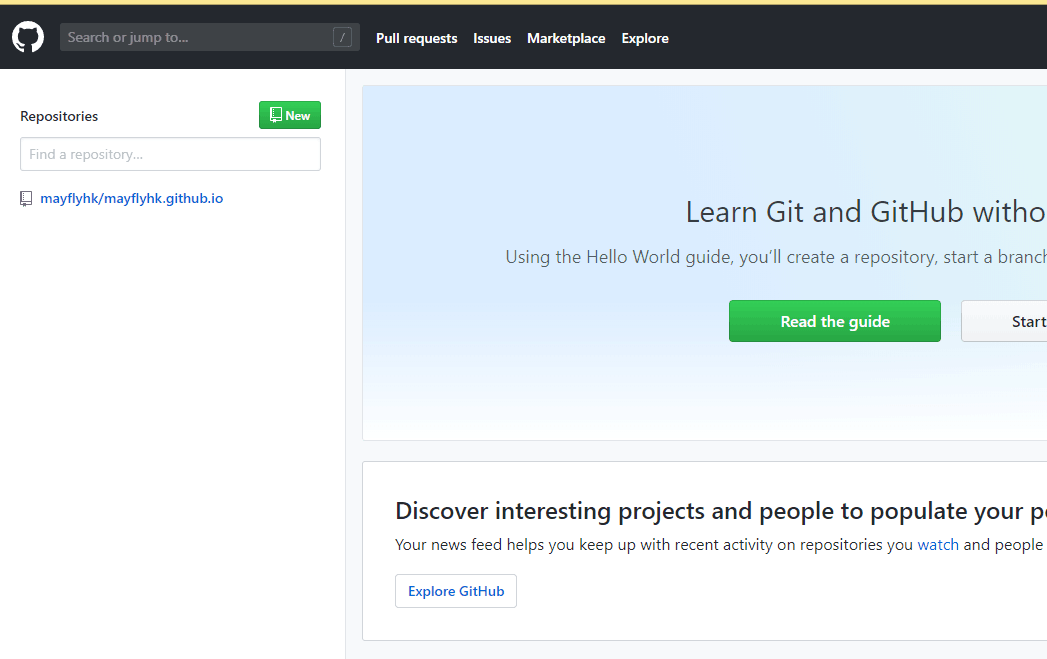

可以改成网页形式查看

模拟登陆并爬取Github的更多相关文章

- 模拟登陆+数据爬取 (python+selenuim)

以下代码是用来爬取LinkedIn网站一些学者的经历的,仅供参考,注意:不要一次性大量爬取会被封号,不要问我为什么知道 #-*- coding:utf-8 -*- from selenium impo ...

- Python爬虫学习笔记之模拟登陆并爬去GitHub

(1)环境准备: 请确保已经安装了requests和lxml库 (2)分析登陆过程: 首先要分析登陆的过程,需要探究后台的登陆请求是怎样发送的,登陆之后又有怎样的处理过程. 如果已经 ...

- 爬取github项目。

import requests from bs4 import BeautifulSoup url = 'https://github.com/login' headers = { 'User-Age ...

- 【转】详解抓取网站,模拟登陆,抓取动态网页的原理和实现(Python,C#等)

转自:http://www.crifan.com/files/doc/docbook/web_scrape_emulate_login/release/html/web_scrape_emulate_ ...

- 通过scrapy,从模拟登录开始爬取知乎的问答数据

这篇文章将讲解如何爬取知乎上面的问答数据. 首先,我们需要知道,想要爬取知乎上面的数据,第一步肯定是登录,所以我们先介绍一下模拟登录: 先说一下我的思路: 1.首先我们需要控制登录的入口,重写star ...

- 运用cookie登陆人人网爬取数据

浏览器访问WEB服务器的过程 在用户访问网页时,不论是通过URL输入域名或IP,还是点击链接,浏览器向WEB服务器发出了一个HTTP请求(Http Request),WEB服务器接收到客户端浏览器的请 ...

- Scrapy模拟登陆豆瓣抓取数据

scrapy startproject douban 其中douban是我们的项目名称 2创建爬虫文件 进入到douban 然后创建爬虫文件 scrapy genspider dou douban. ...

- python爬取github数据

爬虫流程 在上周写完用scrapy爬去知乎用户信息的爬虫之后,github上star个数一下就在公司小组内部排的上名次了,我还信誓旦旦的跟上级吹牛皮说如果再写一个,都不好意思和你再提star了,怕你们 ...

- 新浪微博模拟登陆+数据抓取(java实现)

模拟登陆部分实现: package token.exe; import java.math.BigInteger; import java.util.Random; import org.apache ...

随机推荐

- 《Linux内核设计与实现》读书笔记(七)- 中断处理

中断处理一般不是纯软件来实现的,需要硬件的支持.通过对中断的学习有助于更深入的了解系统的一些底层原理,特别是驱动程序的开发. 主要内容: 什么是中断 中断类型 中断相关函数 中断处理机制 中断控制方法 ...

- C#泛型理解(一)

一.什么是泛型 泛型是C#语言和公共语言运行库(CLR)中的一个新功能,它将类型参数的概念引入.NET Framework.类型参数使得设计某些类和方法成为可能,例如,通过使用泛型类型参数T,可以大大 ...

- bat 操作数据库(附加,分离,删除,还原)

BAT代码: @echo off Title DataBase Color 0A :caozuo echo. echo ═══════════════════════════════════════ ...

- 十天入门java教程 Day02

1,常量,变量的理解 常量,程序运行过程中,不能改变的,叫常量. 变量,程序运行过程中,改变的,叫变量. 2,变量的理解 变量,用来存储数据的,数据类型,存放哪种数据的种类. 变量的概念:程序运行期间 ...

- Android emulator中C代码的调试——gdb/gdbservers时遇到的坑

版权声明:本文为博主原创文章,未经博主允许不得转载. 先写个helloworld吧,在Android源码树中创建文件夹external/helloworld,加入文件: // helloworld.c ...

- Object detection with deep learning and OpenCV

目录 Single Shot Detectors for Object Detection Deep learning-based object detection with OpenCV 这篇文 ...

- 【bzoj2190】: [SDOI2008]仪仗队 数论-欧拉函数

[bzoj2190]: [SDOI2008]仪仗队 在第i行当且仅当gcd(i,j)=1 可以被看到 欧拉函数求和 没了 /* http://www.cnblogs.com/karl07/ */ #i ...

- Liunx配置静态IP

刚开始Linux默认的是动态获取,而我们需要设置静态IP(我是为了xshell的连接) 1. 执行dhclient命令自动获取到一个IP,NETMASK, 2. 执行route命令,获取defau ...

- P2542 [AHOI2005]航线规划 LCT维护双连通分量

\(\color{#0066ff}{ 题目描述 }\) 对Samuel星球的探险已经取得了非常巨大的成就,于是科学家们将目光投向了Samuel星球所在的星系--一个巨大的由千百万星球构成的Samuel ...

- centos下yum搭建安装linux+apache+mysql+php环境教程

我们利用linux系统中yum安装Apache+MySQL+PHP是非常的简单哦,只需要几步就可以完成,具体如下: 一.脚本YUM源安装: 1.yum install wget ...