机器学习 - 算法 - 集成算法 - 分类 ( Bagging , Boosting , Stacking) 原理概述

Ensemble learning - 集成算法

▒ 目的

让机器学习的效果更好, 量变引起质变

继承算法是竞赛与论文的神器, 注重结果的时候较为适用

集成算法 - 分类

▒ Bagging - bootstrap aggregation

◈ 公式

◈ 原理

训练多个分类器取平均, 并行 的训练一堆的分类器

◈ 典例

随机森林

◈ 随机

输入 - 数据源采样随机 - 在原有数据上的进行 60% - 80% 比例的有放回的数据取样

数据量相同, 但是每个树的样本数据各不相同

特征 - 特征选择随机

特征的选择加剧随机性

◈ 森林

多个决策树并行放在一起

每个树的特征数一样, 数据量一样

由于二重的随机性(数据集, 特征) , 每个树基本上都不会一样, 最终的结果也不一样

随机保证了泛化能力, 如果每个树都是一样, 那就无意义了

◈ 优势

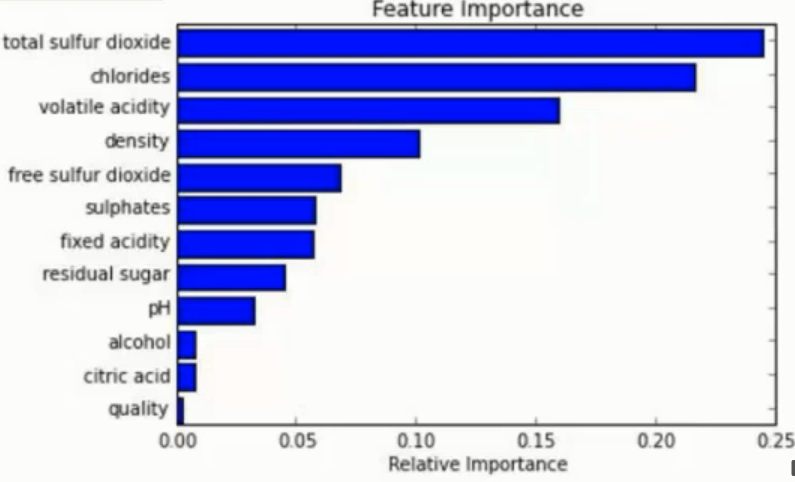

能够处理 高纬度 ( feature 很多 ) 的数据, 而且不用做特征选择 (见ps)

在训练后, 可以对 feature 重要程度 进行比对

容易做成 并行化 方法, 速度较快

可进行 可视化展示 , 便于分析

◈ ps

特征选择

特征选择的目的是为了查找出权重较大对最终结果影响较大的特征

比如可以使用将某一特征的数据进行完全破坏再用无用数据填充

然后与之前的正常特征数据得到的结果比对从而两个的差值大小判断此特征的有用性

也可以建模忽略预测定的某特征进行与带有此特征的进行比对也是相同的道理

注意 : 破坏后的特征别用 0 之类的一样的数据进行填充, 完全一样的特征就没意义了

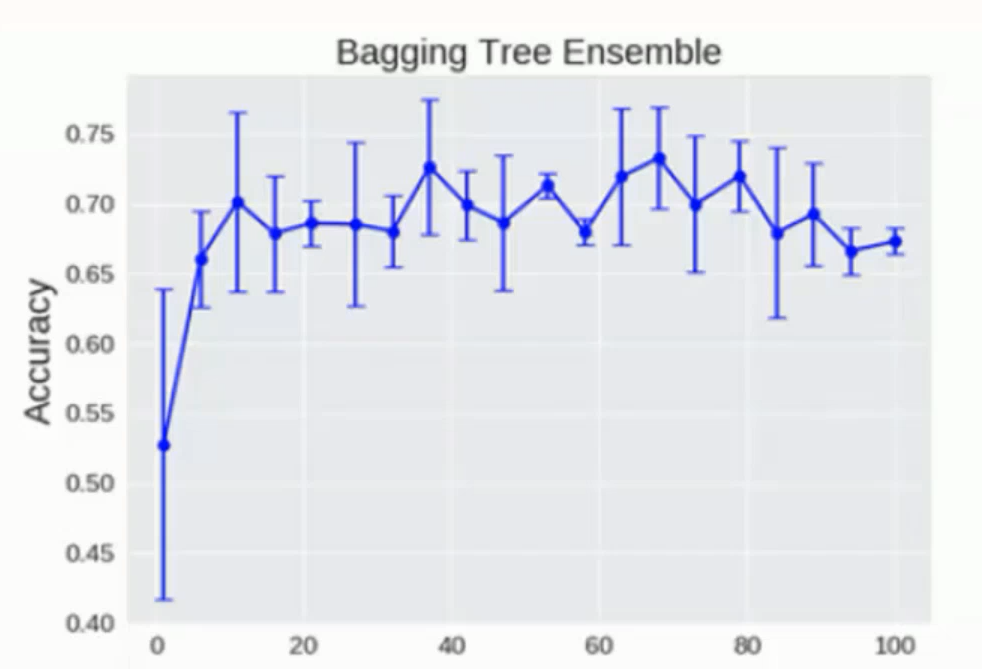

◈ 树模型临界值

随机森林中的树模型理论上是越多越好, 但是其实也会达到临界值

达到一定数量后就会在临界点附近上下浮动

▒ Boosting

◈ 公式

◈ 原理

串行算法, 后面的树基于前面树的残差计算

从弱学习器开始加强, 通过加权来进行训练 ( 加入一颗比原来强的树 )

例子说明:

比如第一颗树预测的结果相差了50, 那么第二颗的任务就是预测这50

然后第二颗预测结果是 30 , 与目标又只差了20, 于是第三颗树的任务就是预测剩余的 20

以此往下类推, 直到尽可能的填满这50的差值让预测结果和真实结果统一

◈ 典例

AdaBoost

Xgboost - 详细的内容 点击这里

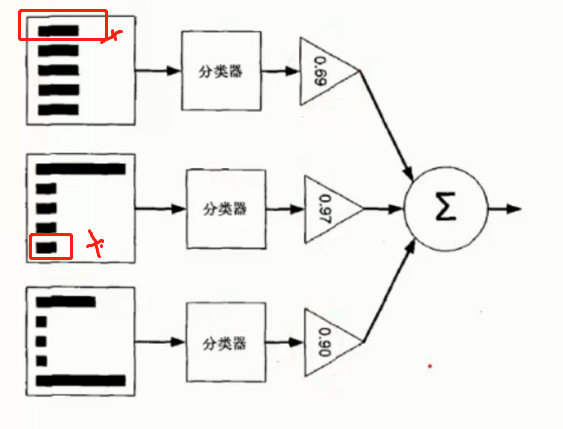

◈ AdaBoost 原理

根据前一次的分类效果调整数据权重

如果某一个数据分错了, 那么在下一次的分配中会给与更高的权重使其更加精准

最终的结果根据每个分类器自身的准确性确定各自的权重再合并

如图所示, 第一个分类器分错了 第一个数据, 因此第二分类器给了第一个数据更高的权重

但是二号又分错了第五个数据, 因此第三个分类器对第五数据更高的权重

▒ Stacking

聚合多个分类或者回归模型. ( 可以分阶段来做 )

◈ 原理

堆叠 直接一堆分类器叠加起来用, 比如有多个算法直接算完了求平均

可以堆叠各种各样的分类器 (KNN, SVM, RF 等等)

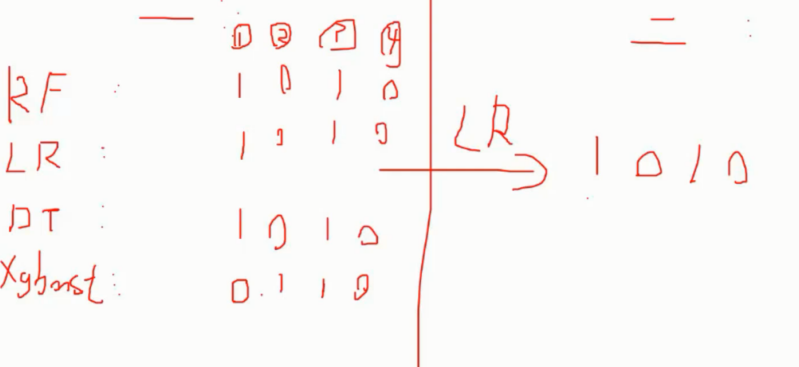

分阶段 第一阶段得出各自结果, 第二阶段再用前一阶段的结果来训练

如图, 使用 4 种分类器的结果作为二阶段 LR 分类器的输入再次处理后得到最终结果

◈ 优势

准确率确实可以提升, 但是速度是个问题

机器学习 - 算法 - 集成算法 - 分类 ( Bagging , Boosting , Stacking) 原理概述的更多相关文章

- 机器学习之——集成算法,随机森林,Bootsing,Adaboost,Staking,GBDT,XGboost

集成学习 集成算法 随机森林(前身是bagging或者随机抽样)(并行算法) 提升算法(Boosting算法) GBDT(迭代决策树) (串行算法) Adaboost (串行算法) Stacking ...

- 机器学习:集成学习(Ada Boosting 和 Gradient Boosting)

一.集成学习的思路 共 3 种思路: Bagging:独立的集成多个模型,每个模型有一定的差异,最终综合有差异的模型的结果,获得学习的最终的结果: Boosting(增强集成学习):集成多个模型,每个 ...

- 【机器学习】Jackknife,Bootstraping, bagging, boosting, AdaBoosting, Rand forest 和 gradient boosting

Jackknife,Bootstraping, bagging, boosting, AdaBoosting, Rand forest 和 gradient boosting 这些术语,我经常搞混淆, ...

- 机器学习入门-集成算法(bagging, boosting, stacking)

目的:为了让训练效果更好 bagging:是一种并行的算法,训练多个分类器,取最终结果的平均值 f(x) = 1/M∑fm(x) boosting: 是一种串行的算法,根据前一次的结果,进行加权来提高 ...

- 机器学习:集成学习(Bagging、Pasting)

一.集成学习算法的问题 可参考:模型集成(Enxemble) 博主:独孤呆博 思路:集成多个算法,让不同的算法对同一组数据进行分析,得到结果,最终投票决定各个算法公认的最好的结果: 弊端:虽然有很多机 ...

- 一小部分机器学习算法小结: 优化算法、逻辑回归、支持向量机、决策树、集成算法、Word2Vec等

优化算法 先导知识:泰勒公式 \[ f(x)=\sum_{n=0}^{\infty}\frac{f^{(n)}(x_0)}{n!}(x-x_0)^n \] 一阶泰勒展开: \[ f(x)\approx ...

- 【Supervised Learning】 集成学习Ensemble Learning & Boosting 算法(python实现)

零. Introduction 1.learn over a subset of data choose the subset uniformally randomly (均匀随机地选择子集) app ...

- 机器学习之KNN算法(分类)

KNN算法是解决分类问题的最简单的算法.同时也是最常用的算法.KNN算法也可以称作k近邻算法,是指K个最近的数据集,属于监督学习算法. 开发流程: 1.加载数据,加载成特征矩阵X与目标向量Y. 2.给 ...

- 集成算法——Ensemble learning

目的:让机器学习效果更好,单个不行,群殴啊! Bagging:训练多个分类器取平均 Boosting:从弱学习器开始加强,通过加权来进行训练 (加入一棵树,比原来要强) Stacking:聚合多个分类 ...

随机推荐

- 第四章、前端之BOM和DOM

目录 第四章.前端之BOM和DOM 一.解释BOM和DOM 二.window对象 三.window子对象 四.弹出框 五.计时相关 六.HTML的DOM树 七.查找元素 八.节点操作 九.JS操作CS ...

- Python入门之第三方模块安装

Python入门之第三方模块安装 平台:Win10 x64 + Anaconda3-5.3.0 (+Python3.7.0) Issue说明:pip install line_profiler-2.1 ...

- 多线程模块的同步机制event对象

多线程模块的同步机制event对象 线程的核心特征就是他们能够以非确定的方式(即何时开始执行,何时被打断,何时恢复完全由操作系统来调度管理,这是用户和程序员无法确定的)独立执行的,如果程序中有其他线程 ...

- TensorFlow指定GPU/CPU进行训练和输出devices信息

TensorFlow指定GPU/CPU进行训练和输出devices信息 1.在tensorflow代码中指定GPU/CPU进行训练 with tf.device('/gpu:0'): .... wit ...

- java线程基础巩固---创建并启动线程

对于java的并发编程方面的东东,不管是面试还是实际工作开发都是非常重要的,而往往只要涉及到并发相关的东东有点让人觉得有点难,而实际工作中涉及到并发可能就是简单的用下同步块.上锁之类的一些简单的操作, ...

- 04—mybatis的关联映射

mybatis的关联映射一对一一对多多对多 一.一对一(一个人只能有一个身份证号) 1.创建表创建表tb_card CREATE TABLE `tb_card` ( `id` int(11) NOT ...

- vue-cli3构建多页面应用

创建一个项目hello-world vue create hello-worldcd hello-worldnpm run serve 在src目录下新建pages目录,在pages下新建页面 App ...

- vue-element-admin登录逻辑,以及动态添加路由,显示侧边栏

这段时间在研究element-admin,感觉这个库有许多值得学习的地方,我学习这个库的方法是,先看它的路由,顺着路由,摸清它的逻辑,有点像顺藤摸瓜. 这个库分的模块非常清晰,适合多人合作开发项目,但 ...

- 用javascript来判别回文数

什么是回文数?通俗的说就是正着读和倒着读都一样的字符串(即使是数字也是可以看成字符串的). 所以下面回文数都是用字符串来表示的,即判断回文数就是对字符串的判断. 举几个回文数的例子: i love u ...

- IP地址正则表达式的写法

IP地址的正则表达式写法 这里讲的是IPv4的地址格式,总长度 32位=4段*8位,每段之间用.分割, 每段都是0-255之间的十进制数值. 将0-255用正则表达式表示,可以分成一下几块来分别考虑: ...