C# 关于爬取网站数据遇到csrf-token的分析与解决

需求

某航空公司物流单信息查询,是一个post请求。通过后台模拟POST HTTP请求发现无法获取页面数据,通过查看航空公司网站后,发现网站使用避免CSRF攻击机制,直接发挥40X错误。

关于CSRF

读者自行百度

网站HTTP请求分析

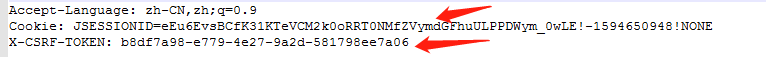

Headers

Form Data

在head里包含了cookie 与 x-csrf-token formdata 里包含了_csrf (与head里的值是一样的).

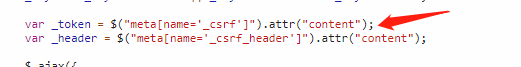

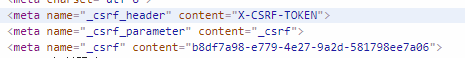

这里通过查看该网站的JS源代码发现_csrf 来自于网页的head标签里

猜测cookie与 x-csrf-token是有一定的有效期,并且他们共同作用来防御CSRF攻击。

解决方案

1,首先请求一下该航空公司的网站,获取cookie与_csrf

2,然后C# 模拟http分别在head和formdata里加入如上参数,发起请求

代码

public class CSRFToken

{

string cookie;//用于请求的站点的cookie

List<string> csrfs;//用于请求站点的token的key 以及 value public CSRFToken(string url)

{

//校验传输安全

if (!string.IsNullOrWhiteSpace(url))

{

try

{

//设置请求的头信息.获取url的host

var _http = new HttpHelper(url);

string cookie;

string html = _http.CreateGetHttpResponseForPC(out cookie);

this.cookie = cookie; string headRegex = @"<meta name=""_csrf.*"" content="".*""/>"; MatchCollection matches = Regex.Matches(html, headRegex);

Regex re = new Regex("(?<=content=\").*?(?=\")", RegexOptions.None);

csrfs = new List<string>();

foreach (Match math in matches)

{ MatchCollection mc = re.Matches(math.Value);

foreach (Match ma in mc)

{

csrfs.Add(ma.Value);

}

} }

catch (Exception e)

{ }

}

} public String getCookie()

{

return cookie;

}

public void setCookie(String cookie)

{

this.cookie = cookie;

}

public List<string> getCsrf_token()

{

return csrfs;

}

}

httpHelper

public string CreatePostHttpResponse(IDictionary<string, string> headers, IDictionary<string, string> parameters)

{

HttpWebRequest request = null;

//HTTPSQ请求

UTF8Encoding encoding = new System.Text.UTF8Encoding();

ServicePointManager.ServerCertificateValidationCallback = new RemoteCertificateValidationCallback(CheckValidationResult);

request = WebRequest.Create(_baseIPAddress) as HttpWebRequest;

request.ProtocolVersion = HttpVersion.Version10;

ServicePointManager.SecurityProtocol = SecurityProtocolType.Tls12 | SecurityProtocolType.Tls11;

request.Method = "POST";

request.ContentType = "application/x-www-form-urlencoded";

// request.ContentType = "application/json";

request.UserAgent = DefaultUserAgent;

//request.Headers.Add("X-CSRF-TOKEN", "bc0cc533-60cc-484a-952d-0b4c1a95672c");

//request.Referer = "https://www.asianacargo.com/tracking/viewTraceAirWaybill.do"; //request.Headers.Add("Origin", "https://www.asianacargo.com");

//request.Headers.Add("Cookie", "JSESSIONID=HP21d2Dq5FoSlG4Fyw4slWwHb0-Sl1CG6jGtj7HE41e5f4aN_R1p!-435435446!117330181");

//request.Host = "www.asianacargo.com"; if (!(headers == null || headers.Count == ))

{ foreach (string key in headers.Keys)

{

request.Headers.Add(key, headers[key]);

} } //如果需要POST数据

if (!(parameters == null || parameters.Count == ))

{

StringBuilder buffer = new StringBuilder();

int i = ;

foreach (string key in parameters.Keys)

{

if (i > )

{

buffer.AppendFormat("&{0}={1}", key, parameters[key]);

}

else

{

buffer.AppendFormat("{0}={1}", key, parameters[key]);

}

i++;

}

byte[] data = encoding.GetBytes(buffer.ToString());

using (Stream stream = request.GetRequestStream())

{

stream.Write(data, , data.Length);

}

} HttpWebResponse response; try

{

//获得响应流

response = (HttpWebResponse)request.GetResponse();

Stream s = response.GetResponseStream(); StreamReader readStream = new StreamReader(s, Encoding.UTF8);

string SourceCode = readStream.ReadToEnd();

response.Close();

readStream.Close();

return SourceCode;

}

catch (WebException ex)

{

response = ex.Response as HttpWebResponse; return null;

} } public string CreateGetHttpResponse(out string cookie)

{

HttpWebRequest request = null;

//HTTPSQ请求

UTF8Encoding encoding = new System.Text.UTF8Encoding();

ServicePointManager.ServerCertificateValidationCallback = new RemoteCertificateValidationCallback(CheckValidationResult);

request = WebRequest.Create(_baseIPAddress) as HttpWebRequest;

request.ProtocolVersion = HttpVersion.Version10;

ServicePointManager.SecurityProtocol = SecurityProtocolType.Tls12 | SecurityProtocolType.Tls11;

request.Method = "GET";

request.ContentType = "application/x-www-form-urlencoded";

request.UserAgent = DefaultUserAgent; HttpWebResponse response; try

{

//获得响应流

response = (HttpWebResponse)request.GetResponse(); cookie = response.Headers["Set-Cookie"];

Stream s = response.GetResponseStream(); StreamReader readStream = new StreamReader(s, Encoding.UTF8);

string SourceCode = readStream.ReadToEnd();

response.Close();

readStream.Close();

return SourceCode;

}

catch (WebException ex)

{

response = ex.Response as HttpWebResponse;

cookie = "";

return null;

} }

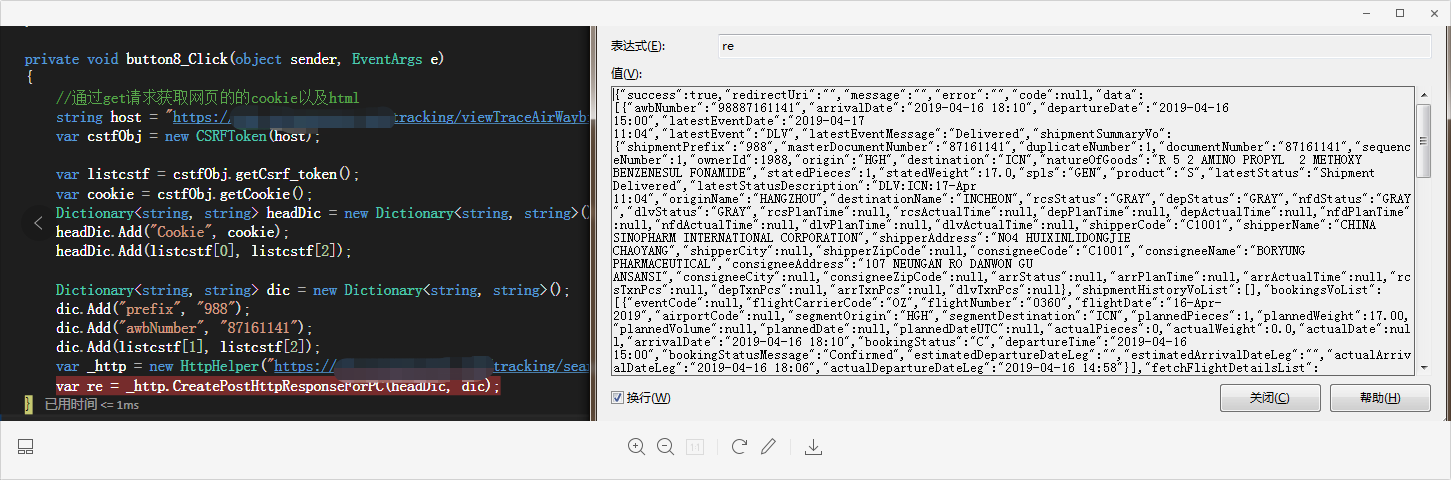

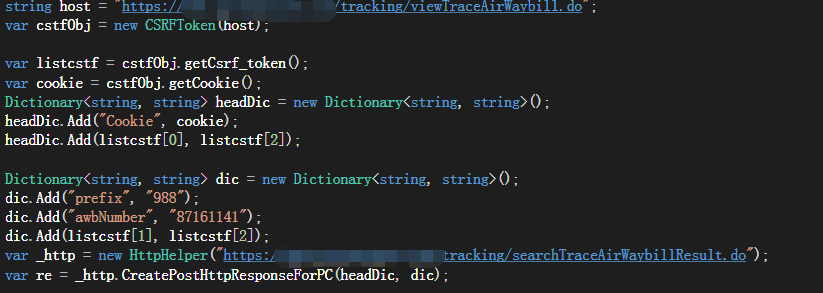

爬取程序

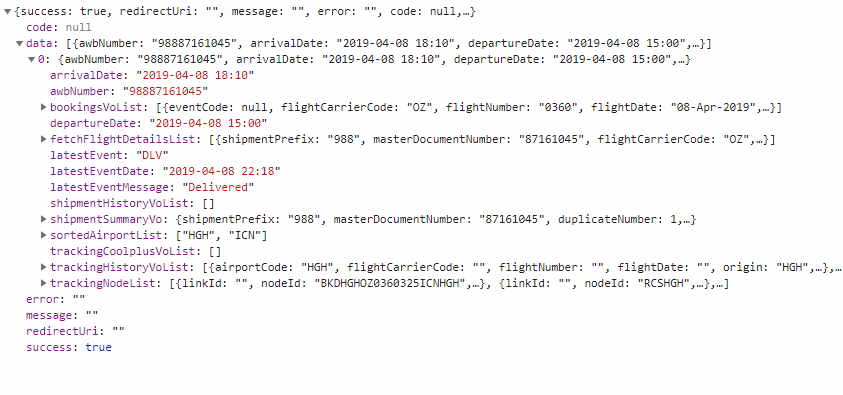

爬取结果

浏览器结果

注意事项与结论

1,不同的网站,获取cstf的方式不一样,无论怎么做,只要信息传到前台我们都可以有相应的方法来获取。

2,请求时候的http验证可能不一样,测试的某航空公司物流信息的时候,http请求的安全协议是tis12。

ServicePointManager.SecurityProtocol = SecurityProtocolType.Tls12 | SecurityProtocolType.Tls11; 还有其他参数比如UserAgent后台可能也会验证

3,基于如上航空公司,发现它的cookie和cstf_token一定时间内不会改变,那么当实际爬取的时候可以考虑缓存cookie以及cstf_token,只有当请求失败的时候,才重新获取

C# 关于爬取网站数据遇到csrf-token的分析与解决的更多相关文章

- 利用linux curl爬取网站数据

看到一个看球网站的以下截图红色框数据,想爬取下来,通常爬取网站数据一般都会从java或者python爬取,但本人这两个都不会,只会shell脚本,于是硬着头皮试一下用shell爬取,方法很笨重,但旨在 ...

- python爬取网站数据

开学前接了一个任务,内容是从网上爬取特定属性的数据.正好之前学了python,练练手. 编码问题 因为涉及到中文,所以必然地涉及到了编码的问题,这一次借这个机会算是彻底搞清楚了. 问题要从文字的编码讲 ...

- 利用phpspider爬取网站数据

本文实例原址:PHPspider爬虫10分钟快速教程 在我们的工作中可能会涉及到要到其它网站去进行数据爬取的情况,我们这里使用phpspider这个插件来进行功能实现. 1.首先,我们需要php环境, ...

- python爬取网站数据保存使用的方法

这篇文章主要介绍了使用Python从网上爬取特定属性数据保存的方法,其中解决了编码问题和如何使用正则匹配数据的方法,详情看下文 编码问题因为涉及到中文,所以必然地涉及到了编码的问题,这一次借这 ...

- 手把手教你用Node.js爬虫爬取网站数据

个人网站 https://iiter.cn 程序员导航站 开业啦,欢迎各位观众姥爷赏脸参观,如有意见或建议希望能够不吝赐教! 开始之前请先确保自己安装了Node.js环境,还没有安装的的童鞋请自行百度 ...

- 3.15学习总结(Python爬取网站数据并存入数据库)

在官网上下载了Python和PyCharm,并在网上简单的学习了爬虫的相关知识. 结对开发的第一阶段要求: 网上爬取最新疫情数据,并存入到MySql数据库中 在可视化显示数据详细信息 项目代码: im ...

- Node爬取网站数据

npm安装cheerio和axios npm isntall cheerio npm install axios 利用cheerio抓取对应网站中的标签根据链接使用axios获取对应页面数据 cons ...

- 使用node.js如何爬取网站数据

数据库又不会弄,只能扒扒别人的数据了. 搭建环境: (1).创建一个文件夹,进入并初始化一个package.json文件. npm init -y (2).安装相关依赖: npm install ...

- Python 爬取网站数据

一.使用request库实现批量下载HTML 二.使用BeautifulSoup库实现html解析 官网:https://beautifulsoup.readthedocs.io/zh_CN/v4.4 ...

随机推荐

- Oracle的大表,小表与全表扫描

大小表区分按照数据量的大小区分: 通常对于小表,Oracle建议通过全表扫描进行数据访问,对于大表则应该通过索引以加快数据查询,当然如果查询要求返回表中大部分或者全部数据,那么全表扫描可能仍然是最好的 ...

- Linux工程管理器——make

一.定义 工程管理器,顾名思义,是指管理较多的文件 Make工程管理器也就是个“自动编译管理器”,这里的“自动”是指它能构根据文件时间戳自动发现更新过的文件而减少编译的工作量,同时,它通过读入Make ...

- 临界区代码 critical section Locks and critical sections in multiple threads

临界区 在同步的程序设计中,临界区段(Critical section)指的是一个访问共享资源(例如:共享设备或是共享存储器)的程序片段,而这些共享资源有无法同时被多个线程访问的特性. 当有线程进入临 ...

- 技术干货丨如何在VIPKID中构建MQ服务

小结: 1. https://mp.weixin.qq.com/s/FQ-DKvQZSP061kqG_qeRjA 文 |李伟 VIPKID数据中间件架构师 交流微信 | datapipeline201 ...

- 0.9.0.RELEASE版本的spring cloud alibaba nacos实例

简而言之,nacos与eureka的不同之处有三:后台老板.部署方式.功能.nacos是阿里的,eureka是奈飞的:nacos有自己的安装包,需要独立部署,eureka仅作为一个服务组件,引入jar ...

- python学习:python的常用功能示例2

1. python 写入txt with open("douban.txt","w") as f: f.write("这是个测试!") fi ...

- 将Python的Django框架与认证系统整合的方法

将Python的Django框架与认证系统整合的方法 这篇文章主要介绍了将Python的Django框架与认证系统整合的方法,包括指定认证后台和编写认证后台等内容,需要的朋友可以参考下 将Django ...

- Delphi ADOQuery的速度优化

今天终于把纠缠了几天的问题改完了,说到底只是一个很小的问题,就是ADOQuery的一个小属性. 把控件DBGridEh的一列的checkbox设为true,将其绑定DataSource和ADOQuer ...

- rhel7免密登录问题

以前在做linux免密登录时只要执行:cat id_rsa.pub>> authorized_keys,就可以了 后来升级到rhel7之后不行,发现有两个需要改动: 1.修改ssh的配置文 ...

- docker(学习笔记)

# 1. Docker介绍## 1.1 什么是容器?## 1.2 容器的前世今生FreeBASE jail ------> Linux vserverchroot ----> 完整的根文件 ...