OpenStack学习系列之十二:安装ceph并对接OpenStack

1.安装ceph(版本:nautilus)

# 在node1、node2、node3上安装ceph并组成集群

yum -y install ceph监视器monitor(node1上操作)

[root@node1 ~]# cat /etc/ceph/ceph.conf

[global]

fsid = a7f64266-0894-4f1e-a635-d0aeaca0e993

mon initial members = node1

mon host = 192.168.31.101

public_network = 192.168.31.0/24

cluster_network = 172.16.100.0/24ceph-authtool --create-keyring /tmp/ceph.mon.keyring --gen-key -n mon. --cap mon 'allow *'sudo ceph-authtool --create-keyring /etc/ceph/ceph.client.admin.keyring \

--gen-key -n client.admin \

--cap mon 'allow *' --cap osd 'allow *' --cap mds 'allow *' --cap mgr 'allow *'生成bootstrap-osd秘钥,生成client.bootstrap-osd用户并将该用户添加到秘钥

sudo ceph-authtool --create-keyring /var/lib/ceph/bootstrap-osd/ceph.keyring \

--gen-key -n client.bootstrap-osd \

--cap mon 'profile bootstrap-osd' --cap mgr 'allow r'sudo ceph-authtool /tmp/ceph.mon.keyring --import-keyring /etc/ceph/ceph.client.admin.keyring

sudo ceph-authtool /tmp/ceph.mon.keyring --import-keyring /var/lib/ceph/bootstrap-osd/ceph.keyring

sudo chown ceph:ceph /tmp/ceph.mon.keyringmonmaptool --create --add node1 192.168.31.101 --fsid a7f64266-0894-4f1e-a635-d0aeaca0e993 /tmp/monmapsudo -u ceph mkdir /var/lib/ceph/mon/ceph-node1使用监视器映射和秘钥填充监视器守护程序

sudo -u ceph ceph-mon --mkfs -i node1 --monmap /tmp/monmap --keyring /tmp/ceph.mon.keyring启动监视器

sudo systemctl start ceph-mon@node1

sudo systemctl enable ceph-mon@node1ceph -sceph mon enable-msgr2ceph config set mon auth_allow_insecure_global_id_reclaim falsepip3 install pecan werkzeug监视器守护程序配置 mgr(node1上操作)

mkdir /var/lib/ceph/mgr/ceph-node1

ceph auth get-or-create mgr.node1 mon 'allow profile mgr' osd 'allow *' mds 'allow *' > \

/var/lib/ceph/mgr/ceph-node1/keyring

-------------------------------------

systemctl start ceph-mgr@node1

systemctl enable ceph-mgr@node1 添加OSD(node1上操作)

# 在node1上将添加3个100G硬盘加入ceph

ceph-volume lvm create --data /dev/sdb

ceph-volume lvm create --data /dev/sdc

ceph-volume lvm create --data /dev/sdd# 同步配置到其它节点

scp /etc/ceph/* node2:/etc/ceph/

scp /etc/ceph/* node3:/etc/ceph/

scp /var/lib/ceph/bootstrap-osd/* node2:/var/lib/ceph/bootstrap-osd/

scp /var/lib/ceph/bootstrap-osd/* node3:/var/lib/ceph/bootstrap-osd/

# node2、node3节点上添加OSD

ceph-volume lvm create --data /dev/sdb

ceph-volume lvm create --data /dev/sdc

ceph-volume lvm create --data /dev/sdd查看状态

[root@node1 ~]# ceph -s

cluster:

id: a7f64266-0894-4f1e-a635-d0aeaca0e993

health: HEALTH_OK

services:

mon: 1 daemons, quorum node1 (age 8m)

mgr: node1(active, since 7m)

osd: 9 osds: 9 up (since 5s), 9 in (since 7s)

data:

pools: 0 pools, 0 pgs

objects: 0 objects, 0 B

usage: 9.0 GiB used, 891 GiB / 900 GiB avail

pgs: 扩展监视器(将node2、node3也扩展为监视器)

[root@node1 ~]# cat /etc/ceph/ceph.conf

[global]

fsid = a7f64266-0894-4f1e-a635-d0aeaca0e993

mon initial members = node1,node2,node3

mon host = 192.168.31.101,192.168.31.102,192.168.31.103

public_network = 192.168.31.0/24

cluster_network = 172.16.100.0/24

auth cluster required = cephx

auth service required = cephx

auth client required = cephx

osd journal size = 1024

osd pool default size = 3

osd pool default min size = 2

osd pool default pg num = 333

osd pool default pgp num = 333

osd crush chooseleaf type = 1

------------------------------------# 拷贝文件到其它节点

scp /etc/ceph/ceph.conf node2:/etc/ceph/

scp /etc/ceph/ceph.conf node3:/etc/ceph/-------------------------# 这里给出node2的操作,node3操作类似,修改对应名字即可

# 获取集群已有的mon.keyring

ceph auth get mon. -o mon.keyring

# 获取集群已有的mon.map

ceph mon getmap -o mon.map

# 创建监视器数据目录,会自动创建/var/lib/ceph/mon/ceph-node2

ceph-mon -i node2 --mkfs --monmap mon.map --keyring mon.keyring

chown ceph.ceph /var/lib/ceph/mon/ceph-node2 -R

# 启动mon

systemctl start ceph-mon@node2

systemctl enable ceph-mon@node2

-------------------------------------------

# 查看状态

[root@node1 ~]# ceph -s

cluster:

id: a7f64266-0894-4f1e-a635-d0aeaca0e993

health: HEALTH_OK

services:

mon: 3 daemons, quorum node1,node2,node3 (age 2m)

mgr: node1(active, since 20m)

osd: 9 osds: 9 up (since 29s), 9 in (since 13m)

task status:

data:

pools: 0 pools, 0 pgs

objects: 0 objects, 0 B

usage: 9.1 GiB used, 891 GiB / 900 GiB avail

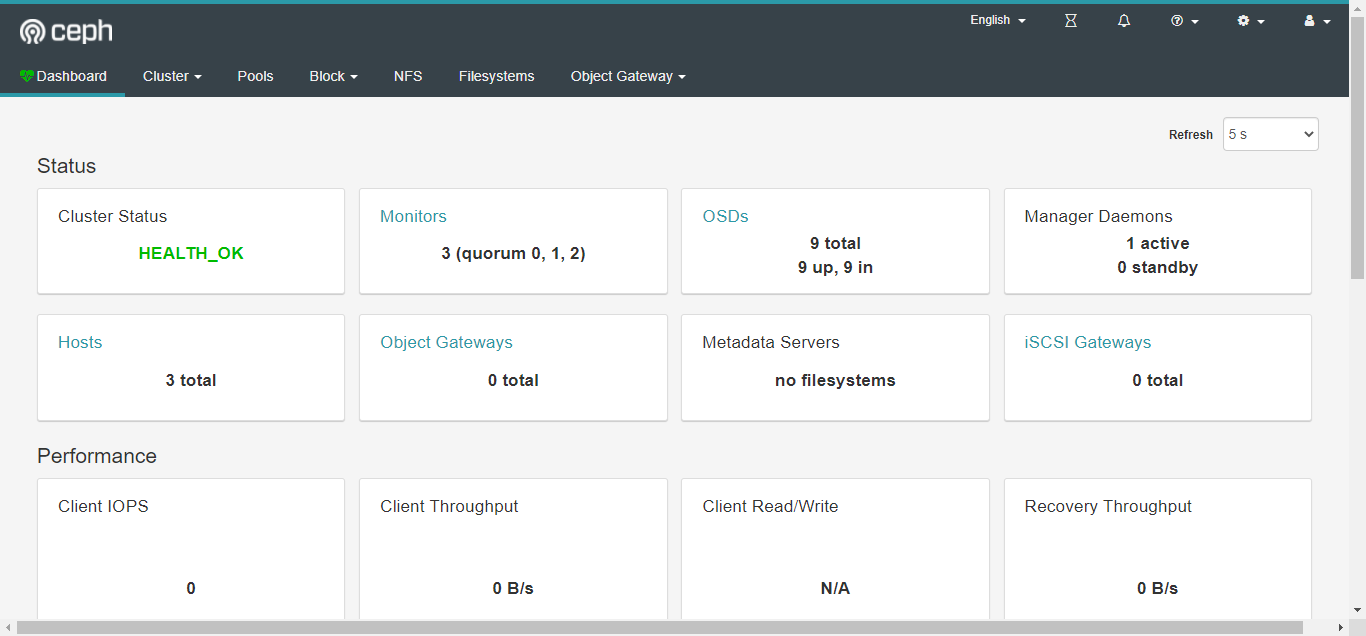

pgs:安装Dashboard

# node1安装Dashboard

yum install ceph-mgr-dashboard -y

# 开启mgr功能

ceph mgr module enable dashboard

# 生成并安装自签名的证书

ceph dashboard create-self-signed-cert

# 创建一个dashboard登录用户名密码(ceph、123456)

echo 123456 > ceph-dashboard-password.txt

ceph dashboard ac-user-create ceph -i ceph-dashboard-password.txt administrator

# 查看服务访问方式

[root@node1 ~]# ceph mgr services

{

"dashboard": "https://node1:8443/"

}

2.OpenStack后端存储对接ceph

---------------------------------------------# OpenStack对接ceph前的准备

# 前三个节点node1,node2,ndoe3是ceph集群,已经安装组件,所以node4和node5要安装ceph-common

yum -y install ceph-common

--- 拷贝配置文件,在node1上拷贝到所有nova节点

for i in $(seq 2 5); do scp /etc/ceph/* node$i:/etc/ceph;done

--创建存储池 64

ceph osd pool create images 64

ceph osd pool create vms 64

ceph osd pool create volumes 64

ceph osd pool application enable images rbd

ceph osd pool application enable vms rbd

ceph osd pool application enable volumes rbd

---配置鉴权

ceph auth get-or-create client.cinder mon 'allow r' \

osd 'allow class-read object_prefix rbd_children, allow rwx pool=volumes, allow rwx pool=vms, allow rx pool=images' \

-o /etc/ceph/ceph.client.cinder.keyring

# ceph auth caps client.cinder mon 'allow *' osd 'allow *' # 开放所有权限,这里两个命令是将上面的命令进行分解

# ceph auth get client.cinder -o /etc/ceph/ceph.client.cinder.keyring # 将证书导出给服务用

ceph auth get-or-create client.glance mon 'allow r' \

osd 'allow class-read object_prefix rbd_children, allow rwx pool=images' \

-o /etc/ceph/ceph.client.glance.keyring

---将生成的key拷贝,拷贝到所有nova节点

for i in $(seq 2 5); do scp /etc/ceph/*.keyring node$i:/etc/ceph;done

--- 修改权限,拷贝到所有nova节点的key文件

for i in $(seq 2 5); do ssh node$i chown glance:glance /etc/ceph/ceph.client.glance.keyring ;done # 这两个文件glance和cinder要使用

for i in $(seq 2 5); do ssh node$i chown cinder:cinder /etc/ceph/ceph.client.cinder.keyring;done

---将秘钥加入到libvcirt中,所有nova节点执行(node2,node3.node4,node5)

ceph auth get-key client.cinder | tee client.cinder.key

uuidgen # 生成uuid,这里使用文档中的uuid

cat > secret.xml <<EOF

<secret ephemeral='no' private='no'>

<uuid>ae3d9d0a-df88-4168-b292-c07cdc2d8f02</uuid>

<usage type='ceph'>

<name>client.cinder secret</name>

</usage>

</secret>

EOF

virsh secret-define --file secret.xml

virsh secret-set-value --secret ae3d9d0a-df88-4168-b292-c07cdc2d8f02 --base64 $(cat client.cinder.key) && rm client.cinder.key secret.xml

---------------------------------------------# OpenStack对接ceph,配置 Glance 节点(node1),对接后需要重新上传镜像

# crudini --set /etc/glance/glance-api.conf DEFAULT "show_image_direct_url" "True"

# crudini --set /etc/glance/glance-api.conf glance_store "default_store" "rbd"

# crudini --set /etc/glance/glance-api.conf glance_store "rbd_store_user" "glance"

# crudini --set /etc/glance/glance-api.conf glance_store "rbd_store_pool" "images"

# crudini --set /etc/glance/glance-api.conf glance_store "stores" "glance.store.filesystem.Store, glance.store.http.Store, glance.store.rbd.Store"

# crudini --set /etc/glance/glance-api.conf paste_deploy "flavor" "keystone"

---------------------------------------------# OpenStack对接ceph,配置 Cinder 节点(node4,node5)

crudini --set /etc/cinder/cinder.conf DEFAULT "enabled_backends" "lvm,nfs,ceph" # 同时支持lvm、nfs、ceph

crudini --set /etc/cinder/cinder.conf ceph "volume_driver" "cinder.volume.drivers.rbd.RBDDriver"

crudini --set /etc/cinder/cinder.conf ceph "volume_backend_name" "ceph"

crudini --set /etc/cinder/cinder.conf ceph "rbd_pool" "volumes"

crudini --set /etc/cinder/cinder.conf ceph "rbd_ceph_conf" "/etc/ceph/ceph.conf"

crudini --set /etc/cinder/cinder.conf ceph "rbd_flatten_volume_from_snapshot" "false"

crudini --set /etc/cinder/cinder.conf ceph "rbd_max_clone_depth" "5"

crudini --set /etc/cinder/cinder.conf ceph "rados_connect_timeout" "-1"

crudini --set /etc/cinder/cinder.conf ceph "glance_api_version" "2"

crudini --set /etc/cinder/cinder.conf ceph "rbd_user" "cinder"

crudini --set /etc/cinder/cinder.conf ceph "rbd_secret_uuid" "ae3d9d0a-df88-4168-b292-c07cdc2d8f02"

---------------------------------------------# OpenStack对接ceph,配置 Nova 节点(node2,node3,node4,node5)

crudini --set /etc/nova/nova.conf libvirt "images_type" "rbd"

crudini --set /etc/nova/nova.conf libvirt "images_rbd_pool" "vms"

crudini --set /etc/nova/nova.conf libvirt "images_rbd_ceph_conf" "/etc/ceph/ceph.conf"

crudini --set /etc/nova/nova.conf libvirt "rbd_user" "cinder"

crudini --set /etc/nova/nova.conf libvirt "rbd_secret_uuid" "ae3d9d0a-df88-4168-b292-c07cdc2d8f02"

crudini --set /etc/nova/nova.conf libvirt "inject_password" "false"

crudini --set /etc/nova/nova.conf libvirt "inject_key" "false"

crudini --set /etc/nova/nova.conf libvirt "inject_partition" "-2"

crudini --set /etc/nova/nova.conf libvirt "live_migration_flag" "VIR_MIGRATE_UNDEFINE_SOURCE,VIR_MIGRATE_PEER2PEER,VIR_MIGRATE_LIVE,VIR_MIGRATE_PERSIST_DEST"

---------------------------------------------# OpenStack重启服务

--- 控制节点

systemctl restart openstack-glance-api openstack-nova-api openstack-cinder-api openstack-cinder-scheduler

--- 计算节点

for i in $(seq 2 5); do ssh node$i systemctl restart openstack-nova-compute;done

--- 存储节点

for i in 4 5; do ssh node$i systemctl restart openstack-cinder-volume;done

---------------------------------------------# OpenStack验证,在node1节点执行

[root@node1 ~]# cinder type-create ceph

+--------------------------------------+------+-------------+-----------+

| ID | Name | Description | Is_Public |

+--------------------------------------+------+-------------+-----------+

| 228269c3-6008-4e62-9408-a2fb04d74c1a | ceph | - | True |

+--------------------------------------+------+-------------+-----------+

[root@node1 ~]# cinder type-key ceph set volume_backend_name=ceph

--- 对glance、cinder、nova操作后确认 rbd ls images / vms / images

创建一个卷后确认

[root@node1 ~]# openstack volume create --size 1 --type ceph volume1

+---------------------+--------------------------------------+

| Field | Value |

+---------------------+--------------------------------------+

| attachments | [] |

| availability_zone | nova |

| bootable | false |

| consistencygroup_id | None |

| created_at | 2022-03-01T10:22:13.000000 |

| description | None |

| encrypted | False |

| id | 3a0ee405-ad4b-4453-8b66-029aa67f7af0 |

| migration_status | None |

| multiattach | False |

| name | volume1 |

| properties | |

| replication_status | None |

| size | 1 |

| snapshot_id | None |

| source_volid | None |

| status | creating |

| type | ceph |

| updated_at | None |

| user_id | 5a44718261844cbd8a65621b9e3cea8d |

+---------------------+--------------------------------------+

[root@node1 ~]# rbd -p volumes ls -l # 在ceph中查看创建的块设备

NAME SIZE PARENT FMT PROT LOCK

volume-3a0ee405-ad4b-4453-8b66-029aa67f7af0 1 GiB 2 OpenStack学习系列之十二:安装ceph并对接OpenStack的更多相关文章

- Dubbo学习系列之十二(Quartz任务调度)

Quartz词义为"石英"水晶,然后聪明的人类利用它发明了石英手表,因石英晶体在受到电流影响时,它会产生规律的振动,于是,这种时间上的规律,也被应用到了软件界,来命名了一款任务调度 ...

- WP8.1学习系列(第二十二章)——在页面之间导航

在本文中 先决条件 创建导航应用 Frame 和 Page 类 页面模板中的导航支持 在页面之间传递信息 缓存页面 摘要 后续步骤 相关主题 重要的 API Page Frame Navigation ...

- WP8.1学习系列(第十二章)——全景控件Panorama开发指南

2014/6/18 适用于:Windows Phone 8 和 Windows Phone Silverlight 8.1 | Windows Phone OS 7.1 全景体验是本机 Windows ...

- Dubbo学习系列之十五(Seata分布式事务方案TCC模式)

上篇的续集. 工具: Idea201902/JDK11/Gradle5.6.2/Mysql8.0.11/Lombok0.27/Postman7.5.0/SpringBoot2.1.9/Nacos1.1 ...

- Dubbo学习系列之十六(ELK海量日志分析框架)

外卖公司如何匹配骑手和订单?淘宝如何进行商品推荐?或者读者兴趣匹配?还有海量数据存储搜索.实时日志分析.应用程序监控等场景,Elasticsearch或许可以提供一些思路,作为业界最具影响力的海量搜索 ...

- VSTO 学习笔记(十二)自定义公式与Ribbon

原文:VSTO 学习笔记(十二)自定义公式与Ribbon 这几天工作中在开发一个Excel插件,包含自定义公式,根据条件从数据库中查询结果.这次我们来做一个简单的测试,达到类似的目的. 即在Excel ...

- webpack4 系列教程(十二):处理第三方JavaScript库

教程所示图片使用的是 github 仓库图片,网速过慢的朋友请移步<webpack4 系列教程(十二):处理第三方 JavaScript 库>原文地址.或者来我的小站看更多内容:godbm ...

- Git学习系列之Windows上安装Git详细步骤(图文详解)

前言 最初,Git是用于Linux下的内核代码管理.因为其非常好用,目前,已经被成功移植到Mac和Windows操作系统下. 鉴于大部分使用者使用的是Windows操作系统,故,这里详细讲解Windo ...

- OSGi 系列(十二)之 Http Service

OSGi 系列(十二)之 Http Service 1. 原始的 HttpService (1) 新建 web-osgi 工程,目录结构如下: (2) HomeServlet package com. ...

随机推荐

- 【pwn】攻防世界 pwn新手区wp

[pwn]攻防世界 pwn新手区wp 前言 这几天恶补pwn的各种知识点,然后看了看攻防世界的pwn新手区没有堆题(堆才刚刚开始看),所以就花了一晚上的时间把新手区的10题给写完了. 1.get_sh ...

- 申请Namecheap的.me 顶级域名以及申请ssl认证--github教育礼包之namecheap

关于教育礼包的取得见另一篇随笔,在那里笔者申请了digital ocean的vps(虚拟专用主机),跟阿里云差不多,不过个人感觉比阿里云便宜好用一点. 有了自己的主机ip,就想到申请域名,方便好记,也 ...

- Docker+etcd+flanneld+kubernets 构建容器编排系统(1)

Docker: Docker Engine, 一个client-server 结构的应用, 包含Docker daemon,一个 用来和daemon 交互的REST API, 一个命令行应用CLI. ...

- cnpm安装教程

安装cnpm,输入以下命令: sudo npm install -g cnpm --registry=https://registry.npm.taobao.org 输入cnpm -v ,检测是否正常 ...

- Flutter 多引擎支持 PlatformView 以及线程合并解决方案

作者:字节移动技术-李皓骅 摘要 本文介绍了 Flutter 多引擎下,使用 PlatformView 场景时不能绕开的一个线程合并问题,以及它最终的解决方案.最终 Pull Request 已经 m ...

- python02day

回顾 1.编译型和解释型 编译型:一次性编译成二进制,再执行 执行效率高,但不能跨平台,开发效率低 代表语言:C 解释型:逐行解释成二进制,再执行 可以跨平台,开发效率高,但执行效率低 代表语言:py ...

- JVM之栈、堆、方法区(三)

一.CPU和内存的交互 今天除夕,祝大家新年快乐,其实,我们知道的,我们的CPU跟内存会有非常频繁的交互,因为如果这个频繁的交互是交给我们的磁盘的话,那么随着我们的CPU运转速度越来越快,那么我们的磁 ...

- Java当中“+=”和“=+”的区别

"+="会自动类型强制转换! 隐含了一个强制类型转换! 一 string a1 = "9"; int a2 = 10; a1+=a2; a1=a1+a2; 不会 ...

- Ubuntu更换镜像源

不同的源 当修改sources.list文件时,我们需要将下面任意一个镜像源的代码复制粘贴到该文件中. 阿里源 # 阿里镜像源 deb http://mirrors.aliyun.com/ubuntu ...

- js window.event

转载请注明来源:https://www.cnblogs.com/hookjc/ 描述event代表事件的状态,例如触发event对象的元素.鼠标的位置及状态.按下的键等等.event对象只在事件发生的 ...