Variational Auto-encoder(VAE)变分自编码器-Pytorch

import os

import torch

import torch.nn as nn

import torch.nn.functional as F

import torchvision

from torchvision import transforms

from torchvision.utils import save_image # 配置GPU或CPU设置

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu') # 创建目录

# Create a directory if not exists

sample_dir = 'samples'

if not os.path.exists(sample_dir):

os.makedirs(sample_dir) # 超参数设置

# Hyper-parameters

image_size = 784

h_dim = 400

z_dim = 20

num_epochs = 15

batch_size = 128

learning_rate = 1e-3 # 获取数据集

# MNIST dataset

dataset = torchvision.datasets.MNIST(root='./data',

train=True,

transform=transforms.ToTensor(),

download=True) # 数据加载,按照batch_size大小加载,并随机打乱

data_loader = torch.utils.data.DataLoader(dataset=dataset,

batch_size=batch_size,

shuffle=True) # 定义VAE类

# VAE model

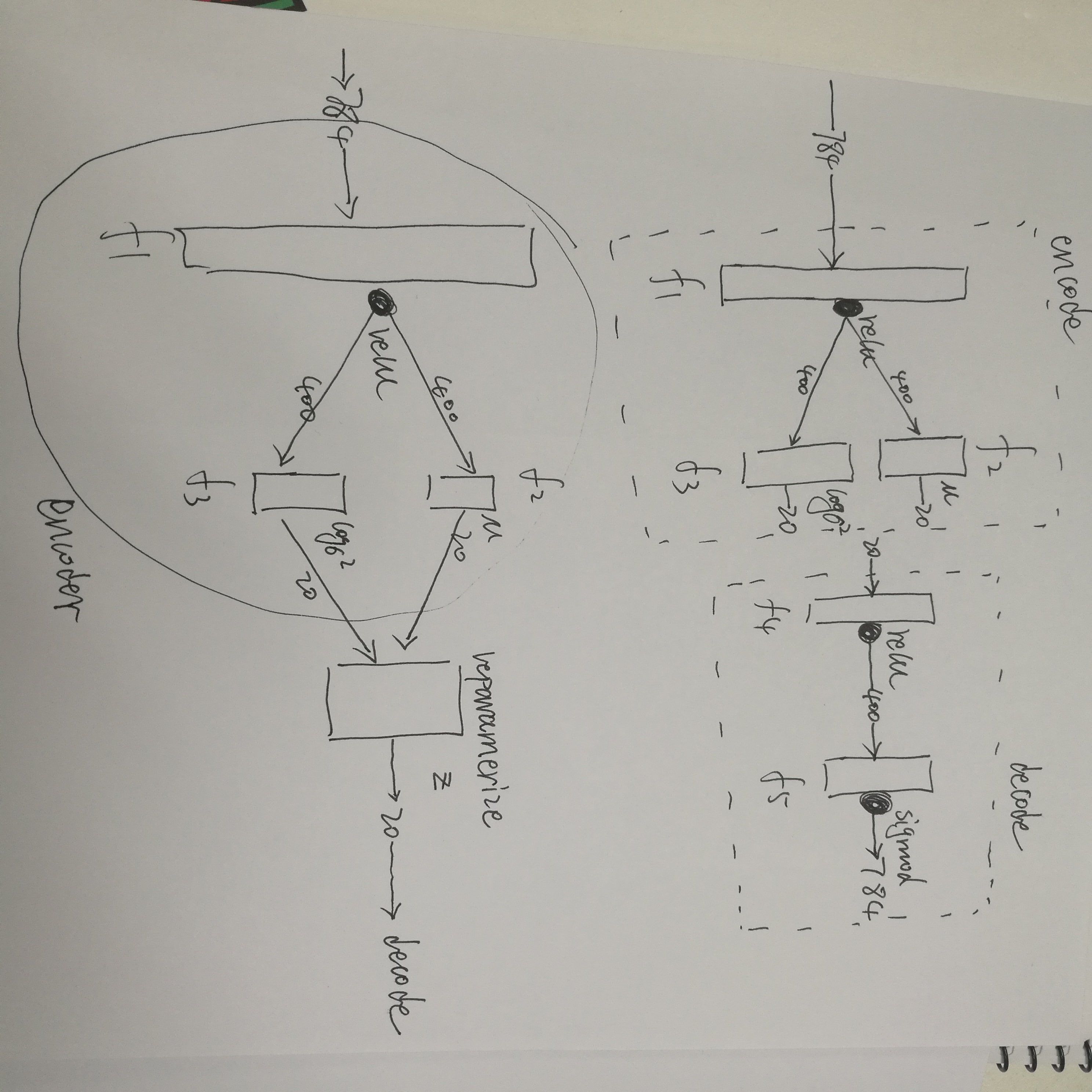

class VAE(nn.Module):

def __init__(self, image_size=784, h_dim=400, z_dim=20):

super(VAE, self).__init__()

self.fc1 = nn.Linear(image_size, h_dim)

self.fc2 = nn.Linear(h_dim, z_dim)

self.fc3 = nn.Linear(h_dim, z_dim)

self.fc4 = nn.Linear(z_dim, h_dim)

self.fc5 = nn.Linear(h_dim, image_size) # 编码 学习高斯分布均值与方差

def encode(self, x):

h = F.relu(self.fc1(x))

return self.fc2(h), self.fc3(h) # 将高斯分布均值与方差参数重表示,生成隐变量z 若x~N(mu, var*var)分布,则(x-mu)/var=z~N(0, 1)分布

def reparameterize(self, mu, log_var):

std = torch.exp(log_var / 2)

eps = torch.randn_like(std)

return mu + eps * std

# 解码隐变量z

def decode(self, z):

h = F.relu(self.fc4(z))

return F.sigmoid(self.fc5(h)) # 计算重构值和隐变量z的分布参数

def forward(self, x):

mu, log_var = self.encode(x)# 从原始样本x中学习隐变量z的分布,即学习服从高斯分布均值与方差

z = self.reparameterize(mu, log_var)# 将高斯分布均值与方差参数重表示,生成隐变量z

x_reconst = self.decode(z)# 解码隐变量z,生成重构x’

return x_reconst, mu, log_var# 返回重构值和隐变量的分布参数 # 构造VAE实例对象

model = VAE().to(device)

print(model)

# VAE( (fc1): Linear(in_features=784, out_features=400, bias=True)

# (fc2): Linear(in_features=400, out_features=20, bias=True)

# (fc3): Linear(in_features=400, out_features=20, bias=True)

# (fc4): Linear(in_features=20, out_features=400, bias=True)

# (fc5): Linear(in_features=400, out_features=784, bias=True)) # 选择优化器,并传入VAE模型参数和学习率

optimizer = torch.optim.Adam(model.parameters(), lr=learning_rate)

#开始训练

for epoch in range(num_epochs):

for i, (x, _) in enumerate(data_loader):

# 前向传播

x = x.to(device).view(-1, image_size)# 将batch_size*1*28*28 ---->batch_size*image_size 其中,image_size=1*28*28=784

x_reconst, mu, log_var = model(x)# 将batch_size*748的x输入模型进行前向传播计算,重构值和服从高斯分布的隐变量z的分布参数(均值和方差) # 计算重构损失和KL散度

# Compute reconstruction loss and kl divergence

# For KL divergence, see Appendix B in VAE paper or http://yunjey47.tistory.com/43

# 重构损失

reconst_loss = F.binary_cross_entropy(x_reconst, x, size_average=False)

# KL散度

kl_div = - 0.5 * torch.sum(1 + log_var - mu.pow(2) - log_var.exp()) # 反向传播与优化

# 计算误差(重构误差和KL散度值)

loss = reconst_loss + kl_div

# 清空上一步的残余更新参数值

optimizer.zero_grad()

# 误差反向传播, 计算参数更新值

loss.backward()

# 将参数更新值施加到VAE model的parameters上

optimizer.step()

# 每迭代一定步骤,打印结果值

if (i + 1) % 10 == 0:

print ("Epoch[{}/{}], Step [{}/{}], Reconst Loss: {:.4f}, KL Div: {:.4f}"

.format(epoch + 1, num_epochs, i + 1, len(data_loader), reconst_loss.item(), kl_div.item())) with torch.no_grad():

# Save the sampled images

# 保存采样值

# 生成随机数 z

z = torch.randn(batch_size, z_dim).to(device)# z的大小为batch_size * z_dim = 128*20

# 对随机数 z 进行解码decode输出

out = model.decode(z).view(-1, 1, 28, 28)

# 保存结果值

save_image(out, os.path.join(sample_dir, 'sampled-{}.png'.format(epoch + 1))) # Save the reconstructed images

# 保存重构值

# 将batch_size*748的x输入模型进行前向传播计算,获取重构值out

out, _, _ = model(x)

# 将输入与输出拼接在一起输出保存 batch_size*1*28*(28+28)=batch_size*1*28*56

x_concat = torch.cat([x.view(-1, 1, 28, 28), out.view(-1, 1, 28, 28)], dim=3)

save_image(x_concat, os.path.join(sample_dir, 'reconst-{}.png'.format(epoch + 1)))

大概长这么个样子:

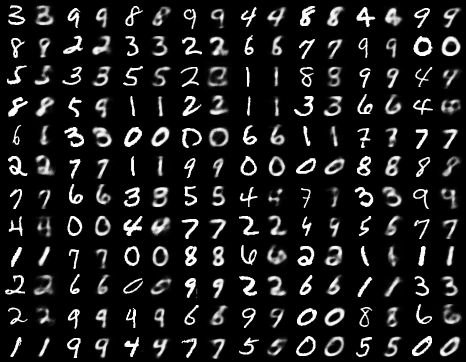

附上一张结果图:

Variational Auto-encoder(VAE)变分自编码器-Pytorch的更多相关文章

- VAE变分自编码器

我在学习VAE的时候遇到了很多问题,很多博客写的不太好理解,因此将很多内容重新进行了整合. 我自己的学习路线是先学EM算法再看的变分推断,最后学VAE,自我感觉这个线路比较好理解. 一.首先我们来宏观 ...

- VAE变分自编码器实现

变分自编码器(VAE)组合了神经网络和贝叶斯推理这两种最好的方法,是最酷的神经网络,已经成为无监督学习的流行方法之一. 变分自编码器是一个扭曲的自编码器.同自编码器的传统编码器和解码器网络一起,具有附 ...

- 变分自编码器(Variational auto-encoder,VAE)

参考: https://www.cnblogs.com/huangshiyu13/p/6209016.html https://zhuanlan.zhihu.com/p/25401928 https: ...

- (转) 变分自编码器(Variational Autoencoder, VAE)通俗教程

变分自编码器(Variational Autoencoder, VAE)通俗教程 转载自: http://www.dengfanxin.cn/?p=334&sukey=72885186ae5c ...

- 变分自编码器(Variational Autoencoder, VAE)通俗教程

原文地址:http://www.dengfanxin.cn/?p=334 1. 神秘变量与数据集 现在有一个数据集DX(dataset, 也可以叫datapoints),每个数据也称为数据点.我们假定 ...

- 4.keras实现-->生成式深度学习之用变分自编码器VAE生成图像(mnist数据集和名人头像数据集)

变分自编码器(VAE,variatinal autoencoder) VS 生成式对抗网络(GAN,generative adversarial network) 两者不仅适用于图像,还可以 ...

- 基于变分自编码器(VAE)利用重建概率的异常检测

本文为博主翻译自:Jinwon的Variational Autoencoder based Anomaly Detection using Reconstruction Probability,如侵立 ...

- 变分推断到变分自编码器(VAE)

EM算法 EM算法是含隐变量图模型的常用参数估计方法,通过迭代的方法来最大化边际似然. 带隐变量的贝叶斯网络 给定N 个训练样本D={x(n)},其对数似然函数为: 通过最大化整个训练集的对数边际似然 ...

- 基于图嵌入的高斯混合变分自编码器的深度聚类(Deep Clustering by Gaussian Mixture Variational Autoencoders with Graph Embedding, DGG)

基于图嵌入的高斯混合变分自编码器的深度聚类 Deep Clustering by Gaussian Mixture Variational Autoencoders with Graph Embedd ...

随机推荐

- Android Studio—增删改查—登录功能

SQLite数据库的常用操作: create table if not exists 表名(字段1 类型(长度),字段2 类型(长度),...)// 建表 drop table if ex ...

- C#求任意两整数之和

2019.9.11 作业要求: 求出任意两整数之和 解决方案: using System; using System.Collections.Generic; using System.Linq; u ...

- C# 复制数组容易踩到的坑--引用类型与值类型

原文链接:https://my.oschina.net/u/3744313/blog/1794235 笔者近期做的项目里大量使用了数组,而在使用过程中,笔者曾经遇到了一个比较低级的问题:如何将一个数组 ...

- 深度学习面试题10:二维卷积(Full卷积、Same卷积、Valid卷积、带深度的二维卷积)

目录 二维Full卷积 二维Same卷积 二维Valid卷积 三种卷积类型的关系 具备深度的二维卷积 具备深度的张量与多个卷积核的卷积 参考资料 二维卷积的原理和一维卷积类似,也有full卷积.sam ...

- linux设备树编译器DTC【转】

本文转载自:https://blog.csdn.net/chenmiaowu88/article/details/54342823 参考文件: \kernel\Documentation\device ...

- python 设计模式之装饰器模式 Decorator Pattern

#写在前面 已经有一个礼拜多没写博客了,因为沉醉在了<妙味>这部小说里,里面讲的是一个厨师苏秒的故事.现实中大部分人不会有她的天分.我喜欢她的性格:总是想着去解决问题,好像从来没有怨天尤人 ...

- 【转】分享一款颜色神器ColorSchemer Studio

原文:https://www.cnblogs.com/xyfll7/p/7569078.html ColorSchemer Studio是一款专业配色软件,网页设计或平面设计师必备工具,和ColorP ...

- shell编程系列3--命令替换

shell编程系列3--命令替换 命令替换 命令替换总结 方法1 `command` 方法2 $(command) 例子1: 获取系统的所有用户并输出 for循环能以空格.换行.tab键作为分隔符 [ ...

- Spark通过修改DataFrame的schema给表字段添加注释(转载)

转载自:https://www.jianshu.com/p/e4c90dc08935 1.需求背景 通过Spark将关系型数据库(以Oracle为例)的表同步的Hive表,要求用Spark建表,有字段 ...

- jenkins下载插件Git Parameter插件

登陆jekinse -> 点击左边菜单列表 -> 点”系统管理“ -> 下拉点”插件管理“ -> 选“可选插件”,在右上角过滤框输入”Git Parameter” -> ...