易百教程人工智能python修正-人工智能监督学习(分类)

分类技术或模型试图从观测值中得出一些结论。 在分类问题中,我们有分类输出,如“黑色”或“白色”或“教学”和“非教学”。 在构建分类模型时,需要有包含数据点和相应标签的训练数据集。 例如,如果想检查图像是否属于汽车。 要实现这个检查,我们将建立一个训练数据集,其中包含与“车”和“无车”相关的两个类。 然后需要使用训练样本来训练模型。 分类模型主要用于人脸识别,垃圾邮件识别等。

在Python中构建分类器的步骤

为了在Python中构建分类器,将使用Python 3和Scikit-learn,这是一个用于机器学习的工具。 按照以下步骤在Python中构建分类器 -

第1步 - 导入Scikit-learn

这将是在Python中构建分类器的第一步。 在这一步中,将安装一个名为Scikit-learn的Python包,它是Python中最好的机器学习模块之一。 以下命令导入包 -

import sklearn

第2步 - 导入Scikit-learn的数据集

在这一步中,我们可以开始使用机器学习模型的数据集。 在这里,将使用乳腺癌威斯康星诊断数据库。 数据集包括有关乳腺癌肿瘤的各种信息,以及恶性或良性分类标签。 该数据集在569个肿瘤上具有569个实例或数据,并且包括关于30个属性或特征(诸如肿瘤的半径,纹理,光滑度和面积)的信息。 借助以下命令,导入Scikit-learn的乳腺癌数据集 -

from sklearn.datasets import load_breast_cancer

现在,以下命令将加载数据集。

data = load_breast_cancer()

以下是字典键列表 -

- 分类标签名称(target_names)

- 实际标签(目标)

- 属性/功能名称(feature_names)

- 属性(数据)

现在,使用以下命令,可以为每个重要信息集创建新变量并分配数据。 换句话说,可以用下列命令组织数据 -

label_names = data['target_names']

labels = data['target']

feature_names = data['feature_names']

features = data['data']

现在,为了使它更清晰,可以使用以下命令来打印类标签,第一个数据实例的标签,我们的功能名称和功能的值 -

print(label_names)

上述命令将分别打印恶性和良性的分类名称。输出结果如下 -

['malignant' 'benign']

现在,下面的命令将显示它们被映射到二进制值0和1。这里0表示恶性肿瘤,1表示良性癌症。得到以下输出 -

print(labels[0])

0

下面给出的两个命令将生成功能名称和功能值。

print(feature_names[0]) print(features[0])

输出结果如下

mean radius

[1.799e+01 1.038e+01 1.228e+02 1.001e+03 1.184e-01 2.776e-01 3.001e-01

1.471e-01 2.419e-01 7.871e-02 1.095e+00 9.053e-01 8.589e+00 1.534e+02

6.399e-03 4.904e-02 5.373e-02 1.587e-02 3.003e-02 6.193e-03 2.538e+01

1.733e+01 1.846e+02 2.019e+03 1.622e-01 6.656e-01 7.119e-01 2.654e-01

4.601e-01 1.189e-01] 从上面的输出中,可以看到第一个数据实例是一个半径为1.7990000e + 01的恶性肿瘤。

要在未看到的数据上测试模型,我们需要将数据分解为训练和测试数据。 它可以在下面的代码的帮助下完成 -

from sklearn.model_selection import train_test_split

上述命令将从sklearn中导入train_test_split函数,下面的命令将数据分解为训练和测试数据。 在下面的例子中,使用40%的数据进行测试,并将提示数据用于训练模型。

train, test, train_labels, test_labels = train_test_split(features,labels,test_size = 0.40, random_state = 42)

现在,使用以下命令构建模型 -

from sklearn.naive_bayes import GaussianNB

现在,使用以下命令构建模型 -

from sklearn.naive_bayes import GaussianNB

上述命令将导入GaussianNB模块。 现在,使用下面给出的命令,需要初始化模型。

gnb = GaussianNB()

将通过使用gnb.fit()将它拟合到数据来训练模型。

model = gnb.fit(train, train_labels)

现在,通过对测试数据进行预测来评估模型,并且可以按如下方式完成 -

preds = gnb.predict(test)

print(preds)

[1 0 0 1 1 0 0 0 1 1 1 0 1 0 1 0 1 1 1 0 1 1 0 1 1 1 1 1 1

0 1 1 1 1 1 1 0 1 0 1 1 0 1 1 1 1 1 1 1 1 0 0 1 1 1 1 1 0

0 1 1 0 0 1 1 1 0 0 1 1 0 0 1 0 1 1 1 1 1 1 0 1 1 0 0 0 0

0 1 1 1 1 1 1 1 1 0 0 1 0 0 1 0 0 1 1 1 0 1 1 0 1 1 0 0 0

1 1 1 0 0 1 1 0 1 0 0 1 1 0 0 0 1 1 1 0 1 1 0 0 1 0 1 1 0

1 0 0 1 1 1 1 1 1 1 0 0 1 1 1 1 1 1 1 1 1 1 1 1 0 1 1 1 0

1 1 0 1 1 1 1 1 1 0 0 0 1 1 0 1 0 1 1 1 1 0 1 1 0 1 1 1 0

1 0 0 1 1 1 1 1 1 1 1 0 1 1 1 1 1 0 1 0 0 1 1 0 1]

上述0和1系列是肿瘤类别的预测值,即恶性和良性。

现在,通过比较两个数组即test_labels和preds,可以看到模型的准确性。 我们将使用accuracy_score()函数来确定准确性。 考虑下面的命令 -

from sklearn.metrics import accuracy_score

print(accuracy_score(test_labels,preds))

0.951754385965

结果显示NaïveBayes分类器准确率为95.17%。

这是基于NaïveBayse高斯模型的机器学习分类器。

支持向量机(SVM)

基本上,支持向量机(SVM)是一种有监督的机器学习算法,可用于回归和分类。 SVM的主要概念是将每个数据项绘制为n维空间中的一个点,每个特征的值是特定坐标的值。以下是了解SVM概念的简单图形表示 -

在上图中,有两个特征。 因此,首先需要在二维空间中绘制这两个变量,其中每个点都有两个坐标,称为支持向量。 该行将数据分成两个不同的分类组。 这条线将是分类器。

在这里,将使用scikit-learn和iris数据集来构建SVM分类器。 Scikitlearn库具有sklearn.svm模块并提供sklearn.svm.svc进行分类。 下面显示了基于4个特征来预测虹膜植物种类的SVM分类器。

数据集

我们将使用包含3个类别(每个类别为50个实例)的虹膜数据集,其中每个类别指的是一类虹膜工厂。 每个实例具有四个特征,即萼片长度,萼片宽度,花瓣长度和花瓣宽度。 下面显示了基于4个特征来预测虹膜植物分类的SVM分类器。

内核

这是SVM使用的技术。 基本上这些功能采用低维输入空间并将其转换到更高维空间。 它将不可分离的问题转换成可分离的问题。 核函数可以是线性,多项式,rbf和sigmoid中的任何一种。 在这个例子中,将使用线性内核。

现在导入下列软件包 -

import pandas as pd

import numpy as np

from sklearn import svm, datasets

import matplotlib.pyplot as plt

现在,加载输入数据 -

iris = datasets.load_iris()

我们使用前两个功能 -

X = iris.data[:, :2]

y = iris.target

我们将用原始数据绘制支持向量机边界,创建一个网格来绘制。

x_min, x_max = X[:, 0].min() - 1, X[:, 0].max() + 1

y_min, y_max = X[:, 1].min() - 1, X[:, 1].max() + 1

h = (x_max / x_min)/100

xx, yy = np.meshgrid(np.arange(x_min, x_max, h),

np.arange(y_min, y_max, h))

X_plot = np.c_[xx.ravel(), yy.ravel()]

需要给出正则化参数的值。

C = 1.0

需要创建SVM分类器对象。参考以下代码 -

Svc_classifier = svm.SVC(kernel='linear',

C=C, decision_function_shape = 'ovr').fit(X, y)

Z = Svc_classifier.predict(X_plot)

Z = Z.reshape(xx.shape)

plt.figure(figsize = (15, 5))

plt.subplot(121)

plt.contourf(xx, yy, Z, cmap = plt.cm.tab10, alpha = 0.3)

plt.scatter(X[:, 0], X[:, 1], c = y, cmap = plt.cm.Set1)

plt.xlabel('Sepal length')

plt.ylabel('Sepal width')

plt.xlim(xx.min(), xx.max())

plt.title('SVC with linear kernel')

plt.show()

执行后得到以下结果 -

逻辑回归

基本上,逻辑回归模型是监督分类算法族的成员之一。 Logistic回归通过使用逻辑函数估计概率来测量因变量和自变量之间的关系。

在这里,如果我们讨论依赖变量和独立变量,那么因变量就是要预测的目标类变量,另一方面,自变量是用来预测目标类的特征。

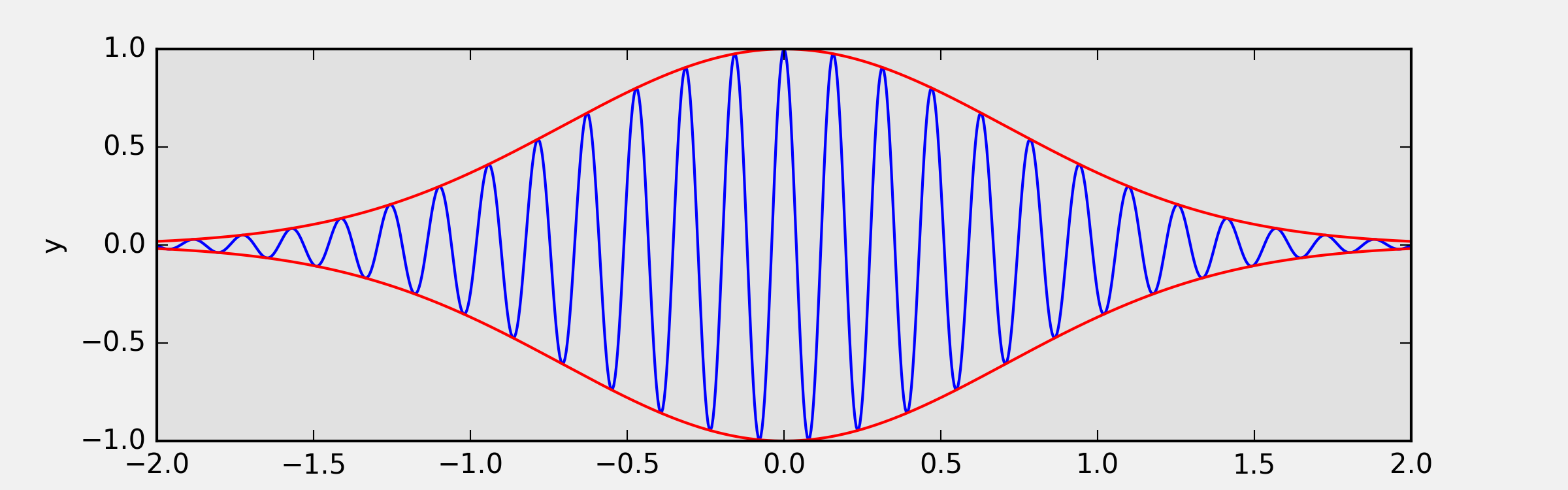

在逻辑回归中,估计概率意味着预测事件的可能性发生。例如,店主想要预测进入商店的顾客将购买游戏站(例如)或不购买。顾客将会观察到许多顾客的特征 - 性别,年龄等,以便预测可能性的发生,即购买游戏站或不购物。逻辑函数是用来构建具有各种参数的函数的S形曲线。

前提条件

在使用逻辑回归构建分类器之前,我们需要在系统上安装Tkinter软件包。 它可以从 https://docs.python.org/2/library/tkinter.html 进行安装。

现在,在下面给出的代码的帮助下,可以使用逻辑回归来创建分类器 -

首先,导入一些软件包 -

import numpy as np

from sklearn import linear_model

import matplotlib.pyplot as plt

现在,需要定义可以完成的样本数据,如下所示 -

X = np.array([[2, 4.8], [2.9, 4.7], [2.5, 5], [3.2, 5.5], [6, 5], [7.6, 4],

[3.2, 0.9], [2.9, 1.9],[2.4, 3.5], [0.5, 3.4], [1, 4], [0.9, 5.9]])

y = np.array([0, 0, 0, 1, 1, 1, 2, 2, 2, 3, 3, 3])

接下来,我们需要创建逻辑回归分类器,可以按如下方式完成 -

Classifier_LR = linear_model.LogisticRegression(solver = 'liblinear', C = 75)

最后但重要的是,我们需要训练这个分类器 -

Classifier_LR.fit(X, y)

Logistic_visualize()的函数来完成 -def Logistic_visualize(Classifier_LR, X, y):

min_x, max_x = X[:, 0].min() - 1.0, X[:, 0].max() + 1.0

min_y, max_y = X[:, 1].min() - 1.0, X[:, 1].max() + 1.0

mesh_step_size = 0.02 #定义绘制网格的步长

x_vals, y_vals = np.meshgrid(np.arange(min_x, max_x, mesh_step_size),

np.arange(min_y, max_y, mesh_step_size)) output =Classifier_LR.predict(np.c_[x_vals.ravel(), y_vals.ravel()])

output = output.reshape(x_vals.shape)

plt.figure()

plt.pcolormesh(x_vals, y_vals, output, cmap = plt.cm.gray) plt.scatter(X[:, 0], X[:, 1], c = y, s = 75, edgecolors = 'black',

linewidth=1, cmap = plt.cm.Paired)

plt.xlim(x_vals.min(), x_vals.max())

plt.ylim(y_vals.min(), y_vals.max())

plt.xticks((np.arange(int(X[:, 0].min() - 1), int(X[:, 0].max() + 1), 1.0)))

plt.yticks((np.arange(int(X[:, 1].min() - 1), int(X[:, 1].max() + 1), 1.0)))

plt.show()

X和Y值的网格,如下所示 -x_vals, y_vals = np.meshgrid(np.arange(min_x, max_x, mesh_step_size),

np.arange(min_y, max_y, mesh_step_size))

使用以下代码,可以在网格网格上运行分类器 -

output =Classifier_LR.predict(np.c_[x_vals.ravel(), y_vals.ravel()])

以下代码行将指定图的边界 -

plt.xlim(x_vals.min(), x_vals.max())

plt.ylim(y_vals.min(), y_vals.max())

plt.xticks((np.arange(int(X[:, 0].min() - 1), int(X[:, 0].max() + 1), 1.0)))

plt.yticks((np.arange(int(X[:, 1].min() - 1), int(X[:, 1].max() + 1), 1.0)))

plt.show()

现在,在运行代码之后,我们将得到以下输出,逻辑回归分类器 -

决策树分类器

决策树基本上是一个二叉树流程图,其中每个节点根据某个特征变量分割一组观察值。

在这里,我们正在构建一个用于预测男性或女性的决策树分类器。这里将采取一个非常小的数据集,有19个样本。 这些样本将包含两个特征 - “身高”和“头发长度”。

前提条件

为了构建以下分类器,我们需要安装pydotplus和graphviz。 基本上,graphviz是使用点文件绘制图形的工具,pydotplus是Graphviz的Dot语言模块。 它可以与包管理器或使用pip来安装。

现在,可以在以下Python代码的帮助下构建决策树分类器 -

首先,导入一些重要的库如下 -

import pydotplus

from sklearn import tree

from sklearn.datasets import load_iris

from sklearn.metrics import classification_report

from sklearn import cross_validation

import collections

现在,提供如下数据集 -

X = [[165,19],[175,32],[136,35],[174,65],[141,28],[176,15],[131,32],

[166,6],[128,32],[179,10],[136,34],[186,2],[126,25],[176,28],[112,38],

[169,9],[171,36],[116,25],[196,25]] Y = ['Man','Woman','Woman','Man','Woman','Man','Woman','Man','Woman',

'Man','Woman','Man','Woman','Woman','Woman','Man','Woman','Woman','Man']

data_feature_names = ['height','length of hair'] X_train, X_test, Y_train, Y_test = cross_validation.train_test_split

(X, Y, test_size=0.40, random_state=5)

在提供数据集之后,需要拟合可以如下完成的模型 -

clf = tree.DecisionTreeClassifier()

clf = clf.fit(X,Y)

prediction = clf.predict([[133,37]])

print(prediction)

使用以下Python代码来实现可视化决策树 -

dot_data = tree.export_graphviz(clf,feature_names = data_feature_names,

out_file = None,filled = True,rounded = True)

graph = pydotplus.graph_from_dot_data(dot_data)

colors = ('orange', 'yellow')

edges = collections.defaultdict(list) for edge in graph.get_edge_list():

edges[edge.get_source()].append(int(edge.get_destination())) for edge in edges: edges[edge].sort() for i in range(2):dest = graph.get_node(str(edges[edge][i]))[0]

dest.set_fillcolor(colors[i])

graph.write_png('Decisiontree16.png')

它会将上述代码的预测作为[‘Woman’]并创建以下决策树 -

可以改变预测中的特征值来测试它。

随机森林分类器

集成方法是将机器学习模型组合成更强大的机器学习模型的方法。 随机森林是决策树的集合,就是其中之一。 它比单一决策树好,因为在保留预测能力的同时,通过平均结果可以减少过度拟合。 在这里,我们将在scikit学习癌症数据集上实施随机森林模型。

导入必要的软件包 -

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_breast_cancer

cancer = load_breast_cancer()

import matplotlib.pyplot as plt

import numpy as np

现在,需要按照以下方式提供数据集

cancer = load_breast_cancer()

X_train, X_test, y_train,

y_test = train_test_split(cancer.data, cancer.target, random_state = 0)

在提供数据集之后,需要拟合可以如下完成的模型 -

forest = RandomForestClassifier(n_estimators = 50, random_state = 0)

forest.fit(X_train,y_train)

print('Accuracy on the training subset:(:.3f)',format(forest.score(X_train,y_train)))

print('Accuracy on the training subset:(:.3f)',format(forest.score(X_test,y_test)))

上面代码,输出结果如下所示 -

Accuracy on the training subset:(:.3f) 1.0

Accuracy on the training subset:(:.3f) 0.965034965034965

现在,与决策树一样,随机森林具有feature_importance模块,它将提供比决策树更好的特征权重视图。 它可以如下绘制和可视化 -

n_features = cancer.data.shape[1]

plt.barh(range(n_features),forest.feature_importances_, align='center')

plt.yticks(np.arange(n_features),cancer.feature_names)

plt.xlabel('Feature Importance')

plt.ylabel('Feature')

plt.show()

执行上面代码,得到以下输出结果 -

分类器的性能

在实现机器学习算法之后,我们需要找出模型的有效性。 衡量有效性的标准可以基于数据集和度量标准。 为了评估不同的机器学习算法,我们可以使用不同的性能指标。 例如,假设使用分类器来区分不同对象的图像,可以使用分类性能指标,如平均准确率,AUC等。从某种意义上说,我们选择评估机器学习模型的指标是非常重要的,因为指标的选择会影响机器学习算法的性能如何被测量和比较。 以下是一些指标 -

混乱矩阵

基本上它用于输出可以是两种或更多种类的分类问题。 这是衡量分类器性能的最简单方法。 混淆矩阵基本上是一个包含两个维度即“实际”和“预测”的表格。 这两个维度都有“真正的正面(TP)”,“真正的负面(TN)”,“错误的正面(FP)”,“错误的否定(FN)”。

在上面的混淆矩阵中,1表示正类,0表示负类。

以下是与混淆矩阵相关的术语 -

- 真正 - 当实际的数据点类别为1并且预测也为1时,TP就是这种情况。

- 真负 - 当数据点的实际类别为0并且预测也为0时,TN就是这种情况。

- 假正 - 当实际的数据点类别为0并且预测也为1时,FP就是这种情况。

- 假负 - FN是数据点的实际类别为1且预测也为

0的情况。

准确性

混淆矩阵本身并不是一个性能指标,但几乎所有的性能矩阵均基于混淆矩阵。 其中之一是准确性。 在分类问题中,它可能被定义为由模型对各种预测所做的正确预测的数量。 计算准确度的公式如下 -

精确

它主要用于文件检索。 它可能被定义为返回的文件有多少是正确的。 以下是计算精度的公式 -

召回或灵敏度

它可能被定义为模型返回的正数有多少。 以下是计算模型召回/灵敏度的公式 -

特异性

它可以定义为模型返回的负数有多少。 这与召回完全相反。 以下是计算模型特异性的公式 -

分类失衡问题

分类不平衡是属于一个类别的观察数量显着低于属于其他类别的观测数量的场景。 例如,在我们需要识别罕见疾病,银行欺诈性交易等情况下,这个问题非常突出。

不平衡分类的例子

让我们考虑一个欺诈检测数据集的例子来理解不平衡分类的概念 -

Total observations = 5000

Fraudulent Observations = 50

Non-Fraudulent Observations = 4950

Event Rate = 1%

解决

平衡类的行为,解决不平衡的类问题。 平衡类的主要目标是增加少数类的频率或减少多数类的频率。 以下是解决失衡类问题的方法 -

重采样

重新采样是用于重建样本数据集的一系列方法 - 包括训练集和测试集。 重新抽样是为了提高模型的准确性。 以下是一些重新抽样技术 -

- 随机抽样 - 这项技术旨在通过随机排除大多数类别的例子来平衡课堂分布。 这样做直到大多数和少数群体的实例得到平衡。

Total observations = 5000

Fraudulent Observations = 50

Non-Fraudulent Observations = 4950

Event Rate = 1%

在这种情况下,我们将10%的样本从非欺诈实例中取而代之,然后将它们与欺诈实例相结合 -

随机抽样后的非欺诈性观察:4950的10% = 495

将他们与欺诈观察结合后的总观测值: 50 + 495 = 545

因此,现在,低采样后新数据集的事件率为: 9%

这种技术的主要优点是可以减少运行时间并改善存储。 但另一方面,它可以丢弃有用的信息,同时减少训练数据样本的数量。

- 随机抽样 - 这种技术旨在通过复制少数类中的实例数量来平衡类分布。

Total observations = 5000

Fraudulent Observations = 50

Non-Fraudulent Observations = 4950

Event Rate = 1%

如果复制50次欺诈性观察30次,那么在复制少数类别观察值后欺诈观察值将为1500。然后,在过采样后新数据中的总观察值将为:4950 + 1500 = 6450。因此,新数据集的事件率是:1500/6450 = 23%。

这种方法的主要优点是不会丢失有用的信息。 但另一方面,由于它复制了少数族群的事件,因此它有更多的过度机会。

合奏技巧

这种方法基本上用于修改现有的分类算法,使其适用于不平衡的数据集。 在这种方法中,我们从原始数据中构建几个两阶段分类器,然后汇总它们的预测。 随机森林分类器是基于集合的分类器的一个例子。

易百教程移动端:请扫描本页面底部(右侧)二维码并关注微信公众号,回复:"教程" 选择相关教程阅读或直接访问:http://m.yiibai.com 。

易百教程人工智能python修正-人工智能监督学习(分类)的更多相关文章

- 易百教程人工智能python修正-人工智能无监督学习(聚类)

无监督机器学习算法没有任何监督者提供任何指导. 这就是为什么它们与真正的人工智能紧密结合的原因. 在无人监督的学习中,没有正确的答案,也没有监督者指导. 算法需要发现用于学习的有趣数据模式. 什么是聚 ...

- 易百教程人工智能python修正-人工智能监督学习(回归)

回归是最重要的统计和机器学习工具之一. 我们认为机器学习的旅程从回归开始并不是错的. 它可以被定义为使我们能够根据数据做出决定的参数化技术,或者换言之,允许通过学习输入和输出变量之间的关系来基于数据做 ...

- 易百教程人工智能python修正-人工智能数据准备-标记数据

我们已经知道,某种格式的数据对于机器学习算法是必需的. 另一个重要的要求是,在将数据作为机器学习算法的输入发送之前,必须正确标记数据. 例如,如果所说的分类,那么数据上会有很多标记. 这些标记以文字, ...

- 易百教程人工智能python修正-人工智能NLTK性别发现器

在这个问题陈述中,将通过提供名字来训练分类器以找到性别(男性或女性). 我们需要使用启发式构造特征向量并训练分类器.这里使用scikit-learn软件包中的标签数据. 以下是构建性别查找器的Pyth ...

- 易百教程人工智能python修正-人工智能数据准备-预处理数据

预处理数据 在我们的日常生活中,需要处理大量数据,但这些数据是原始数据. 为了提供数据作为机器学习算法的输入,需要将其转换为有意义的数据. 这就是数据预处理进入图像的地方. 换言之,可以说在将数据提供 ...

- 易百教程人工智能python补充-NLTK包

自然语言处理(NLP)是指使用诸如英语之类的自然语言与智能系统进行通信的AI方法. 如果您希望智能系统(如机器人)按照您的指示执行操作,希望听取基于对话的临床专家系统的决策时,则需要处理自然语言. N ...

- MyBatis整合Spring MVC(易百教程)

MyBatis是ibatis的升级版,作为hibernate的老对手,它是一个可以自定义SQL.存储过程和高级映射的持久层框架.与Hibernate 的主要区别就是 Mybatis 是半自动化的,而 ...

- Mybatis与Spring集成(易百教程)

整个Mybatis与Spring集成示例要完成的步骤如下: 1.示例功能描述 2.创建工程 3.数据库表结构及数据记录 4.实例对象 5.配置文件 6.测试执行,输出结果 1.示例功能描述 在本示例中 ...

- Mybatis 多对多(易百教程)

mybatis3.0 添加了association和collection标签专门用于对多个相关实体类数据进行级联查询,但仍不支持多个相关实体类数据的级联保存和级联删除操作.因此在进行实体类多对多映射表 ...

随机推荐

- SpringMVC自定义类型转换器

SpringMVC 自定义类型转换器 我们在使用SpringMVC时,常常需要把表单中的参数映射到我们对象的属性中,我们可以在默认的spring-servlet.xml加上如下的配置即可做到普通数据 ...

- 2019 SDN第3次上机作业

0.报文类型与含义 1.Controller-to-Switch 报文 Cortoller-to-Switch是由控制器初始化并下发给交换机的报文类型,其可能会要求交换机回复对应的报文,此类型报文 ...

- go 指南学习笔记

1 If for 后面没有小括号.后面的花括号,要在当前行,并且中间有内容,右花括号要单独一行. 因为go会格式化代码,自动插入分号. 2 函数和方法的区别: 方法需要有一个接受者(select ...

- MySQL8新特性(2)--mysql的升级过程

在之前的版本中,安装新的版本mysql之后,mysql server在下一次启动时,会自动升级数据字典表,然后dba需要执行mysql_upgrade手动升级mysql schema中的系统表,以及其 ...

- PhpStorm使用sftp实现代码自动上传服务器

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明.本文链接:https://blog.csdn.net/huihui940630/article/ ...

- electron---项目打包

创建一个应用目录:app,里面需要有必要的三个文件: index.html <!DOCTYPE html> <html> <head> <meta chars ...

- kafka集群部署以及单机部署

kafka单机部署 一.环境准备 当前环境:centos7.3一台软件版本:kafka_2.12部署目录:/usr/local/kafka启动端口:9092配置文件:/usr/local/kafk ...

- springboot入门简单,深入难

18年1月份的时候在腾讯课堂学习springboot.springcloud搭建微服务,老师告诉我们,springboot入门容易,深入难. 因为你必须东西SpringMVC.Spring.Mybat ...

- STM32F405的内部ADC采集

1. ADC的初始化部分基本一致,下面是引脚复用配置 void HAL_ADC_MspInit(ADC_HandleTypeDef *hadc) { GPIO_InitTypeDef GPIO_Ini ...

- Docker学习-安装,配置,运行

Docker继续学习 2019年12月15日23:15:36 第二次学习docker Docker三个重要概念: 镜像 就是一个模板(类似一个Java类) 容器 容器是用镜像创建的运行实例. 仓库 仓 ...