scrapy框架中多个spider,tiems,pipelines的使用及运行方法

用scrapy只创建一个项目,创建多个spider,每个spider指定items,pipelines.启动爬虫时只写一个启动脚本就可以全部同时启动。

本文代码已上传至github,链接在文未。

一,创建多个spider的scrapy项目

scrapy startproject mymultispider

cd mymultispider

scrapy genspider myspd1 sina.com.cn

scrapy genspider myspd2 sina.com.cn

scrapy genspider myspd3 sina.com.cn

二,运行方法

1.为了方便观察,在spider中分别打印相关信息

import scrapy

class Myspd1Spider(scrapy.Spider):

name = 'myspd1'

allowed_domains = ['sina.com.cn']

start_urls = ['http://sina.com.cn/'] def parse(self, response):

print('myspd1')

其他如myspd2,myspd3分别打印相关内容。

2.多个spider运行方法有两种,第一种写法比较简单,在项目目录下创建crawl.py文件,内容如下

from scrapy.crawler import CrawlerProcess

from scrapy.utils.project import get_project_settings process = CrawlerProcess(get_project_settings()) # myspd1是爬虫名

process.crawl('myspd1')

process.crawl('myspd2')

process.crawl('myspd3') process.start()

为了观察方便,可在settings.py文件中限定日志输出

LOG_LEVEL = 'ERROR'

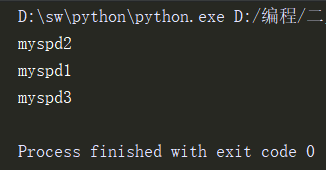

右键运行此文件即可,输出如下

3.第二种运行方法为修改crawl源码,可以从官方的github中找到:https://github.com/scrapy/scrapy/blob/master/scrapy/commands/crawl.py

在spiders目录的同级目录下创建一个mycmd目录,并在该目录中创建一个mycrawl.py,将crawl源码复制进来,修改其中的run方法,改为如下内容

def run(self, args, opts):

# 获取爬虫列表

spd_loader_list = self.crawler_process.spider_loader.list()

# 遍历各爬虫

for spname in spd_loader_list or args:

self.crawler_process.crawl(spname, **opts.spargs)

print("此时启动的爬虫:" + spname)

self.crawler_process.start()

在该文件的目录下创建初始化文件__init__.py

完成后机构目录如下

使用命令启动爬虫

scrapy mycrawl --nolog

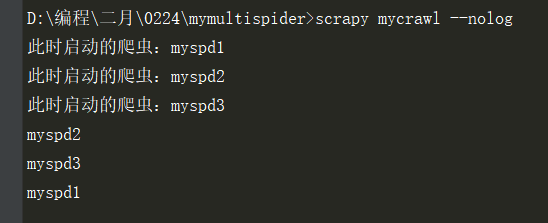

输出如下:

三,指定items

1,这个比较简单,在items.py文件内创建相应的类,在spider中引入即可

items.py

import scrapy class MymultispiderItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

pass class Myspd1spiderItem(scrapy.Item):

name = scrapy.Field() class Myspd2spiderItem(scrapy.Item):

name = scrapy.Field() class Myspd3spiderItem(scrapy.Item):

name = scrapy.Field()

spider内,例myspd1

# -*- coding: utf-8 -*-

import scrapy

from mymultispider.items import Myspd1spiderItem class Myspd1Spider(scrapy.Spider):

name = 'myspd1'

allowed_domains = ['sina.com.cn']

start_urls = ['http://sina.com.cn/'] def parse(self, response):

print('myspd1')

item = Myspd1spiderItem()

item['name'] = 'myspd1的pipelines'

yield item

四,指定pipelines

1,这个也有两种方法,方法一,定义多个pipeline类:

pipelines.py文件内:

class Myspd1spiderPipeline(object):

def process_item(self,item,spider):

print(item['name'])

return item class Myspd2spiderPipeline(object):

def process_item(self,item,spider):

print(item['name'])

return item class Myspd3spiderPipeline(object):

def process_item(self,item,spider):

print(item['name'])

return item

1.1settings.py文件开启管道

ITEM_PIPELINES = {

# 'mymultispider.pipelines.MymultispiderPipeline': 300,

'mymultispider.pipelines.Myspd1spiderPipeline': 300,

'mymultispider.pipelines.Myspd2spiderPipeline': 300,

'mymultispider.pipelines.Myspd3spiderPipeline': 300,

}

1.2spider中设置管道,例myspd1

# -*- coding: utf-8 -*-

import scrapy

from mymultispider.items import Myspd1spiderItem class Myspd1Spider(scrapy.Spider):

name = 'myspd1'

allowed_domains = ['sina.com.cn']

start_urls = ['http://sina.com.cn/']

custom_settings = {

'ITEM_PIPELINES': {'mymultispider.pipelines.Myspd1spiderPipeline': 300},

} def parse(self, response):

print('myspd1')

item = Myspd1spiderItem()

item['name'] = 'myspd1的pipelines'

yield item

指定管道的代码

custom_settings = {

'ITEM_PIPELINES': {'mymultispider.pipelines.Myspd1spiderPipeline': 300},

}

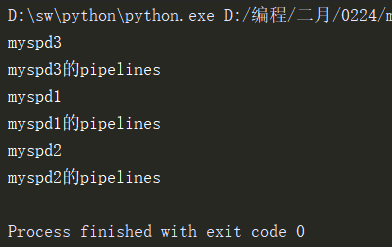

1.3运行crawl文件,运行结果如下

2,方法二,在pipelines.py文件内判断是哪个爬虫的结果

2.1 pipelines.py文件内

class MymultispiderPipeline(object):

def process_item(self, item, spider):

if spider.name == 'myspd1':

print('myspd1的pipelines')

elif spider.name == 'myspd2':

print('myspd2的pipelines')

elif spider.name == 'myspd3':

print('myspd3的pipelines')

return item

2.2 settings.py文件内只开启MymultispiderPipeline这个管道文件

ITEM_PIPELINES = {

'mymultispider.pipelines.MymultispiderPipeline': 300,

# 'mymultispider.pipelines.Myspd1spiderPipeline': 300,

# 'mymultispider.pipelines.Myspd2spiderPipeline': 300,

# 'mymultispider.pipelines.Myspd3spiderPipeline': 300,

}

2.3spider中屏蔽掉指定pipelines的相关代码

# -*- coding: utf-8 -*-

import scrapy

from mymultispider.items import Myspd1spiderItem class Myspd1Spider(scrapy.Spider):

name = 'myspd1'

allowed_domains = ['sina.com.cn']

start_urls = ['http://sina.com.cn/']

# custom_settings = {

# 'ITEM_PIPELINES': {'mymultispider.pipelines.Myspd1spiderPipeline': 300},

# } def parse(self, response):

print('myspd1')

item = Myspd1spiderItem()

item['name'] = 'myspd1的pipelines'

yield item

2.4 运行crawl.py文件,结果如下

代码git地址:https://github.com/terroristhouse/crawler

python系列教程:

链接:https://pan.baidu.com/s/10eUCb1tD9GPuua5h_ERjHA

提取码:h0td

scrapy框架中多个spider,tiems,pipelines的使用及运行方法的更多相关文章

- scrapy框架中Spiders用法

scrapy框架中Spiders用法 Spider类定义了如何爬去某个网站,包括爬取的动作以及如何从网页内容中提取结构化的数据 总的来说spider就是定义爬取的动作以及分析某个网页 工作流程分析 以 ...

- Scrapy框架中的CrawlSpider

小思考:如果想要通过爬虫程序去爬取”糗百“全站数据新闻数据的话,有几种实现方法? 方法一:基于Scrapy框架中的Spider的递归爬取进行实现(Request模块递归回调parse方法). 方法二: ...

- scrapy框架中Item Pipeline用法

scrapy框架中item pipeline用法 当Item 在Spider中被收集之后,就会被传递到Item Pipeline中进行处理 每个item pipeline组件是实现了简单的方法的pyt ...

- scrapy框架中Download Middleware用法

scrapy框架中Download Middleware用法 Downloader Middleware处理的过程主要在调度器发送requests请求的时候以及网页将response结果返回给sp ...

- 爬虫(十五):Scrapy框架(二) Selector、Spider、Downloader Middleware

1. Scrapy框架 1.1 Selector的用法 我们之前介绍了利用Beautiful Soup.正则表达式来提取网页数据,这确实非常方便.而Scrapy还提供了自己的数据提取方法,即Selec ...

- Scrapy框架中选择器的用法【转】

Python爬虫从入门到放弃(十四)之 Scrapy框架中选择器的用法 请给作者点赞 --> 原文链接 Scrapy提取数据有自己的一套机制,被称作选择器(selectors),通过特定的Xpa ...

- scrapy框架中选择器的用法

scrapy框架中选择器的用法 Scrapy提取数据有自己的一套机制,被称作选择器(selectors),通过特定的Xpath或者CSS表达式来选择HTML文件的某个部分Xpath是专门在XML文件中 ...

- python学习之-用scrapy框架来创建爬虫(spider)

scrapy简单说明 scrapy 为一个框架 框架和第三方库的区别: 库可以直接拿来就用, 框架是用来运行,自动帮助开发人员做很多的事,我们只需要填写逻辑就好 命令: 创建一个 项目 : cd 到需 ...

- Python爬虫从入门到放弃(十六)之 Scrapy框架中Item Pipeline用法

当Item 在Spider中被收集之后,就会被传递到Item Pipeline中进行处理 每个item pipeline组件是实现了简单的方法的python类,负责接收到item并通过它执行一些行为, ...

随机推荐

- [LOJ#2017][轮廓线DP][KMP]「SCOI2016」围棋

题目传送门 看到 \(m\le 12\) 和 \(c\le 6\) ,容易想到状压 DP 考虑转化成 \(3^{nm}\) 减去不合法的方案数,轮廓线 DP :\(f[i][j][S][k][h]\) ...

- 遗传编程GP-地图路径寻路

本文介绍的是基于GP,并非A*算法,算是另类实现吧. 先看看地图定义,在文本文件中定义如下字符串,代表30列11行大小的地图 初始位置在左上角(0,0) ,值为1的是允许走的通的路,目标位置为右下角( ...

- 在eclipse中导入源码

因为初学java有一个源码项目想要导入,在网上找了很多方法试了都不行,后来发现其实是想多了,这里说一个很简洁的方法.* 1.首先点eclipse中的File然后点import, 2. 然后选Gener ...

- .NetCore自定义WebAPI返回Json的格式大小写的三种方式

.NetCore的Controller/WebAPI可以帮我们将返回结果自动转换为Json格式给前台,而且可以自由设定格式(大写.小写.首字母大写等),我总结了三种方法,对应三种灵活度,供大家参考 ( ...

- 基于swoole+Redis的消息实时推送通知

swoole+Redis将实时数据的推送 一 实现功能 设计师订单如果设计师未抢单,超时(5分钟)设计订单时时给设计师派送, 设计师公众号中收到派单信息 设计发布者收到派单成功信息 环境 centos ...

- applyColorMap 在OpenCV中对灰度图进行颜色映射,实现数据的色彩化

什么是色彩映射: 说直白点就是将各种数据映射成颜色信息,例如:温度,高度,压力,密度,湿度,城市拥堵数据等等 色彩化后更加直观表达 在OpenCV里可以使用 Mat im_gray = imread( ...

- VLC for CentOS7

https://blog.csdn.net/qiuyoujie/article/details/78486947 http://elearning.wsldp.com/pcmagazine/insta ...

- 事务管理(ACID)

目录 一.事务管理(ACID) 原子性(Atomicity) 一致性(Consistency) 持久性(Durability) 隔离性(Isolation) 二.事务隔离级别 脏读 不可复读 虚读(幻 ...

- C#系列之算数运算符(四)

今天,我将做一个算术运算符++和--的笔记以及一元运算符和二元运算符同时存在怎么计算的笔记 ++:分为前加加和后加加,但是最后结果都是+1: --:分为前减减和后减减,但是最后结果都是-1: 例如: ...

- Centos 7x 安装 Telegram MTproxy代理【完美可用】

0x00 最近迷上了Telegram,也就是电报,觉得通过这个获取国外的新闻比较方便 可是我的VPS小机子不给力,一开始使用的Centos 6x,死活装不上去, 发现MTproxy不支持Centos ...