K-means VS K-NN and 手肘法

1. The difference between classification and clustering. from here.

Classification: supervised learning with labels.

Clustering: unsupervised learning without labels.

Classification and Clustering are the two types of learning methods which characterize objects into groups by one or more features. These processes appear to be similar, but there is a difference between them in the context of data mining. The prior difference between classification and clustering is that classification is used in supervised learning technique where predefined labels are assigned to instances by properties, on the contrary, clustering is used in unsupervised learning where similar instances are grouped, based on their features or properties.

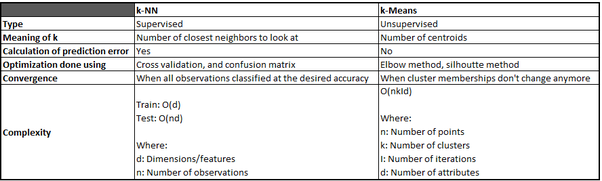

2. The difference between k-means and k-NN. from here.

k-means: an unsupervised algorithm used for clustering.

k-NN: a supervised algorithm used for classification.

3. K-NN algorithm

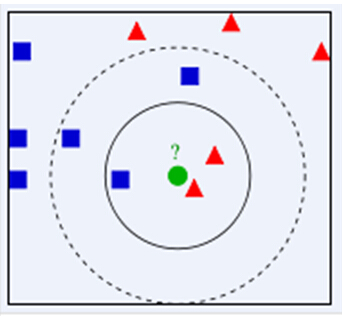

K-nearest neighbours needs labelled data to train on. With the given data, KNN can classify new, unlabelled data by analysis of the k number of the nearest data points.

Steps

- 计算测试数据与各个训练数据之间的距离;

按照距离的递增关系进行排序;

选取距离最小的K个点;

确定前K个点所在类别的出现频率;

返回前K个点中出现频率最高的类别作为测试数据的预测分类。

影响KNN结果的两个因素: i. k的选取, ii. 距离的测算

- k过小,导致容易受噪声影响,将噪声学习到模型中,而忽略了数据的真实分布. k过大, 模型简化,忽略训练数据中的大量有用信息,导致无法学习. 如果k=N(N为训练样本的个数),那么无论输入实例是什么,都将简单地预测它属于在训练实例中最多的类。这时,模型是不是非常简单,这相当于你压根就没有训练模型!

4. K-means algorithm

Steps

- Initially, randomly pick k centroids/cluster centers. Try to make them near the data but different from one another.

- Then assign each data point to the closest centroid.

- Move the centroids to the average location of the data points assigned to it.

- Repeat the preceding two steps until the assignments don’t change, or change very little.

5. How to optimize K in k-means?

SSE + elbow method; silhouette coefficient; Calinski-Harabaz index; 信息准则: AIC-Akaike information criterion; BIC-Bayesian information criterion.

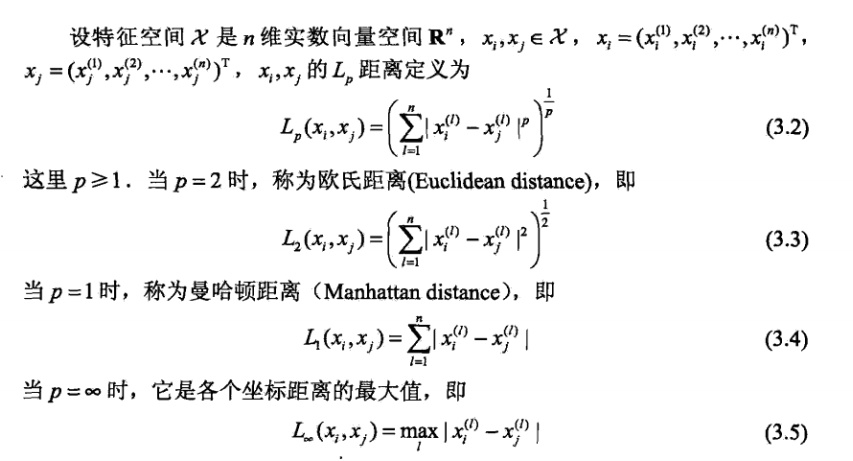

SSE,sum of the squared errors,误差的平方和。在K-means 算法中,SSE 计算的是每类中心点与其同类成员距离的平方和。

其中, ui 表示第i类的中心点.

其中, ui 表示第i类的中心点.

手肘法的核心思想是:

随着聚类数k的增大,样本划分会更加精细,每个簇的聚合程度会逐渐提高,那么误差平方和SSE自然会逐渐变小。

当k小于最佳聚类数时,k的增大会大幅增加每个簇的聚合程度,故SSE的下降幅度会很大;

当k到达最佳聚类数时,再增加k所得到的聚合程度,回报会迅速变小,所以SSE的下降幅度会骤减,然后随着k值的继续增大而趋于平缓。也就是说SSE和 k 的关系图是一个手肘的形状,而这个肘部对应的k值就是数据的最佳聚类数。这也是该方法被称为手肘法的原因。

from here.

6. how to optimize KNN?

cross-validation;

Supplementary knowledge:

1. cross-validation 交叉验证

from here.

在机器学习里,通常来说我们不能将全部用于数据训练模型,否则我们将没有数据集对该模型进行验证,从而评估我们的模型的预测效果。

交叉验证是在机器学习建立模型和验证模型参数时常用的办法。交叉验证,顾名思义,就是重复的使用数据,把得到的样本数据进行切分,组合为不同的训练集和测试集,用训练集来训练模型,用测试集来评估模型预测的好坏。在此基础上可以得到多组不同的训练集和测试集,某次训练集中的某样本在下次可能成为测试集中的样本,即所谓“交叉”。

根据切分的方法不同,交叉验证分为下面三种:

第一种是简单交叉验证,所谓的简单,是和其他交叉验证方法相对而言的。首先,我们随机的将样本数据分为两部分(比如: 70%的训练集,30%的测试集),然后用训练集来训练模型,在测试集上验证模型及参数。接着,我们再把样本打乱,重新选择训练集和测试集,继续训练数据和检验模型。最后我们选择损失函数评估最优的模型和参数。

第二种是S折交叉验证(S-Folder Cross Validation)。和第一种方法不同,S折交叉验证会把样本数据随机的分成S份,每次随机的选择S-1份作为训练集,剩下的1份做测试集。当这一轮完成后,重新随机选择S-1份来训练数据。若干轮(小于S)之后,选择损失函数评估最优的模型和参数。

第三种是留一交叉验证(Leave-one-out Cross Validation),它是第二种情况的特例,此时S等于样本数N,这样对于N个样本,每次选择N-1个样本来训练数据,留一个样本来验证模型预测的好坏。此方法主要用于样本量非常少的情况,比如对于普通适中问题,N小于50时,我一般采用留一交叉验证。

Reference:

K-means VS K-NN and 手肘法的更多相关文章

- lintcode 中等题:k Sum ii k数和 II

题目: k数和 II 给定n个不同的正整数,整数k(1<= k <= n)以及一个目标数字. 在这n个数里面找出K个数,使得这K个数的和等于目标数字,你需要找出所有满足要求的方案. 样例 ...

- 今天遇到的面试题for(j=0,i=0;j<6,i<10;j++,i++) { k=i+j; } k 值最后是多少?

for(j=0,i=0;j<6,i<10;j++,i++) { k=i+j; } k 值最后是多少? <script type="text/javascript" ...

- 设子数组A[0:k]和A[k+1:N-1]已排好序(0≤K≤N-1)。试设计一个合并这2个子数组为排好序的数组A[0:N-1]的算法。

设子数组A[0:k]和A[k+1:N-1]已排好序(0≤K≤N-1).试设计一个合并这2个子数组为排好序的数组A[0:N-1]的算法.要求算法在最坏情况下所用的计算时间为O(N),只用到O(1)的辅助 ...

- 有两个序列A和B,A=(a1,a2,...,ak),B=(b1,b2,...,bk),A和B都按升序排列。对于1<=i,j<=k,求k个最小的(ai+bj)。要求算法尽量高效。

有两个序列A和B,A=(a1,a2,...,ak),B=(b1,b2,...,bk),A和B都按升序排列.对于1<=i,j<=k,求k个最小的(ai+bj).要求算法尽量高效. int * ...

- Python交互K线工具 K线核心功能+指标切换

Python交互K线工具 K线核心功能+指标切换 aiqtt团队量化研究,用vn.py回测和研究策略.基于vnpy开源代码,刚开始接触pyqt,开发界面还是很痛苦,找了很多案例参考,但并不能完全满足我 ...

- 给定一个非负索引 k,其中 k ≤ 33,返回杨辉三角的第 k 行。

从第0行开始,输出第k行,传的参数为第几行,所以在方法中先将所传参数加1,然后将最后一行加入集合中返回. 代码如下: public static List<Integer> generat ...

- [leetcode]692. Top K Frequent Words K个最常见单词

Given a non-empty list of words, return the k most frequent elements. Your answer should be sorted b ...

- [leetcode]347. Top K Frequent Elements K个最常见元素

Given a non-empty array of integers, return the k most frequent elements. Example 1: Input: nums = [ ...

- imshow(K)和imshow(K,[]) 的区别

参考文献 imshow(K)直接显示K:imshow(K,[])显示K,并将K的最大值和最小值分别作为纯白(255)和纯黑(0),中间的K值映射为0到255之间的标准灰度值.

随机推荐

- CSS语法、选择器、继承、层叠

行内样式(内联样式) <h1 style="color:red;font-size:20px;">css行内样式</h1> 内部样式表(嵌入样式) < ...

- ora.vip 1 ONLINE INTERMEDIAT

问题出现情景: 三节点12C rac某次扩存储,两个节点同时重启,其中一个节点 ora.rac1.vip 1 ONLINE INTERMEDIATE rac2 FAILED OVER 出现原因可能 ...

- #AcWing系列课程Level-2笔记——3. 整数二分算法

整数二分算法 编写整数二分,记住下面的思路,代码也就游刃有余了! 1.首先找到数组的中间值,mid=(left+right)>>1,区间[left, right]被划分成[left, mi ...

- 斯坦福发布2019全球AI报告:中国论文数量超美国,自动驾驶汽车领域获投资最多

近日,斯坦福联合MIT.哈佛.OpenAI等院校和机构发布了一份291页的<2019年度AI指数报告>. 这份长达291页的报告从AI的研究&发展.会议.技术性能.经济.教育.自动 ...

- linq to sql 比较字符串形式的时间

where Convert.ToDateTime(t.Date.Trim()).CompareTo(Convert.ToDateTime("2009/9/9")) >= 0 ...

- C#浅拷贝与深拷贝测试

1.浅拷贝与深拷贝 浅拷贝:只复制对象的基本类型,对象类型,仍属于原来的引用. 深拷贝:不紧复制对象的基本类,同时也复制原对象中的对象.就是说完全是新对象产生的. 2.浅拷贝与深拷贝的区别 ...

- 博客前端live2D实现

1.本来以为没那么简单,结果看了大佬的https://www.cnblogs.com/liuzhou1/p/10813828.html#4431992的简单明了.效果如下,可随鼠标移动. ①这里添加在 ...

- simmon effect : build the funcion of trail list

#the real experiment for simon effect #load the library which is our need import pygame import sys i ...

- JDK下载安装与环境变量配置图文教程【超详细】

JDK下载安装与环境变量配置图文教程[超详细] 创建时间:2019年11月13日11时02分 文章目录 1. JDK介绍 1.1 什么是JDK? 1.2 JDK版本介绍 2. JDK下载与安装 3.w ...

- One CLI for webpack must be installed. These are recommended choices, delivered as separate packages:

C:\Users\arn>webpack -v One CLI for webpack must be installed. These are recommended choices, del ...