【大数据系列】hive安装及启动

一、安装好jdk和hadoop

二、下载apache-hive

https://mirrors.tuna.tsinghua.edu.cn/apache/hive/hive-2.3.0/

三、解压到安装目录并配置环境变量

tar -zxvf apache-hive-2.3.0 #解压

vi /etc/profile #打开配置环境变量的文件

export HIVE_HOME=/home/hadoop/apache-hive-2.3.0 #配置hive_home

export PATH=$PATH:/home/hadoop/apache-hive-2.3.0/bin #修改path

source /etc/profile #使环境变量生效

cd /home/hadoop/apache-hive-2.3.0/conf #切换到配置文件目录下

cp hive-default.xml.template hive-site.xml #生成hive-site.xml

vi hive-site.xml

替换${system:java.io.tempDir}为/home/hadoop/hive #替换环境变量

替换${system:user.name}为hadoop #替换环境变量

cd /home/hadoop/hive

mkdir hadoop

四、初始化schema库

cd /home/hadoop/apache-hive-2.3.0/bin

./schematool -initSchema -dbType derby #hive默认的数据库是derby

初始化完成之后,会在bin目录下创建一个metastore_db文件夹

hive #进入hive shell

五、hive常见命令

$hive>show databases; #显示库

$hive>show tables; #显示表

$hive>create database myhive; #创建库

$hive>use myhive; #启用myhive库

$hive>describe database myhive ;#查看数据库信息

$hive>describe table employee ;#查看表信息

$hive>create table test1 like test;//只是复制表结构,不复制数据

$hive>create table test3 as select id,name from test1;#复制表结构的同时内容也复制了

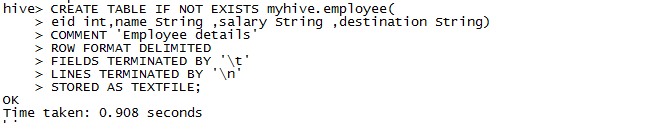

六、创建表

准备测试数据的文件

1201 Gopal 45000 Techinal manager

1202 Manisha 45000 Proof reader

1203 Masthanvali 40000 Techinal writer

1204 Krian 40000 Hr Admin

1205 Kranthi 30000 Op Admin

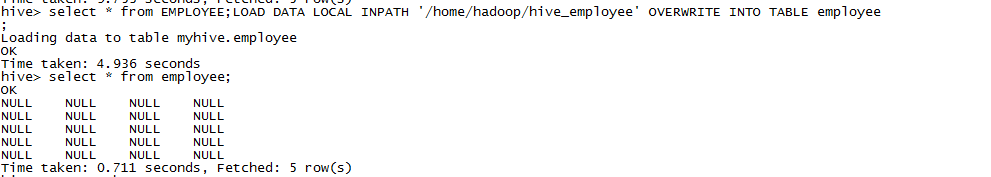

查询的数据为空,感觉看能是新建的文件中分隔符没识别出来吧,又新建了表做了测试。

FIELDS TERMINATED BY 表示字段以什么分割

LINES TERMINATED BY 表示行用什么分割

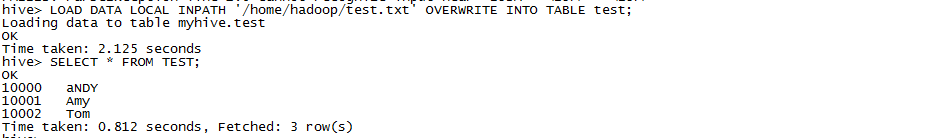

准备测试数据

10000,aNDY

10001,Amy

10002,Tom

LOAD DATA插入数据等价于hdfs上传数据

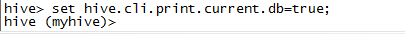

七、设置显示当前数据库

【大数据系列】hive安装及启动的更多相关文章

- 大数据学习——hive安装部署

1上传压缩包 2 解压 tar -zxvf apache-hive-1.2.1-bin.tar.gz -C apps 3 重命名 mv apache-hive-1.2.1-bin hive 4 设置环 ...

- 【大数据系列】安装Ambari

一.Ambari简介 The Apache Ambari project is aimed at making Hadoop management simpler by developing soft ...

- 大数据系列之数据仓库Hive安装

Hive系列博文,持续更新~~~ 大数据系列之数据仓库Hive原理 大数据系列之数据仓库Hive安装 大数据系列之数据仓库Hive中分区Partition如何使用 大数据系列之数据仓库Hive命令使用 ...

- 大数据系列(5)——Hadoop集群MYSQL的安装

前言 有一段时间没写文章了,最近事情挺多的,现在咱们回归正题,经过前面四篇文章的介绍,已经通过VMware安装了Hadoop的集群环境,相关的两款软件VSFTP和SecureCRT也已经正常安装了. ...

- 大数据系列(4)——Hadoop集群VSFTP和SecureCRT安装配置

前言 经过前三篇文章的介绍,已经通过VMware安装了Hadoop的集群环境,当然,我相信安装的过程肯定遇到或多或少的问题,这些都需要自己解决,解决的过程就是学习的过程,本篇的来介绍几个Hadoop环 ...

- 大数据系列(2)——Hadoop集群坏境CentOS安装

前言 前面我们主要分析了搭建Hadoop集群所需要准备的内容和一些提前规划好的项,本篇我们主要来分析如何安装CentOS操作系统,以及一些基础的设置,闲言少叙,我们进入本篇的正题. 技术准备 VMwa ...

- 12.Linux软件安装 (一步一步学习大数据系列之 Linux)

1.如何上传安装包到服务器 有三种方式: 1.1使用图形化工具,如: filezilla 如何使用FileZilla上传和下载文件 1.2使用 sftp 工具: 在 windows下使用CRT 软件 ...

- 大数据系列之数据仓库Hive命令使用及JDBC连接

Hive系列博文,持续更新~~~ 大数据系列之数据仓库Hive原理 大数据系列之数据仓库Hive安装 大数据系列之数据仓库Hive中分区Partition如何使用 大数据系列之数据仓库Hive命令使用 ...

- 大数据系列之数据仓库Hive原理

Hive系列博文,持续更新~~~ 大数据系列之数据仓库Hive原理 大数据系列之数据仓库Hive安装 大数据系列之数据仓库Hive中分区Partition如何使用 大数据系列之数据仓库Hive命令使用 ...

- 大数据系列之数据仓库Hive中分区Partition如何使用

Hive系列博文,持续更新~~~ 大数据系列之数据仓库Hive原理 大数据系列之数据仓库Hive安装 大数据系列之数据仓库Hive中分区Partition如何使用 大数据系列之数据仓库Hive命令使用 ...

随机推荐

- CentOS6.5安装wine

全程只有两个命令: $ yum install epel-release $ yum install wine 关于epel-release,说白了就是一个第三方软件源. 企业版 Linux 附加软件 ...

- sql 查找最后一条记录

1.通过row select * from tablewhere rownum<(select count(*)+1 from table)minusselect * from tablewhe ...

- DWZ主从表界面唯一性验证(后台验证)(三)

之前的博客介绍了前台自写js来验证主动表的唯一性,除了前台的验证,我也学习了后台的一些判断. 再次介绍一下背景需求: 利用DWZ的主从表结构批量添加课程信息,在提交表单后,触发Action事件 1.是 ...

- Deferred对象

摘要:虽然js已经出了ES6,ES7等等版本,从而也诞生了新的异步对象->promise,但是基础还是要终结的,这一片就来回顾一下ajax以及ajax的异步对象->deferred. 1. ...

- Linux安装rpc监控系统资源

1.rpc服务需rsh的支持,一般情况下rsh已安装.rpm -qa rsh查看. 2.右键另存为http://heanet.dl.sourceforge.net/sourceforge/rstatd ...

- Java编程思想学习笔记——接口

1.抽象类和抽象方法 抽象方法:不完整的,仅有声明而没有方法体. abstract void f(); 抽象类:包含抽象方法的类.(若一个类包含一个或多个抽象方法,则该类必须限定为抽象的.) 1.用抽 ...

- iview框架select默认选择一个option的值

给select加v-model,绑定的值为默认要显示的option的value值,展示的则为option的标签之间的内容,并且如果option的value是双引号,这里绑定的值也要双引号,否则不能正常 ...

- Spring IOC-ContextLoaderListener

[spring version : 4.1.6.RELEASE] 使用spring的项目中,一般都会在web.xml中配置ContextLoaderListener,它就是spring ioc 的入口 ...

- [AX2012]关于财务默认维度

和以前的版本一样,AX2012中很多地方都使用财务维度,比如客户.销售订单.销售订单行等,根据相应的财务维度设置,生成的相应财务分录将带有财务维度,方便后续对财务分录交易的分析.下图是在客户记录上设置 ...

- [AX]AX2012 R2 HR Jobs, Positions, Department和Workers

部门.作业(Job的官方翻译)和位置(Position的官方翻译)是AX人力资源管理的基本组织元素,Job和Position在AX有的地方又称作工作和职位,其实这个翻译更为恰当. Job定义的是一个工 ...