【hadoop】 hadoop 单机伪分布式安装

准备:

虚拟机(CentOS 6.9)

JDK1.8

hadoop2.8.0

一.JDK安装及配置

rpm -ivh jdkxxxx 安装

配置环境变量

vim /etc/profile

export JAVA_HOME=/usr/java/jdk1.8.0_121 export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

source /etc/profile 使其立即生效

java -version 验证

二. hadoop 下载安装

官网下载:http://hadoop.apache.org/releases.html ,下载 2.8.0 版本。

解压缩到 /opt/hadoop/下

此处用root 用户来操作hadoop(推荐用新添加用户来操作).

开始配置hadoop

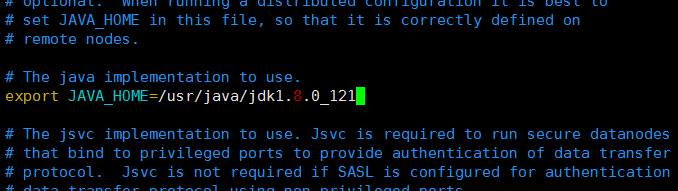

1. hadoop-env.sh

配置java

2. core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop/hadoop/data</value>

</property> <property>

<name>fs.default.name</name>

<value>hdfs://hadoop02:9000</value> </property>

</configuration>

3. hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property> <property>

<name>dfs.namenode.name.dir</name>

<value>file:/opt/hadoop/hadoop/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/opt/hadoop/hadoop/dfs/data</value>

</property>

</configuration>

4.mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

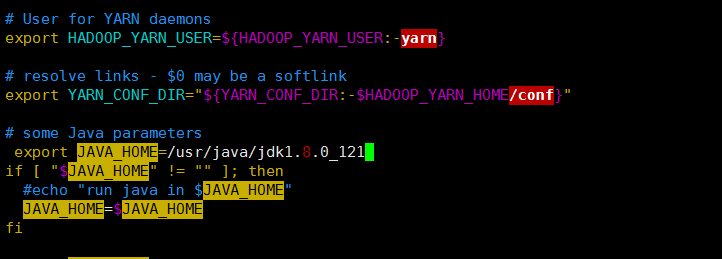

5.yarn-env.sh

修改java

6. yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

三.启动hadoop

执行 hdfs namenode -format

启动hadoop

start-all.sh

停止hadoop

stop-all.sh

四、验证

jps 查看

表示启动成功。

浏览器 输入 http://localhost:50070 查看hdfs 状态

查看yarn 信息 http://localhost:8088

各个配置的详细信息 参考官网:

【hadoop】 hadoop 单机伪分布式安装的更多相关文章

- 第5章 选举模式和ZooKeeper的集群安装 5-2 单机伪分布式安装zookeeper集群

先搭建伪分布式集群,再去搭建真分布式集群.有些的人的电脑内存.性能比较低,所以在搭建真实的一个分布式环境的话,可能会相对来说比较卡,所以两种都会做一下,首先会在单机上搭建一个集群.单机上的集群主要就是 ...

- hadoop+zookeeper+hbase伪分布式安装

基本安装步骤 安装包下载 从大数据组件下载地址下载以下组件安装包 hadoop-2.6.0-cdh5.6.0.tar.gz hbase-1.0.0-cdh5.6.0.tar.gz zookeeper- ...

- hadoop最简伪分布式安装

本次安装运行过程使用的是Ubuntu16.04 64位+Hadoop2.5.2+jdk1.7.0_75 Notice: Hadoop2.5.2版本默认只支持64位系统 使用的jdk可以为1.7和1.8 ...

- 转载:Hadoop安装教程_单机/伪分布式配置_Hadoop2.6.0/Ubuntu14.04

原文 http://www.powerxing.com/install-hadoop/ 当开始着手实践 Hadoop 时,安装 Hadoop 往往会成为新手的一道门槛.尽管安装其实很简单,书上有写到, ...

- Hadoop安装教程_单机/伪分布式配置_Hadoop2.6.0/Ubuntu14.04

摘自: http://www.cnblogs.com/kinglau/p/3796164.html http://www.powerxing.com/install-hadoop/ 当开始着手实践 H ...

- Hadoop安装教程_单机/伪分布式配置

环境 本教程使用 CentOS 6.4 32位 作为系统环境,请自行安装系统(可参考使用VirtualBox安装CentOS).如果用的是 Ubuntu 系统,请查看相应的 Ubuntu安装Hadoo ...

- Hadoop单机和伪分布式安装

本教程为单机版+伪分布式的Hadoop,安装过程写的有些简单,只作为笔记方便自己研究Hadoop用. 环境 操作系统 Centos 6.5_64bit 本机名称 hadoop001 本机IP ...

- Hadoop:Hadoop单机伪分布式的安装和配置

http://blog.csdn.net/pipisorry/article/details/51623195 因为lz的linux系统已经安装好了很多开发环境,可能下面的步骤有遗漏. 之前是在doc ...

- 新手推荐:Hadoop安装教程_单机/伪分布式配置_Hadoop-2.7.1/Ubuntu14.04

下述教程本人在最新版的-jre openjdk-7-jdk OpenJDK 默认的安装位置为: /usr/lib/jvm/java-7-openjdk-amd64 (32位系统则是 /usr/lib/ ...

随机推荐

- WCF安全:通过 扩展实现用户名密码认证

在webSservice时代,可以通过SOAPHEADER的方式很容易将用户名.密码附加到SOAP header消息头上,用户客户端对调用客户端身份的验证.在WCF 时代,也可以通过Operation ...

- hive中使用with as查询作为临时中间表

oracle.hive都存在with as的用法.用于将重复的查询结果复用. 今天做统计分析时用到,使用例子如下: 1. 直接查询 with tmp_a as ( select f1,f2,f3 fr ...

- hdfs平衡分布

这篇文章是从网上看到的,觉得很好就收藏了,但是最终不知道出处了. Hadoop的HDFS集群非常容易出现机器与机器之间磁盘利用率不平衡的情况,比如集群中添加新的数据节点.当HDFS出现不平衡状况的时候 ...

- 连接两个点云中的字段或数据形成新点云以及Opennni Grabber初识

(1)学习如何连接两个不同点云为一个点云,进行操作前要确保两个数据集中字段的类型相同和维度相等,同时了解如何连接两个不同点云的字段(例如颜色 法线)这种操作的强制约束条件是两个数据集中点的数目必须一样 ...

- Linux下 mkdir 命令详解

一次性地建立多级目录,则可以使用-p参数 # mkdir -p /home/dir1/dir2/dir3

- Java设计模式(10)代理模式(Proxy模式)

理解并使用设计模式,能够培养我们良好的面向对象编程习惯,同时在实际应用中,可以如鱼得水,享受游刃有余的乐趣. Proxy是比较有用途的一种模式,而且变种较多,应用场合覆盖从小结构到整个系统的大结构,P ...

- Rscripts的使用,以及如何为R脚本传参数

一.在windows下使用Rscript: 1.进入cmd.exe下,将当前工作目录转到Rscript.exe所在目录下面,然后调用Rscript **.R文件即可.但是所调用的.R文件必须是在R的 ...

- [hbase] 查询数据

获取hbase数据 说说:count 'SOCIA:T_SOCIA_ALBUM_TALK'scan 'SOCIA:T_SOCIA_ALBUM_TALK',{LIMIT=>5}get 'SOCIA ...

- html常用对照表

常用对照表:http://tool.oschina.net/commons

- 第10章:awk进阶操作

第10章:awk进阶操作 在第4章:查找与替换简单的讲解了awk的使用,本章介绍详细讲解awk的使用.awk是一个强大的文本分析工具,简单的说awk就是把文件逐行的读入, 以空格为默认分隔符将每行切片 ...