Kafaka高可用集群环境搭建

zk集群环境搭建:https://www.cnblogs.com/toov5/p/9897868.html

三台主机每台的Java版本1.8

下面kafka集群的搭建:

3台虚拟机均进行以下操作:

// 解压下载好的kafka压缩包并重命名

cd /home

wget http://mirror.bit.edu.cn/apache/kafka/1.1.1/kafka_2.11-1.1.1.tgz

tar -xzvf kafka_2.11-1.1.1.tgz

mv kafka_2.11-1.1.1 kafka

// 修改配置文件

vi ./kafka/config/server.properties

修改如下:

主机1的:(其他主机类似)

broker.id=0 #做标记的哦 其他的主机 1 2 与Zookeeper的data目录下的myId一致!

listeners=PLAINTEXT://192.168.91.1:9092 #监听的IP地址和端口号 这其实是个协议 要写全! 监听的本机的ip端口号哈 其他的主机ip地址更改

zookeeper.connect=192.168.91.1:2181,192.168.91.3:2181,192.168.91.4:2181 #zk的集群地址

然后修改系统环境中配置kafka的路径

vi /etc/profile

// 在文件最下方添加kafka路径

export KAFKA_HOME=/home/kafaka/kafka

// PATH的修改 多路径PATH写法为PATH=${ZOOKEEPER_HOME}/bin:${KAFKA_HOME}/bin:$PATH

$PATH:${KAFKA_HOME}/bin

我的配置后:

export PATH=$PATH:${KAFKA_HOME}/bin:$JAVA_HOME/bin:$ZOOKEEPER_HOME/bin:$PATH

// 使修改完的环境变量生效

source /etc/profile

此时 其他的两台

scp -r ./kafaka/ root@192.168.91.3:/home

scp -r ./kafaka/ root@192.168.91.4:/home

然后分别修改server.properties

broker.id=X #做标记的哦 其他的主机 X =1 和 2

listeners=PLAINTEXT://192.168.91.X:9092 #监听的IP地址和端口号 这其实是个协议 要写全! 监听的本机的ip端口号哈 其他的主机ip地址更改

,修改 /etc/profile 与第一台一致

此时的环境便搭建完毕!

先启动Zookeeper集群,

逐个主机启动: /home/zookeeper/zookeeper-3.4.6/bin/zkServer.sh start

查看启动状态: /home/zookeeper/zookeeper-3.4.6/bin/zkServer.sh status

再启动kafka集群

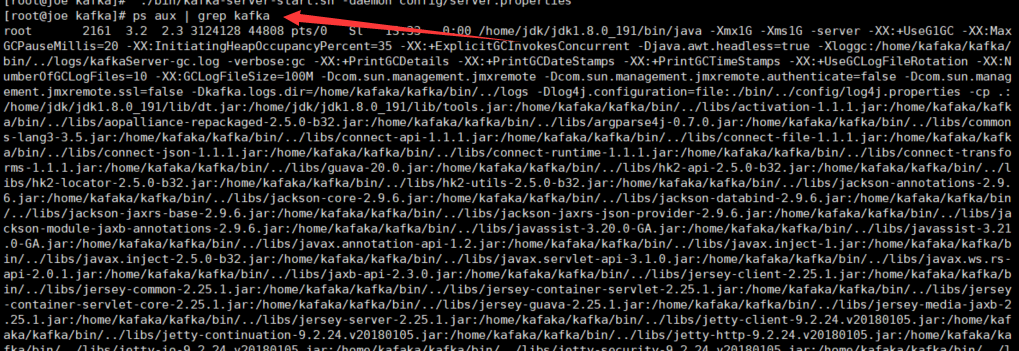

2、在后台开启3台虚拟机的kafka程序

/home/kafaka/kafka

./bin/kafka-server-start.sh -daemon config/server.properties

启动成功!

注意每个服务器要关闭防火墙!!

Kafka 没有后台图形化 不跟rabbitmq似的哈哈

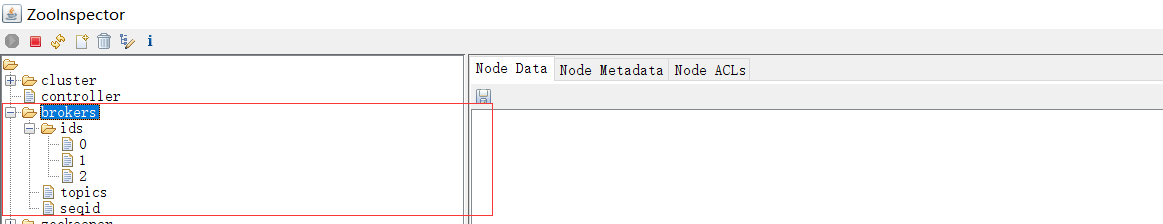

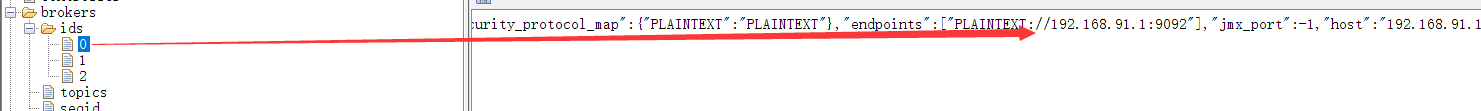

查看Zookeeper:

每个broker启动后 会去zk注册信息,创建节点信息

下面创建个topic试试:

参考官网:http://kafka.apachecn.org/quickstart.html

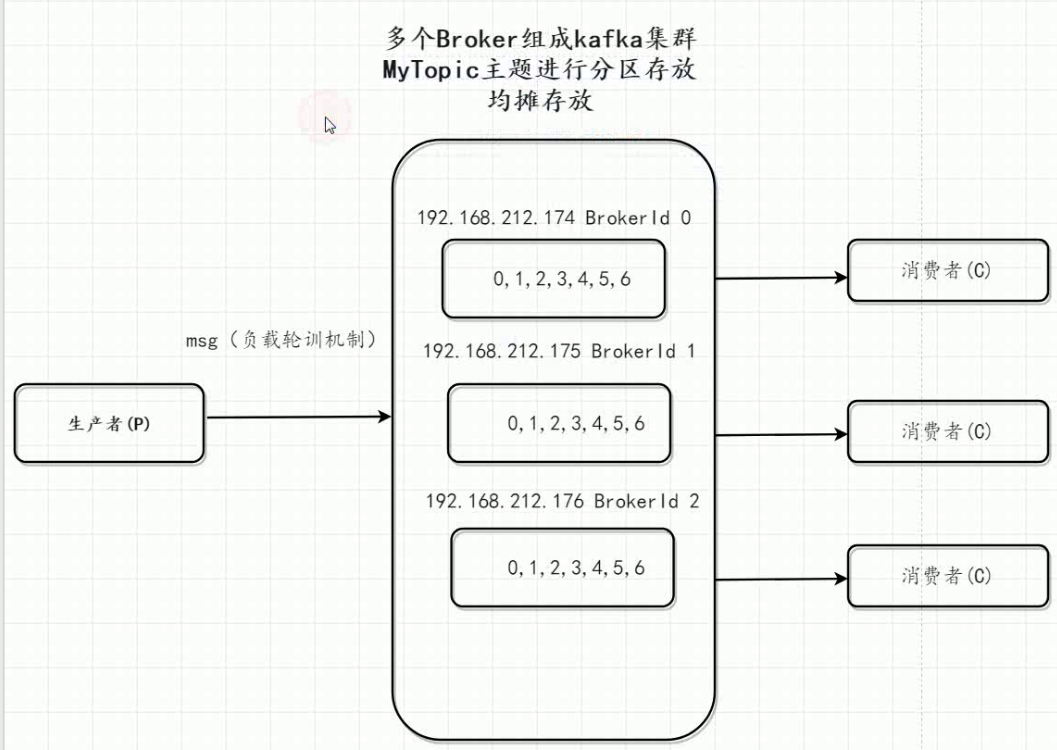

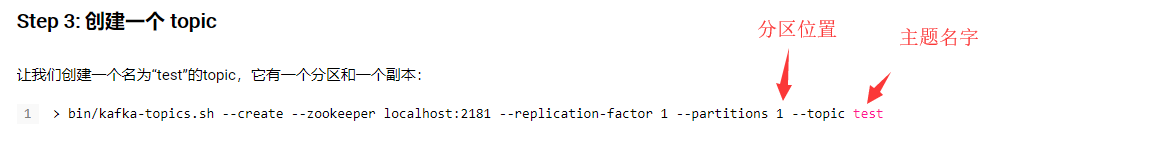

创建topic时候 需要指定分区partition 1 表示只在一个broker里面存放。(单节点存放)

3 表示三个broker里面存放 。生产者投递消息时候 均摊存放!

只会在1个broker进行创建

在某一台服务器上创建 topic:

/home/kafaka/kafka/bin/kafka-topics.sh --create --zookeeper 192.168.91.1:2181 --replication-factor 1 --partitions 1 --topic test # 创建topic时候 会向zk进行连接 1表示在单机上存储创建

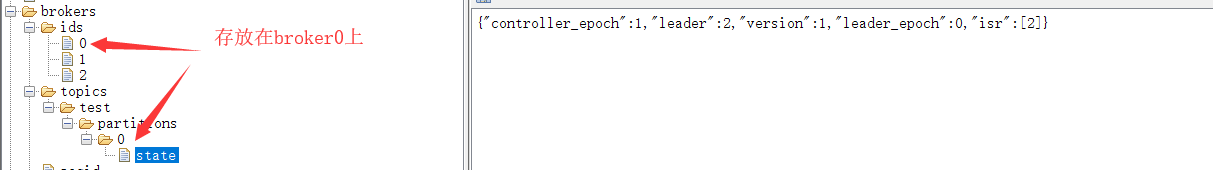

zk查看:

broker就是我们指定的这台服务器上 partition是1 的话每次都投递到 0这个broker上哦

下面介绍下日志查看:

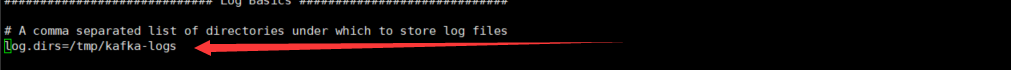

kafka的日志存放是在配置中的 server.properties:

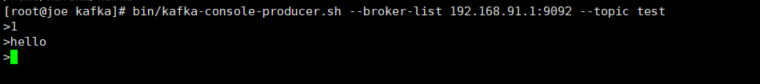

创新topic后发送消息

往指定的broker发送消息

bin/kafka-console-producer.sh --broker-list 192.168.91.1:9092 --topic test

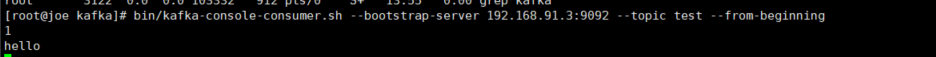

启动consumer进行消费:连接的不是同一台主机,也可以进行消费

bin/kafka-console-consumer.sh --bootstrap-server 192.168.91.3:9092 --topic test --from-beginning

同是一个集群。互通的 ,只是消息存放的地方有别而已。

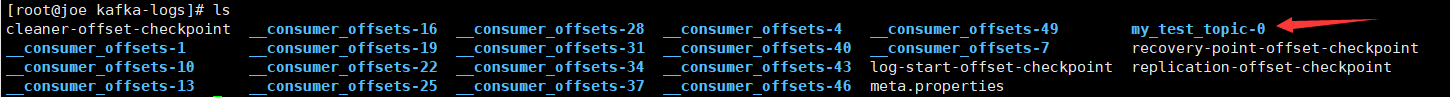

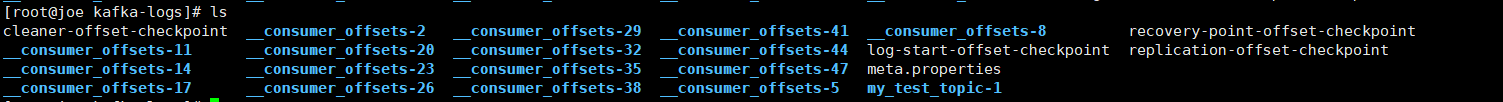

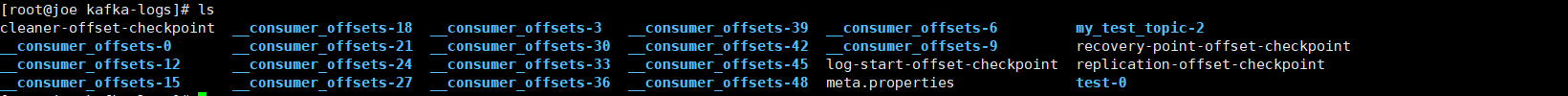

继续创建topic,存放到三个broker:

/home/kafaka/kafka/bin/kafka-topics.sh --create --zookeeper 192.168.91.1:2181 --replication-factor 1 --partitions 3 --topic my_test_topic

创建成功后查看日志目录:

broker0

broker1

broker2

通过test-0 my_test_topic_x 可以看出编号是有自己的算法的

得出的结论是 topic 在三台不同的节点进行存放的,生产者投递消费进行均摊。

Kafaka高可用集群环境搭建的更多相关文章

- ElasticSearch高可用集群环境搭建和分片原理

1.ES是如何实现分布式高并发全文检索 2.简单介绍ES分片Shards分片技术 3.为什么ES主分片对应的备分片不在同一台节点存放 4.索引的主分片定义好后为什么不能做修改 5.ES如何实现高可用容 ...

- SpringCloud之Eureka高可用集群环境搭建

注册中心集群 在微服务中,注册中心非常核心,可以实现服务治理,如果一旦注册出现故障的时候,可能会导致整个微服务无法访问,在这时候就需要对注册中心实现高可用集群模式. Eureka集群相当简单:相互注册 ...

- rabbitmq+haproxy+keepalived高可用集群环境搭建

1.先安装centos扩展源: # yum -y install epel-release 2.安装erlang运行环境以及rabbitmq # yum install erlang ... # yu ...

- CentOS下RabbitMq高可用集群环境搭建

准备工作 1,准备两台或多台安装有rabbitmq-server服务的服务器 我这里准备了两台,分别如下: 192.168.40.130 rabbitmq01192.168.40.131 rabbit ...

- Mysql高可用集群环境介绍

MySQL高可用集群环境搭建 01.MySQL高可用环境方案 02.MySQL主从复制原理 03.MySQL主从复制作用 04.在Linux环境上安装MySQL 05.在MySQL集群环境上配置主从复 ...

- Apache httpd和JBoss构建高可用集群环境

1. 前言 集群是指把不同的服务器集中在一起,组成一个服务器集合,这个集合给客户端提供一个虚拟的平台,使客户端在不知道服务器集合结构的情况下对这一服务器集合进行部署应用.获取服务等操作.集群是企业应用 ...

- Flink的高可用集群环境

Flink的高可用集群环境 Flink简介 Flink核心是一个流式的数据流执行引擎,其针对数据流的分布式计算提供了数据分布,数据通信以及容错机制等功能. 因现在主要Flink这一块做先关方面的学习, ...

- centos HA高可用集群 heartbeat搭建 heartbeat测试 主上停止heartbeat服务 测试脑裂 两边都禁用ping仲裁 第三十二节课

centos HA高可用集群 heartbeat搭建 heartbeat测试 主上停止heartbeat服务 测试脑裂 两边都禁用ping仲裁 第三十二节课 heartbeat是Linu ...

- Mysql双主双从高可用集群的搭建且与MyCat进行整合

1.概述 老话说的好:瞻前顾后.患得患失只会让我们失败,下定决心,干就完了. 言归正传,之前我们聊了Mysql的一主一从读写分离集群的搭建,虽然一主一从或一主多从集群解决了并发读的问题,但由于主节点只 ...

随机推荐

- PowerDesigner 建模后如何导入到数据库

from:https://jingyan.baidu.com/article/7f766daf465e9c4101e1d0d5.html 大家都知道PowerDesigner是一个数据库建模工具,但是 ...

- 关于 js 动态生成html 绑定事件失效的问题

在实际问题中,也只到使用新版jq 的on 事件 进行动态元素的绑定: 是这样 (但是依然没有效果——): $('dom节点').on('click',function(){}) 之后经过查阅发现:正确 ...

- Android无线测试之—UiAutomator UiDevice API介绍三

获取坐标与坐标点击 一.坐标相关的知识: 1)手机屏幕坐标:左上角开始到右下角结束 2)DP:设备独立像素,例如320像素显示到640像素上要拉伸一倍 3)Point:代表一个点(x,y),左上角的坐 ...

- Android开发:《Gradle Recipes for Android》阅读笔记(翻译)2.5——在项目中共享配置

问题: 取出多个模块下相同的配置 解决方案: 在顶级gradle配置文件里面使用allprojects或者subprojects块 讨论: 当你在android studio中新建android项目时 ...

- 1060 最复杂的数(反素数玄学dfs)

1060 最复杂的数 题目来源: Ural 1748 基准时间限制:1 秒 空间限制:131072 KB 分值: 40 难度:4级算法题 把一个数的约数个数定义为该数的复杂程度,给出一个n,求1-n中 ...

- 修改已生成项目app名称

在搜索里添加product Name,然后修改成你需要的app名称 修改完后可能会报错误如下 原因是test的测试路径发生了变化,其实如果不修改Test host的路径保留原来的重命名之前的app也是 ...

- Wireshark网络分析工具(二)

一.TCP三次握手过称 1. 第一次握手的数据包 客户端发送一个TCP,标志位为SYN,序列号为0, 代表客户端请求建立连接. 如下图: 2. 第二次握手的数据包 服务器发回确认包, 标志位为 SYN ...

- MongoDB学习笔记—概念解析

Mongo基本概念 下表将帮助您更容易理解Mongo中的一些概念: SQL术语/概念 MongoDB术语/概念 解释/说明 database database 数据库 table collection ...

- cut命令学习

cut最基本的用法: -f 列号:提取第几列 -d 分隔符:按照指定分隔符分割列(默认是制表符tab) 测试用例:(制表符)

- 'substring(from:)' is deprecated: Please use String slicing subscript with a 'partial range from' operator.

let newStr = String(str[..<index]) // = str.substring(to: index) In Swift 3 let newStr = String(s ...