零基础Python爬虫实现(百度贴吧)

提示:本学习来自Ehco前辈的文章, 经过实现得出的笔记。

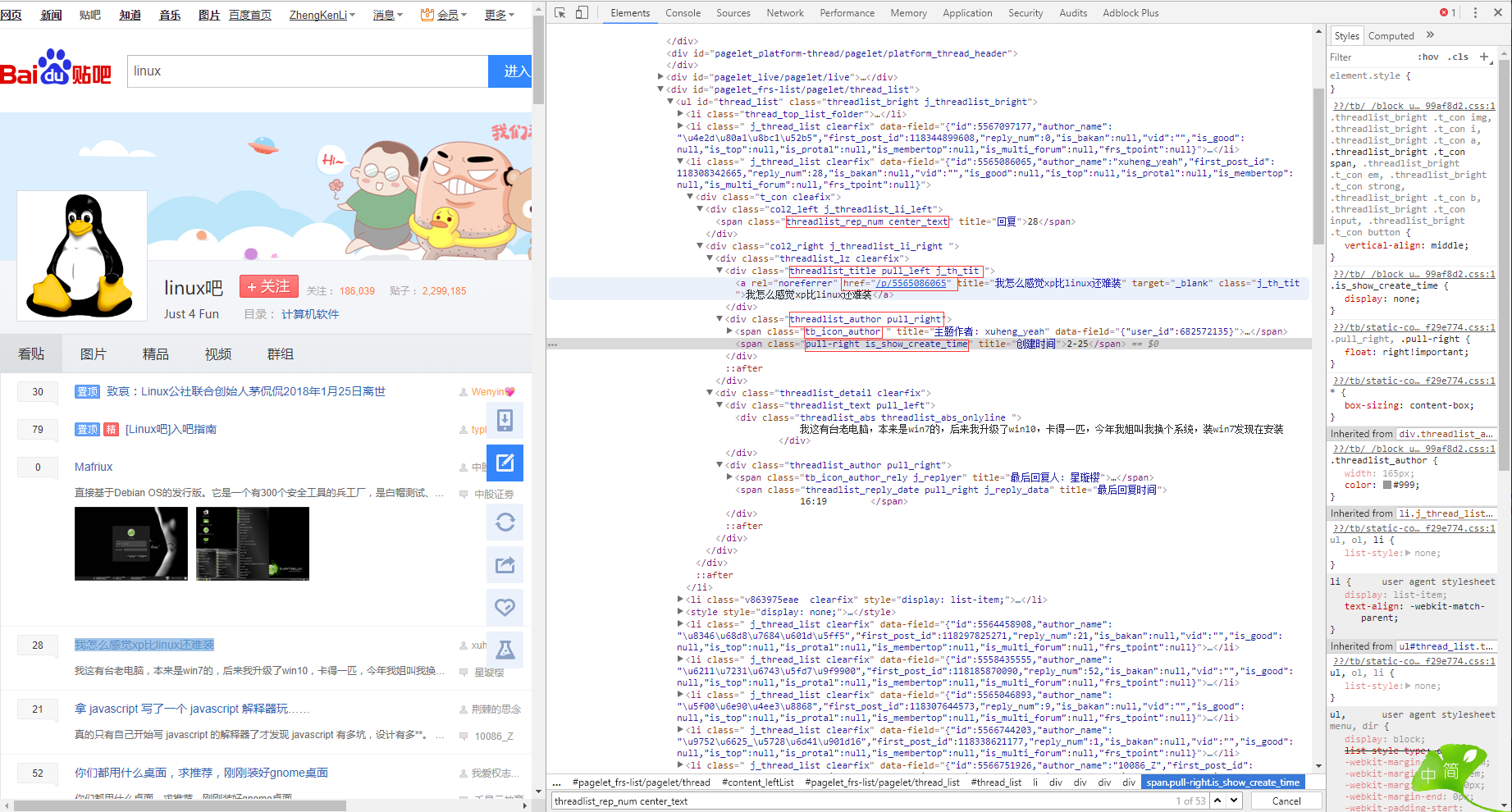

目标

http://tieba.baidu.com/f?kw=linux&ie=utf-8

网站结构

学习目标

由于是第一个实验性质爬虫,我们要做的不多,我们需要做的就是: 1. 从网上爬下特定页码的网页

2. 对于爬下的页面内容进行简单的筛选分析

3. 找到每一篇帖子的 标题、发帖人、日期、楼层、以及跳转链接

4. 将结果保存到文本。

发现规律

&pn=0 : 首页

&pn=50: 第二页

&pn=100:第三页

&pn=50*n 第n页

50 表示 每一页都有50篇帖子。

这样就能实现翻页操作

附上代码

import requests

import time from bs4 import BeautifulSoup def get_html(url):

try:

r = requests.get(url, timeout=30)

r.raise_for_status() r.encoding = 'utf-8'

return r.text

except:

return "error" def get_content(url):

comments = []

html = get_html(url) soup = BeautifulSoup(html, 'lxml')

liTags = soup.find_all('li', attrs={'class':' j_thread_list clearfix'}) for li in liTags:

comment = {}

try:

#标题

comment['title'] = li.find(

'a', attrs={'class':'j_th_tit '}).text.strip()

#链接

comment['link'] = "http://tieba.baidu.com/" + \

li.find('a', attrs={'class' : 'j_th_tit'})['href']

#发帖人

comment['name'] = li.find(

'span', attrs = {'class':'tb_icon_author '}

).text.strip()

#发帖时间

comment['time'] = li.find(

'span', attrs={'class':'pull-right is_show_create_time'}

).text.strip()

#回复数量

comment['replyNum'] = li.find(

'span', attrs={'class':'threadlist_rep_num center_text'}

).text.strip()

comments.append(comment)

except:

print("出了点小问题")

return comments def Out2File(dict):

with open('TTBT.txt', 'a+') as f:

for comment in dict:

f.write('标题: {} \t 连接: {} \t 发帖人: {} \t 发帖时间: {} \t 回复数量: {} \n'.format(

comment['title'], comment['link'], comment['name'], comment['time'], comment['replyNum']

))

print("当前页面爬取完成") def main(base_url, deep):

url_list = []

for i in range(0, deep):

url_list.append(base_url + '&pn' + str(50 * i))

print("所有的网页已经下载到本地! 开始筛选信息") for url in url_list:

content = get_content(url)

Out2File(content)

print("所有的信息都已经保存完毕") base_url = 'http://tieba.baidu.com/f?kw=linux&ie=utf-8'

deep = 3 if __name__ == '__main__':

main(base_url, deep)

结果

零基础Python爬虫实现(百度贴吧)的更多相关文章

- 零基础Python爬虫实现(爬取最新电影排行)

提示:本学习来自Ehco前辈的文章, 经过实现得出的笔记. 目标网站 http://dianying.2345.com/top/ 网站结构 要爬的部分,在ul标签下(包括li标签), 大致来说迭代li ...

- 嵩天老师的零基础Python笔记:https://www.bilibili.com/video/av15123607/?from=search&seid=10211084839195730432#page=25 中的42-45讲 {字典}

#coding=gbk#嵩天老师的零基础Python笔记:https://www.bilibili.com/video/av15123607/?from=search&seid=1021108 ...

- 嵩天老师的零基础Python笔记:https://www.bilibili.com/video/av13570243/?from=search&seid=15873837810484552531 中的15-23讲

#coding=gbk#嵩天老师的零基础Python笔记:https://www.bilibili.com/video/av13570243/?from=search&seid=1587383 ...

- 嵩天老师的零基础Python笔记:https://www.bilibili.com/video/av13570243/?from=search&seid=15873837810484552531 中的1-14讲

#coding=gbk#嵩天老师的零基础Python笔记:https://www.bilibili.com/video/av13570243/?from=search&seid=1587383 ...

- 零基础Python应该怎样学习呢?(附视频教程)

Python应该怎样学习呢? 阶段一:适合自己的学习方式 对于零基础的初学者来说,最迷茫的是不知道怎样开始学习?那这里小编建议可以采用视频+书籍的方式进行学习.看视频学习可以让你迅速掌握编程的基础语法 ...

- 如何用Python爬虫实现百度图片自动下载?

Github:https://github.com/nnngu/LearningNotes 制作爬虫的步骤 制作一个爬虫一般分以下几个步骤: 分析需求 分析网页源代码,配合开发者工具 编写正则表达式或 ...

- python爬虫获取百度图片(没有精华,只为娱乐)

python3.7,爬虫技术,获取百度图片资源,msg为查询内容,cnt为查询的页数,大家快点来爬起来.注:现在只能爬取到百度的小图片,以后有大图片的方法,我会陆续发贴. #!/usr/bin/env ...

- 【学习笔记】第二章 python安全编程基础---python爬虫基础(urllib)

一.爬虫基础 1.爬虫概念 网络爬虫(又称为网页蜘蛛),是一种按照一定的规则,自动地抓取万维网信息的程序或脚本.用爬虫最大的好出是批量且自动化得获取和处理信息.对于宏观或微观的情况都可以多一个侧面去了 ...

- 零基础Python接口测试教程

目录 一.Python基础 Python简介.环境搭建及包管理 Python基本语法 基本数据类型(6种) 条件/循环 文件读写(文本文件) 函数/类 模块/包 常见算法 二.接口测试快速实践 简单接 ...

随机推荐

- android逆向四则运算

不断更新 除法: ; bRet = a/b+; return bRet; .text:00001010 a = R0 ; int.text:00001010 b = R1 ; int.text:000 ...

- java基础(二) -对象和类

Java 对象和类 Java作为一种面向对象语言.支持以下基本概念: 多态 继承 封装 抽象 类 对象 实例 方法 重载 对象:对象是类的一个实例(对象不是找个女朋友),有状态和行为.例如,一条狗是一 ...

- Selenium基本使用(十三)测试中常见问题

我们在使用selenium测试过程中,经常会遇到这样的问题: 1.frame或iframe <iframe id='frame1' name='frame1'> <input typ ...

- DataGrip设置长sql语句自动换行

我这个DataGrip是英文版的. 在每个查询窗口(Console)的工具图标里,有个Settings.打开Settings弹出框,试图从Appearance和Editor里找到设置选项,却没有找到. ...

- Thinkphp 3.2 验证码图片显示错误解决方法

在调用验证码之前加上 ob_clean(); 不显示验证码的代码: public function verify(){ $verify = new \Think\Verify(); $verify-& ...

- react native 中使用swiper

1.下载依赖 cnpm install react-native-swiper --save 2.在组件中使用 import React, { Component } from 'react'; im ...

- 笔记 : windows系统下 命令行 php --version 的版本与phpinfo()版本不一致问题

第一 : php --version命令cmd不随wamp中php版本改变而改变的, php命令是随着wamp安装时将:wamp/bin/php/php5.6.25[版本]自动或手动添加到环境变量, ...

- 安装Esxi 6.5

最详细安装Esxi 6.5 Exsi 是一款虚拟化系统,与VMware,VirtualBox不同,它不需要安装在其他操作系统上,直接运行在裸机上:占用系统资源很小,易于管理,所以被大多数中小型 ...

- jar包的读取

昨天在做项目插件的时候,因为会用到jar包中的一个文件来初始化程序.并且以后还是会访问这个文件,所以就想到干脆吧文件拷贝到指定目录.在拷贝的时候也费了好一会时间,这里涉及到了jar文件的操作,在这里记 ...

- FSDB Dumper

FSDB:Fast Signal Database 相比较于VCD文件,FSDB文件的大小比VCD波形小5-50倍. 各家的仿真器都支持在simulation的过程中,直接生成FSDB文件 将VCD文 ...