hadoop运行原理之Job运行(一) JobTracker启动及初始化

这部分的计划是这样的,首先解释JobTracker的启动过程和作业从JobClient提交到JobTracker上;然后分析TaskTracker和heartbeat;最后将整个流程debug一遍来加深映象。

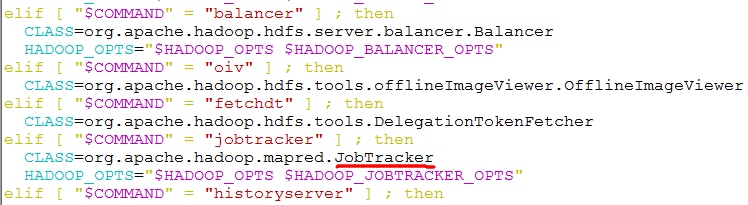

在看JobTracker源代码的时候就会发现,它里边有main()方法,这就说明了它是一个独立的java进程。在hadoop根目录下的bin文件夹中的hadoop脚本中可以看到,它指定了JobTracker类。如下图所示:

JobTracker的main()方法中最主要的是以下两条语句:

public static void main(String argv[]

) throws IOException, InterruptedException {

StringUtils.startupShutdownMessage(JobTracker.class, argv, LOG); try {

if(argv.length == 0) {

JobTracker tracker = startTracker(new JobConf());//用来生成JobTracker对象

tracker.offerService();//初始化JobTracker,并启动作业调度器

}

else {

if ("-dumpConfiguration".equals(argv[0]) && argv.length == 1) {

dumpConfiguration(new PrintWriter(System.out));

}

else {

System.out.println("usage: JobTracker [-dumpConfiguration]");

System.exit(-1);

}

}

} catch (Throwable e) {

LOG.fatal(StringUtils.stringifyException(e));

System.exit(-1);

}

}

startTracker()方法比较简单,通过几次方法调用最终生成JobTracker对象。下面重点分析offerService()方法。由于篇幅限制,只列出了最重要的部分:

public void offerService() throws InterruptedException, IOException {

......

// Initialize the JobTracker FileSystem within safemode

setSafeModeInternal(SafeModeAction.SAFEMODE_ENTER);

initializeFilesystem();

setSafeModeInternal(SafeModeAction.SAFEMODE_LEAVE);

// Initialize JobTracker

initialize();

......

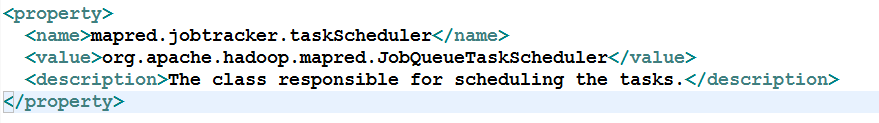

taskScheduler.start();

首先进入安全模式下(SAFEMODE_ENTER),初始化文件系统,然后退出安全模式(SAFEMODE_LEAVE)。然后初始化JobTracker。最后启动作业调度器(TaskScheduler)。默认的作业调度器是JobQueueTaskScheduler,在mapred-default.xml中配置。所以taskScheduler.start()会调用JobQueueTaskScheduler的start()方法。如下所示:

JobQueueTaskScheduler使用FIFO来对job进行调度。下面来进入到JobQueueTaskScheduler来分析start()方法。

@Override

public synchronized void start() throws IOException {

super.start();

taskTrackerManager.addJobInProgressListener(jobQueueJobInProgressListener);

eagerTaskInitializationListener.setTaskTrackerManager(taskTrackerManager);

eagerTaskInitializationListener.start();

taskTrackerManager.addJobInProgressListener(

eagerTaskInitializationListener);

}

这里用到了观察者模式,JobQueueTaskScheduler向JobTracker注册了两个JobInProgressListener:EagerTaskInitializationListener和JobQueueJobInProgressListener,分别用于作业初始化和作业排序。

这里的taskTrackerManager实际上是JobTracker,因为JobTracker的父类就是TaskTrackerManager。在JobTracker的startTracker()方法中,将JobTracker实例传递给TaskTrackerManager。如下所示:

public static JobTracker startTracker(JobConf conf, String identifier, boolean initialize)

throws IOException, InterruptedException {

DefaultMetricsSystem.initialize("JobTracker");

JobTracker result = null;

while (true) {

try {

result = new JobTracker(conf, identifier);

result.taskScheduler.setTaskTrackerManager(result);

......

在eagerTaskInitializationListener.start()方法启动一个线程JobInitManager,这个线程用来监控jobInitQueue,即List<JobInProgress>。当有新的job(JobInProgress)加入到队列中时,JobInitManager线程就对其进行初始化。

class JobInitManager implements Runnable {

public void run() {

JobInProgress job = null;

while (true) {

try {

synchronized (jobInitQueue) {

while (jobInitQueue.isEmpty()) {

jobInitQueue.wait();

}

job = jobInitQueue.remove(0); //从队列中拿出一个job

}

threadPool.execute(new InitJob(job)); //对job进行初始化

} catch (InterruptedException t) {

LOG.info("JobInitManagerThread interrupted.");

break;

}

}

LOG.info("Shutting down thread pool");

threadPool.shutdownNow();

}

}

class InitJob implements Runnable {

private JobInProgress job;

public InitJob(JobInProgress job) {

this.job = job;

}

public void run() {

ttm.initJob(job); //实质上调用JobTracker的initJob()方法进行初始化

}

}

这里JobInitManager线程最终调用了JobTracker的initJob()方法来对job进行初始化。具体过程下篇文章中再写。

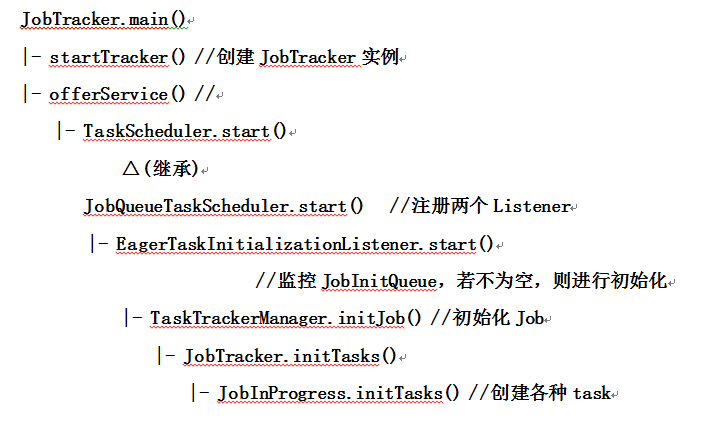

最后画个流程图来总结一下,画的不好,将就看一下吧。

本文基于hadoop1.2.1

如有错误,还请指正

参考文章:《Hadoop技术内幕 深入理解MapReduce架构设计与实现原理》 董西成

转载请注明出处:http://www.cnblogs.com/gwgyk/p/3998753.html

hadoop运行原理之Job运行(一) JobTracker启动及初始化的更多相关文章

- hadoop运行原理之Job运行(二) Job提交及初始化

本篇主要介绍Job从客户端提交到JobTracker及其被初始化的过程. 以WordCount为例,以前的程序都是通过JobClient.runJob()方法来提交Job,但是现在大多用Job.wai ...

- hadoop运行原理之Job运行(三) TaskTracker的启动及初始化

与JobTracker一样,TaskTracker也有main()方法,然后以线程的方式启动(继承了Runnable接口).main()方法中主要包含两步:一是创建一个TaskTracker对象:二是 ...

- hadoop运行原理之Job运行(四) JobTracker端心跳机制分析

接着上篇来说,TaskTracker端的transmitHeartBeat()方法通过RPC调用JobTracker端的heartbeat()方法来接收心跳并返回心跳应答.还是先看看这张图,对它的大概 ...

- hadoop运行原理之Job运行(五) 任务调度

接着上篇来说.hadoop首先调度辅助型task(job-cleanup task.task-cleanup task和job-setup task),这是由JobTracker来完成的:但对于计算型 ...

- html、JSP运行原理

HTML运行原理 1.本地运行 所谓本地运行就是直接用 浏览器打开 2.远程访问的原理示意图: 何为协议?计算机互相通信(网络)的规则.常见的协议有 http .smtp. ftp.pop等 ...

- jmeter的运行原理和测试计划要素

jmeter运行原理 1.jmeter运行在JVM虚拟机上,jmeter是以线程的方式运行的. 2.jmeter通过线程组来驱动多个线程,运行测试脚本对被测试服务器发起负载,每一个负载机上够可以运行多 ...

- Python+Appium运行简单的demo,你需要理解Appium运行原理!

坚持原创输出,点击蓝字关注我吧 作者:清菡 博客:oschina.云+社区.知乎等各大平台都有. 目录 一.Appium 的理念 四个原则 1.Web-Selenium 的运行原理 2.Appium ...

- Hadoop基础-Hdfs各个组件的运行原理介绍

Hadoop基础-Hdfs各个组件的运行原理介绍 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.NameNode工作原理(默认端口号:50070) 1>.什么是NameN ...

- Hadoop(六)之HDFS的存储原理(运行原理)

前言 其实说到HDFS的存储原理,无非就是读操作和写操作,那接下来我们详细的看一下HDFS是怎么实现读写操作的! 一.HDFS读取过程 1)客户端通过调用FileSystem对象的open()来读取希 ...

随机推荐

- MVC5关联表读取相关表数据

SchoolName = db.Sys_Company.Find(gr.SchoolCode).FullName 只需Model中指定好SchoolCode是Sys_Company的主键就行了!

- javascript中的自增与自减

一直都对自增与自减的执行顺序有点糊涂,今天查了资料,来总结一下 a++(a--),就是指当时计算a,当下一次使用这个变量的时候才执行++或者-- ++a(--a),就是指当时就计算++或者-- 例1: ...

- Openstack安全规则说明

openstack的安全规则,主要是在网络控制器,nova-network中进行的端口限制,所以我们需要对规则进行定制. 定制通用安全组规则 通用安全组规则主要包括2个,1是支持ping的icmp协议 ...

- 简单破解.net(C#)程序

一直在用makedown2(free版),每当打开多个页面,就会提示升级为pro,还要注册码激活什么的.就有了破解的想法.以前也弄过一个小程序的破解,所以还算有些经验. 1. ildasm 用来将ma ...

- javascript,jQuery,trim()

JavaScript trim() Syntax string.trim() The trim() method removes whitespace from both sides of a str ...

- 欲实施CRM软件,必须先懂什么是CRM软件

CRM是Customer Relationship Management(客户关系管理)的缩写,它是利用信息科学技术,实现市场营销.销售.服务等活动自动化,使企业能更高效地为客户提供满意.周到的服务, ...

- 使用Android studio 出现的问题解决

问题一.安装过程中出现的报错Failed to install Intel HAXM 解决:重启电脑,启动BIOS,我的是惠普的,开机时按F10就进去了 切换到Configuration选项,将设置I ...

- Java在Web开发语言上败给了PHP

PHP的主要语言开发者之一.Zend公司的创始人之一Andi Gutmans最近在blog中直言不讳地批评了Java语言.他指出,目前Java厂商试图在JVM上提供动态语言实现的路子根本不对,Java ...

- Python学习笔记-常用模块

1.python模块 如果你退出 Python 解释器并重新进入,你做的任何定义(变量和方法)都会丢失.因此,如果你想要编写一些更大的程序,为准备解释器输入使用一个文本编辑器会更好,并以那个文件替代作 ...

- manacher浅析

manacher算法的输入是一个字符串,可以计算出以每个字符为中心的最长回文子串的半径.为了避免讨论奇数偶数,将原串的每两个字母之间以及前后各加一个特殊字母,比如'#',那么对于abcbb就变成了 # ...