039.集群网络-Pod和SVC网络实践

一 Pod和SVC网络

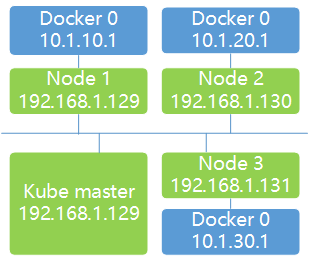

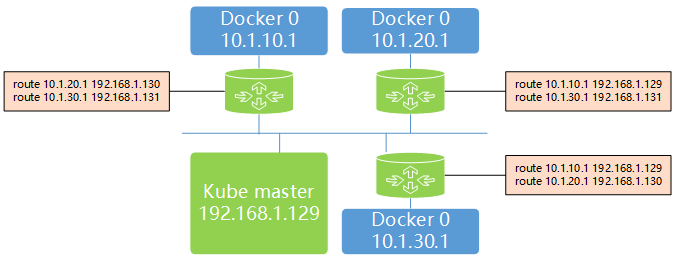

1.1 实践准备及原理

二 Pod和SVC实验

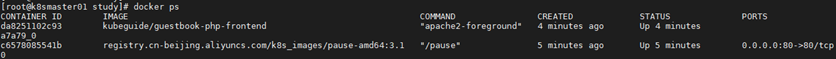

2.1 检查环境

2.2 创建RC

1 apiVersion: v1

2 kind: ReplicationController

3 metadata:

4 name: frontend

5 labels:

6 name: frontend

7 spec:

8 replicas: 1

9 selector:

10 name: frontend

11 template:

12 metadata:

13 labels:

14 name: frontend

15 spec:

16 containers:

17 - name: php-redis

18 image: kubeguide/guestbook-php-frontend

19 env:

20 - name: GET_HOSTS_FROM

21 value: env

22 ports:

23 - containerPort: 80

24 hostPort: 80

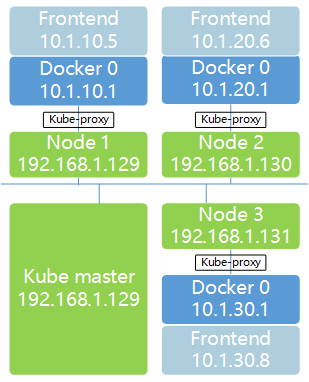

2.3 再次检查网络

2.4 网络模型释义

2.5 发布SVC

1 apiVersion: v1

2 kind: Service

3 metadata:

4 name: frontend

5 labels:

6 name: frontend

7 spec:

8 ports:

9 - port: 80

10 selector:

11 name: frontend

2.6 确认验证

039.集群网络-Pod和SVC网络实践的更多相关文章

- 【K8S】K8S-网络模型、POD/RC/SVC YAML 语法官方文档

K8S-网络模型.POD/RC/SVC YAML 语法官方文档 Kubernetes - Production-Grade Container Orchestration kubernetes/kub ...

- 036.集群网络-K8S网络模型及Linux基础网络

一 Kubernetes网络模型概述 1.1 Kubernetes网络模型 Kubernetes网络模型设计的一个基础原则是:每个Pod都拥有一个独立的IP地址,并假定所有Pod都在一个可以直接连通的 ...

- [k8s]kube-router替代kube-proxy实现svc网络和pod网络

本文讲解了kube-router部署,无需在部署kube-proxy了. kube-router采用lvs实现svc网络,采用bgp实现pod网络. kube-router也是基于cni网络,本文是容 ...

- K8s 从懵圈到熟练 – 集群网络详解

作者 | 声东 阿里云售后技术专家 导读:阿里云 K8S 集群网络目前有两种方案:一种是 flannel 方案:另外一种是基于 calico 和弹性网卡 eni 的 terway 方案.Terway ...

- Kubernetes 从懵圈到熟练 – 集群网络详解(转)

阿里云K8S集群网络目前有两种方案,一种是flannel方案,另外一种是基于calico和弹性网卡eni的terway方案.Terway和flannel类似,不同的地方在于,terway支持Pod弹性 ...

- 灵雀云Kube-OVN:基于OVN的开源Kubernetes网络实践

近日,灵雀云发布了基于OVN的Kubernetes网络组件Kube-OVN,并正式将其在Github上开源.Kube-OVN提供了大量目前Kubernetes不具备的网络功能,并在原有基础上进行增强. ...

- Hadoop配置第1节-集群网络配置

Hadoop-集群网络配置 总体目标:完成zookeeper+Hadoop+Hbase 整合平台搭建 进度:1:集群网络属性配置2:集群免密码登陆配置3:JDK的安装4:Zookeeper的安装5 ...

- Ceph集群网络切换

背景:需要对已部署好的Ceph集群切换网络,包含包含公共网络和集群网络 1 关闭所有mon节点的mon服务并修改服务器IP systemctl stop ceph-mon@storage01.serv ...

- docker 网络实践

#docker 网络模式 环境 centos7. , Docker version -ce docker自带网络类型 bridge,host,none,container,overlay,macvla ...

随机推荐

- Junit 单元测试在 intelliJ IDEA 中的安装

1.为什么使用Junit我们都知道,main 方法是一个程序的入口,通常来说,没有main方法,程序就无法运行.我们经常会写一些class文件(如下图所示),他们并没有自己的main方法.那么我们如何 ...

- python标准库:ftplib模块

ftplib模块包含了文件传输协议(FTP)客户端的实现. 下面的例子展示了如何登入和获取进入目录的列表,dir函数传入一个回调函数,该回调函数在服务器相应时每一行调用一次.ftplib模块默认的回调 ...

- js 创建对象的多种方式

参考: javascript 高级程序设计第三版 工厂模式 12345678910 function (name) { var obj = new Object() obj.name = name o ...

- Elays'Blog

文章导航 阴影的重要意义 阴影是光线被阻挡的结果,它能够使场景看起来真实很多,可以让观察者获得物体之间的空间位置关系.如下图所示: 图1 可以看到,有阴影的时候能够更容易的看出立方体是悬浮在地板上的. ...

- HAProxy此例简单介绍基于docker的HAProxy反代

HAProxy拓展连接 此例简单介绍基于Docker的HAProxy反代 反代: 1.获取haproxy镜像 docker pull haproxy 2.写配置文件haproxy.cfg 1 glo ...

- 开始使用Github

Gather ye rosebuds while ye may 我自己也是刚开始使用github没几天,写得不好我就写自己常用的吧 2015年9月20日下午3:19更新知乎上这个答案写得好多了

- Mac 下配置 adb 环境

使用 adb 命令可以很直接的观察你的应用 第一步 打开终端,敲入命令:sudo vi .bash_profile(如果有密码就为本机登录密码, 如果没有这个文件就会创建一个新的). 第二步 在文件中 ...

- php获取远程图片并把它保存到本地

/* *功能:php多种方式完美实现下载远程图片保存到本地 *参数:文件url,保存文件名称,使用的下载方式 *当保存文件名称为空时则使用远程文件原来的名称 */ function getImage( ...

- 3——PHP 简单运算符的使用

*/ * Copyright (c) 2016,烟台大学计算机与控制工程学院 * All rights reserved. * 文件名:text.cpp * 作者:常轩 * 微信公众号:Worldhe ...

- Linux命令学习神器!命令看不懂直接给你解释!

大家都知道,Linux 系统有非常多的命令,而且每个命令又有非常多的用法,想要全部记住所有命令的所有用法,恐怕是一件不可能完成的任务. 一般情况下,我们学习一个命令时,要么直接百度去搜索它的用法,要么 ...