spark动态资源(executor)分配

spark动态资源调整其实也就是说的executor数目支持动态增减,动态增减是根据spark应用的实际负载情况来决定。

开启动态资源调整需要(on yarn情况下)

1.将spark.dynamicAllocation.enabled设置为true。意思就是启动动态资源功能

2.将spark.shuffle.service.enabled设置为true。 在每个nodeManager上设置外部shuffle服务

2.1 将spark-<version>-yarn-shuffle.jar拷贝到每台nodeManager的${HADOOP_HOME}/share/hadoop/yarn/lib/下。

2.2 配置yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle,spark_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.spark_shuffle.class</name>

<value>org.apache.spark.network.yarn.YarnShuffleService</value>

</property>

<property>

<name>spark.shuffle.service.port</name>

<value>7337</value>

</property>

2.3 重启所有nodeManager

关于资源(executor)的Request与Remove策略

Request策略

当有被挂起的任务(pending task)的时候,也就表示当前的executor数量还不足够所有的task并行运行,这时候spark会申请增加资源,

但是并不是出现pending task就立刻请求增加executor。由下面两个参数决定,如下:

- 1.spark.dynamicAllocation.schedulerBacklogTimeout:

如果启用了动态资源分配功能,如果有pending task并且等待了一段时间(默认1秒),则增加executor

- 2.spark.dynamicAllocation.sustainedSchedulerBacklogTimeout:

随后每隔N秒(默认1秒),再检测pending task,如果仍然存在,增加executor。

此外每轮请求的executor数量是指数增长的。 比如,在第一轮中添加1个executor,然后在随后的轮中添加2、4、8,依此类推。

Remove策略

如果某executor空闲超过了一段时间,则remove此executor,由下面参数决定:

spark.dynamicAllocation.executorIdleTimeout:默认60秒

此外关于动态资源分配还有以下相关参数

- spark.dynamicAllocation.initialExecutors:

初始executor数量,如果--num-executors设置的值比这个值大,那么将使用--num-executors设置的值作为初始executor数量。

- spark.dynamicAllocation.maxExecutors:

executor数量的上限,默认是无限制的。

- spark.dynamicAllocation.minExecutors:

executor数量的下限,默认是0个

- spark.dynamicAllocation.cachedExecutorIdleTimeout:

如果executor内有缓存数据(cache data),并且空闲了N秒。则remove该executor。默认值无限制。也就是如果有缓存数据,则不会remove该executor

为什么?比如在写shuffle数据时候,executor可能会写到磁盘也可能会保存在内存中,如果保存在内存中,该executor又remove掉了,那么数据也就丢失了。

spark动态资源分配机制的应用

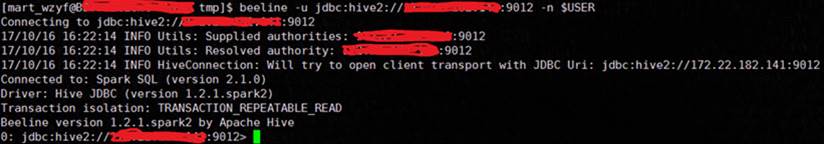

使用spark thriftserver将spark作为一个长期运行的服务。用户通过JDBC来提交sql查询:

$SPARK_HOME/sbin/start-thriftserver.sh

--executor-memory 20g --executor-cores --driver-memory 10g --driver-cores \

--conf spark.dynamicAllocation.enabled=true \

--conf spark.shuffle.service.enabled=true \

--conf spark.dynamicAllocation.initialExecutors= \

--conf spark.dynamicAllocation.minExecutors= \

--conf spark.dynamicAllocation.maxExecutors= \

--conf spark.dynamicAllocation.executorIdleTimeout=300s \

--conf spark.dynamicAllocation.schedulerBacklogTimeout=10s \

动态调整资源面临的问题

我们先看看,动态资源调整需要解决哪几个问题:

Cache问题。如果需要移除的Executor含有RDD cache该如何办?

Shuffle问题。如果需要移除的Executor包含了Shuffle Write先关数据该怎么办?

添加和删除之后都需要告知DAGSchedule进行相关信息更新。

Cache去掉了重算即可。为了防止数据抖动,默认包含有Cache的Executor是不会被删除的,因为默认的Idle时间设置的非常大:

private val cachedExecutorIdleTimeoutS = conf.getTimeAsSeconds(

"spark.dynamicAllocation.cachedExecutorIdleTimeout",

s"${Integer.MAX_VALUE}s")

你可以自己设置从而去掉这个限制。

而对于Shuffle,则需要和Yarn集成,需要配置yarn.nodemanager.aux-services。具体配置方式,大家可以Google。这样Spark Executor就不用保存Shuffle状态了。

使用动态资源分配的建议

我们发现,DRA(Dynamic Resource Allocation)涉及到的点还是很多的,虽然逻辑比较简单,但是和任务调度密切相关,是一个非常动态的过程。这个设计本身也是面向一个通用的调度方式。

建议如果采用了DRA,可以注意如下几点:

设置一个合理的minExecutors-maxExecutors值

将Executor对应的cpuCore 最好设置为<=3 ,避免Executor数目下降时,等不及新申请到资源,已有的Executor就因为任务过重而导致集群挂掉。

如果程序中有shuffle,例如(reduce,groupBy),建议设置一个合理的并行数,避免杀掉过多的Executors。

对于每个Stage持续时间很短的应用,其实不适合这套机制。这样会频繁增加和杀掉Executors,造成系统颠簸。而Yarn对资源的申请处理速度并不快。

官网关于动态资源分配的文档:

http://spark.apache.org/docs/2.3.1/job-scheduling.html#dynamic-resource-allocation

http://spark.apache.org/docs/2.3.1/configuration.html#dynamic-allocation

spark动态资源(executor)分配的更多相关文章

- 记一次有关spark动态资源分配和消息总线的爬坑经历

问题: 线上的spark thriftserver运行一段时间以后,ui的executor页面上显示大量的active task,但是从job页面看,并没有任务在跑.此外,由于在yarn mode下, ...

- Spark Streaming资源动态申请和动态控制消费速率剖析

本期内容 : Spark Streaming资源动态分配 Spark Streaming动态控制消费速率 为什么需要动态处理 : Spark 属于粗粒度资源分配,也就是在默认情况下是先分配好资源然后再 ...

- 利用动态资源分配优化Spark应用资源利用率

背景 在某地市开展项目的时候,发现数据采集,数据探索,预处理,数据统计,训练预测都需要很多资源,现场资源不够用. 目前该项目的资源3台旧的服务器,每台的资源 内存为128G,cores 为24 (co ...

- Spark技术内幕:Executor分配详解

当用户应用new SparkContext后,集群就会为在Worker上分配executor,那么这个过程是什么呢?本文以Standalone的Cluster为例,详细的阐述这个过程.序列图如下: 1 ...

- Spark动态加载外部资源文件

Spark动态加载外部资源文件 1.spark-submit --files 动态加载外部资源文件 之前做一个关于Spark的项目时,因项目中需要读取某个静态资源文件,然后在本地IDEA测试一切皆正常 ...

- Spark Streaming资源动态分配和动态控制消费速率

本篇从二个方面讲解: 高级特性: 1.Spark Streaming资源动态分配 2.Spark Streaming动态控制消费速率 原理剖析,动态控制消费速率其后面存在一套理论,资源动态分配也有一套 ...

- Spark动态资源分配-Dynamic Resource Allocation

微信搜索lxw1234bigdata | 邀请体验:数阅–数据管理.OLAP分析与可视化平台 | 赞助作者:赞助作者 Spark动态资源分配-Dynamic Resource Allocation S ...

- Spark On YARN内存分配

本文转自:http://blog.javachen.com/2015/06/09/memory-in-spark-on-yarn.html?utm_source=tuicool 此文解决了Spark ...

- spark on yarn 内存分配

Spark On YARN内存分配 本文主要了解Spark On YARN部署模式下的内存分配情况,因为没有深入研究Spark的源代码,所以只能根据日志去看相关的源代码,从而了解“为什么会这样,为什么 ...

随机推荐

- 杭电 1059 Dividing

Dividing Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others)Total Su ...

- linux命令行大全第四章[通配符的使用]

通配符示例 1.创建几个文件及目录 补充创建一个以大写字母开头的文件. 2.1显示所有文件及目录 2.2显示所有以1开头的文件及目录 2.3显示以a开头.txt结尾的文件 2.4显示以e开头,后跟任意 ...

- 同一台服务器lnmpa环境下配置ip或域名访问不同站点

1.配置域名访问 (1)添加虚拟主机 (2)nginx配置 cd /usr/local/nginx/conf/vhost vim zkadmin.zouke.com.conf (3)apache配置 ...

- ubuntu 更改pip默认源

mkdir ~/.pip vim ~/.pip/pip.conf [global] timeout = 6000 https://pypi.tuna.tsinghua.edu.cn/simple 保存 ...

- Java基础 -3.2

逻辑运算符 三目(赋值)运算符 合理地利用三目运算可以避免一些大范围的程序编写 三目运算是一种所谓的赋值运算的处理 它是需要设置一个逻辑关系的判断之后才可以进行的赋值操作 基本语法: 关系运算?关系满 ...

- Linux 修改/etc/profile 出错 导致所有命令都 command not found 的解决办法

执行命令 export PATH=/usr/bin:/usr/sbin:/bin:/sbin:/usr/X11R6/bin 然后再修改/etc/profile 再执行文件: source /etc/p ...

- 南京江行智能获得百度和松禾资本的A+轮融资

导读 据公司情报专家<财经涂鸦>消息,南京江行联加智能科技有限公司(江行智能)获得百度 和松禾资本的A+ 轮融资. 天眼查信息显示,12 月 8 日,公司工商信息发生变更,股东新增了广州百 ...

- c数据结构线性表的总结

1:连表的特点 1.链表是一种存储结构,用于存放线性表 2.连表的结点是根据需要调用动态分配内存函数进行分配的,因此链表可随需要伸长缩短 在腰存储的数据个数未知的情况下节省内存. ...

- 【PAT甲级】1009 Product of Polynomials (25 分)

题意: 给出两个多项式,计算两个多项式的积,并以指数从大到小输出多项式的指数个数,指数和系数. trick: 这道题数据未知,导致测试的时候发现不了问题所在. 用set统计非零项时,通过set.siz ...

- 【PAT甲级】1017 Queueing at Bank (25 分)

题意: 输入两个正整数N,K(N<=10000,k<=100)分别表示用户的数量以及银行柜台的数量,接下来N行输入一个字符串(格式为HH:MM:SS)和一个正整数,分别表示一位用户到达银行 ...