Text-CNN 文本分类

1.简介

TextCNN 是利用卷积神经网络对文本进行分类的算法,由 Yoon Kim 在 “Convolutional Neural Networks for Sentence Classification” 一文 (见参考[1]) 中提出. 是2014年的算法.

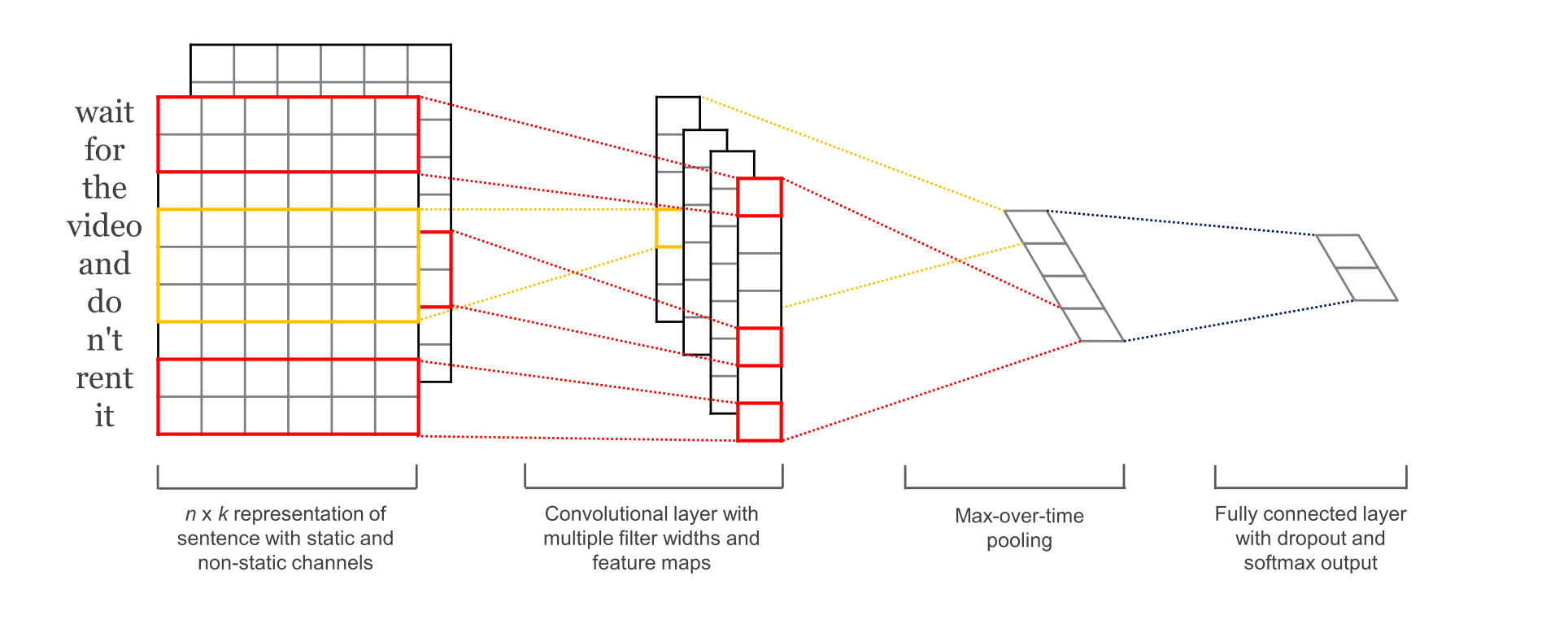

图1-1 参考[1] 中的论文配图

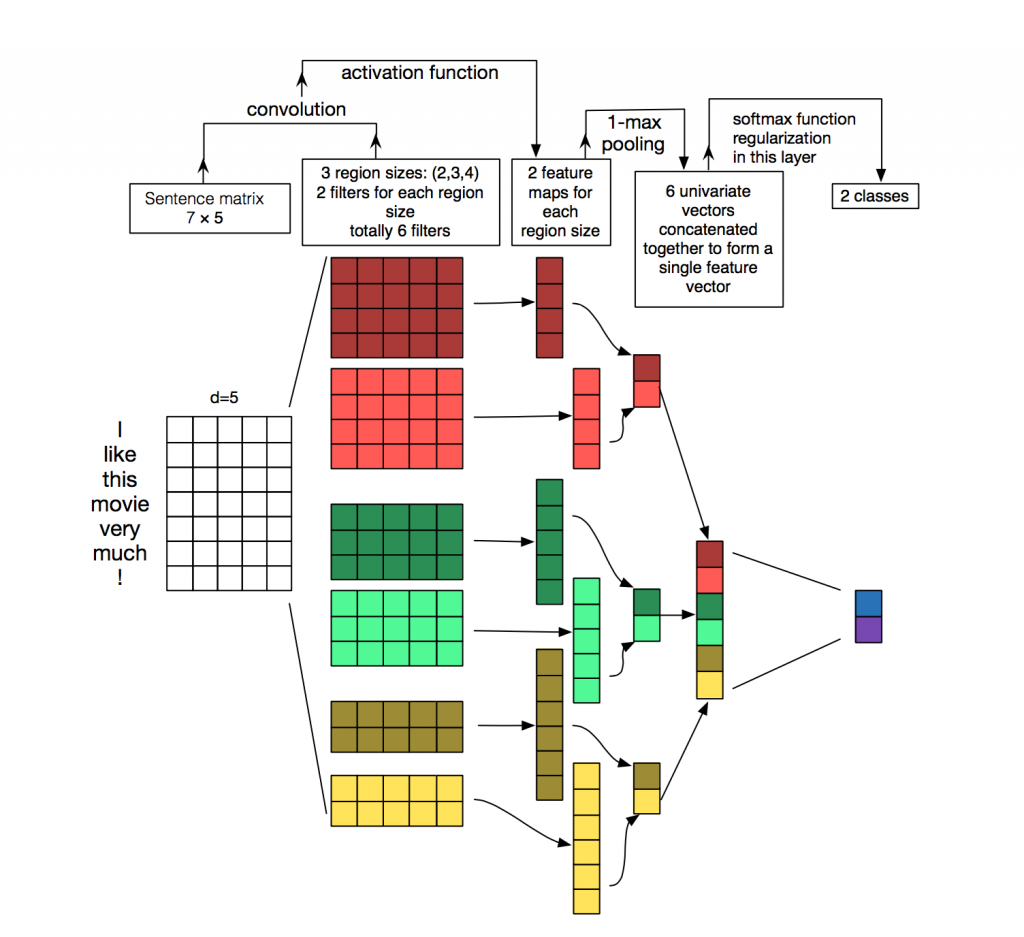

图1-2 网络盗图

合理性:

深度学习模型在计算机视觉与语音识别方面取得了卓越的成就. 在 NLP 也是可以的.

卷积具有局部特征提取的功能, 所以可用 CNN 来提取句子中类似 n-gram 的关键信息.

2.参数与超参数

- sequence_length

Q: 对于CNN, 输入与输出都是固定的,可每个句子长短不一, 怎么处理?

A: 需要做定长处理, 比如定为n, 超过的截断, 不足的补0. 注意补充的0对后面的结果没有影响,因为后面的max-pooling只会输出最大值,补零的项会被过滤掉. - num_classes

多分类, 分为几类. - vocabulary_size

语料库的词典大小, 记为|D|. - embedding_size

将词向量的维度, 由原始的 |D| 降维到 embedding_size. - filter_size_arr

多个不同size的filter.

3.Embedding Layer

通过一个隐藏层, 将 one-hot 编码的词 投影 到一个低维空间中.

本质上是特征提取器,在指定维度中编码语义特征. 这样, 语义相近的词, 它们的欧氏距离或余弦距离也比较近.

4.Convolution Layer

为不同尺寸的 filter 都建立一个卷积层. 所以会有多个 feature map.

图像是像素点组成的二维数据, 有时还会有RGB三个通道, 所以它们的卷积核至少是二维的.

从某种程度上讲, word is to text as pixel is to image, 所以这个卷积核的 size 与 stride 会有些不一样.

- xi

xi∈Rk

, 一个长度为n的句子中, 第 i 个词语的词向量, 维度为k.

- xi:j

xi:j=xi⊕xi+1⊕...⊕xj

表示在长度为n的句子中, 第 [i,j] 个词语的词向量的拼接.

- h

卷积核所围窗口中单词的个数, 卷积核的尺寸其实就是 hk

.

- w

w∈Rhk

, 卷积核的权重矩阵.

- ci

ci=f(w⋅xi:i+h−1+b)

, 卷积核在单词i位置上的输出. b∈RK

, 是 bias. f

是双曲正切之类的激活函数.

- c=[c1,c2,...,cn−h+1]

filter在句中单词上进行所有可能的滑动, 得到的 feature map

.

5.Max-Pooling Layer

max-pooling只会输出最大值, 对输入中的补0 做过滤.

6.SoftMax 分类 Layer

最后接一层全连接的 softmax 层,输出每个类别的概率。

7.小的变种

在 word representation 处理上会有一些变种.

- CNN-rand

设计好 embedding_size 这个 Hyperparameter 后, 对不同单词的向量作随机初始化, 后续BP的时候作调整. - static

拿 pre-trained vectors from word2vec, FastText or GloVe 直接用, 训练过程中不再调整词向量. 这也算是迁移学习的一种思想. - non-static

pre-trained vectors + fine tuning , 即拿word2vec训练好的词向量初始化, 训练过程中再对它们微调. - multiple channel

类比于图像中的RGB通道, 这里也可以用 static 与 non-static 搭两个通道来搞.

一些结果表明,max-pooling 总是优于 average-pooling ,理想的 filter sizes 是重要的,但具体任务具体考量,而用不用正则化似乎在NLP任务中并没有很大的不同。

8. Text CNN 的tf实现

参见[4], [6]. 挺详细的。

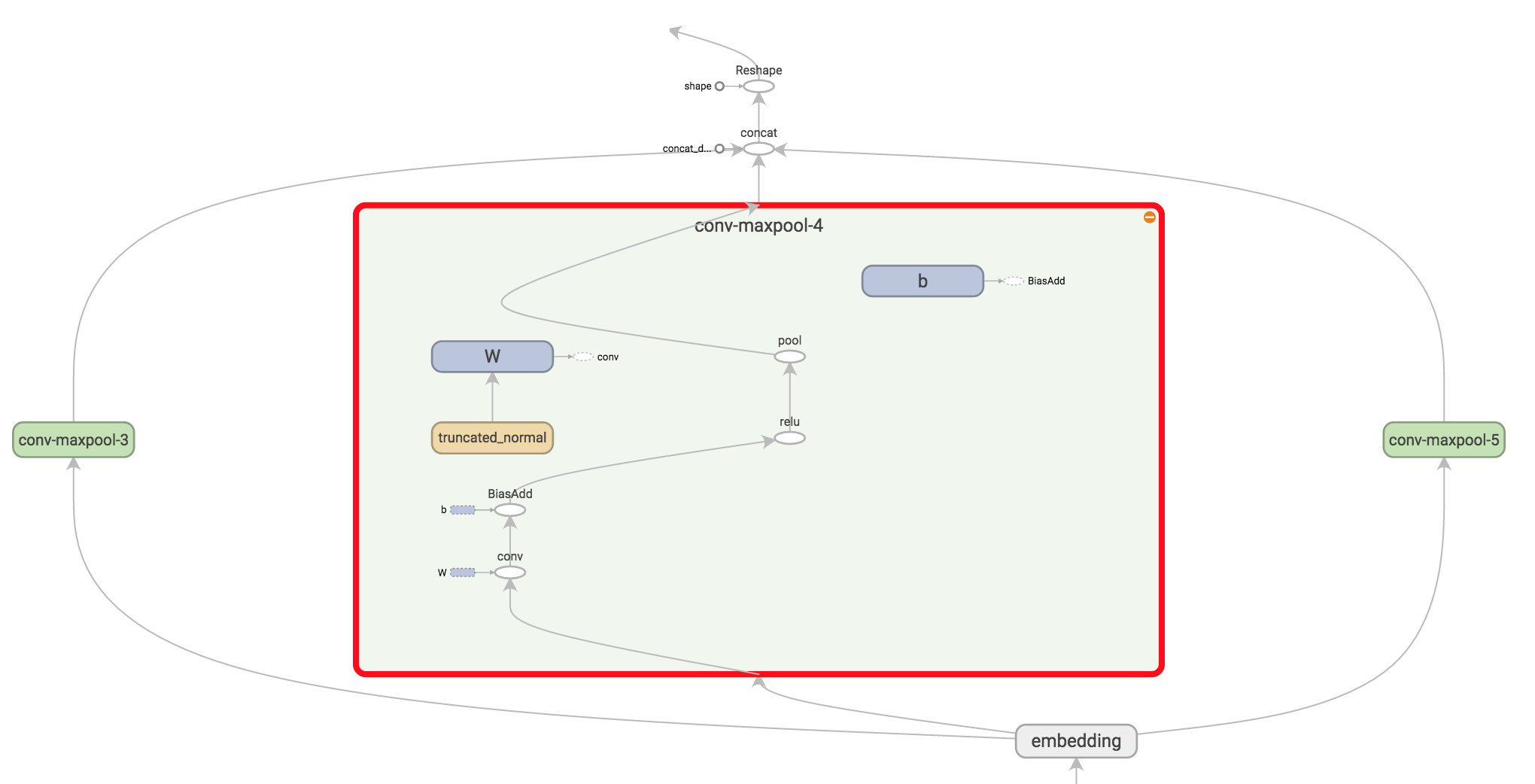

图 8-1 Text CNN 网络中的卷积与池化 结构

需要注意的细节有。 tf.nn.embedding_lookup() creates the actual embedding operation. The result of the embedding operation is a 3-dimensional tensor of shape [None, sequence_length, embedding_size].

TensorFlow’s convolutional conv2d operation expects a 4-dimensional tensor with dimensions corresponding to batch, width, height and channel. The result of our embedding doesn’t contain the channel dimension, so we add it manually, leaving us with a layer of shape [None, sequence_length, embedding_size, 1].

9. 与 LeNet 作比较

# LeNet5

conv1_weights = tf.get_variable(

"weight",

[CONV1_SIZE, CONV1_SIZE, NUM_CHANNELS, CONV1_DEEP],

initializer=tf.truncated_normal_initializer(stddev=0.1))

tf.nn.conv2d(

input_tensor,

conv1_weights,

strides=[1, 1, 1, 1],

padding='SAME')

tf.nn.max_pool(

relu1,

ksize = [1,POOL1_SIZE,POOL1_SIZE,1],

strides=[1,POOL1_SIZE,POOL1_SIZE,1],

padding="SAME")

#TextCNN

conv1_weights = tf.get_variable(

"weight",

[FILTER_SIZE, EMBEDDING_SIZE, 1, NUM_FILTERS],

initializer=tf.truncated_normal_initializer(stddev=0.1))

tf.nn.conv2d(

self.embedded_chars_expanded,

conv1_weights,

strides=[1, 1, 1, 1],

padding="VALID")

tf.nn.max_pool(

h,

ksize=[1, SEQUENCE_LENGTH - FILTER_SIZE + 1, 1, 1],

strides=[1, 1, 1, 1],

padding='VALID')先来比较卷积

Lenet是正方形的, 且每一层都只用了同一种尺寸的卷积核.

Text中, filter是矩形, 长度有好几种, 一般取 (2,3,4), 而宽度是定长的, 同word的embedding_size 相同. 每种尺寸都配有 NUM_FILTERS 个数目, 类比于Lenet中的output_depth. 所以得到的featuremap是长条状, 宽度为1.

因为是卷积, 所以stride每个维度都是1.

再说池化层.

Lenet的kernel是正方形, 一般也是2*2等, 所以会把卷积后的featurmap尺寸缩小一半.

TextCNN依旧是长方形, 将整个featuremap映射到一个点上. 一步到位, 只有一个池化层.

全连接层

都是多分类, 这一步的处理比较类似. 将池化后的矩阵 reshape为二维, 用 tf.nn.sparse_softmax_cross_entropy_with_logits() 计算损失.

10. TextCNN 论文中的网络结构

windows size 分别取 (3,4,5), 每个尺寸都会有100个filter.

3.1 Hyperparameters and Training

For all datasets we use: rectified linear units, filter

windows (h) of 3, 4, 5 with 100 feature maps each,

dropout rate (p) of 0.5, l2 constraint (s) of 3, and

mini-batch size of 50. These values were chosen

via a grid search on the SST-2 dev set.Text-CNN 文本分类的更多相关文章

- CNN 文本分类

谈到文本分类,就不得不谈谈CNN(Convolutional Neural Networks).这个经典的结构在文本分类中取得了不俗的结果,而运用在这里的卷积可以分为1d .2d甚至是3d的. 下面 ...

- CNN文本分类

CNN用于文本分类本就是一个不完美的解决方案,因为CNN要求输入都是一定长度的,而对于文本分类问题,文本序列是不定长的,RNN可以完美解决序列不定长问题, 因为RNN不要求输入是一定长度的.那么对于C ...

- pytorch -- CNN 文本分类 -- 《 Convolutional Neural Networks for Sentence Classification》

论文 < Convolutional Neural Networks for Sentence Classification>通过CNN实现了文本分类. 论文地址: 666666 模型图 ...

- CNN tensorflow text classification CNN文本分类的例子

from:http://deeplearning.lipingyang.org/tensorflow-examples-text/ TensorFlow examples (text-based) T ...

- CNN 文本分类模型优化经验——关键点:加卷积层和FC可以提高精度,在FC前加BN可以加快收敛,有时候可以提高精度,FC后加dropout,conv_1d的input维度加大可以提高精度,但是到256会出现OOM。

network = tflearn.input_data(shape=[None, max_len], name='input') network = tflearn.embedding(networ ...

- 文本分类:Keras+RNN vs传统机器学习

摘要:本文通过Keras实现了一个RNN文本分类学习的案例,并详细介绍了循环神经网络原理知识及与机器学习对比. 本文分享自华为云社区<基于Keras+RNN的文本分类vs基于传统机器学习的文本分 ...

- 用深度学习(CNN RNN Attention)解决大规模文本分类问题 - 综述和实践

https://zhuanlan.zhihu.com/p/25928551 近来在同时做一个应用深度学习解决淘宝商品的类目预测问题的项目,恰好硕士毕业时论文题目便是文本分类问题,趁此机会总结下文本分类 ...

- [转] 用深度学习(CNN RNN Attention)解决大规模文本分类问题 - 综述和实践

转自知乎上看到的一篇很棒的文章:用深度学习(CNN RNN Attention)解决大规模文本分类问题 - 综述和实践 近来在同时做一个应用深度学习解决淘宝商品的类目预测问题的项目,恰好硕士毕业时论文 ...

- 文本分类需要CNN?No!fastText完美解决你的需求(后篇)

http://blog.csdn.net/weixin_36604953/article/details/78324834 想必通过前一篇的介绍,各位小主已经对word2vec以及CBOW和Skip- ...

- 文本分类需要CNN?No!fastText完美解决你的需求(前篇)

http://blog.csdn.net/weixin_36604953/article/details/78195462?locationNum=8&fps=1 文本分类需要CNN?No!f ...

随机推荐

- FileSystemWatcher监听文件事件

现有一个需求如下:监控某个目录中的文件修改,创建,删除等信息,并记录下来. 这里用到FileSystemWatcher类.由于考虑到文件的写入量会很频率,所以考虑先将监听到的消息记录到内存中. 监听部 ...

- springboot-elasticsearch项目启动报错:'elasticsearchTemplate' that could not be found

解决: 将elasticsearch的相关配置加入到application.yml配置文件中就可以解决

- 借助marquee实现弹幕效果

HTML标签marquee实现滚动效果 .基于此,实现简易版 弹幕: HTML <div class="right_liuyan"> <marquee id=& ...

- 【VS开发】设置文档标题

[注意]我们注意到我们的文档的创建的时候我们会发现系统会去调用Doc类中的OnNewDocument函数,这里我们知道他是一个虚函数,我们可以在这里设置我们的文档的标题. 代码如下: BOOL CGr ...

- 【miscellaneous】华为智能视频监控系统设计解决方案

[导读] 近年来,随着经济的快速增长.社会的迅速进步,校园.工厂园区.中小企业.楼宇等领域对安全防范和现场记录报警系统的需求与日俱增,视频监控在工作.生活各方面得到了非常广泛的应用. 1.中小型视频监 ...

- HDU 1003 Max Sum (动态规划 最大区间和)

Max Sum Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others)Total Sub ...

- 小记---------maxwell 一个可以实时读取mysql二进制日志binlog,并生成JSON格式的消息,作为生产者发送给kafka,Redis,文件或其他平台的应用程序

maxwell主要提供了下列功能 支持 SELECT * FROM table 的方式进行全量数据初始化 支持在主库发生failover后,自动回复binlog位置(GTID) ...

- C++中类模板的概念和意义

1,在 C++ 中是否能够将泛型的思想应用于类? 1,函数模板是将泛型编程的思想应用于函数,就有了函数模板: 2,可以,常用的 C++ 标准库就是 C++ 中的标准模板库,C++ 中的 STL 就是将 ...

- 设计模式之单例模式(Singleton Pattern)

单例模式是最简单的设计模式之一.属于创建型模式,它提供了一种创建对象的最佳方式.使应用中只存在一个对象的实例,并且使这个单实例负责所有对该对象的调用.这种模式涉及到一个单一的类,该类负责创建自己的对象 ...

- git推送新项目到github

1.首先在github上新建一个裸仓库 得到新仓库地址 2.打开本地要添加项目的目录,右键选择git bash,执行命令 (1)git init (2)git remote add origin ht ...