成功秀了一波scala spark ML逻辑斯蒂回归

1、直接上官方代码,调整过的,方可使用

- package com.test

- import org.apache.spark.{SparkConf, SparkContext}

- import org.apache.spark.mllib.classification.{LogisticRegressionModel, LogisticRegressionWithLBFGS}

- import org.apache.spark.mllib.evaluation.MulticlassMetrics

- import org.apache.spark.mllib.regression.LabeledPoint

- import org.apache.spark.mllib.util.MLUtils

- object logsitiRcongin {

- def main(args: Array[String]): Unit = {

- val conf = new SparkConf().setMaster("local").setAppName("df")

- val sc = new SparkContext(conf)

- // Load training data in LIBSVM format.

- val data = MLUtils.loadLibSVMFile(sc, "E:\\spackLearn\\spark-2.3.3-bin-hadoop2.7\\data\\mllib\\sample_libsvm_data.txt")

- // Split data into training (60%) and test (40%).

- val splits = data.randomSplit(Array(0.6, 0.4), seed = 11L)

- val training = splits(0).cache()

- val test = splits(1)

- // Run training algorithm to build the model

- val model = new LogisticRegressionWithLBFGS()

- .setNumClasses(10)

- .run(training)

- // Compute raw scores on the test set.

- val predictionAndLabels = test.map { case LabeledPoint(label, features) =>

- val prediction = model.predict(features)

- (prediction, label)

- }

- // Get evaluation metrics.

- val metrics = new MulticlassMetrics(predictionAndLabels)

- val accuracy = metrics.accuracy

- println(s"最后的得分:Accuracy = $accuracy")

- // Save and load model

- model.save(sc, "data/model/scalaLogisticRegressionWithLBFGSModel")

- val sameModel = LogisticRegressionModel.load(sc, "data/model/scalaLogisticRegressionWithLBFGSModel")

- while (true){

- }

- }

- }

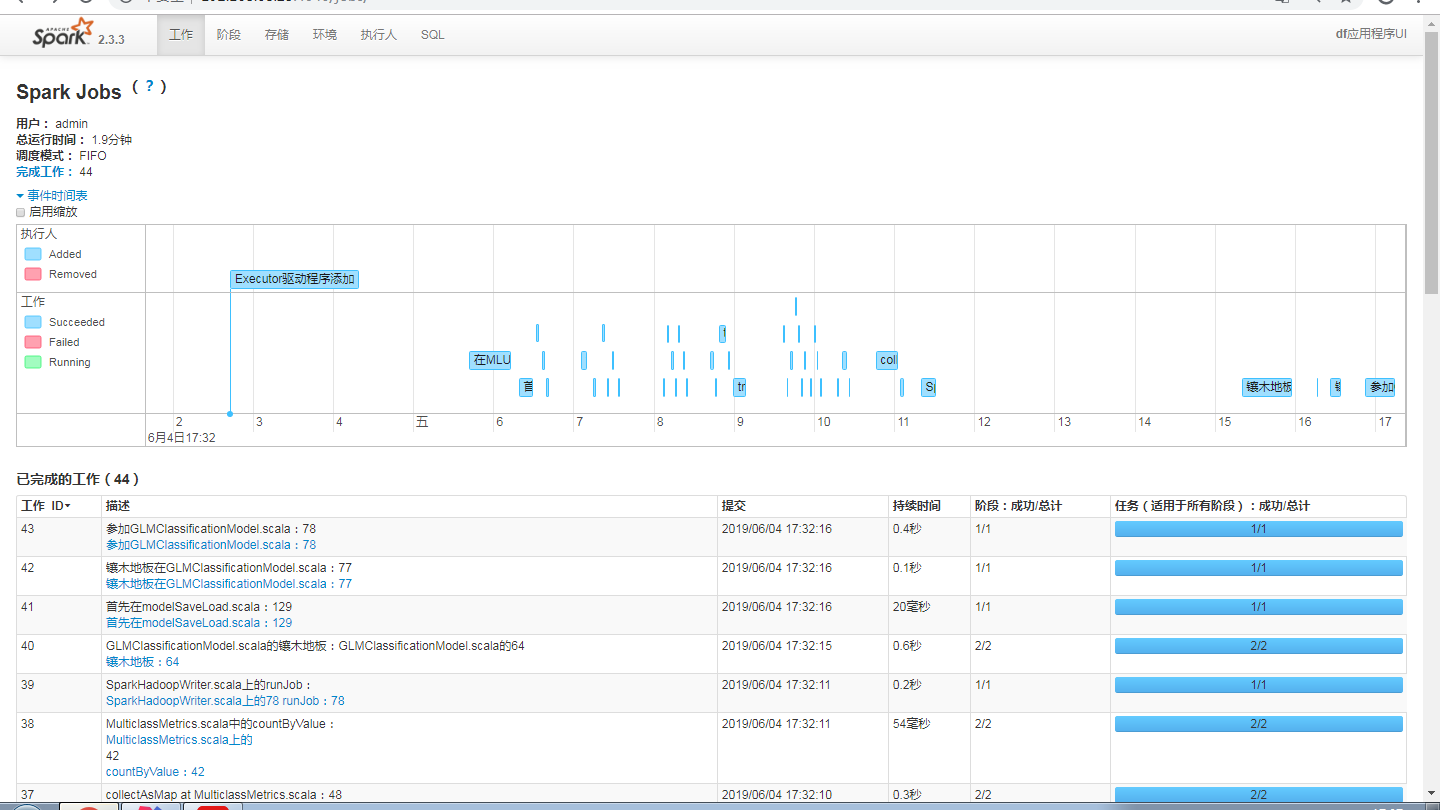

最后查看任务调度

成功秀了一波scala spark ML逻辑斯蒂回归的更多相关文章

- spark机器学习从0到1逻辑斯蒂回归之(四)

逻辑斯蒂回归 一.概念 逻辑斯蒂回归(logistic regression)是统计学习中的经典分类方法,属于对数线性模型.logistic回归的因变量可以是二分类的,也可以是多分类的.logis ...

- [置顶] 局部加权回归、最小二乘的概率解释、逻辑斯蒂回归、感知器算法——斯坦福ML公开课笔记3

转载请注明:http://blog.csdn.net/xinzhangyanxiang/article/details/9113681 最近在看Ng的机器学习公开课,Ng的讲法循循善诱,感觉提高了不少 ...

- Spark ML逻辑回归

import org.apache.log4j.{Level, Logger} import org.apache.spark.ml.classification.LogisticRegression ...

- Spark ML源码分析之二 从单机到分布式

前一节从宏观角度给大家介绍了Spark ML的设计框架(链接:http://www.cnblogs.com/jicanghai/p/8570805.html),本节我们将介绍,Spar ...

- Extending sparklyr to Compute Cost for K-means on YARN Cluster with Spark ML Library

Machine and statistical learning wizards are becoming more eager to perform analysis with Spark MLli ...

- Spark ML下实现的多分类adaboost+naivebayes算法在文本分类上的应用

1. Naive Bayes算法 朴素贝叶斯算法算是生成模型中一个最经典的分类算法之一了,常用的有Bernoulli和Multinomial两种.在文本分类上经常会用到这两种方法.在词袋模型中,对于一 ...

- Spark ML源码分析之四 树

之前我们讲过,在Spark ML中所有的机器学习模型都是以参数作为划分的,树相关的参数定义在treeParams.scala这个文件中,这里构建一个关于树的体系结构.首先,以Decis ...

- Eclipse+maven+scala+spark环境搭建

准备条件 我用的Eclipse版本 Eclipse Java EE IDE for Web Developers. Version: Luna Release (4.4.0) 我用的是Eclipse ...

- scala spark 机器学习初探

Transformer: 是一个抽象类包含特征转换器, 和最终的学习模型, 需要实现transformer方法 通常transformer为一个RDD增加若干列, 最终转化成另一个RDD, 1. 特征 ...

随机推荐

- 用PS修改PNG格式图标的颜色

需求:将黑色的PNG格式图标,更改为其它颜色 原始图标: 原始图标 - 黑色 方法1: 图层样式 -> 颜色叠加 选择颜色叠加 选择想要的颜色 方法2: 更换颜色 一 ...

- 调试dcc 试图将u-boot放入ocm运行碰到的问题

1. 起因: gd->mon_len = (ulong)&__bss_end - (ulong)_start; 在u-boot.map中查找,发现__bss_end并不是u-boot.b ...

- 分布式远程获取配置文件config属性(修正)

1.采用springcloud 获取github上config配置文件属性需要注意的问题; 2.此时github下面的配置文件,命名要特别注意,否则会获取不到配置里面的属性而报错,报错是因为配置文件命 ...

- 约会 Rendezvous:基环树

提炼:tarjan判环,dfs建树,倍增lca,预处理环两点间距离 我犯的错误: 1.基环树不只有一棵,可以有很多 2.自环不能将其忽略,(对于我的算法)应该将其特殊考虑在算法内 3.代码一定要简洁有 ...

- Java 11必掌握的8大特性,完美代码信手拈来

[MyEclipse CI 2019.4.0安装包下载] 美国时间 09 月 25 日,Oralce正式发布了Java 11,这是据Java 8以后支持的首个长期版本.从官方发布的支持路线图表看出,J ...

- SpringBoot框架(6)--事件监听

一.场景:类与类之间的消息通信,例如创建一个对象前后做拦截,日志等等相应的事件处理. 二.事件监听步骤 (1)自定义事件继承ApplicationEvent抽象类 (2)自定义事件监听器,一般实现Ap ...

- 数据结构——Bloom Filter

1. 一个很长的二进制向量和一个映射函数 2.用于检索一个元素是否在集合中,但有一定的错误概率:通过BloomFilter的元素不一定在集合当中,但是不通过BloomFilter的元素一定不在集合当中 ...

- DOM事件处理函数

事件 JavaScript与HTML之间的交互是通过事件实现的. 事件,就是文档或浏览器窗口中发生的一些特定的交互瞬间.可以使用侦听器(或是处理程序)来预定事件,以便事件发生时执行相应的代码 IE9. ...

- Sql Server2008中自定义函数调用存储过程解决方案

1.开启sql server 2008远程连接 打开sql server配置管理器 配置SSCM,选中左侧的“SQL Server服务”,确保右侧的“SQL Server”以及“SQL Server ...

- [CSP-S模拟测试]:简单计算(数学)

题目传送门(内部题104) 输入格式 第一行一个正整数$T$,表示该测试点内的数据组数,你需要对该测试点内的$T$组数据都分别给出正确的答案才能获得该测试点的分数. 接下来$T$组数据,每组数据一行两 ...