Factorized Hidden Variability Learning For Adaptation Of Short Duration Language Identification Models

基于因子分解的隐层变量学习,应用于短语句语种识别模型的自适应

LFVs(Language Feature Vectors,语种特征向量)[11],与BSVs(Bottleneck Speaker Vectors)类似,即瓶颈特征

3.1. 神经元调制

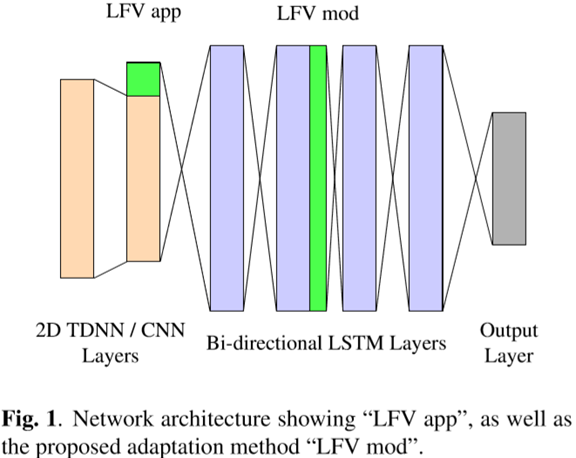

由于说话人特性的变化反映在语音信号中,因此将表示说话人适应声学特性的特征拼接到特征中。如VTLN或fMLLR,是直接对声学特征进行操作的自适应方法。可以训练一个说话人自适应系统以基于说话人属性直接对输入特征进行转换,这样效果与基于i-Vector的自适应类似[8]。但是与说话人变化特性相比,语言特性是更高阶的概念。在某些方面基于声学。例如,具有相同音素的多种语言,可以在某种程度上可以观察到语言特定属性。但是,声学特征变换适应性方法无法考虑到音位配列学或者不同声学单元集的知识。在这里,在更深层次的DNN处添加特征可能会改善自适应性。[17]基于Meta-PI网络进行了尝试。关键点是使用Meta-PI连接,它允许通过将隐层单元乘以系数来调制神经元的输出。应用于语种自适应,我们用LFV来对隐藏层的输出进行调制。基于语种特征的调制,LSTM单元的输出被衰减或增强。这迫使隐藏层中的单元基于语种特征来学习或适应。调制可以被认为与Dropout有关[18],其中网络连接以随机概率被丢弃。在结果部分中,我们将此方法称为"LFV调制"。

所示的网络配置。基本架构受百度Deepspeech 2的启发。它将两个TDNN/CNN层与4个双向LSTM层组合在一起。输出层是一个前馈层,它将最后一个LSTM层的输出映射到目标。将每层LSTM单元维数设定为LFV维数的数倍。这样就可以构建包含相同单位数量的LSTM单元的隐藏层组。然后用LFV的某一维对每组的输出进行调制。该图显示了两种配置,"LFV 拼接"和"LFV 调制",但一次只应用一种方法。在初步实验中,我们得出在第二个LSTM层的输出处进行调制可以获得最佳性能。

Factorized Hidden Variability Learning For Adaptation Of Short Duration Language Identification Models的更多相关文章

- Coursera Deep Learning笔记 序列模型(三)Sequence models & Attention mechanism(序列模型和注意力机制)

参考 1. 基础模型(Basic Model) Sequence to sequence模型(Seq2Seq) 从机器翻译到语音识别方面都有着广泛的应用. 举例: 该机器翻译问题,可以使用" ...

- ICLR 2013 International Conference on Learning Representations深度学习论文papers

ICLR 2013 International Conference on Learning Representations May 02 - 04, 2013, Scottsdale, Arizon ...

- Machine and Deep Learning with Python

Machine and Deep Learning with Python Education Tutorials and courses Supervised learning superstiti ...

- Deep Learning in a Nutshell: History and Training

Deep Learning in a Nutshell: History and Training This series of blog posts aims to provide an intui ...

- Machine Learning for Developers

Machine Learning for Developers Most developers these days have heard of machine learning, but when ...

- How do I learn machine learning?

https://www.quora.com/How-do-I-learn-machine-learning-1?redirected_qid=6578644 How Can I Learn X? ...

- (转) Ensemble Methods for Deep Learning Neural Networks to Reduce Variance and Improve Performance

Ensemble Methods for Deep Learning Neural Networks to Reduce Variance and Improve Performance 2018-1 ...

- (转)Understanding, generalisation, and transfer learning in deep neural networks

Understanding, generalisation, and transfer learning in deep neural networks FEBRUARY 27, 2017 Thi ...

- Rolling in the Deep (Learning)

Rolling in the Deep (Learning) Deep Learning has been getting a lot of press lately, and is one of t ...

随机推荐

- 【POJ2230】Watchcow

题目大意:给定一个 N 个点,M 条边的无向图,要求不重复地经过每条边两次,并且从 1 号节点出发最后回到 1 号节点,求一条路径. 题解:不重复地经过两次这个操作很容易地通过无向图的建边方式来实现, ...

- R语言修改标题、坐标轴刻度、坐标轴名称的大小(cex.axis、cex.lab、cex.main函数)

修改标题.坐标轴刻度.坐标轴名称的大小,用到了cex.axis.cex.lab.cex.main函数,其中,cex.axis表示修改坐标轴刻度字体大小,cex.lab表示修改坐标轴名称字体大小,cex ...

- 第十九节,使用RNN实现一个退位减法器

退位减法具有RNN的特性,即输入的两个数相减时,一旦发生退位运算,需要将中间状态保存起来,当高位的数传入时将退位标志一并传入参与计算. 我们在做减法运算时候,把减数和被减数转换为二进制然后进行运算.我 ...

- 关于JAVA-JS-JSP之间传值的各种方法

https://blog.csdn.net/murex_dustyone/article/details/52945552 这篇博文写的非常好,保存下来,一起学习

- RJ45连接器

http://www.huilyn.com/path315.html HBJ-6308ANLF http://www.hanrun.com/en/ HR971169C h ...

- 爬虫之requests请求库高级应用

1.SSL Cert Verification #证书验证(大部分网站都是https) import requests respone=requests.get('https://www.12306. ...

- PEP8规范

目录 一 代码编排 二 文档编排 三 空格使用 四 注释 五 文档描述 六 命名规范 七 编码建议 代码编排 1缩进,4个空格,不用tab键(因为可能不同系统tab的空格数不一定) 2每行最大长度79 ...

- Grunt安装与环境配置

公司项目还没有前后端分离,而前端是使用node.js搭建起来的,现在需要自己动手开发,故学习下并做为记录防止以后忘记. grunt依赖node.js,所以在安装之前确保你安装了 Node.js.然后开 ...

- qml: QtChart横纵轴label设置;

在qml中,使用ChartView作为图表展示区域, 但是并没有给定接口用来设置xlabel,ylabel. 没得办法,只能采用笨方案: (我的方法如下) import QtQuick 2.0 imp ...

- svn 基础

安装,略过. 快速创建.配置及启动项目 创建项目 svnadmin create /home/svn/project_name #创建名为project_name的项目(/home/svn为自定义创建 ...