python实战——网络爬虫之request

Urllib库是python中的一个功能强大的,用于操做URL,并在做爬虫的时候经常要用到的库,在python2中,分为Urllib和Urllib2两个库,在python3之后就将两个库合并到Urllib库中,使用方法有所不同,我使用的是python3。

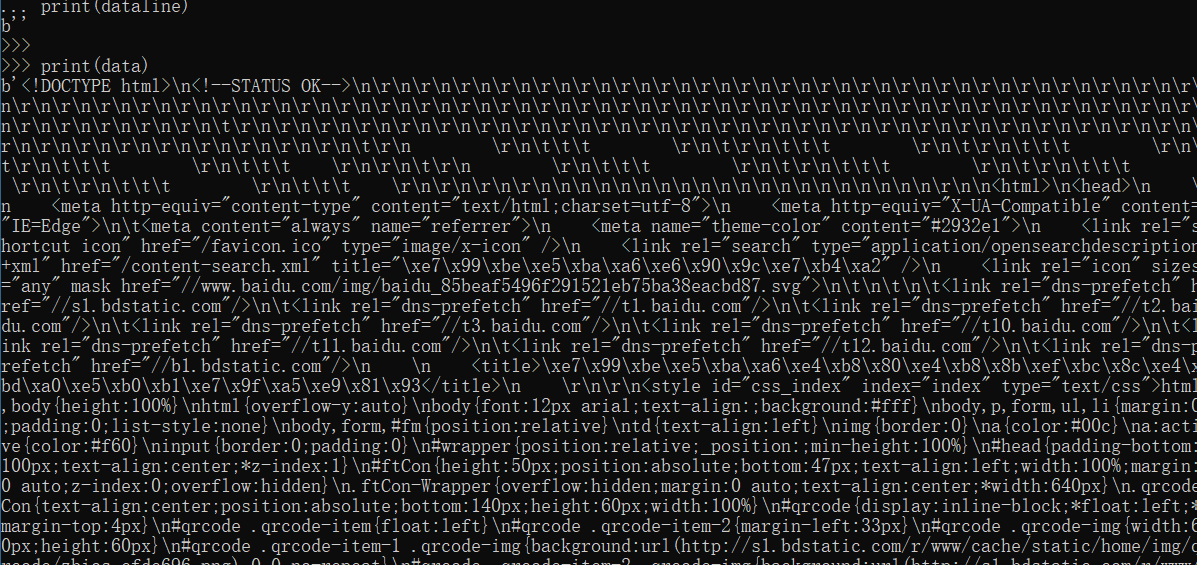

第一步,先导入Urllib库对应的模块,import urllib.request 或者直接导入request模块 from urllib import request

from urllib import request

file = request.urlopen("http://www.baidu.com") #urlopen打开并爬取一个页面,并将值赋给file,以百度为例

data = file.read() #read()读取全部能容

dataline = file.readline() #readline()只读取一行

# 分别打印两个值

print(dataline)

print(data)

打印结果:

这样就将获取的网页的HTML代码爬取下来了

爬取到数据之后我们怎么将爬取的网页以网页的形式进行保存

from urllib import request

file = request.urlopen("http://www.baidu.com")

data = file.read()

fhandle = open("F:/爬虫/1.html","wb") #通过open()函数打开该文件,“wb”以二进制写入形式打开,不会的话可以学习一下之前的python的文件写入操作。

#文件目录自己先创建

fhandle.write(data) #将data数据写入到

fhandle.close() #将文件关闭

然后找到该文件,用浏览器打开

图片信息还未爬取,但至此我们已经网页爬取并保存。

还有一种直接使用request模块中的urlretrieve函数直接写入

格式:urlretrieve(url,filename=本地地址)

from urllib import request

filename=request.urlretrieve("http://www.qq.com",filename="F:/爬虫/2.html" )

然后查看保存的路径下的文件,打开之后

使用urlretrieve执行的过程中会产生一些缓存,可以使用函数urlcleanup()进行清除

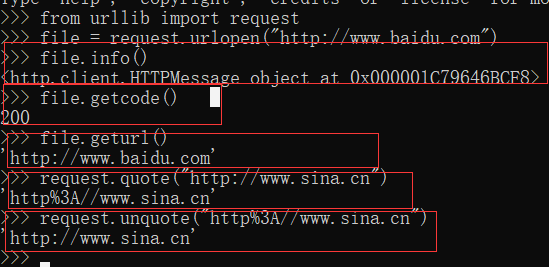

还有写其他的常用的方法如下:

返回与当前环境有关的信息 info()

获取当前爬取网页的状态码 getcode()

获取当前爬取网页的URL地址 geturl()

由于URL标准中之允许一部分的ASCII字符,比如数字,字母,部分表单符号等,其他不符合标准的要进行编码,使用quote()

编码之后进行解码 unquote()

当然不是所有的网站都可以这么轻松的获取到,很多网站都进行了反爬虫设置,用浏览器可以打开但用爬虫爬不到,此时我们就需要设置一些headers信息,模拟成浏览器去访问这些网站。

首先打开浏览器,输入www.baidu.com 然后按F12 在刷新一下网页

点击网络就可以看到上面的图了,然后点击第一个和右边的按钮

你就可以看到这样的

右边的标头就是headers,然后找到User-Agent,这个就是我们要用到的模拟浏览器的信息,将其复制下来

我们可以得到该信息 “User-Agent:Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36”

这样我们就可以修改报头,其中request()下的build_opener()和request.Request()下的add_header()都可以进行操作,如下:

from urllib import request

url = "www.baidu.com" #仅仅是个例子

headers = ("User-Agent","User-Agent:Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36")

opener = request.build_opener()

opener.addheaders=[headers]

data = opener.open(url).read()

print(data)

还有一种方法是通过request.Request(url)方式进行操作如下:

from urllib import request urll = "http://www.baidu.com"

req = request.Request(urll)

req.add_header("User-Agent","User-Agent:Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36")

#这里的键值对不止这一个,你也可以把所有的都写上,比如Cookie、host都可以

data = request.urlopen(req).read()

fhandle = open("F:/爬虫/1.html","wb")

fhandle.write(data)

fhandle.close()

HTTP请求之GET请求

当我们用百度进行搜索时会看到网络请求用的时get请求

可以看出搜索词的关键字时wd,这样我们可以通过构造类似的网址进行网络请求,然后再将请求的网址保存

from urllib import request keywd = "中国是一个伟大的国家"

key_code = request.quote(keywd) #汉字要编码,

urll = "http://www.baidu.com/s?wd="+key_code #拼接字符串

req = request.Request(urll)

data = request.urlopen(req).read()

fhandle = open("F:/爬虫/3.html","wb")

fhandle.write(data)

fhandle.close()

然后打开本地保存的文件

从上面的示例中可以总结出,使用GET请求的思路如下:

1.构造对应的URL地址,该URL地址包含GET请求的字段名和字段内容的信息,并且URL满足GET请求的格式,即 “http://网址?字段1=字段内容1&字段2=字段内容2”。

2.以顶印度额URL为参数,构建Request对象。

3.通过urlopen()打开构建的Request对象。

4.按需求进行后续处理的操作,比如读取网页的内容、将内容写入文件等。

HTTP请求之POST请求

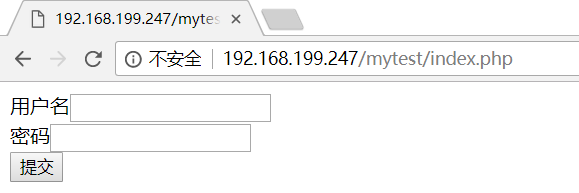

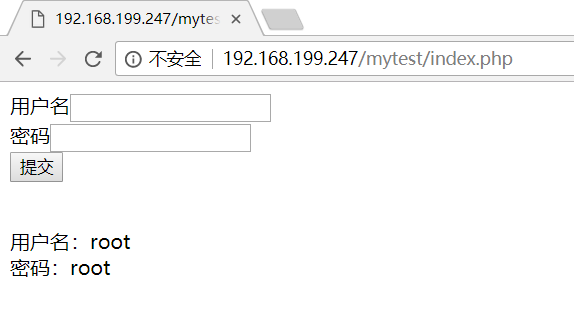

在注册和登陆网站是我们基本上都会遇到post请求,下面举个例子,这个是自己搭建的post请求网页,很粗糙的一个,只是将post请求的用户名个密码提交之后打印在了页面上。源码如下:

<form action="<?=$_SERVER['PHP_SELF'] ?>" method="POST">

用户名<input type="text" name="username"><br>

密码<input type="password" name="passwd"><br>

<input type="submit" name="submit" value="提交">

</form> <?php

if (isset($_POST['submit'])) {

echo "<br>";

echo '用户名:'.$_POST['username']."<br>";

echo "密码:".$_POST['passwd'].'<br>';

}

?>

原始的页面是

填写用户名和密码之后的页面

怎么构建post请求,一般的思路如下:

1.设置好URL网址

2.构建表单数据,并使用urllib.parse.urlencode对数据进行编码处理

3.创建Request对象,参数包括URL地址和要传递的编码处理

4.使用add_header()添加头部信息,模拟浏览器进行爬取

5.使用urllib.request.urlopen()打开对应的Request对象,完成信息的传递

6.读取或者写入等操作

现在我们去爬一下上面的网站:http://192.168.199.247/mytest/index.php

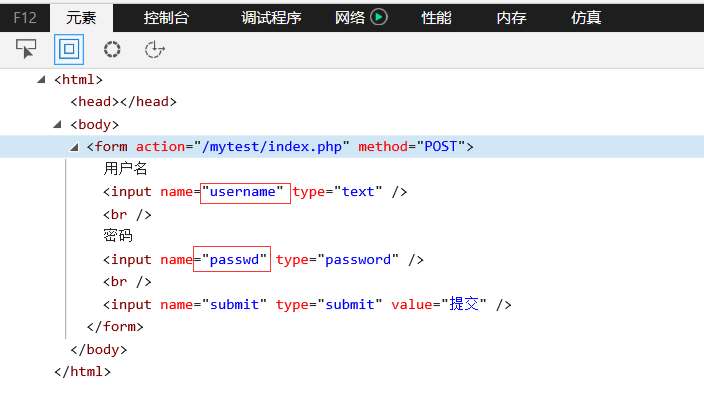

至于构建表单数据,我们需要看一下源码,打开网页,按F12,找到from表单的部分。

从上面我们可以看出需要提交表单的两个字段分别是:username、passwd。这样我们就可以构造数据,POST请求时的数据构造都要是以字典的形式进行所以我们构造的函数为:

{"username":"root","passwd":"root"},我们将用户名和密码都设置为root,这只完之后我们进行编码。然后创建Request对象之后就按着思路往下走就可以了

代码:

from urllib import request

from urllib import parse #编码时需要用到的库 url = "http://192.168.199.247/mytest/index.php"

postdata = parse.urlencode({

"username":"root",

"passwd":"root"

}).encode("utf-8") #设置编码格式为utf-8

req = request.Request(url,postdata) #在Request之后可以直接设置传递的数据 Request(url地址,传递的数据)

req.add_header("User-Agent","User-Agent:Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36")

data = request.urlopen(req).read()

fhandle = open("F:/爬虫/1.html","wb")

fhandle.write(data)

fhandle.close()

python实战——网络爬虫之request的更多相关文章

- python实战——网络爬虫

学习网络爬虫的目的: 1,可以私人定制一个搜索引擎,可以深层次的了解搜索引擎的工作原理. 2,大数据时代,要进行数据分析,首先要有数据源,学习爬虫,可以让我们获取更多的数据. 3,从业人员可以可好的利 ...

- Python 3网络爬虫开发实战》中文PDF+源代码+书籍软件包

Python 3网络爬虫开发实战>中文PDF+源代码+书籍软件包 下载:正在上传请稍后... 本书书籍软件包为本人原创,在这个时间就是金钱的时代,有些软件下起来是很麻烦的,真的可以为你们节省很多 ...

- Python 3网络爬虫开发实战中文 书籍软件包(原创)

Python 3网络爬虫开发实战中文 书籍软件包(原创) 本书书籍软件包为本人原创,想学爬虫的朋友你们的福利来了.软件包包含了该书籍所需的所有软件. 因为软件导致这个文件比较大,所以百度网盘没有加速的 ...

- Python 3网络爬虫开发实战中文PDF+源代码+书籍软件包(免费赠送)+崔庆才

Python 3网络爬虫开发实战中文PDF+源代码+书籍软件包+崔庆才 下载: 链接:https://pan.baidu.com/s/1H-VrvrT7wE9-CW2Dy2p0qA 提取码:35go ...

- 《Python 3网络爬虫开发实战中文》超清PDF+源代码+书籍软件包

<Python 3网络爬虫开发实战中文>PDF+源代码+书籍软件包 下载: 链接:https://pan.baidu.com/s/18yqCr7i9x_vTazuMPzL23Q 提取码:i ...

- Python简单网络爬虫实战—下载论文名称,作者信息(下)

在Python简单网络爬虫实战—下载论文名称,作者信息(上)中,学会了get到网页内容以及在谷歌浏览器找到了需要提取的内容的数据结构,接下来记录我是如何找到所有author和title的 1.从sou ...

- Python 3网络爬虫开发实战书籍

Python 3网络爬虫开发实战书籍,教你学会如何用Python 3开发爬虫 本书介绍了如何利用Python 3开发网络爬虫,书中首先介绍了环境配置和基础知识,然后讨论了urllib.reques ...

- Python学习网络爬虫--转

原文地址:https://github.com/lining0806/PythonSpiderNotes Python学习网络爬虫主要分3个大的版块:抓取,分析,存储 另外,比较常用的爬虫框架Scra ...

- 用Python写网络爬虫 第二版

书籍介绍 书名:用 Python 写网络爬虫(第2版) 内容简介:本书包括网络爬虫的定义以及如何爬取网站,如何使用几种库从网页中抽取数据,如何通过缓存结果避免重复下载的问题,如何通过并行下载来加速数据 ...

随机推荐

- Java数据结构和算法(二)顺序存储的树结构

Java数据结构和算法(二)顺序存储的树结构 数据结构与算法目录(https://www.cnblogs.com/binarylei/p/10115867.html) 二叉树也可以用数组存储,可以和完 ...

- bat 调用exe

@set errorlevel=>nul :reInput @echo 请输入批次号: @set/p 批次号= >nul @set 批次号|findstr "\\<%sea ...

- Debian8 下面 muduo库编译与使用

其实<Linux 多线程服务端编程>已经写得很详细 但是考虑到代码版本的更新和操作系统的不同 可能部分位置会有些许出入 这里做个记录 方便以后学习运行 我使用的虚拟 安装的是debian系 ...

- jar 包 的用处 ,dozer、poi、itext 、jxl 、jbarcode 、itextrenderer jquery 效果

1.dozer 做类型转换的, 新建 xml 文件 描述两个实体的对应关系 ,DozerBeanMapper mapper =new DozerBeanMapper().addMappingFiles ...

- MySQL 组合查询 concat

concat( pms_user.f_pu_name, '(' , pms_user.f_pu_realName,')') as userIds

- 2018.08.27 rollcall(非旋treap)

描述 初始有一个空集,依次插入N个数Ai.有M次询问Bj,表示询问第Bj个数加入集合后的排名为j的数是多少 输入 第一行是两个整数N,M 接下来一行有N个整数,Ai 接下来一行有M个整数Bj,保证数据 ...

- python 编码方式大全 fr = open(filename_r,encoding='cp852')

7.8.3. Standard Encodings Python comes with a number of codecs built-in, either implemented as C fun ...

- MFC自动生成代码详解(一)

首先声明这篇博客是给MFC刚刚上路的coder准备的,老鸟们就自觉无视我吧! 大家有没有感觉,创建MFC工程时他总会生成一大堆文件一大堆代码.虽然给我们带来了便利,但是调试的时候碰到这些代码总是畏首畏 ...

- Linux内存子系统及常用调优参数

1>内存子系统 1>组件: slab allocator buddy system kswapd pdflush 2>虚拟化环境: PA:进程地址: HA:虚拟机地址: ...

- java web渲染器

渲染就是server端将夹杂有脚本语言变量对象的模版文件解释为纯html页面的过程!