DQN(Deep Reiforcement Learning) 发展历程(一)

目录

马尔可夫理论

马尔可夫性质

- P[St+1 | St] = P[St+1 | S1,...,St]

- 给定当前状态 St ,过去的状态可以不用考虑

- 当前状态 St 可以代表过去的所有状态

- 给定当前状态的条件下,未来的状态和过去的状态相互独立。

马尔可夫过程(MP)

- 形式化地描述了强化学习的环境。

- 包括二元组(S,P)

- 根据给定的转移概率矩阵P,从当前状态St转移到下一状态St+1,

- 基于模型的(Model-based):事先给出了转移概率矩阵P

马尔可夫奖励过程(MRP)

- 和马尔可夫过程相比,加入了奖励r,加入了折扣因子gamma,gamma在0~1之间。

- 马尔可夫奖励过程是一个四元组⟨S, P, R, γ⟩

- 需要折扣因子的原因是

- 使未来累积奖励在数学上易于计算

- 由于可能经过某些重复状态,避免累积奖励的计算成死循环

- 用于表示未来的不确定性

- gamma越大表示越看中未来的奖励

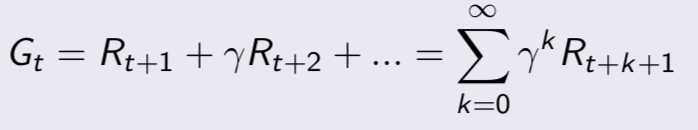

值函数(value function)

- 引入了值函数(value function),给每一个状态一个值V,以从当前状态St到评估未来的目标G的累积折扣奖励的大小

MRP求解

- v = R + γPv (矩阵形式)

- 直接解出上述方程时间复杂度O(n^3), 只适用于一些小规模问题

马尔可夫决策过程(MDP)

- 加入了一个动作因素a,用于每个状态的决策

- MDP是一个五元组⟨S, A, P, R, γ⟩

- 策略policy是从S到A的一个映射

效用函数

- 相比于值函数,加入了一个动作因素

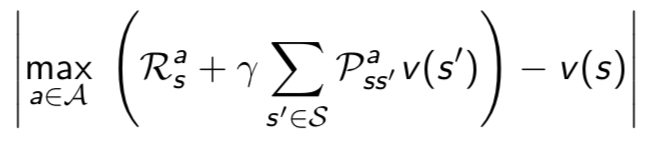

优化的值函数

- 为了求最佳策略,在值函数求解时,选择一个最大的v来更新当前状态对应的v

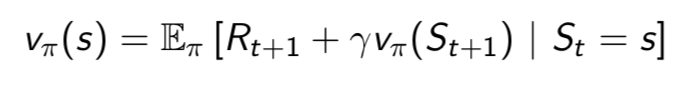

贝尔曼等式

- 和值函数的求解方法相比,不需要从当前状态到目标求解,只需要从当前状态到下一状态即可(根据递推公式)

参考

david siver 课程

https://home.cnblogs.com/u/pinard/

DQN(Deep Reiforcement Learning) 发展历程(一)的更多相关文章

- DQN(Deep Reiforcement Learning) 发展历程(五)

目录 值函数的近似 DQN Nature DQN DDQN Prioritized Replay DQN Dueling DQN 参考 DQN发展历程(一) DQN发展历程(二) DQN发展历程(三) ...

- DQN(Deep Reiforcement Learning) 发展历程(三)

目录 不基于模型(Model-free)的预测 蒙特卡罗方法 时序差分方法 多步的时序差分方法 参考 DQN发展历程(一) DQN发展历程(二) DQN发展历程(三) DQN发展历程(四) DQN发展 ...

- DQN(Deep Reiforcement Learning) 发展历程(四)

目录 不基于模型的控制 选取动作的方法 在策略上的学习(on-policy) 不在策略上的学习(off-policy) 参考 DQN发展历程(一) DQN发展历程(二) DQN发展历程(三) DQN发 ...

- DQN(Deep Reiforcement Learning) 发展历程(二)

目录 动态规划 使用条件 分类 求解方法 参考 DQN发展历程(一) DQN发展历程(二) DQN发展历程(三) DQN发展历程(四) DQN发展历程(五) 动态规划 动态规划给出了求解强化学习的一种 ...

- [DQN] What is Deep Reinforcement Learning

已经成为DL中专门的一派,高大上的样子 Intro: MIT 6.S191 Lecture 6: Deep Reinforcement Learning Course: CS 294: Deep Re ...

- Deep Reinforcement Learning 基础知识(DQN方面)

Introduction 深度增强学习Deep Reinforcement Learning是将深度学习与增强学习结合起来从而实现从Perception感知到Action动作的端对端学习的一种全新的算 ...

- 论文笔记之:Dueling Network Architectures for Deep Reinforcement Learning

Dueling Network Architectures for Deep Reinforcement Learning ICML 2016 Best Paper 摘要:本文的贡献点主要是在 DQN ...

- Deep Reinforcement Learning: Pong from Pixels

这是一篇迟来很久的关于增强学习(Reinforcement Learning, RL)博文.增强学习最近非常火!你一定有所了解,现在的计算机能不但能够被全自动地训练去玩儿ATARI(译注:一种游戏机) ...

- 论文笔记之:Human-level control through deep reinforcement learning

Human-level control through deep reinforcement learning Nature 2015 Google DeepMind Abstract RL 理论 在 ...

随机推荐

- python-组合模式

源码地址:https://github.com/weilanhanf/PythonDesignPatterns 说明: 组合模式主要用来处理一类具有“容器特征”的对象——它们即充当对象又可以作为容器包 ...

- Geolocation API

Geolocation API--地理定位 navigator.geolocation getCurrentPosition() 触发请求用户共享地理定位信息的对话框 接收3个参数: 1.成功回调函数 ...

- Ubuntu14.16.18更新源

一.源概述 源,可以认为是软件库,使用apt-get install安装的时候,会在源保存的库中进行搜索,因此源(默认源在欧洲)会影响下载速度和资源数量 二.更新源 1.步骤 编辑/etc/apt/s ...

- jQuery操作table数据上移、下移和置顶

jQuery 操作table中的tr换行的步骤如下: 1.获取当前tr var $tr = $(this).parents("tr"); 2.移动tr //上移 $tr.prev( ...

- ajax请求json数据跨域问题(转)

一.后台代理技术 由服务器端向跨域下的网站发出请求,再将请求结果返回给前端,成功避免同源策略的限制. 具体操作如下: 1.在localhost:81/a.html中,向同源下的某个代理程序发出请求 $ ...

- IDEA项目搭建四——使用Mybatis实现Dao层

一.引入mybatis及mysql的jar包 可以从阿里云上面查找版本,db操作放在dao层所以打开该层的pom.xml文件,找到<dependencies>节点增加两个引入 <de ...

- OSGI企业应用开发(十一)Bundle资源获取途径

使用OSGI模块化标准构建Java EE项目,其中比较繁琐的一个方面就是Bundle资源的获取,因为很多开源框架官方都没有发布Bundle版本的Jar文件,这也是使用OSGI开发企业应用首先要解决的问 ...

- 如何扩展Linux虚拟内存文件系统

由于ArcGIS GeoAnalystics Server和Raster Analytics Server大数据分析平台都是基于Spark分析平台的,其部署服务器除了要求具有高内存特点外,也需要确保相 ...

- 帆软发布大数据直连引擎FineDirect,对焦大数据BI

摘要:近日,帆软官方正式发布大数据直连引擎FineDirect模块.通过该模块,企业在应用FineBI原有功能的基础上,可直接对接现有数据源,无论是传统的关系型数据库,还是Hadoop生态圈.Mpp构 ...

- Android网络编程系列之Volley总结

前言 Volley的中文翻译为“齐射.并发”,是在2013年的Google大会上发布的一款Android平台网络通信库,具有网络请求的处理.小图片的异步加载和缓存等功能,能够帮助 Android AP ...