环境篇:呕心沥血@CDH线上调优

环境篇:呕心沥血@线上调优

- 为什么出这篇文章?

近期有很多公司开始引入大数据,由于各方资源有限,并不能合理分配服务器资源,和服务器选型,小叶这里将工作中的总结出来,给新入行的小伙伴带个方向,不敢说一定对,但是本人亲自测试,发现集群使用率稳定提高了3分之1,最高可达到2分之1,有不对的地方欢迎留言指出。

注:可能有些服务没有设计,使用到的小伙伴可以参照这种方式去规划。

0 资源:集群服务安排

| 服务名称 | 子服务 | CM-64G | ZK-Kafka(3台)-12G | DataNode(3台)-64G | NameNode1-64G | NameNode2-64G | Resourcemanager1-32G | Resourcemanager2-32G | hive-hbase-16G | hive-hbase-16G |

|---|---|---|---|---|---|---|---|---|---|---|

| MySQL | MySQL | √ | ||||||||

| CM | Activity Monitor Alert Publisher Event Server Host Monitor Service Monitor |

√ √ √ √ √ |

||||||||

| HDFS | NameNode DataNode Failover Controller JournalNode |

X √ X X |

√ X √ √ |

√ X √ √ |

X X X √ |

|||||

| Yarn | NodeManager Resourcemanager JobHisoryServer |

√ X X |

X √ √ |

X √ √ |

||||||

| Zookeeper | Zookeeper Server | √ | ||||||||

| Kafka | Kafka Broker | √ | ||||||||

| Hive | Hive Metastore Server HiveServer2 Gateway(安装对应应用服务器) |

X √ √ |

√ X √ |

√ X √ |

||||||

| Hbase | HMaster HRegionServer Thrift Server |

X √ √ |

√ X |

√ X |

||||||

| Oozie | Oozie Server | √ | ||||||||

| Hue | Hue Server Load Balancer |

X √ |

√ X |

|||||||

| Spark | History Server Gateway(安装对应应用服务器) |

√ X |

||||||||

| Flume | Flume Agent (安装对应应用服务器) | |||||||||

| Sqoop | Sqoop(安装对应应用服务器) |

1 优化:Cloudera Management

1.1 Cloudera Management Service

这些服务主要是提供监控功能,目前的调整主要集中在内存放,以便有足够的资源 完成集群管理。

| 服务 | 选项 | 配置值 |

|---|---|---|

| Activity Monitor | Java Heap Size | 2G |

| Alert Publisher | Java Heap Size | 2G |

| Event Server | Java Heap Size | 2G |

| Host Monitor | Java Heap Size | 4G |

| Service Monitor | Java Heap Size | 4G |

| Reports Manager | Java Heap Size | 2G |

| Navigator Metadata Server | Java Heap Size | 8G |

2 优化:Zookeeper

| 服务 | 选项 | 配置值 |

|---|---|---|

| Zookeeper | Java Heap Size (堆栈大小) | 4G |

| Zookeeper | maxClientCnxns (最大客户端连接数) | 1024 |

| Zookeeper | dataDir (数据文件目录+数据持久化路径) | /hadoop/zookeeper (建议独立目录) |

| Zookeeper | dataLogDir (事务日志目录) | /hadoop/zookeeper_log (建议独立目录) |

3 优化:HDFS

3.1 磁盘测试

3.1.1 读测试

hdparm 用于查看硬盘的相关信息或对硬盘进行测速、优化、修改硬盘相关参数设定

#安装hdparm

yum install hdparm

#获取硬盘符

fdisk -l

#读测试(读取上一步获取硬盘符)

hdparm -t /dev/vda

三次测试结果:

Timing buffered disk reads: 500 MB in 0.84 seconds = 593.64 MB/sec

Timing buffered disk reads: 500 MB in 0.93 seconds = 538.80 MB/sec

Timing buffered disk reads: 500 MB in 0.74 seconds = 672.95 MB/sec

说明:接近1s秒读取了500MB磁盘,读速度约 500 MB/秒

3.1.2 写测试

dd 这里使用 time + dd 简单测试写速度,不要求很精确

查看内存缓存情况

free -m

清除缓存

sync; echo 3 > /proc/sys/vm/drop_caches

查block size

blockdev --getbsz /dev/vda

写测试

echo 3 > /proc/sys/vm/drop_caches; time dd if=/dev/zero of=/testdd bs=4k count=100000

三次测试结果:

记录了100000+0 的读入

记录了100000+0 的写出409600000 bytes (410 MB) copied, 0.574066 s, 714 MB/s --410MB复制,用时0.57秒,评估714M/s

409600000 bytes (410 MB) copied, 1.84421 s, 222 MB/s --410MB复制,用时1.84秒,评估222 M/s

409600000 bytes (410 MB) copied, 1.06969 s, 383 MB/s --410MB复制,用时1.06秒,评估383M/s

3.1.3 网络带宽

iperf3测量一个网络最大带宽

#安装iperf3

yum -y install iperf3

#服务端

iperf3 -s

#客户端

iperf3 -c 上调命令执行的服务机器IP

测试结果:

| [ ID]-->线程id | Interva-->传输时间 | Transfer-->接收数据大小 | Bandwidth-->带宽每秒大小 | Retr | 角色 |

|---|---|---|---|---|---|

| [ 4] | 0.00-10.00 sec | 17.0 GBytes | 14.6 Gbits/sec | 0 | sender-->发送 |

| [ 4] | 0.00-10.00 sec | 17.0 GBytes | 14.6 Gbits/sec | receiver-->接收 |

3.2 官方压测

3.2.1 用户准备

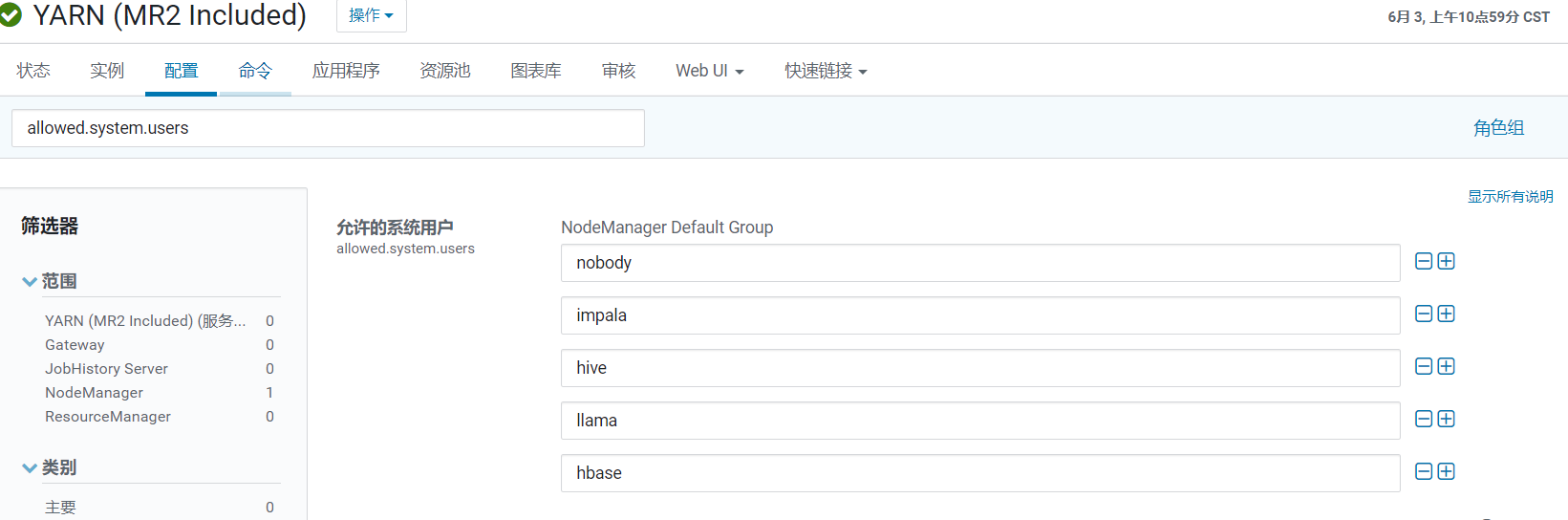

由于只能使用yarn配置了允许用户,故这里选择hive用户,如果su hive不能进入,则需要配置该步骤

usermod -s /bin/bash hive

su hive

3.2.2 HDFS 写性能测试

- 测试内容:HDFS集群写入10个128M文件(-D指定文件存储目录)

hadoop jar /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/jars/hadoop-mapreduce-client-jobclient-3.0.0-cdh6.2.0-tests.jar TestDFSIO -D test.build.data=/test/benchmark -write -nrFiles 10 -fileSize 128

INFO fs.TestDFSIO: ----- TestDFSIO ----- : write

INFO fs.TestDFSIO: Date & time: Thu Jun 11 10:30:36 CST 2020

INFO fs.TestDFSIO: Number of files: 10 --十个文件

INFO fs.TestDFSIO: Total MBytes processed: 1280 --总大小1280M

INFO fs.TestDFSIO: Throughput mb/sec: 16.96 --吞吐量 每秒16.96M

INFO fs.TestDFSIO: Average IO rate mb/sec: 17.89 --平均IO情况17.89M

INFO fs.TestDFSIO: IO rate std deviation: 4.74 --IO速率标准偏差

INFO fs.TestDFSIO: Test exec time sec: 46.33 --总运行时间

3.2.3 HDFS 读性能测试

- 测试内容:HDFS集群读取10个128M文件

hadoop jar /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/jars/hadoop-mapreduce-client-jobclient-3.0.0-cdh6.2.0-tests.jar TestDFSIO -D test.build.data=/test/benchmark -read -nrFiles 10 -fileSize 128

INFO fs.TestDFSIO: ----- TestDFSIO ----- : read

INFO fs.TestDFSIO: Date & time: Thu Jun 11 10:41:19 CST 2020

INFO fs.TestDFSIO: Number of files: 10 --文件数

INFO fs.TestDFSIO: Total MBytes processed: 1280 --总大小

INFO fs.TestDFSIO: Throughput mb/sec: 321.53 --吞吐量 每秒321.53M

INFO fs.TestDFSIO: Average IO rate mb/sec: 385.43 --平均IO情况385.43M

INFO fs.TestDFSIO: IO rate std deviation: 107.67 --IO速率标准偏差

INFO fs.TestDFSIO: Test exec time sec: 20.81 --总运行时间

3.2.4 删除测试数据

hadoop jar /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/jars/hadoop-mapreduce-client-jobclient-3.0.0-cdh6.2.0-tests.jar TestDFSIO -D test.build.data=/test/benchmark -clean

3.3 参数调优

| 服务 | 选项 | 配置值 |

|---|---|---|

| NameNode | Java Heap Size (堆栈大小) | 56G |

| NameNode | dfs.namenode.handler.count (详见3.3.2) | 80 |

| NameNode | dfs.namenode.service.handler.count (详见3.3.2) | 80 |

| NameNode | fs.permissions.umask-mode (使用默认值022) | 027(使用默认值022) |

| DataNode | Java Heap Size (堆栈大小) | 8G |

| DataNode | dfs.datanode.failed.volumes.tolerated (详见3.3.3) | 1 |

| DataNode | dfs.datanode.balance.bandwidthPerSec (DataNode 平衡带宽) | 100M |

| DataNode | dfs.datanode.handler.count (服务器线程数) | 64 |

| DataNode | dfs.datanode.max.transfer.threads (最大传输线程数) | 20480 |

| JournalNode | Java Heap Size (堆栈大小) | 1G |

3.3.1 数据块优化

dfs.blocksize = 128M

- 文件以块为单位进行切分存储,块通常设置的比较大(最小6M,默认128M),根据网络带宽计算最佳值。

- 块越大,寻址越快,读取效率越高,但同时由于MapReduce任务也是以块为最小单位来处理,所以太大的块不利于于对数据的并行处理。

- 一个文件至少占用一个块(如果一个1KB文件,占用一个块,但是占用空间还是1KB)

- 我们在读取HDFS上文件的时候,NameNode会去寻找block地址,寻址时间为传输时间的1%时,则为最佳状态。

- 目前磁盘的传输速度普遍为100MB/S

- 如果寻址时间约为10ms,则传输时间=10ms/0.01=1000ms=1s

- 如果传输时间为1S,传输速度为100MB/S,那么一秒钟我们就可以向HDFS传送100MB文件,设置块大小128M比较合适。

- 如果带宽为200MB/S,那么可以将block块大小设置为256M比较合适。

3.3.2 NameNode 的服务器线程的数量

- dfs.namenode.handler.count=20*log2(Cluster Size),比如集群规模为16 ,8以2为底的对数是4,故此参数设置为80

- dfs.namenode.service.handler.count=20*log2(Cluster Size),比如集群规模为16 ,8以2为底的对数是4,故此参数设置为80

NameNode有一个工作线程池,用来处理不同DataNode的并发心跳以及客户端并发的元数据操作。该值需要设置为集群大小的自然对数乘以20,。

3.3.3 DataNode 停止提供服务前允许失败的卷的数量

DN多少块盘损坏后停止服务,默认为0,即一旦任何磁盘故障DN即关闭。 对盘较多的集群(例如DN有超过2块盘),磁盘故障是常态,通常可以将该值设置为1或2,避免频繁有DN下线。

4 优化:YARN + MapReduce

| 服务 | 选项 | 配置值 | 参数说明 |

|---|---|---|---|

| ResourceManager | Java Heap Size (堆栈大小) | 4G | |

| ResourceManager | yarn.scheduler.minimum-allocation-mb (最小容器内存) | 2G | 给应用程序 Container 分配的最小内存 |

| ResourceManager | yarn.scheduler.increment-allocation-mb (容器内存增量) | 512M | 如果使用 Fair Scheduler,容器内存允许增量 |

| ResourceManager | yarn.scheduler.maximum-allocation-mb (最大容器内存) | 32G | 给应用程序 Container 分配的最大内存 |

| ResourceManager | yarn.scheduler.minimum-allocation-vcores (最小容器虚拟 CPU 内核数量) | 1 | 每个 Container 申请的最小 CPU 核数 |

| ResourceManager | yarn.scheduler.increment-allocation-vcores (容器虚拟 CPU 内核增量) | 1 | 如果使用 Fair Scheduler,虚拟 CPU 内核允许增量 |

| ResourceManager | yarn.scheduler.maximum-allocation-vcores (最大容器虚拟 CPU 内核数量) | 16 | 每个 Container 申请的最大 CPU 核数 |

| ResourceManager | yarn.resourcemanager.recovery.enabled | true | 启用后,ResourceManager 中止时在群集上运行的任何应用程序将在 ResourceManager 下次启动时恢复,备注:如果启用 RM-HA,则始终启用该配置。 |

| NodeManager | Java Heap Size (堆栈大小) | 4G | |

| NodeManager | yarn.nodemanager.resource.memory-mb | 40G | 可分配给容器的物理内存数量,参照资源池内存90%左右 |

| NodeManager | yarn.nodemanager.resource.cpu-vcores | 32 | 可以为容器分配的虚拟 CPU 内核的数量,参照资源池内存90%左右 |

| ApplicationMaster | yarn.app.mapreduce.am.command-opts | 右红 | 传递到 MapReduce ApplicationMaster 的 Java 命令行参数 "-Djava.net.preferIPv4Stack=true " |

| ApplicationMaster | yarn.app.mapreduce.am.resource.mb (ApplicationMaster 内存) | 4G | |

| JobHistory | Java Heap Size (堆栈大小) | 2G | |

| MapReduce | mapreduce.map.memory.mb (Map 任务内存) | 4G | 一个MapTask可使用的资源上限。如果MapTask实际使用的资源量超过该值,则会被强制杀死。 |

| MapReduce | mapreduce.reduce.memory.mb (Reduce 任务内存) | 8G | 一个 ReduceTask 可使用的资源上限。如果 ReduceTask 实际使用的资源量超过该值,则会被强制杀死 |

| MapReduce | mapreduce.map.cpu.vcores | 2 | 每个 MapTask 可使用的最多 cpu core 数目 |

| MapReduce | mapreduce.reduce.cpu.vcores | 4 | 每个 ReduceTask 可使用的最多 cpu core 数目 |

| MapReduce | mapreduce.reduce.shuffle.parallelcopies | 20 | 每个 Reduce 去 Map 中取数据的并行数。 |

| MapReduce | mapreduce.task.io.sort.mb(Shuffle 的环形缓冲区大小) | 512M | 当排序文件时要使用的内存缓冲总量。注意:此内存由 JVM 堆栈大小产生(也就是:总用户 JVM 堆栈 - 这些内存 = 总用户可用堆栈空间) |

| MapReduce | mapreduce.map.sort.spill.percent | 80% | 环形缓冲区溢出的阈值 |

| MapReduce | mapreduce.task.timeout | 10分钟 | Task 超时时间,经常需要设置的一个参数,该参数表 达的意思为:如果一个 Task 在一定时间内没有任何进 入,即不会读取新的数据,也没有输出数据,则认为 该 Task 处于 Block 状态,可能是卡住了,也许永远会 卡住,为了防止因为用户程序永远 Block 住不退出, 则强制设置了一个该超时时间。如果你的程序对每条输入数据的处理时间过长(比如会访问数据库,通过网络拉取数据等),建议将该参数调大,该参数过小常出现的错误提示是 :AttemptID:attempt_12267239451721_123456_m_00 0335_0 Timed out after 600 secsContainer killed by the ApplicationMaster。 |

5 优化:Impala

| 服务 | 选项 | 配置值 | 参数说明 |

|---|---|---|---|

| Impala Daemon | mem_limit (内存限制) | 50G | 由守护程序本身强制执行的 Impala Daemon 的内存限制。 如果达到该限制,Impalad Daemon 上运行的查询可能会被停止 |

| Impala Daemon | Impala Daemon JVM Heap | 512M | 守护进程堆栈大小 |

| Impala Daemon | scratch_dirs | 节点上多块独立磁盘(目录) | Impala Daemon 将溢出信息等数据写入磁盘以释放内存所在的目录。这可能是大量数据 |

| Impala Catalog Server | Java Heap Size | 8G | 堆栈大小 |

6 优化:Kafka

6.1 官方压测

6.1.1 Kafka Producer 压力测试

- record-size 是一条信息有多大,单位是字节。

- num-records 是总共发送多少条信息。

- throughput 是每秒多少条信息,设成-1,表示不限流,可测出生产者最大吞吐量。

bash /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/lib/kafka//bin/kafka-producer-perf-test.sh --topic test --record-size 100 --num-records 100000 --throughput -1 --producer-props bootstrap.servers=cdh01.cm:9092,cdh02.cm:9092,cdh03.cm:9092

100000 records sent, 225733.634312 records/sec (21.53 MB/sec),

8.20 ms avg latency, 66.00 ms max latency,

3 ms 50th, 28 ms 95th, 30 ms 99th, 30 ms 99.9th.

参数解析:一共写入 10w 条消息,吞吐量为 21.53 MB/sec,每次写入的平均延迟

为 8.20 毫秒,最大的延迟为 66.00 毫秒。

6.1.2 Kafka Consumer 压力测试

- zookeeper 指定 zookeeper 的链接信息

- topic 指定 topic 的名称

- fetch-size 指定每次 fetch 的数据的大小

- messages 总共要消费的消息个数

bash /opt/cloudera/parcels/CDH-6.2.0-1.cdh6.2.0.p0.967373/lib/kafka//bin/kafka-consumer-perf-test.sh --broker-list cdh01.cm:9092,cdh02.cm:9092,cdh03.cm:9092 --topic test --fetch-size 10000 --messages 10000000 --threads 1

start.time, end.time, data.consumed.in.MB, MB.sec, data.consumed.in.nMsg, nMsg.sec, rebalance.time.ms, fetch.time.ms, fetch.MB.sec, fetch.nMsg.sec

2020-06-11 17:53:48:179, 2020-06-11 17:54:04:525, 57.2205, 3.5006, 600000, 36706.2278, 3051, 13295, 4.3039, 45129.7480

start.time:2020-06-11 17:53:48:179 开始时间

end.time:2020-06-11 17:54:04:525 结束时间(用时16秒)

data.consumed.in.MB:57.2205 消费57M数据

MB.sec:3.5006 3.5M/S

data.consumed.in.nMsg:600000 消费60万消息

nMsg.sec:36706.2278 36706条消息/S

rebalance.time.ms:3051 平衡时间3S

fetch.time.ms:13295 抓取时间13S

fetch.MB.sec:4.3039 一秒抓取4.3M

fetch.nMsg.sec:45129.7480 一秒抓取45129条消息

开始测试时间,测试结束数据,共消费数据57.2205MB,吞吐量 3.5M/S,共消费600000条,平均每秒消费36706.2278条。

6.1.3 Kafka 机器数量计算

Kafka 机器数量(经验公式)= 2 X(峰值生产速度 X 副本数 /100)+ 1

先拿到峰值生产速度,再根据设定的副本数,就能预估出需要部署 Kafka 的数量。

比如我们的峰值生产速度是 50M/s。副本数为 2。

Kafka 机器数量 = 2 X( 50 X 2 / 100 )+ 1 = 3 台

6.2 参数调优

| 服务 | 选项 | 配置值 | 参数说明 |

|---|---|---|---|

| Kafka Broker | Java Heap Size of Broker | 2G | Broker堆栈大小 |

| Kafka Broker | Data Directories | 多块独立磁盘 | |

| Kafka 服务 | Maximum Message Size | 10M | 服务器可以接收的消息的最大大小。此属性必须与使用者使用的最大提取大小同步。否则,不守规矩的生产者可能会发布太大而无法消费的消息 |

| Kafka 服务 | Replica Maximum Fetch Size | 20M | 副本发送给leader的获取请求中每个分区要获取的最大字节数。此值应大于message.max.bytes。 |

| Kafka 服务 | Number of Replica Fetchers | 6 | 用于复制来自领导者的消息的线程数。增大此值将增加跟随者代理中I / O并行度。 |

7 优化:HBase

| 服务 | 选项 | 配置值 | 参数说明 |

|---|---|---|---|

| HBase | Java Heap Size | 18G | 客户端 Java 堆大小(字节)主要作用来缓存Table数据,但是flush时会GC,不要太大,根据集群资源,一般分配整个Hbase集群内存的70%,16->48G就可以了 |

| HBase | hbase.client.write.buffer | 512M | 写入缓冲区大小,调高该值,可以减少RPC调用次数,单数会消耗更多内存,较大缓冲区需要客户端和服务器中有较大内存,因为服务器将实例化已通过的写入缓冲区并进行处理,这会降低远程过程调用 (RPC) 的数量。 |

| HBase Master | Java Heap Size | 8G | HBase Master 的 Java 堆栈大小 |

| HBase Master | hbase.master.handler.count | 300 | HBase Master 中启动的 RPC 服务器实例数量。 |

| HBase RegionServer | Java Heap Size | 31G | HBase RegionServer 的 Java 堆栈大小 |

| HBase RegionServer | hbase.regionserver.handler.count | 100 | RegionServer 中启动的 RPC 服务器实例数量,根据集群情况,可以适当增加该值,主要决定是客户端的请求数 |

| HBase RegionServer | hbase.regionserver.metahandler.count | 60 | 用于处理 RegionServer 中的优先级请求的处理程序的数量 |

| HBase RegionServer | zookeeper.session.timeout | 180000ms | ZooKeeper 会话延迟(以毫秒为单位)。HBase 将此作为建议的最长会话时间传递给 ZooKeeper 仲裁 |

| HBase RegionServer | hbase.hregion.memstore.flush.size | 1G | 如 memstore 大小超过此值,Memstore 将刷新到磁盘。通过运行由 hbase.server.thread.wakefrequency 指定的频率的线程检查此值。 |

| HBase RegionServer | hbase.hregion.majorcompaction | 0 | 合并周期,在合格节点下,Region下所有的HFile会进行合并,非常消耗资源,在空闲时手动触发 |

| HBase RegionServer | hbase.hregion.majorcompaction.jitter | 0 | 抖动比率,根据上面的合并周期,有一个抖动比率,也不靠谱,还是手动好 |

| HBase RegionServer | hbase.hstore.compactionThreshold | 6 | 如在任意一个 HStore 中有超过此数量的 HStoreFiles,则将运行压缩以将所有 HStoreFiles 文件作为一个 HStoreFile 重新写入。(每次 memstore 刷新写入一个 HStoreFile)您可通过指定更大数量延长压缩,但压缩将运行更长时间。在压缩期间,更新无法刷新到磁盘。长时间压缩需要足够的内存,以在压缩的持续时间内记录所有更新。如太大,压缩期间客户端会超时。 |

| HBase RegionServer | hbase.client.scanner.caching | 1000 | 内存未提供数据的情况下扫描仪下次调用时所提取的行数。较高缓存值需启用较快速度的扫描仪,但这需要更多的内存且当缓存为空时某些下一次调用会运行较长时间 |

| HBase RegionServer | hbase.hregion.max.filesize | 50G | HStoreFile 最大大小。如果列组的任意一个 HStoreFile 超过此值,则托管 HRegion 将分割成两个 |

8 优化:Hive

| 服务 | 选项 | 配置值 | 参数说明 |

|---|---|---|---|

| HiveServer2 | Java Heap Size | 4G | |

| Hive MetaStore | Java Heap Size | 8G | |

| Hive Gateway | Java Heap Size | 2G | |

| Hive | hive.execution.engine | Spark | 执行引擎切换 |

| Hive | hive.fetch.task.conversion | more | Fetch抓取修改为more,可以使全局查找,字段查找,limit查找等都不走计算引擎,而是直接读取表对应储存目录下的文件,大大普通查询速度 |

| Hive | hive.exec.mode.local.auto(hive-site.xml 服务高级配置,客户端高级配置) | true | 开启本地模式,在单台机器上处理所有的任务,对于小的数据集,执行时间可以明显被缩短 |

| Hive | hive.exec.mode.local.auto.inputbytes.max(hive-site.xml 服务高级配置,客户端高级配置) | 50000000 | 文件不超过50M |

| Hive | hive.exec.mode.local.auto.input.files.max(hive-site.xml 服务高级配置,客户端高级配置) | 10 | 个数不超过10个 |

| Hive | hive.auto.convert.join | 开启 | 在join问题上,让小表放在左边 去左链接(left join)大表,这样可以有效的减少内存溢出错误发生的几率 |

| Hive | hive.mapjoin.smalltable.filesize(hive-site.xml 服务高级配置,客户端高级配置) | 50000000 | 50M以下认为是小表 |

| Hive | hive.map.aggr | 开启 | 默认情况下map阶段同一个key发送给一个reduce,当一个key数据过大时就发生数据倾斜。 |

| Hive | hive.groupby.mapaggr.checkinterval(hive-site.xml 服务高级配置,客户端高级配置) | 200000 | 在map端进行聚合操作的条目数目 |

| Hive | hive.groupby.skewindata(hive-site.xml 服务高级配置,客户端高级配置) | true | 有数据倾斜时进行负载均衡,生成的查询计划会有两个MR Job,第一个MR Job会将key加随机数均匀的分布到Reduce中,做部分聚合操作(预处理),第二个MR Job在根据预处理结果还原原始key,按照Group By Key分布到Reduce中进行聚合运算,完成最终操作 |

| Hive | hive.exec.parallel(hive-site.xml 服务高级配置,客户端高级配置) | true | 开启并行计算 |

| Hive | hive.exec.parallel.thread.number(hive-site.xml 服务高级配置,客户端高级配置) | 16G | 同一个sql允许的最大并行度,针对集群资源适当增加 |

9 优化:Oozie、Hue

| 服务 | 选项 | 配置值 | 参数说明 |

|---|---|---|---|

| Oozie | Java Heap Size | 1G | 堆栈大小 |

| Hue | Java Heap Size | 4G | 堆栈大小 |

环境篇:呕心沥血@CDH线上调优的更多相关文章

- 环境篇:Atlas2.0.0兼容CDH6.2.0部署

环境篇:Atlas2.0.0兼容CDH6.2.0部署 Atlas 是什么? Atlas是一组可扩展和可扩展的核心基础治理服务,使企业能够有效地满足Hadoop中的合规性要求,并允许与整个企业数据生态系 ...

- 环境篇:Atlas2.1.0兼容CDH6.3.2部署

环境篇:Atlas2.1.0兼容CDH6.3.2部署 Atlas 是什么? Atlas是一组可扩展和可扩展的核心基础治理服务,使企业能够有效地满足Hadoop中的合规性要求,并允许与整个企业数据生态系 ...

- 环境篇:Kylin3.0.1集成CDH6.2.0

环境篇:Kylin3.0.1集成CDH6.2.0 Kylin是什么? Apache Kylin™是一个开源的.分布式的分析型数据仓库,提供Hadoop/Spark 之上的 SQL 查询接口及多维分析( ...

- 环境篇:CM+CDH6.3.2环境搭建(全网最全)

环境篇:CM+CDH6.3.2环境搭建(全网最全) 一 环境准备 1.1 三台虚拟机准备 Master( 32g内存 + 100g硬盘 + 4cpu + 每个cpu2核) 2台Slave( 12g内存 ...

- 环境篇:DolphinScheduler-1.3.1安装部署及使用技巧

环境篇:DolphinScheduler-1.3.1安装部署 1 配置jdk JDK百度网盘:https://pan.baidu.com/s/1og3mfefJrwl1QGZGZDZ8Sw 提取码:t ...

- Java生产环境下性能监控与调优详解视频教程 百度云 网盘

集数合计:9章Java视频教程详情描述:A0193<Java生产环境下性能监控与调优详解视频教程>软件开发只是第一步,上线后的性能监控与调优才是更为重要的一步本课程将为你讲解如何在生产环境 ...

- 篇5 python自动化测试应用-Selenium环境篇

篇5 python自动化测试应用-Selenium环境篇 --lamecho 1.1概要 大家好!我是lamecho(辣么丑),从本篇开始我将开始 ...

- SpringBoot系列之profles配置多环境(篇二)

SpringBoot系列之profles配置多环境(篇二) 继续上篇博客SpringBoot系列之profles配置多环境(篇一)之后,继续写一篇博客进行补充 写Spring项目时,在测试环境是一套数 ...

- 第一篇:CDH配置本地http服务

在我们安装cdh的时候,避免不了要安装一大堆软件,包括cm的服务器,hadoop的各种组件.这些组件的文件都比较大,所以我们会在本地配置一个http服务,以便于在安装cdh服务的时候能快速的安装完.本 ...

随机推荐

- 11.1 Go Http

11.0 Go Http http客户端 package main import ( "fmt" "net/http" "net/http/httpu ...

- INNODB索引单列不能超767 复合不能超3072

innodb复合索引长度为什么是3072 我们知道InnoDB一个page的默认大小是16k.由于是Btree组织,要求叶子节点上一个page至少要包含两条记录(否则就退化链表了). ...

- ORM多表增删改查

一 创建多表 在models.py里创建4张表:Author(作者).AuthorDetail(作者详细信息).Publish(出版社).Book(书) 四张表关系为: (1)首先创建一对一关系.On ...

- Unity实现写入json文件

using System.Collections; using System.Collections.Generic; using UnityEngine; using LitJson; using ...

- MarkDown语法使用(效果版本)

function syntaxHighlighting() { var n = 33; var s = "hello, こんにちは"; console.log(s); } plai ...

- Django创建应用以及路由的配置

Django简介:是一个开放源代码的web 应用框架,由python 写成.初次发布于2005年7月,并于2008年9月发布了第一个正式版本1.0. 文件说明:manage.py:一个命令行工具,可以 ...

- Go 包管理中的常见问题

随处可见的GO111MODULE=on 在GitHub上,经常看到不少项目的readme里都有这么一句: ✗ GO111MODULE=on go get golang.org/x/tools/gopl ...

- Tortoise svn 基础知识

1 不跟踪文件.文件夹 1.1 文件.文件夹已经被svn跟踪 将本地文件.文件夹删除(windows删除文件的删除,快捷键是shift+delete),然后执行svn update 将服务器同步到 ...

- [nginx报错问题]reload时报错:nginx: [error] invalid PID number "" in ...

错误 第一次探索nginx,执行以下命令时: nginx -s reload 报出错误: nginx: [error] invalid PID number "" in ... * ...

- ansible模块详解

[简单介绍] Ansible是一种agentless(基于ssh),可实现批量配置.命令执行和控制,基于Python实现的自动化运维工具. 有以下两个特性: 模块化:通过调用相关模块,完成指定任务,且 ...