Hadoop入门 之 Hadoop的安装

1.安装Hadoop的三大步骤

答:1.Linux环境,2.JDK环境,3.配置Hadoop。

2.安装Linux

答:利用阿里云,腾讯云等公有云。选择Ubuntu进行安装,然后利用小putty进行操作。

3.安装JDK,设置环境变量

答:命令:ls,javac看是否安装有jdk,apk-get install openjdk-7-jdk进行安装。安装完毕之后设置环境变量,vim /etc/profile,添加下面四行。

export JAVA_HOME=/jdk的安装路径

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=$JAVA_HOME/lib:$JRE_HOME/lib:$CALSSPATH

export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH

保存一下,vim etc/profile,source /etc/profile。到此,jdk就安装完毕了,可以在任何目录下javac。

4.下载安装配置Hadoop

答:(1)下载安装包 wget http://mirror.bit.edu.cn/apache/hadoop/common/hadoop-1.2.1/hadoop-1.2.1.tar.gz。ls查看当前目录的文件夹,把安装包放到指定文件夹opt中,mv hadoop-1.2.1.tar.gz /opt/,cd opt,ls,解压压缩包tar -zxvf hadoop-1.2.1.tar.gz

cd hadoop1.2.1/,看到主要配置文件在conf里面,cd conf,看到里面有四个需要配置的文件map-red-site.xml,core-site.xml,hdfs-site.xml,hadoop-env.sh。

第一,我们打开 vim hadoop-env.sh,echo JAVA_HOME打印出jdk的安装路径,修改export JAVA_HOME=/jdk路径,wq保存一下。

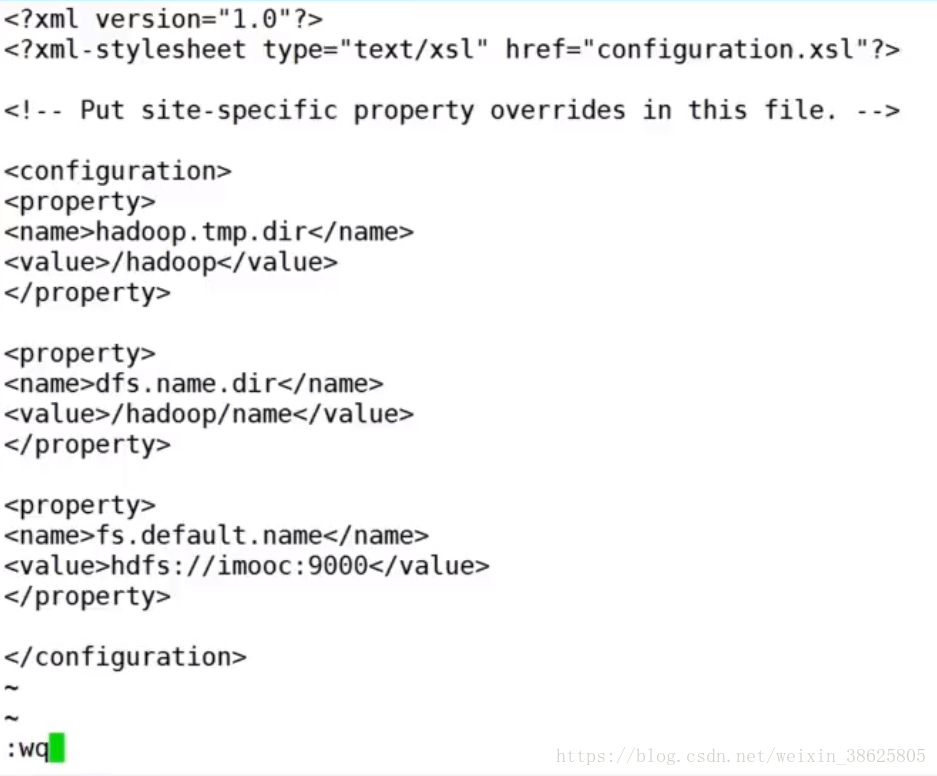

第二,打开 vim core-site.xml,添加如图2.

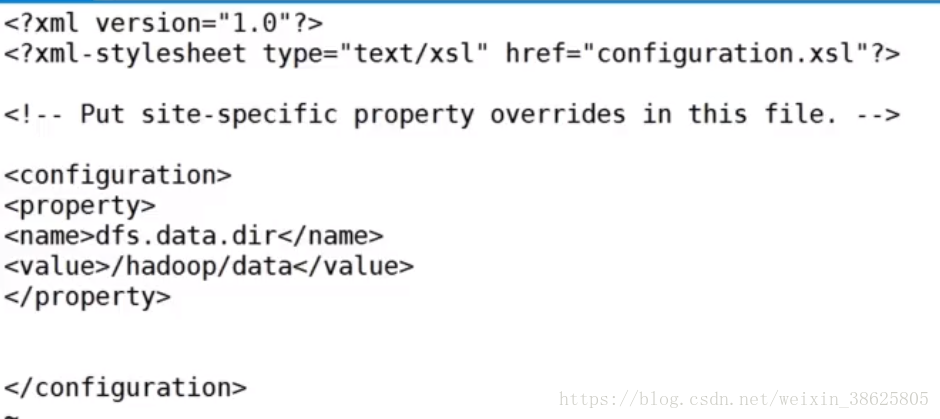

第三,vim hdfs-site.xml

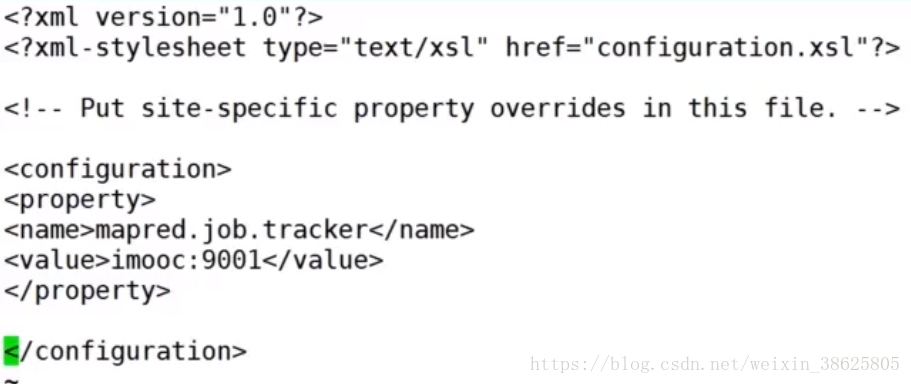

第四,vim map-red-site.xml

第五,告诉系统我们的Hadoop位置,vim /etc/profile,加入,export HADOOP_HOME=/opt/Hadoop1.2.1,在PATH中,增加

:$HADOOP_HOME/bin:$PATH,wq保存,再source /etc/profile生效,这时命令行输入hadoop,cd ..,cd bin/,ls

第六,hadoop namenode -format,进行格式化namenode

5.启动Hadoop

答:cd /otc/hadoop1.2.1/bin/,ls,start-all.sh,然后输入jps,查看当前Hadoop的进程,查看Hadoop下有哪些文件,hadoop fs -ls/

Hadoop入门 之 Hadoop的安装的更多相关文章

- 大数据初级笔记二:Hadoop入门之Hadoop集群搭建

Hadoop集群搭建 把环境全部准备好,包括编程环境. JDK安装 版本要求: 强烈建议使用64位的JDK版本,这样的优势在于JVM的能够访问到的最大内存就不受限制,基于后期可能会学习到Spark技术 ...

- hadoop入门:hadoop使用shell命令总结

第一部分:Hadoop Bin后面根据项目的实际需要Hadoop Bin 包括:Hadoop hadoop的Shellhadoop-config.sh 它的作用是对一些变量进行赋值 HAD ...

- Hadoop入门——初识Hadoop

一.hadoop是什么 Hadoop被公认是一套行业大数据标准开源软件,在分布式环境下提供了海量数据的处理能力.几乎所有主流厂商都围绕Hadoop开发工具.开源软件.商业化工具和技术服务.今年大型IT ...

- hadoop入门篇-hadoop下载安装教程(附图文步骤)

在前几篇的文章中分别就虚拟系统安装.LINUX系统安装以及hadoop运行服务器的设置等内容写了详细的操作教程,本篇分享的是hadoop的下载安装步骤. 在此之前有必要做一个简单的说明:分享的所有内容 ...

- Hadoop入门 之 Hadoop常识

1.Hadoop是什么? 答:Hadoop是开源的分布式存储和分布式计算平台. 2.Hadoop的组成是什么? 答:Hadoop由HDFS和MapReduce这两个核心部分组成. HDFS(Hadoo ...

- Hadoop入门必须知道的简单知识

Hadoop入门知识 Hadoop构成 Hadoop由4个主要构成部分: 1) 基础核心:提供基础的通用的功能 2) HDFS:分布式存储 3) MapReduce:分布式计算 4) YARN:资源分 ...

- 初识Hadoop入门介绍

初识hadoop入门介绍 Hadoop一直是我想学习的技术,正巧最近项目组要做电子商城,我就开始研究Hadoop,虽然最后鉴定Hadoop不适用我们的项目,但是我会继续研究下去,技多不压身. < ...

- hadoop入门(3)——hadoop2.0理论基础:安装部署方法

一.hadoop2.0安装部署流程 1.自动安装部署:Ambari.Minos(小米).Cloudera Manager(收费) 2.使用RPM包安装部署:Apache ...

- Hadoop入门之安装配置(hadoop-0.20.2)

Hadoop,简单理解为HDFS(分布式存储)+Mapreduce(分布式处理),专为离线和大规模数据分析而设计. Hadoop可以把很多linux的廉价PC组成分布式结点,然后编程人员也不需要知道分 ...

随机推荐

- nodeCZBK-笔记2

目录 day04 mongoDB数据库使用 day05 node使用mongoDB数据库 day04 mongoDB数据库使用 电脑全局安装数据库 开机命令:mongod --dbpath c:\mo ...

- Math和Date

Math和Date 一.对象 1.对象的概念 对象的本质:键值对,属性名和属性值 对象的意义:存储数据,编程 对象中的变量:属性 对象中的函数:方法 2.对象的赋值 var obj = {}; var ...

- 外观/门面模式(Facade)

2015/4/28 外观/门面模式(Facade),为子系统中的一组接口提供一个一致的界面,此模式定义了一个高层接口,这个接口使得这一子系统更加容易使用. #include <vector> ...

- python基础知识补充

set 集合 {} 无序 集合天然去重 增 : s.add s.update 迭代添加 删 : s.pop( ) 随机删除 返回删除值 s.clear( ) 清空 获取到的是 set( ) del s ...

- xgboost保险赔偿预测

XGBoost解决xgboost保险赔偿预测 import xgboost as xgb import pandas as pd import numpy as np import pickle im ...

- unity_数据结构(常见数据结构及适用场景)

常见的数据结构: 1.Array: 最简单的数据结构 特点:数组存储在连续的内存上.数组的内容都是相同类型.数组可以直接通过下标访问.优点:由于是在连续内存上存储的,所以它的索引速度非常快,访问一个元 ...

- Delphi - cxGrid字段类型设定为ComboBox 并实现动态加载Item

cxGrid设定字段类型为ComboBox 在cxGrid中选中需要设定的字段: 单击F11调出属性控制面板,在Properties下拉选项中选中ComboBox,完成字段类型的设定. cxGrid ...

- Spring Boot 2.0 教程 | 快速集成整合消息中间件 Kafka

欢迎关注个人微信公众号: 小哈学Java, 每日推送 Java 领域干货文章,关注即免费无套路附送 100G 海量学习.面试资源哟!! 个人网站: https://www.exception.site ...

- CodeForces 283C World Eater Brothers

World Eater Brothers 题解: 树DP, 枚举每2个点作为国家. 然后计算出最小的答案. 首先我们枚举根, 枚举根了之后, 我们算出每个点的子树内部和谐之后的值是多少. 这样val[ ...

- CodeForces 758 D Ability To Convert

Ability To Convert 题意:给你一个n进制的60位的数,但是由于Alexander只会写0->9,所以他就会用10来表示十而不是A(假设进制>10); 题解:模拟就好了,先 ...