Lucene05-分词器

Lucene05-分词器

1、概念

Analyzer(分词器)的作用是把一段文本中的词按规则取出所包含的所有词。对应的是Analyzer类,这是一个抽象类,切分词的具体规则是由子类实现的,所以对于不同的语言(规则),要用不同的分词器。如下图

注意:在创建索引时会用到分词器,在使用字符串搜索时也会用到分词器,这两个地方要使用同一个分词器,否则可能会搜索不出结果。所以当改变分词器的时候,需要重新建立索引库

2、常见的中文分词器

中文的分词比较复杂,因为不是一个字就是一个词,而且一个词在另外一个地方就可能不是一个词,如在“帽子和服装”中,“和服”就不是一个词。对于中文分词,通常有三种方式:单字分词、二分法分词、词典分词

2.1 单字分词

就是按照中文一个字一个字地进行分词,效率比较低。如:“我们是中国人”,效果:“我”、“们”、“是”、“中”、“国”、“人”。(StandardAnalyzer就是这样)

Analyzer analyzer2 = new StandardAnalyzer();

2.2 二分法分词

按两个字进行切分,把相邻的两个字组成词分解出来,效率也比较低。而且很多情况下分的词不对。如:“我们是中国人”,效果:“我们”、“们是”、“是中”、“中国”、“国人”。(CJKAnalyzer就是这样)

Analyzer analyzer3 = new CJKAnalyzer(Version.LUCENE_30);

2.3 词库分词(IKAnalyzer)

按某种算法构造词,然后去匹配已建好的词库集合,如果匹配到就切分出来成为词语。通常词库分词被认为是最理想的中文分词算法。如:“我们是中国人”,效果为:“我们”、“中国人”。(使用极易分词的MMAnalyzer。可以使用“极易分词”,或者是“庖丁分词”分词器、IKAnalyzer)。

Analyzer analyzer4 = new IKAnalyzer();

基本上可以把词分出来(经常用的分词器)

3、IDEA集成IKAnalyzer

3.1 添加maven依赖

- <!-- IK分词器-->

- <dependency>

- <groupId>com.github.magese</groupId>

- <artifactId>ik-analyzer</artifactId>

- <version>7.4.0</version>

- </dependency>

3.2 添加配置文件

停用词和扩展词以及配置文件

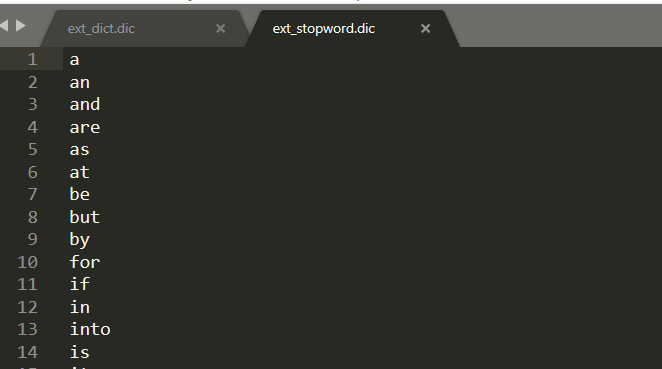

ext_stopword.dic为停用词的词库,词库里的词都被当作为停用词使用。

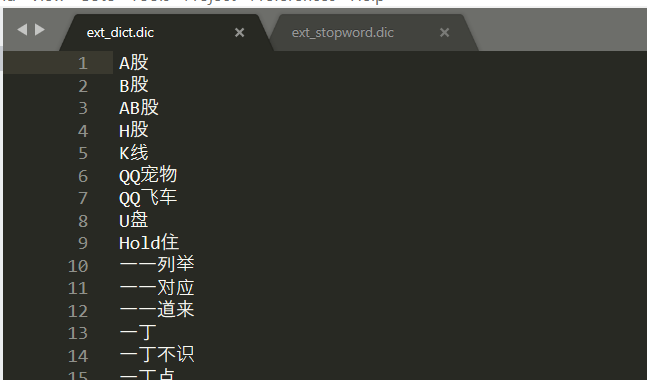

ext_dict.dic 为扩用词的词库,词库里的词都被当作为扩用词使用。

停用词:有些词在文本中出现的频率非常高。但对本文的语义产生不了多大的影响。例如英文的a、an、the、of等。或中文的”的、了、呢等”。这样的词称为停用词。停用词经常被过滤掉,不会被进行索引。在检索的过程中,如果用户的查询词中含有停用词,系统会自动过滤掉。停用词可以加快索引的速度,减少索引库文件的大小。

扩展词:就是不想让哪些词被分开,让他们分成一个词。比如传智播客、传智

IKAnalyzer.cfg.xml为IKAnalyzer的配置文件。

- <?xml version="1.0" encoding="UTF-8"?>

- <!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

- <properties>

- <comment>IK Analyzer 扩展配置</comment>

- <!--用户可以在这里配置自己的扩展字典 -->

- <entry key="ext_dict">ext_dict.dic;</entry>

- <!--用户可以在这里配置自己的扩展停止词字典-->

- <entry key="ext_stopwords">ext_stopword.dic;</entry>

- </properties>

3.3 测试分词器

添加测试类

代码如下:

- import org.apache.lucene.analysis.Analyzer;

- import org.apache.lucene.analysis.TokenStream;

- import org.apache.lucene.analysis.cjk.CJKAnalyzer;

- import org.apache.lucene.analysis.standard.StandardAnalyzer;

- import org.apache.lucene.analysis.tokenattributes.CharTermAttribute;

- import org.junit.Test;

- import org.wltea.analyzer.lucene.IKAnalyzer;

- import java.io.IOException;

- import java.io.StringReader;

- /**

- * @author PC-Black

- * @version v1.0

- * @date 2019/7/20 18:39

- * @description TODO

- **/

- public class AnalayzerTest {

- @Test

- public void testIKAnalyzer()throws IOException {

- //使用lucene 自带的标准分词器...

- IKAnalyzer analyzer = new IKAnalyzer();

- // Analyzer analyzer=new CJKAnalyzer();

- // Analyzer analyzer=new StandardAnalyzer();

- analyzer(analyzer,"最贵的苹果4");

- }

- public static void analyzer(Analyzer analyzer, String str) throws IOException {

- StringReader reader = new StringReader(str);

- //处理单个字符组成的字符流,读取Reader对象中的数据,处理后转换成词汇单元

- TokenStream tokenStream = analyzer.tokenStream(str, reader);

- // 清空流

- try {

- tokenStream.reset();

- } catch (IOException e) {

- e.printStackTrace();

- }

- CharTermAttribute attribute = tokenStream.getAttribute(CharTermAttribute.class);

- try {

- while (tokenStream.incrementToken()) {

- System.out.print(attribute.toString()+"|");

- }

- } catch (IOException e) {

- e.printStackTrace();

- }

- }

- }

单字分词器

二分法分词

IK分词

Lucene05-分词器的更多相关文章

- solr服务中集成IKAnalyzer中文分词器、集成dataimportHandler插件

昨天已经在Tomcat容器中成功的部署了solr全文检索引擎系统的服务:今天来分享一下solr服务在海量数据的网站中是如何实现数据的检索. 在solr服务中集成IKAnalyzer中文分词器的步骤: ...

- 如何在Elasticsearch中安装中文分词器(IK+pinyin)

如果直接使用Elasticsearch的朋友在处理中文内容的搜索时,肯定会遇到很尴尬的问题--中文词语被分成了一个一个的汉字,当用Kibana作图的时候,按照term来分组,结果一个汉字被分成了一组. ...

- 11大Java开源中文分词器的使用方法和分词效果对比

本文的目标有两个: 1.学会使用11大Java开源中文分词器 2.对比分析11大Java开源中文分词器的分词效果 本文给出了11大Java开源中文分词的使用方法以及分词结果对比代码,至于效果哪个好,那 ...

- [Linux]Linux下安装和配置solr/tomcat/IK分词器 详细实例一.

在这里一下讲解着三个的安装和配置, 是因为solr需要使用tomcat和IK分词器, 这里会通过图文教程的形式来详解它们的安装和使用.注: 本文属于原创文章, 如若转载,请注明出处, 谢谢.关于设置I ...

- Apache Lucene(全文检索引擎)—分词器

目录 返回目录:http://www.cnblogs.com/hanyinglong/p/5464604.html 本项目Demo已上传GitHub,欢迎大家fork下载学习:https://gith ...

- Elasticsearch初步使用(安装、Head配置、分词器配置)

目录 返回目录:http://www.cnblogs.com/hanyinglong/p/5464604.html 1.ElasticSearch简单说明 a.ElasticSearch是一个基于Lu ...

- IK分词器 整合solr4.7 含同义词、切分词、停止词

转载请注明出处! IK分词器如果配置成 <fieldType name="text_ik" class="solr.TextField"> < ...

- Elasticsearch5.1.1+ik分词器+HEAD插件安装小记

一.安装elasticsearch 1.首先需要安装好java,并配置好环境变量,详细教程请看 http://tecadmin.net/install-java-8-on-centos-rhel-an ...

- 转:solr6.0配置中文分词器IK Analyzer

solr6.0中进行中文分词器IK Analyzer的配置和solr低版本中最大不同点在于IK Analyzer中jar包的引用.一般的IK分词jar包都是不能用的,因为IK分词中传统的jar不支持s ...

- 我与solr(六)--solr6.0配置中文分词器IK Analyzer

转自:http://blog.csdn.net/linzhiqiang0316/article/details/51554217,表示感谢. 由于前面没有设置分词器,以至于查询的结果出入比较大,并且无 ...

随机推荐

- Visual Studio一直弹出“未将对象引用设置到对象的实例”对话框的处理

试了一下,VS2017更新到最新版本的时候,会有这个错误.相当于是相当编辑XAML界面的时候会弹出,程序真正执行的时候反而不会弹出. 应该是最新的VS2017在显示XAML编辑界面的时候,会执行一部分 ...

- delphi 程序强制结束自身(两种方法都暴力)

procedure KillSelf;begin Sleep(1000); if not TerminateProcess(GetCurrentProcessId, 0) then WinExe ...

- DOTNET CORE DATETIME在LINUX与WINDOWS时间不一致

.net core项目,部署到CentOS上的时候,发现DateTime.Now获取的时间与Windows不一致,主要是时区不一致. static void Main(string[] args) { ...

- 用TTcpClient和TTcpServer进行文件的传输

发送数据时有Sendln,SendBuf,SendStream.接收数据时有Receiveln,ReceiveBuf,当时我很奇怪为什么没有ReceiveStream.因为很自然的想到是对应关系的.但 ...

- C++开源库,欢迎补充

C++在“商业应用”方面,曾经是天下第一的开发语言,但这一桂冠已经被java抢走多年.因为当今商业应用程序类型,已经从桌面应用迅速转移成Web应 用.当Java横行天下之后,MS又突然发力,搞出C#语 ...

- QTcpSocket 对连接服务器中断的不同情况进行判定(六种情况,其中一种使用IsNetworkAlive API方法)

简述 对于一个C/S结构的程序,客户端有些时候需要实时得知与服务器的连接状态.而对于客户端与服务器断开连接的因素很多,现在就目前遇到的情况进行一下总结. 分为下面六种不同情况 客户端网线断开 客户端网 ...

- php 的mvc开发

至于什么MVC结构,其实就是三个Model,Contraller,View单词的简称,,Model,主要任务就是把数据库或者其他文件系统的数据按 照我们需要的方式读取出来.View,主要负责页面的,把 ...

- 简单看看jdk7源码之java.lang包01

从今天开始简单开始读一遍jdk的源码,估计这个时间会很长,慢慢啃吧....(首先说一句抱歉,因为很多图都是直接百度扣的,图太多了不能为每一个图附上原版链接,不好意思!) 在网上看了很多的教程,读源码有 ...

- Netty源码分析--初始化Options,添加处理器(四)

接上篇,我们继续进入AbstractBootstrap类的 initAndRegister() 方法 进入init()方法 设置父级Channel的options, 进入到上节提到的NioServer ...

- C# RESTful API 访问辅助类

REST 全称是 Representational State Transfer,有人说它是一种风格,并非一种标准,个人觉得挺有道理.它本身并没有创造新的技术.组件与服务,更像是告诉大家如何更好地使用 ...