在eclipse使用map reduce编写word count程序生成jar包并在虚拟机运行的步骤

---恢复内容开始---

1.首先准备一个需要统计的单词文件 word.txt,我们的单词是以空格分开的,统计时按照空格分隔即可

hello hadoop

hello yarn

hello zookeeper

hdfs hadoop

select from hadoop

select from yarn

mapReduce

MapReduce

2.上传word.txt到hdfs根目录

$ bin/hdfs dfs -put test/word.txt /

3.准备工作完成后在eclipse编写代码,分别编写Map、Reduce、Driver等Java文件

WordCountMap.java

map执行我们的word.txt 文件是按行执行,每一行执行一个map

WordCountMap.java

map执行我们的word.txt 文件是按行执行,每一行执行一个map

package com.ijeffrey.mapreduce.wordcount.client;

import java.io.IOException;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

/**

* map 输出的键值对必须和reducer输入的键值对类型一致

* @author PXY

*

*/

public class WordCountMap extends Mapper<LongWritable, Text, Text, IntWritable> {

private Text keyout = new Text();

private IntWritable valueout = new IntWritable(1);

@Override

protected void map(LongWritable key, Text value, Mapper<LongWritable, Text, Text, IntWritable>.Context context)

throws IOException, InterruptedException {

String line = value.toString();

// 我的文件记录的单词是以空格记录单词,所以这里用空格来截取

String[] words = line.split(" ");

// 遍历数组,并以k v 对的形式输出

for (String word : words) {

keyout.set(word);

context.write(keyout, valueout);

}

}

}

WordCountReducer.java

package com.ijeffrey.mapreduce.wordcount.client;

import java.io.IOException;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;

/**

* reducer 输入的键值对必须和map输出的键值对类型一致

* map <hello,1> <world,1> <hello,1> <apple,1> ....

* reduce 接收 <apple,[1]> <hello,[1,1]> <world,[1]>

* @author PXY

*

*/

public class WordCountReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable valueout = new IntWritable();

@Override

protected void reduce(Text key, Iterable<IntWritable> values,

Reducer<Text, IntWritable, Text, IntWritable>.Context context) throws IOException, InterruptedException {

int count = 0; // 统计总数

// 遍历数组,累加求和

for(IntWritable value : values){

// IntWritable类型不能和int类型相加,所以需要先使用get方法转换成int类型

count += value.get();

}

// 将统计的结果转成IntWritable

valueout.set(count);

// 最后reduce要输出最终的 k v 对

context.write(key, valueout);

}

}

WordCountDriver.java

package com.ijeffrey.mapreduce.wordcount.client;

import java.io.IOException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

/**

* 运行主函数

* @author PXY

*

*/

public class WordCountDriver {

public static void main(String[] args) throws IOException, ClassNotFoundException, InterruptedException {

Configuration conf = new Configuration();

// 获得一个job对象,用来完成一个mapreduce作业

Job job = Job.getInstance(conf);

// 让程序找到主入口

job.setJarByClass(WordCountDriver.class);

// 指定输入数据的目录,指定数据计算完成后输出的目录

// sbin/yarn jar share/hadoop/xxxxxxx.jar wordcount /wordcount/input/ /wordcount/output/

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

// 告诉我调用那个map方法和reduce方法

job.setMapperClass(WordCountMap.class);

job.setReducerClass(WordCountReducer.class);

// 指定map输出键值对的类型

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class);

// 指定reduce输出键值对的类型

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

// 提交job任务

boolean result = job.waitForCompletion(true);

System.exit(result ? 0 : 1);

}

}

}

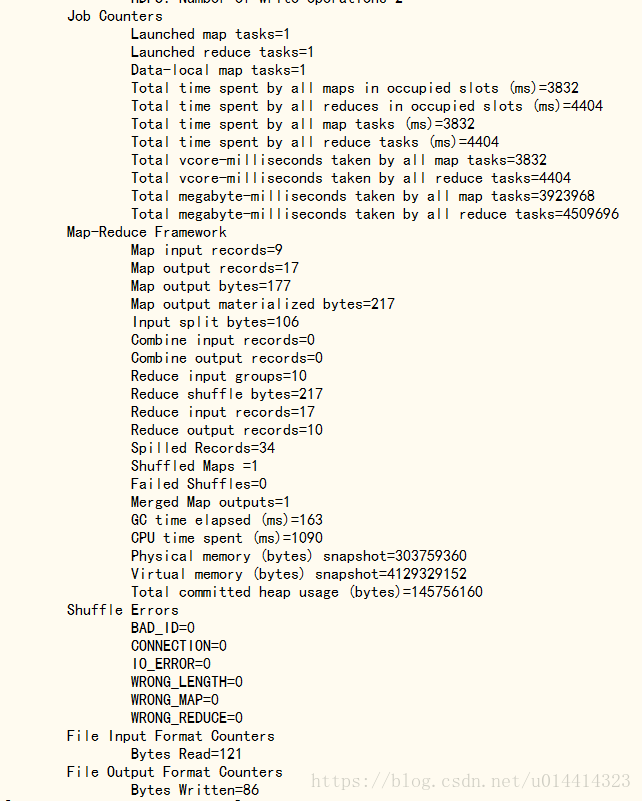

4.将编写完成的代码打成jar包,并在集群上运行

将jar上传到到服务器,启动服务后运行我们自己编写的MapReduce,统计根目录下的word.txt并将运行结果写入output

$ bin/yarn jar test/wordCount.jar com.ijeffrey.mapreduce.wordcount.client.WordCountDriver /word.txt /output

注意:运行jar的时候要添加Driver的完全路径

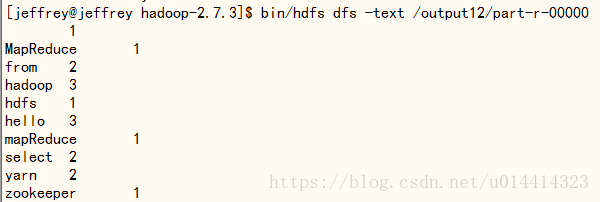

运行完成后查看output结果:

$ bin/hdfs dfs -text /output12/part-r-00000

在eclipse使用map reduce编写word count程序生成jar包并在虚拟机运行的步骤的更多相关文章

- Eclipse笔记-sun.misc.BASE64Encoder找不到jar包的解决方法

从SVN检出新项目,在Eclipse中报错如下: 转: Eclipse笔记-sun.misc.BASE64Encoder找不到jar包的解决方法 2018-01-04 00:36:20 雨临Lewis ...

- spark编写word count

创建SparkContext对象的时候需要传递SparkConf对象,SparkConf至少需要包含spark.master和spark.app.name这两个参数,不然的话程序不能正常运行 obje ...

- 在Eclipse上打包并使用Proguard工具混淆jar包

近期由于工作须要,学习到了Android jar包的打包与混淆. 之前觉得还是非常easy的,可是自己深入研究下,发现还是有一些东西须要注意的,并且自己也踩了一些坑,在这里写下供同僚们借鉴借鉴. 转载 ...

- Eclipse中如何添加相对路径的外部jar包

在eclipse中进行java编程的时候,常常需要引用外部jar包.而采用相对路径引用jar包可以大大方便java工程的拷贝,这样使得java工程从一个路径转移到另一个路径时不用大费周章的修改外包ja ...

- java 项目打jar包,用cmd运行,并且编写运行脚本

项目是ideal编辑器的springboot项目的demo.打包就是在侧边栏,点击packge ,就会在target下生成jar包. 生成之后把 jar包放在一个文件夹中.新建一个txt文件,在txt ...

- eclipse将javaSE项目导出成可执行jar包

将第三方包和项目打包到一块 step1:选中要导出的项目,右键选择Export step2:选择java/Runable JAR file step3:选择main主程序,选择第三方包打包的形式,推荐 ...

- Hive中自定义Map/Reduce示例 In Python

Hive支持自定义map与reduce script.接下来我用一个简单的wordcount例子加以说明.使用Python开发(如果使用Java开发,请看这里). 开发环境: python:2.7.5 ...

- Hadoop学习笔记2 - 第一和第二个Map Reduce程序

转载请标注原链接http://www.cnblogs.com/xczyd/p/8608906.html 在Hdfs学习笔记1 - 使用Java API访问远程hdfs集群中,我们已经可以完成了访问hd ...

- Hadoop Map/Reduce教程

原文地址:http://hadoop.apache.org/docs/r1.0.4/cn/mapred_tutorial.html 目的 先决条件 概述 输入与输出 例子:WordCount v1.0 ...

随机推荐

- MySQL练习50题

介绍一个学习SQL的网站:https://sqlbolt.com/ 习题来源于网络,SQL语句是自己的练习答案,部分参考了网络上的答案. 花了一晚上的时间做完,个人认为其中的难点有:分组提取前几名的数 ...

- pandas-Notes2

#coding = utf-8 import pandas as pd import numpy as np import matplotlib as plt dates = pd.date_rang ...

- PAT Basic 1080

1080 MOOC期终成绩 对于在中国大学MOOC(http://www.icourse163.org/ )学习“数据结构”课程的学生,想要获得一张合格证书,必须首先获得不少于200分的在线编程作业分 ...

- 2015多校训练第二场 hdu5305

把这题想复杂了,一直在考虑怎么快速的判断将选的边和已选的边无冲突,后来经人提醒发现这根本没必要,反正数据也不大开两个数组爆搜就OK了,搜索之前要先排除两种没必要搜的情况,这很容易想到,爆搜的时候注意几 ...

- 如何理解C4.5算法解决了ID3算法的偏向于选择取值较多的特征问题

如何理解C4.5算法解决了ID3算法的偏向于选择取值较多的特征问题 考虑一个极端情况,某个属性(特征)的取值很多,以至于每一个取值对应的类别只有一个.这样根据\[H(D) - H(D|A)\]可以得知 ...

- [python IO学习篇]补充打开中文路径的文件

http://blog.csdn.net/mottolinux/article/details/525600621 关于Python编码的基本常识 在python里面 “明文”是unicode类型和s ...

- 在springmvc中使用@PathVariable时,应该注意点什么?

导读:近来在做库存调剂系统时,我从前台到后台的传值方式,主要包括:1个,用@PathVariable或者@RequestParam从路径取:大于一个,用于更新或者添加操作的,我用的是表单实体传到后台: ...

- ThinkPHP5杂技(二)

不要使用数据库查询嵌套 if (!$listA = Db::name('coin') ->field('id,symbol') ->where('id', 'IN', logic('All ...

- PHP curl 封装 GET及POST方法很不错的

<?php function curl_get($url, array $params = array(), $timeout = 5) { $ch = curl_init(); curl_se ...

- HDU-1529 Cashier Employment

据网上说这是到差分约束四星题... 可我觉得难吗? 比推DP方程容易... 两种约束方式,当然实现到程序就变成六种了... #include <cstdio> #include <c ...