日志收集系统系列(三)之LogAgent

一、什么是LogAhent

类似于在linux下通过tail的方法读日志文件,将读取的内容发给kafka,这里的tailf是可以动态变化的,当配置文件发生变化时,可以通知我们程序自动增加需要增加的配置文件。tailf去获取相应的日志并发给kafka producer。主要包含kafka、tailf和configlog。LogAgent工作流程

读日志--

tailf第三方库在

kafka写日志 --sarama第三方库读取配置文件 --

"gopkg.in/ini.v1"

二、tail

1. 下载

go get github.com/hpcloud/tail

2. 使用示例

package main import (

"fmt"

"github.com/hpcloud/tail"

"time"

) func main() {

fileName := "./my.log"

config := tail.Config{

ReOpen: true, // 重新打开

Follow: true, // 是否跟随

Location: &tail.SeekInfo{Offset: 0, Whence: 2}, // 从文件的哪个地方开始读

MustExist: false, // 文件不存在不报错

Poll: true,

}

tails, err := tail.TailFile(fileName, config)

if err != nil {

fmt.Println("tail file failed, err:", err)

return

}

var (

line *tail.Line

ok bool

)

for {

line, ok = <-tails.Lines//遍历chan,读取日志内容

if !ok {

fmt.Printf("tail file close reopen, filename:%s\n", tails.Filename)

time.Sleep(time.Second)

continue

}

fmt.Println("line:", line.Text)

}

}

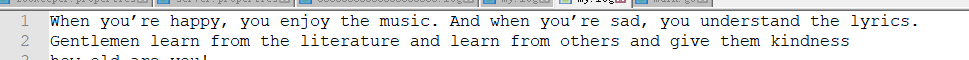

使用说明

首先初始化配置结构体config

调用

TailFile函数,并传入文件路径和config,返回有个tail的结构体,tail结构体的Lines字段封装了拿到的信息遍历

tail.Lnes字段,取出信息(注意这里要循环的取,因为tail可以实现实时监控)

运行

三、sarama

1. 下载

go get github.com/Shopify/sarama

2. 生产消费示例

package main import (

"fmt"

"github.com/Shopify/sarama"

) func main() {

config := sarama.NewConfig()

config.Producer.RequiredAcks = sarama.WaitForAll // 发送完数据需要leader和follow都确认

config.Producer.Partitioner = sarama.NewRandomPartitioner // 新选出一个partition

config.Producer.Return.Successes = true // 成功交付的消息将在success channel返回 // 构造一个消息

msg := &sarama.ProducerMessage{}

msg.Topic = "web_log"

msg.Value = sarama.StringEncoder("this is a test log")

// 连接kafka

client, err := sarama.NewSyncProducer([]string{"127.0.0.1:9092"}, config)

if err != nil {

fmt.Println("producer closed, err:", err)

return

}

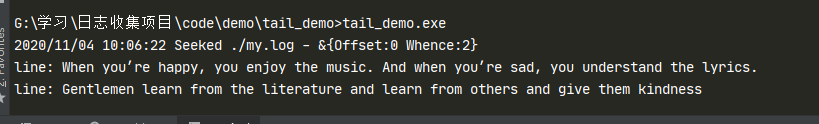

fmt.Println("kafka 连接成功!")

defer client.Close()

// 发送消息

pid, offset, err := client.SendMessage(msg)

if err != nil {

fmt.Println("send msg failed, err:", err)

return

}

fmt.Printf("pid:%v offset:%v\n", pid, offset)

print("发送成功!")

}

- 运行

- kafka文件

3. 消费示例

package main import (

"fmt"

"github.com/Shopify/sarama"

) // kafka consumer func main() {

consumer, err := sarama.NewConsumer([]string{"127.0.0.1:9092"}, nil)

if err != nil {

fmt.Printf("fail to start consumer, err:%v\n", err)

return

}

partitionList, err := consumer.Partitions("web_log") // 根据topic取到所有的分区

if err != nil {

fmt.Printf("fail to get list of partition:err%v\n", err)

return

}

fmt.Println("分区: ", partitionList)

for partition := range partitionList { // 遍历所有的分区

// 针对每个分区创建一个对应的分区消费者

pc, err := consumer.ConsumePartition("web_log", int32(partition), sarama.OffsetNewest)

if err != nil {

fmt.Printf("failed to start consumer for partition %d,err:%v\n", partition, err)

return

}

defer pc.AsyncClose()

// 异步从每个分区消费信息

go func(sarama.PartitionConsumer) {

for msg := range pc.Messages() {

fmt.Printf("Partition:%d Offset:%d Key:%s Value:%s\n", msg.Partition, msg.Offset, msg.Key, msg.Value)

}

}(pc)

}

select {}

}

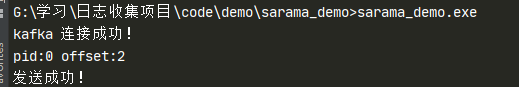

四、简易版LogAgent

1. 项目结构

│ go.mod

│ go.sum

│ main.go

│ my.log

├─conf

│ config.go

│ config.ini

│

├─kafka

│ kafka.go

│

└─taillog

taillog.go

2. 配置文件

[kafka]

address=127.0.0.1:9092

topic=web_log [taillog]

filename=./my.log

config/config.go

package conf

type Config struct {

Kafka Kafka `ini:"kafka"`

TailLog TailLog `ini:"taillog"`

}

type Kafka struct {

Address string `ini:"address"`

Topic string `ini:"topic"`

}

type TailLog struct {

FileName string `ini:"filename"`

}

kafka/kafka.go

package kafka import (

"fmt"

"github.com/Shopify/sarama"

)

// 专门往kafka写日志的模块 var (

client sarama.SyncProducer // 声明一个全局的连接kafka的生产者client

) // init初始化client

func Init(addrs []string) (err error) {

config := sarama.NewConfig() config.Producer.RequiredAcks = sarama.WaitForAll // 发送完数据需要leader和follow都确认

config.Producer.Partitioner = sarama.NewRandomPartitioner // 新选出⼀个partition

config.Producer.Return.Successes = true // 成功交付的消息将在success channel返回 // 连接kafka

client, err = sarama.NewSyncProducer(addrs, config)

if err != nil {

fmt.Println("producer closed, err:", err)

return

}

return

} func SendToKafka(topic, data string) {

msg := &sarama.ProducerMessage{}

msg.Topic = topic

msg.Value = sarama.StringEncoder(data)

// 发送到kafka

pid, offset, err := client.SendMessage(msg)

if err != nil{

fmt.Println("sned mage failed, err:", err)

}

fmt.Printf("pid:%v offset:%v\n", pid, offset)

fmt.Println("发送成功")

}

taillog/taillog.go

package taillog import (

"fmt"

"github.com/hpcloud/tail"

) // 专门收集日志的模块 var (

tailObj *tail.Tail

logChan chan string

) func Init(filename string) (err error) {

config := tail.Config{

ReOpen: true,

Follow: true,

Location: &tail.SeekInfo{Offset: 0, Whence: 2},

MustExist: false,

Poll: true}

tailObj, err = tail.TailFile(filename, config)

if err != nil {

fmt.Println("tail file failed, err:", err)

return

}

return

} func ReadChan() <-chan *tail.Line {

return tailObj.Lines

}

main.go

package main import (

"fmt"

"gopkg.in/ini.v1"

"logagent/conf"

"logagent/kafka"

"logagent/taillog"

"strings"

"time"

) var config = new(conf.Config) // logAgent 入口程序 func main() {

// 0. 加载配置文件

//cfg, err := ini.Load("./conf/config.ini")

//address := cfg.Section("kafka").Key("address").String()

//topic := cfg.Section("kafka").Key("topic").String()

//path := cfg.Section("taillog").Key("path").String()

err := ini.MapTo(config, "./conf/config.ini")

if err != nil {

fmt.Printf("Fail to read file: %v", err)

return

}

fmt.Println(config)

// 1. 初始化kafka连接

err = kafka.Init(strings.Split(config.Kafka.Address, ";"))

if err != nil {

fmt.Println("init kafka failed, err:%v\n", err)

return

}

fmt.Println("init kafka success.")

// 2. 打开日志文件准备收集日志

err = taillog.Init(config.TailLog.FileName)

if err != nil {

fmt.Printf("Init taillog failed,err:%v\n", err)

return

}

fmt.Println("init taillog success.")

run()

} func run() {

// 1. 读取日志

for {

select {

case line := <-taillog.ReadChan():

// 2. 发送到kafka

kafka.SendToKafka(config.Kafka.Topic, line.Text)

default:

time.Sleep(time.Second)

}

}

}

kafka终端打开消费者程序,进入kafka安装目录

bin\windows\kafka-console-consumer.bat --bootstrap-server=127.0.0.1:9092 --topic=web_log --from-beginning

五、etcd

etcd是使用Go语言开发的一个开源、高可用的分布式key-value存储,可以用于配置共享和服务注册和发现,类似的项目有Zookeeper和consul,提供Restful`的接口,使用简单,基于raft算法的强一致性,高可用的服务存储目录。

5.1 特点

完全复制:集群中的每个节点都可以使用完整的存档

高可用性:Etcd可用于避免硬件的单点故障或网络问题

一致性:每次读取都会返回跨多主机的最新写入

简单:包括一个定义良好、面向用户的API(gRPC)

快速:每秒10000次写入的基准速度

可靠:使用Raft算法实现强一致性、高可用服务存储目录

5.2 应用场景

服务发现

服务发现要解决的也是分布式系统中最常见的问题之一,即在同一个分布式集群中的进程或服务,要如何才能找到对方并建立连接。本质上来说,服务发现就是想要了解集群中是否有进程在监听 udp 或 tcp 端口,并且通过名字就可以查找和连接。

配置中心(我们实现的日志收集客户端需要用到)

将一些配置信息放到etcd上进行集中管理。 这类场景方式通常是这样的:应用在启动到时候主动从etcd获取一次配置信息,同时在etcd节点上注册一个Watcher并等待,以后每次配置有更新的时候,etcd都会实时通知订阅者,以此达到获取最新配置信息的目的。

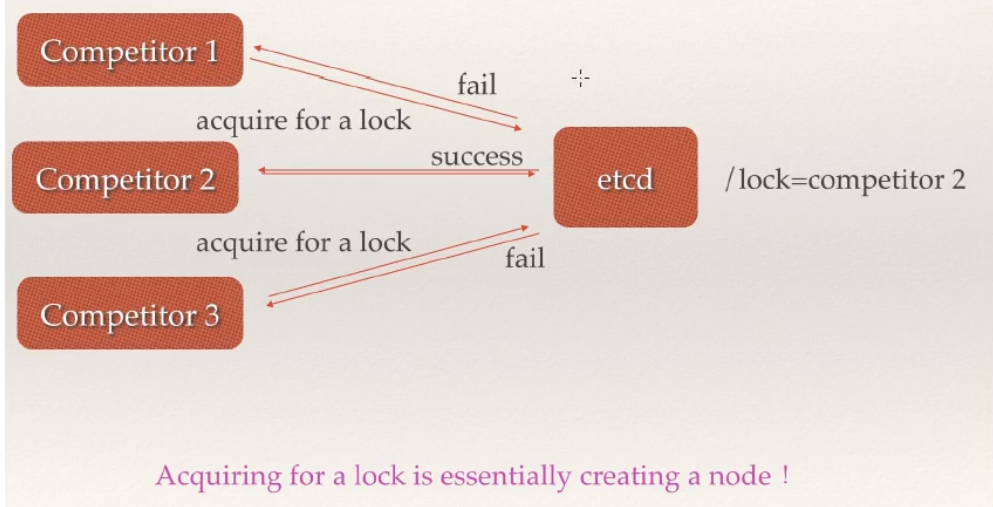

分布式锁

因为 etcd 使用 Raft 算法保持了数据的强一致性,某次操作存储到集群中的值必然是全局一致的,所以很容易实现分布式锁。锁服务有两种使用方式,一是保持独占,二是控制时序。

保持独占即所有获取锁的用户最终只有一个可以得到。etcd 为此提供了一套实现分布式锁原子操作 CAS(

CompareAndSwap)的 API。通过设置prevExist值,可以保证在多个节点同时去创建某个目录时,只有一个成功。而创建成功的用户就可以认为是获得了锁。控制时序,即所有想要获得锁的用户都会被安排执行,但是获得锁的顺序也是全局唯一的,同时决定了执行顺序。etcd 为此也提供了一套 API(自动创建有序键),对一个目录建值时指定为

POST动作,这样 etcd 会自动在目录下生成一个当前最大的值为键,存储这个新的值(客户端编号)。同时还可以使用 API 按顺序列出所有当前目录下的键值。此时这些键的值就是客户端的时序,而这些键中存储的值可以是代表客户端的编号。

5.3 etcd架构

从etcd的架构图中我们可以看到,etcd主要分为四个部分。

HTTP Server: 用于处理用户发送的API请求以及其它etcd节点的同步与心跳信息请求。

Store:用于处理etcd支持的各类功能的事务,包括数据索引、节点状态变更、监控与反馈、事件处理与执行等等,是etcd对用户提供的大多数API功能的具体实现。

Raft:Raft强一致性算法的具体实现,是etcd的核心。

WAL:Write Ahead Log(预写式日志),是etcd的数据存储方式。除了在内存中存有所有数据的状态以及节点的索引以外,etcd就通过WAL进行持久化存储。WAL中,所有的数据提交前都会事先记录日志。Snapshot是为了防止数据过多而进行的状态快照;Entry表示存储的具体日志内容。

通常,一个用户的请求发送过来,会经由HTTP Server转发给Store进行具体的事务处理,如果涉及到节点的修改,则交给Raft模块进行状态的变更、日志的记录,然后再同步给别的etcd节点以确认数据提交,最后进行数据的提交,再次同步。

重要概念:

Raft:etcd所采用的保证分布式系统强一致性的算法。

Node:一个Raft状态机实例。

Member: 一个etcd实例。它管理着一个Node,并且可以为客户端请求提供服务。

Cluster:由多个Member构成可以协同工作的etcd集群。

Peer:对同一个etcd集群中另外一个Member的称呼。

Client: 向etcd集群发送HTTP请求的客户端。

WAL:预写式日志,etcd用于持久化存储的日志格式。

snapshot:etcd防止WAL文件过多而设置的快照,存储etcd数据状态。

Proxy:etcd的一种模式,为etcd集群提供反向代理服务。

Leader:Raft算法中通过竞选而产生的处理所有数据提交的节点。

Follower:竞选失败的节点作为Raft中的从属节点,为算法提供强一致性保证。

Candidate:当Follower超过一定时间接收不到Leader的心跳时转变为Candidate开始竞选。

Term:某个节点成为Leader到下一次竞选时间,称为一个Term。

Index:数据项编号。Raft中通过Term和Index来定位数据。

5.4 为什么用etcd而不是zookeeper?

etcd 实现的这些功能,ZooKeeper都能实现。那么为什么要用 etcd 而非直接使用ZooKeeper呢?

为什么不选择ZooKeeper?

部署维护复杂,其使用的

Paxos强一致性算法复杂难懂。官方只提供了Java和C两种语言的接口。使用

Java编写引入大量的依赖。运维人员维护起来比较麻烦。最近几年发展缓慢,不如

etcd和consul等后起之秀。

为什么选择etcd?

简单。使用 Go 语言编写部署简单;支持HTTP/JSON API,使用简单;使用 Raft 算法保证强一致性让用户易于理解。

etcd 默认数据一更新就进行持久化。

etcd 支持 SSL 客户端安全认证。

最后,etcd 作为一个年轻的项目,正在高速迭代和开发中,这既是一个优点,也是一个缺点。优点是它的未来具有无限的可能性,缺点是无法得到大项目长时间使用的检验。然而,目前 CoreOS、Kubernetes和CloudFoundry等知名项目均在生产环境中使用了etcd,所以总的来说,etcd值得你去尝试。

5.5 raft协议

- 核心要点

- Leader选举

- 日志同步 (Log Replication)

leader收到client的更新请求后,会将更新的内容同步给所有follower。

- 集群状态的正确性 (Safety)

保证日志的一致性

保证选举的正确性

- zookeeper的zad协议的区别

- etcd的watch

etcd底层如何实现watch给客户发通知(websocket)

5.5 etcd的下载和安装

下载

https://github.com/coreos/etcd/releases

选择对应版本的下载即可,下载之后解压

etcd启动

双击etcd.exe运行

etcd客户端

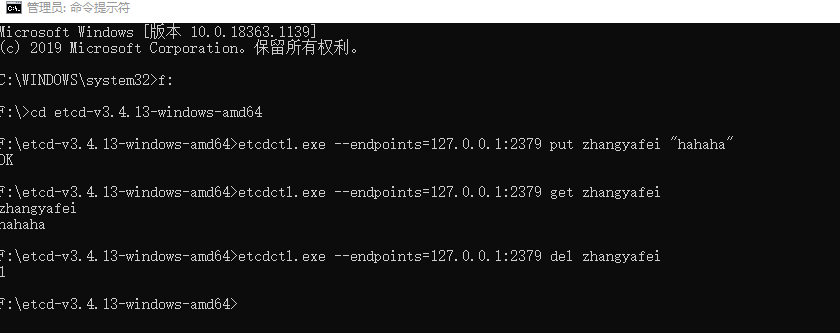

etcdctl.exe --endpoints=127.0.0.1:2379 put zhangyafei "hahaha"

5.6 go操作etcd

下载

go get "go.etcd.io/etcd/clientv3"

注:若运行过程中报undefined: balancer.PickOptions类似错误,原始为grpc版本不兼容,需要修改go.mod

replace google.golang.org/grpc => google.golang.org/grpc v1.26.0

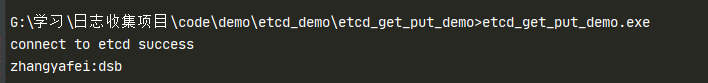

put和get

package main

import (

"context"

"fmt"

"time"

"go.etcd.io/etcd/clientv3"

)

func main() {

// etcd client put/get demo

// use etcd/clientv3

cli, err := clientv3.New(clientv3.Config{

Endpoints: []string{"127.0.0.1:2379"},

DialTimeout: 5 * time.Second,

})

if err != nil {

// handle error!

fmt.Printf("connect to etcd failed, err:%v\n", err)

return

}

fmt.Println("connect to etcd success")

defer cli.Close()

// put

ctx, cancel := context.WithTimeout(context.Background(), time.Second)

_, err = cli.Put(ctx, "zhangyafei", "dsb")

cancel()

if err != nil {

fmt.Printf("put to etcd failed, err:%v\n", err)

return

}

// get

ctx, cancel = context.WithTimeout(context.Background(), time.Second)

resp, err := cli.Get(ctx, "zhangyafei")

cancel()

if err != nil {

fmt.Printf("get from etcd failed, err:%v\n", err)

return

}

for _, ev := range resp.Kvs {

fmt.Printf("%s:%s\n", ev.Key, ev.Value)

}

}

watch

package main

import (

"context"

"fmt"

"time"

"go.etcd.io/etcd/clientv3"

)

// watch demo

func main() {

cli, err := clientv3.New(clientv3.Config{

Endpoints: []string{"127.0.0.1:2379"},

DialTimeout: 5 * time.Second,

})

if err != nil {

fmt.Printf("connect to etcd failed, err:%v\n", err)

return

}

fmt.Println("connect to etcd success")

defer cli.Close()

// watch key:q1mi change

// 派一个哨兵 一直监视着 zhangyafei这个key的变化(新增 删除 修改))

rch := cli.Watch(context.Background(), "zhangyafei") // <-chan WatchResponse

// 从通道尝试取值(监视的信息)

for wresp := range rch {

for _, ev := range wresp.Events {

fmt.Printf("Type: %s Key:%s Value:%s\n", ev.Type, ev.Kv.Key, ev.Kv.Value)

}

}

}我们在etcd目录终端输入以下命令,可以查看、新增、删除key

etcdctl.exe --endpoints=http://127.0.0.1:2379 put zhangyafei "hello"

etcdctl.exe --endpoints=http://127.0.0.1:2379 get zhangyafei

etcdctl.exe --endpoints=http://127.0.0.1:2379 del zhangyafei

lease租约

package main import (

"fmt"

"time"

) // etcd lease import (

"context"

"log" "go.etcd.io/etcd/clientv3"

) func main() {

cli, err := clientv3.New(clientv3.Config{

Endpoints: []string{"127.0.0.1:2379"},

DialTimeout: time.Second * 5,

})

if err != nil {

log.Fatal(err)

}

fmt.Println("connect to etcd success.")

defer cli.Close() // 创建一个5秒的租约

resp, err := cli.Grant(context.TODO(), 5)

if err != nil {

log.Fatal(err)

} // 5秒钟之后, /nazha/ 这个key就会被移除

_, err = cli.Put(context.TODO(), "/nazha/", "dsb", clientv3.WithLease(resp.ID))

if err != nil {

log.Fatal(err)

}

}keepAlive

package main import (

"context"

"fmt"

"log"

"time" "go.etcd.io/etcd/clientv3"

) // etcd keepAlive func main() {

cli, err := clientv3.New(clientv3.Config{

Endpoints: []string{"127.0.0.1:2379"},

DialTimeout: time.Second * 5,

})

if err != nil {

log.Fatal(err)

}

fmt.Println("connect to etcd success.")

defer cli.Close() resp, err := cli.Grant(context.TODO(), 5)

if err != nil {

log.Fatal(err)

} _, err = cli.Put(context.TODO(), "/nazha/", "dsb", clientv3.WithLease(resp.ID))

if err != nil {

log.Fatal(err)

} // the key 'foo' will be kept forever

ch, kaerr := cli.KeepAlive(context.TODO(), resp.ID)

if kaerr != nil {

log.Fatal(kaerr)

}

for {

ka := <-ch

fmt.Println("ttl:", ka.TTL)

}

}基于etcd实现分布式锁

下载

import "go.etcd.io/etcd/clientv3/concurrency"

go.etcd.io/etcd/clientv3/concurrency在etcd之上实现并发操作,如分布式锁、屏障和选举。示例

cli, err := clientv3.New(clientv3.Config{Endpoints: endpoints})

if err != nil {

log.Fatal(err)

}

defer cli.Close() // 创建两个单独的会话用来演示锁竞争

s1, err := concurrency.NewSession(cli)

if err != nil {

log.Fatal(err)

}

defer s1.Close()

m1 := concurrency.NewMutex(s1, "/my-lock/") s2, err := concurrency.NewSession(cli)

if err != nil {

log.Fatal(err)

}

defer s2.Close()

m2 := concurrency.NewMutex(s2, "/my-lock/") // 会话s1获取锁

if err := m1.Lock(context.TODO()); err != nil {

log.Fatal(err)

}

fmt.Println("acquired lock for s1") m2Locked := make(chan struct{})

go func() {

defer close(m2Locked)

// 等待直到会话s1释放了/my-lock/的锁

if err := m2.Lock(context.TODO()); err != nil {

log.Fatal(err)

}

}() if err := m1.Unlock(context.TODO()); err != nil {

log.Fatal(err)

}

fmt.Println("released lock for s1") <-m2Locked

fmt.Println("acquired lock for s2")输出

acquired lock for s1

released lock for s1

acquired lock for s2

7 etcd集群

etcd 作为一个高可用键值存储系统,天生就是为集群化而设计的。由于 Raft 算法在做决策时需要多数节点的投票,所以 etcd 一般部署集群推荐奇数个节点,推荐的数量为 3、5 或者 7 个节点构成一个集群。

搭建一个3节点集群示例:

在每个etcd节点指定集群成员,为了区分不同的集群最好同时配置一个独一无二的token。

下面是提前定义好的集群信息,其中n1、n2和n3表示3个不同的etcd节点。

TOKEN=token-01

CLUSTER_STATE=new

CLUSTER=n1=http://10.240.0.17:2380,n2=http://10.240.0.18:2380,n3=http://10.240.0.19:2380

在n1这台机器上执行以下命令来启动etcd:

etcd --data-dir=data.etcd --name n1 \

--initial-advertise-peer-urls http://10.240.0.17:2380 --listen-peer-urls http://10.240.0.17:2380 \

--advertise-client-urls http://10.240.0.17:2379 --listen-client-urls http://10.240.0.17:2379 \

--initial-cluster ${CLUSTER} \

--initial-cluster-state ${CLUSTER_STATE} --initial-cluster-token ${TOKEN}

在n2这台机器上执行以下命令启动etcd:

etcd --data-dir=data.etcd --name n2 \

--initial-advertise-peer-urls http://10.240.0.18:2380 --listen-peer-urls http://10.240.0.18:2380 \

--advertise-client-urls http://10.240.0.18:2379 --listen-client-urls http://10.240.0.18:2379 \

--initial-cluster ${CLUSTER} \

--initial-cluster-state ${CLUSTER_STATE} --initial-cluster-token ${TOKEN}

在n3这台机器上执行以下命令启动etcd:

etcd --data-dir=data.etcd --name n3 \

--initial-advertise-peer-urls http://10.240.0.19:2380 --listen-peer-urls http://10.240.0.19:2380 \

--advertise-client-urls http://10.240.0.19:2379 --listen-client-urls http://10.240.0.19:2379 \

--initial-cluster ${CLUSTER} \

--initial-cluster-state ${CLUSTER_STATE} --initial-cluster-token ${TOKEN}

etcd 官网提供了一个可以公网访问的 etcd 存储地址。你可以通过如下命令得到 etcd 服务的目录,并把它作为-discovery参数使用。

curl https://discovery.etcd.io/new?size=3

https://discovery.etcd.io/a81b5818e67a6ea83e9d4daea5ecbc92 # grab this token

TOKEN=token-01

CLUSTER_STATE=new

DISCOVERY=https://discovery.etcd.io/a81b5818e67a6ea83e9d4daea5ecbc92 etcd --data-dir=data.etcd --name n1 \

--initial-advertise-peer-urls http://10.240.0.17:2380 --listen-peer-urls http://10.240.0.17:2380 \

--advertise-client-urls http://10.240.0.17:2379 --listen-client-urls http://10.240.0.17:2379 \

--discovery ${DISCOVERY} \

--initial-cluster-state ${CLUSTER_STATE} --initial-cluster-token ${TOKEN} etcd --data-dir=data.etcd --name n2 \

--initial-advertise-peer-urls http://10.240.0.18:2380 --listen-peer-urls http://10.240.0.18:2380 \

--advertise-client-urls http://10.240.0.18:2379 --listen-client-urls http://10.240.0.18:2379 \

--discovery ${DISCOVERY} \

--initial-cluster-state ${CLUSTER_STATE} --initial-cluster-token ${TOKEN} etcd --data-dir=data.etcd --name n3 \

--initial-advertise-peer-urls http://10.240.0.19:2380 --listen-peer-urls http://10.240.0.19:2380 \

--advertise-client-urls http://10.240.0.19:2379 --listen-client-urls http:/10.240.0.19:2379 \

--discovery ${DISCOVERY} \

--initial-cluster-state ${CLUSTER_STATE} --initial-cluster-token ${TOKEN}

到此etcd集群就搭建起来了,可以使用etcdctl来连接etcd。

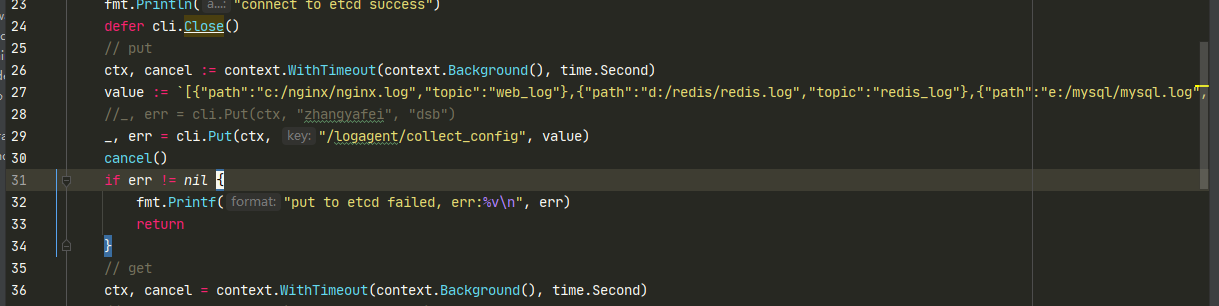

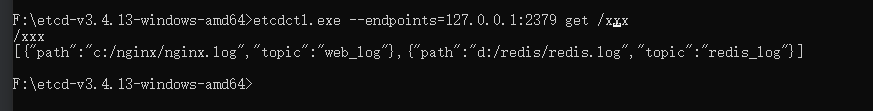

六、logagent从etcd加载收集项配置

1. 配置

value := `[{"path":"c:/nginx/nginx.log","topic":"web_log"},{"path":"d:/redis/redis.log","topic":"redis_log"},{"path":"e:/mysql/mysql.log","topic":"mysql_log"}]`

2. 将配置信息发送打破etcd

etcd读取配置

logagent从etcd加载收集项配置conf/config.ini[kafka]

address=127.0.0.1:9092

[etcd]

address=127.0.0.1:2379

timeout=5

collect_log_key=/logagent/collect_configconf/config.gopackage conf

type Config struct {

Kafka Kafka `ini:"kafka"`

Etcd Etcd `ini:"etcd"`

}

type Kafka struct {

Address string `ini:"address"`

//Topic string `ini:"topic"`

}

type Etcd struct {

Address string `ini:"address"`

Key string `ini:"collect_log_key"`

Timeout int `ini:"timeout"`

}etcd/etcd.gopackage etcd

import (

"context"

"encoding/json"

"fmt"

"go.etcd.io/etcd/clientv3"

"strings"

"time"

)

var (

cli *clientv3.Client

)

type LogEntry struct {

Path string `json:"path"` // 日志存放的路径

Topic string `json:"topic"` // 日志发往kafka中的哪个Topic

}

// 初始化etcd的函数

func Init(addr string, timeout time.Duration) (err error) {

cli, err = clientv3.New(clientv3.Config{

Endpoints: strings.Split(addr, ";"),

DialTimeout: timeout,

})

return

}

// 从etcd中获取日志收集项的配置信息

func GetConf(key string) (logEntryConf []*LogEntry, err error) {

ctx, cancel := context.WithTimeout(context.Background(), time.Second)

resp, err := cli.Get(ctx, key)

cancel()

if err != nil {

fmt.Printf("get from etcd failed, err:%v\n", err)

return

}

for _, ev := range resp.Kvs {

//fmt.Printf("%s:%s\n", ev.Key, ev.Value)

err = json.Unmarshal(ev.Value, &logEntryConf)

if err != nil {

fmt.Printf("unmarshal etcd value failed,err:%v\n", err)

return

}

}

return

}main.gopackage main

import (

"fmt"

"gopkg.in/ini.v1"

"logagent/conf"

"logagent/etcd"

"logagent/kafka"

"strings"

"time"

)

var config = new(conf.Config)

// logAgent 入口程序

func main() {

// 0. 加载配置文件

err := ini.MapTo(config, "./conf/config.ini")

if err != nil {

fmt.Printf("Fail to read file: %v", err)

return

}

// 1. 初始化kafka连接

err = kafka.Init(strings.Split(config.Kafka.Address, ";"))

if err != nil {

fmt.Println("init kafka failed, err:%v\n", err)

return

}

fmt.Println("init kafka success.")

// 2. 初始化etcd

err = etcd.Init(config.Etcd.Address, time.Duration(config.Etcd.Timeout) * time.Second)

if err != nil {

fmt.Printf("init etcd failed,err:%v\n", err)

return

}

fmt.Println("init etcd success.")

// 2.1 从etcd中获取日志收集项的配置信息

logEntryConf, err := etcd.GetConf(config.Etcd.Key)

// 2,.2 派一个哨兵

if err != nil {

fmt.Printf("etcd.GetConf failed, err:%v\n", err)

return

}

fmt.Printf("get conf from etcd success, %v\n", logEntryConf)

for index, value := range logEntryConf{

fmt.Printf("index:%v value:%v\n", index, value)

}

}

项目地址:https://gitee.com/zhangyafeii/go-log-collect/tree/master/code/logagent

日志收集系统系列(三)之LogAgent的更多相关文章

- 日志收集系统系列(四)之LogAgent优化

实现功能 logagent根据etcd的配置创建多个tailtask logagent实现watch新配置 logagent实现新增收集任务 logagent删除新配置中没有的那个任务 logagen ...

- 日志收集系统系列(五)之LogTransfer

从kafka里面把日志取出来,写入ES,使用Kibana做可视化展示 1. ElasticSearch 1.1 介绍 Elasticsearch(ES)是一个基于Lucene构建的开源.分布式.RES ...

- Go实现海量日志收集系统(三)

再次整理了一下这个日志收集系统的框,如下图 这次要实现的代码的整体逻辑为: 完整代码地址为: https://github.com/pythonsite/logagent etcd介绍 高可用的分布式 ...

- ELK+kafka构建日志收集系统

ELK+kafka构建日志收集系统 原文 http://lx.wxqrcode.com/index.php/post/101.html 背景: 最近线上上了ELK,但是只用了一台Redis在 ...

- Flume -- 开源分布式日志收集系统

Flume是Cloudera提供的一个高可用的.高可靠的开源分布式海量日志收集系统,日志数据可以经过Flume流向需要存储终端目的地.这里的日志是一个统称,泛指文件.操作记录等许多数据. 一.Flum ...

- [转载] 一共81个,开源大数据处理工具汇总(下),包括日志收集系统/集群管理/RPC等

原文: http://www.36dsj.com/archives/25042 接上一部分:一共81个,开源大数据处理工具汇总(上),第二部分主要收集整理的内容主要有日志收集系统.消息系统.分布式服务 ...

- 基于Flume的美团日志收集系统(一)架构和设计

美团的日志收集系统负责美团的所有业务日志的收集,并分别给Hadoop平台提供离线数据和Storm平台提供实时数据流.美团的日志收集系统基于Flume设计和搭建而成. <基于Flume的美团日志收 ...

- 基于Flume的美团日志收集系统(一)架构和设计【转】

美团的日志收集系统负责美团的所有业务日志的收集,并分别给Hadoop平台提供离线数据和Storm平台提供实时数据流.美团的日志收集系统基于Flume设计和搭建而成. <基于Flume的美团日志收 ...

- 分布式日志收集系统Apache Flume的设计详细介绍

问题导读: 1.Flume传输的数据的基本单位是是什么? 2.Event是什么,流向是怎么样的? 3.Source:完成对日志数据的收集,分成什么打入Channel中? 4.Channel的作用是什么 ...

随机推荐

- 为什么在集合中不能使用int关键字作为类型

解释: 1.Int是基本数据类型,Integer是Int的引用类型,定义集合的时候不能使用基本数据类型,需要使用对应的引用类型 2.int是基本数据类型,Integer是他的包装类,包装类主要用在类型 ...

- [BUUCTF]REVERSE——[GXYCTF2019]luck_guy

[GXYCTF2019]luck_guy 附件 步骤: ida载入,shift+f12查看程序里的字符串,看到了关于flag的提示 双击跟进跳转,ctrl+x找到关键函数 flag是由f1和f1拼接而 ...

- 2. Go中defer使用注意事项

1. 简介 defer 会在当前函数返回前执行传入的函数,它会经常被用于关闭文件描述符.关闭数据库连接以及解锁资源. 理解这句话主要在三个方面: 当前函数 返回前执行,当然函数可能没有返回值 传入的函 ...

- VirtualBox 同时添加 NAT 和 Host-Only 网卡出现无法上网的情况

如果网卡1是 NAT,网卡2是 Host-Only,可以 ping 通 baidu.com. 如果网卡1是 Host-Only,网卡2是 NAT,无法 ping 通 baidu.com. 使用 nmc ...

- LuoguB2029 大象喝水 题解

Update \(\texttt{2021.12.4}\) 修改了原先的错误代码,给各位造成影响,在此表示很抱歉. Content 大象要喝 \(20\) 升水,但现在只有一个深 \(h\) 厘米,半 ...

- oracle同义词创建(synonym)

oracle同义词创建(synonym) 在现在的项目中会有很多接口,数据来源也可能是不同数据库或者是不同的用户下的表,给访问该表带来了一定的麻烦.这个时候就可以使用同义词来简化. 同义词的语法是 ...

- 复杂SQL案例:用户授权渠道查询

供参考: SELECT r.course_id 课程id, r.user_id 用户ID, u.user_full_name 姓名, u.province_name 省名, u.city_name 城 ...

- JAVA结合Redis处理缓存穿透问题

public List<WeixinMenu> getList() { List<WeixinMenu> weixinMenuList= (List<WeixinMenu ...

- Python pyecharts绘制折线图

一.pyecharts绘制折线图line.add()方法简介 line.add()方法简介 add(name,x_axis,y_axis,is_symbol_show=True, is_smooth= ...

- 【LeetCode】53. Maximum Subarray 最大子序和 解题报告(Python & C++ & Java)

作者: 负雪明烛 id: fuxuemingzhu 个人博客: http://fuxuemingzhu.cn/ 目录 题目描述 题目大意 解题方法 暴力解法 动态规划 日期 题目地址: https:/ ...