ELK、ELFK企业级日志分析系统

ELK、ELFK企业级日志分析系统

一、ELK日志分析系统

1. ELK简介

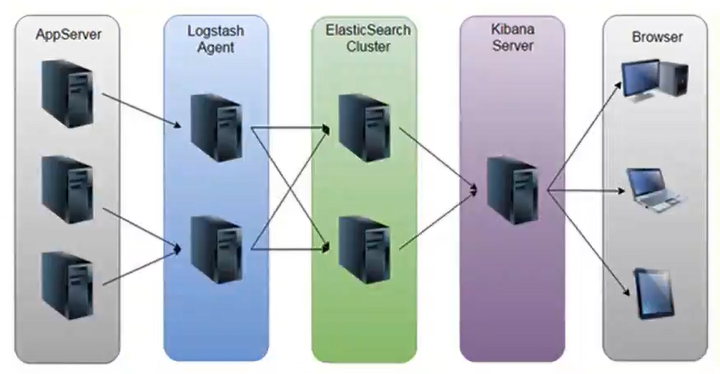

ELK平台是一套完整的日志集中处理解决方案,将ElasticSearch、Logstash和Kibana三个开源工具配合使用,完成更强大的用户对日志的查询、排序、统计需求。

1.2 ElasticSearch

ES是基于Lucene(一个全文检索引擎的架构)开发的分布式存储检索引擎,用来存储各类日志。

ES是用JAVA开发的,可通过RESTful Web接口,让用户可以通过浏览器与ES通信。

ES是个分布式搜索和分析引擎,优点是能对大容量的数据进行接近实时的存储、搜索和分析操作。

1.3 Logstash

Logstash作为数据收集引擎。它支持动态的从各种数据源搜索数据,并对数据进行过滤、分析、丰富、统一格式等操作,然后存储到用户指定的位置,一般会发送给ES。

Logstash由JRuby语言编写,运行在JAVA虚拟机(JVM)上,是一款强大的数据处理工具,可以实现数据传输、格式处理、格式化输出。Logstash具有强大的插件功能,常用于日志处理。

1.4 Kibana

Kibana是基于Node.js开发的展示工具,可以为Logstash和ES提供图形化的日志分析Web界面展示,可以汇总、分析和搜索重要数据日志。

1.5 Filebeat

Filebeat是一款轻量级的开源日志文件数据搜索器。通常在需要采集数据的客户端安装Filebeat,并指定目录与日志格式,Filebeat就能快速收集数据,并发送给logstash进行解析,或是直接发给ES存储,性能上相比运行于JVM上的logstash优势明显,是对它的替代。

2. ELK的使用原因

日志主要包括日志、应用程序日志和安全日志。系统运维和开发人员可以通过日志了解服务器软硬件信息、检查配置过程中的错误及错误及错误发生的原因。经常分析日志可以了解服务器的负荷,性能安全性,从而及时采取措施纠正错误。

往往单台机器的日志我们使用grep、awk等工具就能基本实现简单分析,但是当日志被分散的储存不同的设备上。如果你管理数十上百台服务器,你还在使用依次登录每台机器的传统方法查阅汇总。集中化管理日志后,日志的统计和检索又成为一件比较麻烦的事情,一般我们使用grep、awk和wc等linux命令能实现检索和统计,但是对于要求更高的查询、排序和统计等要求和庞大的机器数量依然使用这样的方法难免有点力不从心。

一般大型系统是一个分布式部署的架构,不同的服务模块部署在不同的服务器上,问题出现时,大部分情况需要根据问题暴露的关键信息,定位到具体的服务器和服务模块,构建一套集中式日志系统,可以提高定位问题的效率。

3. 完整日志系统的基本特征

● 收集:能够采集多种来源的日志数据

● 传输:能够稳定的把日志数据解析过滤并传输到存储系统

● 存储:存储日志数据

● 分析:支持UI分析

● 警告:能够提供错误报告,监控机制

4. ELK的工作原理

(1)在所有需要收集日志的服务器上部署Logstash;或者先将日志进行集中化管理在日志服务器上,在日志服务器上部署Logstash。

(2)Logstash收集日志,将日志格式化并输出到es群集中。

(3)ES对格式化后的数据进行索引和存储。

(4)Kibana从ES群集中查询数据生成图表,并进行前端数据的显示。

二、部署ELK日志分析系统

1. 服务器配置

| 服务器 | 配置 | 主机名 | ip地址 | 主要软件部署 |

|---|---|---|---|---|

| node1节点 | 2C/4G | node1 | 192.168.122.10 | ElasticSearch、Kibana |

| node2节点 | 2C/4G | node2 | 192.168.122.11 | ElasticSearch |

| apache节点 | - | apache | 192.168.122.12 | Logstash、Apache |

2. 关闭防火墙

systemctl stop firewalld

setenforce 0

3. ELK ElasticSearch集群部署(在node1、node2节点上操作)

3.1 环境准备(更改主机名、配置域名解析、查看Java环境)

以node1为例

[root@localhost ~]# hostnamectl set-hostname node1

[root@localhost ~]# su

[root@node1 ~]# echo "192.168.122.10 node1" >> /etc/hosts

[root@node1 ~]# echo "192.168.122.11 node2" >> /etc/hosts

[root@node1 ~]# java -version

#如果没有安装,可使用“yum install -y java”进行安装

openjdk version "1.8.0_131"

OpenJDK Runtime Environment (build 1.8.0_131-b12)

OpenJDK 64-Bit Server VM (build 25.131-b12, mixed mode)

3.2 部署ElasticSearch软件

3.2.1 安装elasticsearch-rpm包

以node1为例

[root@node1 ~]# cd /opt

[root@node1 opt]# rz -E

#上传elasticsearch-5.5.0.rpm到/opt目录下

rz waiting to receive.

[root@node1 opt]# rpm -ivh elasticsearch-5.5.0.rpm

3.2.2 加载系统服务

以node1为例

[root@node1 opt]# systemctl daemon-reload

[root@node1 opt]# systemctl enable elasticsearch.service

Created symlink from /etc/systemd/system/multi-user.target.wants/elasticsearch.service to /usr/lib/systemd/system/elasticsearch.service.

3.2.3 修改elasticsearch主配置文件

以node1为例

[root@node1 opt]# cp /etc/elasticsearch/elasticsearch.yml /etc/elasticsearch/elasticsearch.yml.bak

#备份配置文件

[root@node1 opt]# vim /etc/elasticsearch/elasticsearch.yml

##17行,取消注释,指定群集名称

cluster.name: my-elk-cluster

##23行,取消注释,指定节点名称(node1节点为node1,node2节点为node2)

node.name: node1

##33行,取消注释,指定数据存放路径

path.data: /data/elk_data

##37行,取消注释,指定日志存放路径

path.logs: /var/log/elasticsearch/

##43行,取消注释,改为在启动的时候不锁定内存,开启为true

bootstrap.memory_lock: false

##55行,取消注释,设置监听地址,0.0.0.0代表所有地址

network.host: 0.0.0.0

##59行,取消注释,ES服务的默认监听端口为9200

http.port: 9200

##68行,取消注释,集群发现通过单播实现,指定要发现的节点node1、node2

discovery.zen.ping.unicast.hosts: ["node1", "node2"]

[root@node1 opt]# grep -v "^#" /etc/elasticsearch/elasticsearch.yml

cluster.name: my-elk-cluster

node.name: node1

path.data: /data/elk_data

path.logs: /var/log/elasticsearch/

bootstrap.memory_lock: false

network.host: 0.0.0.0

http.port: 9200

discovery.zen.ping.unicast.hosts: ["node1", "node2"]

3.2.4 创建数据存放路径并授权

以node1为例

[root@node1 opt]# mkdir -p /data/elk_data

[root@node1 opt]# chown elasticsearch:elasticsearch /data/elk_data/

3.2.5 启动elasticsearch

以node1为例

[root@node1 opt]# systemctl start elasticsearch.service

[root@node1 opt]# netstat -natp | grep 9200

tcp6 0 0 :::9200 :::* LISTEN 4216/java

3.2.6 查看节点信息

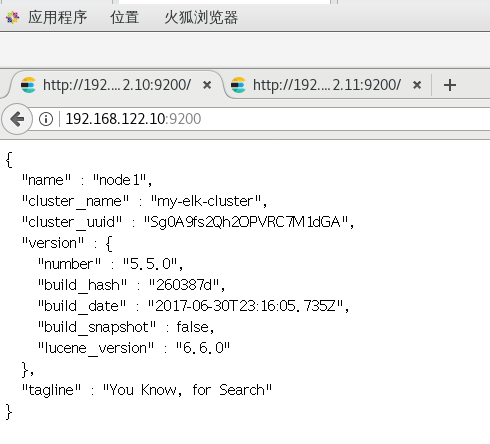

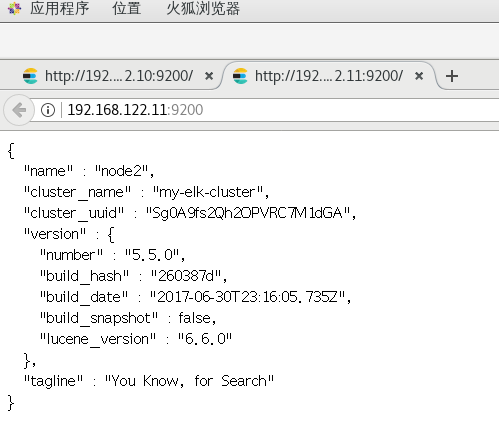

浏览器访问http://192.168.122.10:9200、http://192.168.122.11:9200查看节点node1、node2的信息

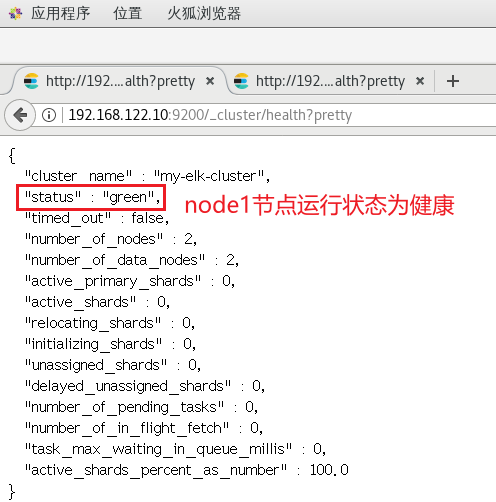

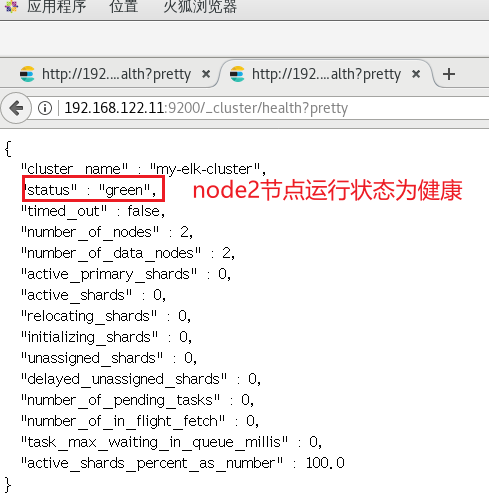

浏览器访问http://192.168.122.10:9200/_cluster/health?pretty、http://192.168.122.11:9200/_cluster/health?pretty查看群集的健康情况,可以看到status值为green(绿色),表示节点健康运行

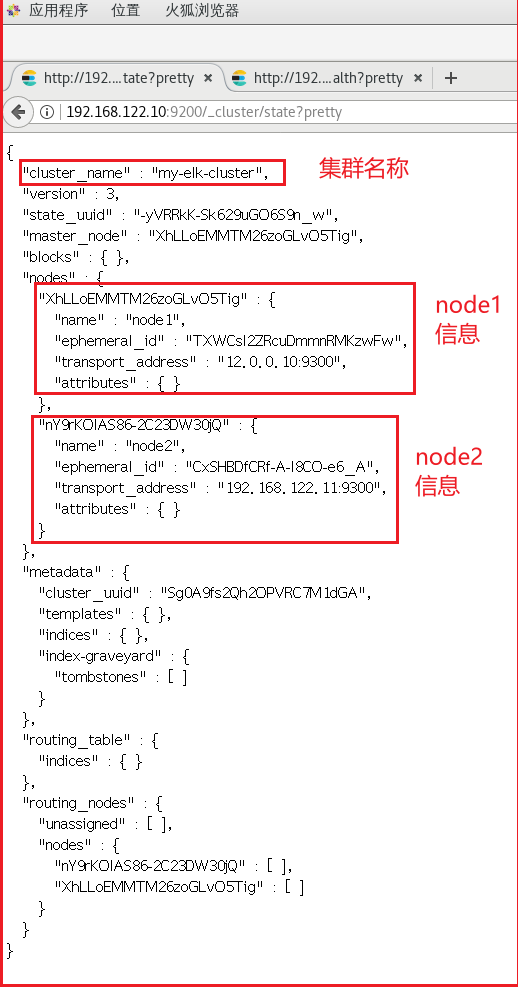

浏览器访问http://192.168.122.10/_cluster/state?pretty、http://192.168.122.11/_cluster/state?pretty检查群集状态信息

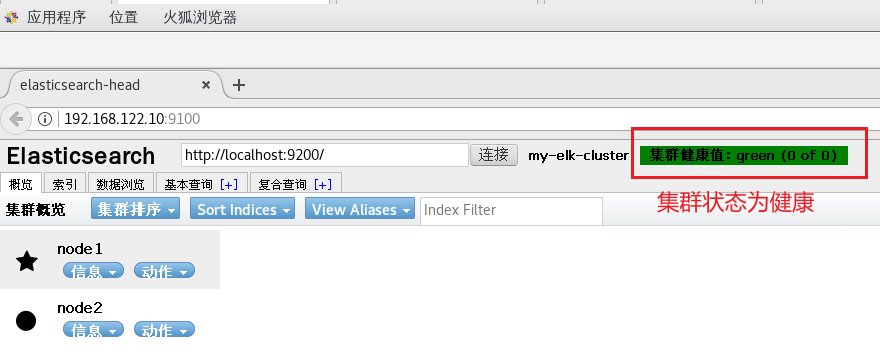

使用上述方式查看群集的状态对用户并不友好,可以通过安装Elasticsearch-head插件,更方便的对群集进行管理。

3.3 安装Elasticsearch-head插件

ES在5.0版本后,插件需要作为独立服务进行安装,需要使用npm工具(NodeJS的包管理工具)安装。安装Elasticsarch-head需要提前安装好依赖软件node和phantomjs。

● node

是一个基于Chrome V8引擎的JavaScript运行环境

● phantomjs

是一个基于webkit的JavaScriptAPI,可以理解为一个隐形的浏览器,任何基于webkit浏览器做的事情,它都可以做到。

3.3.1 编译安装node

以node1为例

[root@node1 ~]# cd /opt

[root@node1 opt]# rz -E

#上传软件包node-v8.2.1.tar.gz到/opt目录

rz waiting to receive.

[root@node1 opt]# yum install -y gcc gcc-c++ make

[root@node1 opt]# tar zxvf node-v8.2.1.tar.gz

[root@node1 opt]# cd node-v8.2.1/

[root@node1 node-v8.2.1]# ./configure

[root@node1 node-v8.2.1]# make -j 2 && make install

3.3.2 安装phantomjs

以node1为例

[root@node1 node-v8.2.1]# cd /opt

[root@node1 opt]# rz -E

#上传软件包phantomjs-2.1.1-linux-x86_64.tar.bz2到/opt目录

rz waiting to receive.

[root@node1 opt]# tar jxvf phantomjs-2.1.1-linux-x86_64.tar.bz2 -C /usr/local/src

[root@node1 opt]# cd /usr/local/src/phantomjs-2.1.1-linux-x86_64/bin

[root@node1 bin]# cp phantomjs /usr/local/bin

3.3.3 安装Elasticsearch-head数据可视化工具

以node1为例

[root@node1 bin]# cd /opt

[root@node1 opt]# rz -E

#上传软件包elasticsearch-head.tar.gz到/opt目录

rz waiting to receive.

[root@node1 opt]# tar zxvf elasticsearch-head.tar.gz -C /usr/local/src/

[root@node1 opt]# cd /usr/local/src/elasticsearch-head/

[root@node1 elasticsearch-head]# npm install

3.3.4 修改Elasticsearch主配置文件

以node1为例

[root@node1 elasticsearch-head]# vim /etc/elasticsearch/elasticsearch.yml

##末行添加以下内容

http.cors.enabled: true ##开启跨域访问支持,默认为false

http.cors.allow-origin: "*" ##指定跨域访问允许的域名地址为所有

[root@node1 elasticsearch-head]# systemctl restart elasticsearch.service

3.3.5 启动elasticsearch-head服务

以node1为例

[root@node1 elasticsearch-head]# cd /usr/local/src/elasticsearch-head/

[root@node1 elasticsearch-head]# npm run start &

[1] 71012

> elasticsearch-head@0.0.0 start /usr/local/src/elasticsearch-head

> grunt server

Running "connect:server" (connect) task

Waiting forever...

Started connect web server on http://localhost:9100

^C

[root@node1 elasticsearch-head]# netstat -natp | grep 9100

tcp 0 0 0.0.0.0:9100 0.0.0.0:* LISTEN 71022/grunt

注:必须在解压后的elasticsearch-head目录下启动服务,进程会读取该目录下的gruntfile.js文件,否则可能启动失败。

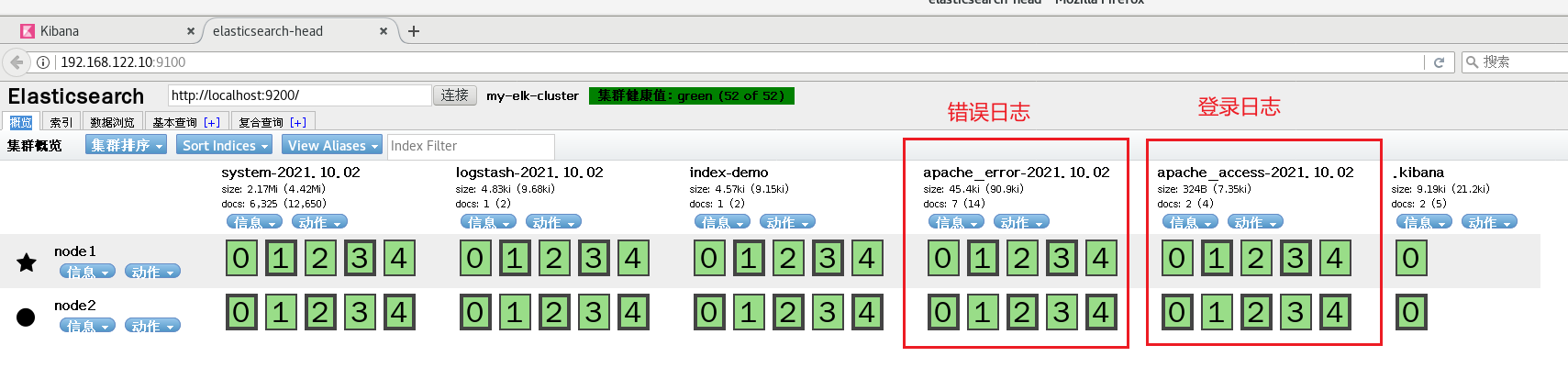

3.3.6 通过Elasticsearch-head查看ES信息

通过浏览器访问http://192.168.122.10:9100地址并连接群集。如果看到群集健康值为green,代表群集很健康。

3.3.7 插入索引

通过命令插入一个测试索引,索引为index-demo,类型为test

[root@node1 elasticsearch-head]# curl -X PUT 'localhost:9200/index-demo/test/1?pretty&pretty' -H 'content-Type: application/json' -d '{"user":"zhangsan","mesg":"hello world"}'

{

"_index" : "index-demo",

"_type" : "test",

"_id" : "1",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 2,

"failed" : 0

},

"created" : true

}

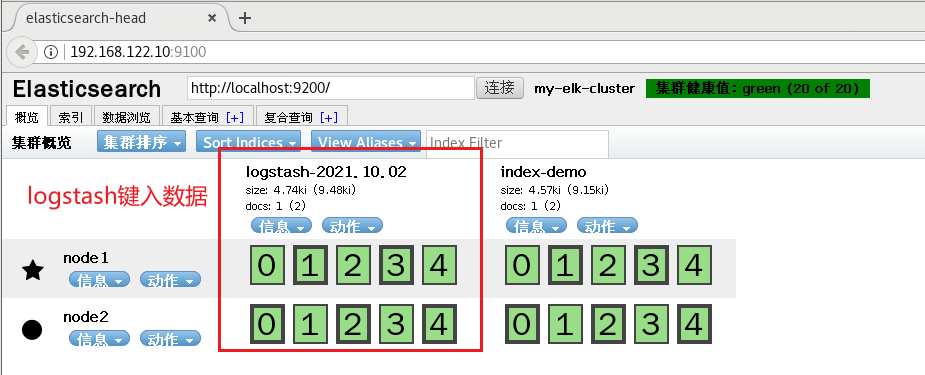

3.3.8 浏览器查看索引信息

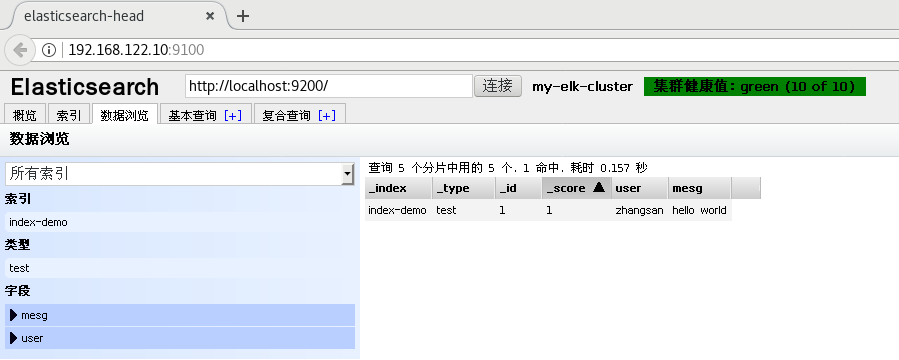

浏览器访问http://129.168.122.10:9100查看索引信息,可以看见索引默认被分片为5个,并且有一个副本。

点击“数据浏览”,会发现在node1上创建的索引为index-demo,类型为test的相关信息。

4. ELK-Logstash部署(在Apache节点上操作)

Logstash一般部署在需要监控其日志的服务器。在本案例中,Logstash部署在Apache服务器上,用于收集Apache的日志信息并发送到Elasticsearch。

4.1 更改主机名

[root@localhost ~]# hostnamectl set-hostname apache

[root@localhost ~]# su

[root@apache ~]#

4.2 安装Apache服务(httpd)

[root@apache ~]# yum install -y httpd

[root@apache ~]# systemctl start httpd

4.3 安装Java环境

[root@apache ~]# yum install -y java

[root@apache ~]# java -version

openjdk version "1.8.0_302"

OpenJDK Runtime Environment (build 1.8.0_302-b08)

OpenJDK 64-Bit Server VM (build 25.302-b08, mixed mode)

4.4 安装logstash

[root@apache ~]# cd /opt

[root@apache opt]# rz -E

#上传软件包logstash-5.5.1.rpm到/opt目录下

rz waiting to receive.

[root@apache opt]# rpm -ivh logstash-5.5.1.rpm

[root@apache opt]# systemctl start logstash.service

[root@apache opt]# systemctl enable logstash.service

Created symlink from /etc/systemd/system/multi-user.target.wants/logstash.service to /etc/systemd/system/logstash.service.

[root@apache opt]# ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

4.5 测试Logstash

4.5.1 Logstash命令常用选项

| Logstash命令常用选项 | 说明 |

|---|---|

| -f | 通过这个选项可以指定Logstash的配置文件,根据配置文件配置Logstash的输入和输出流。 |

| -e | 从命令行中获取,输入、输出后面跟着字符串,该字符串可以被当做Logstash的配置(如果是空,则默认使用stdin作为输入,stdout作为输出)。 |

| -t | 测试配置文件食肉正确,然后退出。 |

4.5.2 定义输入和输出流

4.5.2.1 标准输入、输出

输入采用标准输入,输出采用标准输出(类似管道)

[root@apache opt]# logstash -e 'input { stdin{} } output { stdout{} }'

······

The stdin plugin is now waiting for input:

20:26:17.422 [Api Webserver] INFO logstash.agent - Successfully started Logstash API endpoint {:port=>9600}

www.test.com

#键入内容(标准输入)

2021-10-02T12:27:03.538Z apache www.test.com

#输入结果(标准输出)

4.5.2.2 rubydebug输出

使用rubydebug输出详细格式显示,codec为一种编解码器

[root@apache opt]# logstash -e 'input { stdin{} } output { stdout{ codec=>rubydebug } }'

······

The stdin plugin is now waiting for input:

20:37:23.433 [Api Webserver] INFO logstash.agent - Successfully started Logstash API endpoint {:port=>9600}

www.test.com

#键入内容(标准输入)

{

#输出结果(处理后的结果)

"@timestamp" => 2021-10-02T12:39:01.630Z,

"@version" => "1",

"host" => "apache",

"message" => "www.test.com"

}

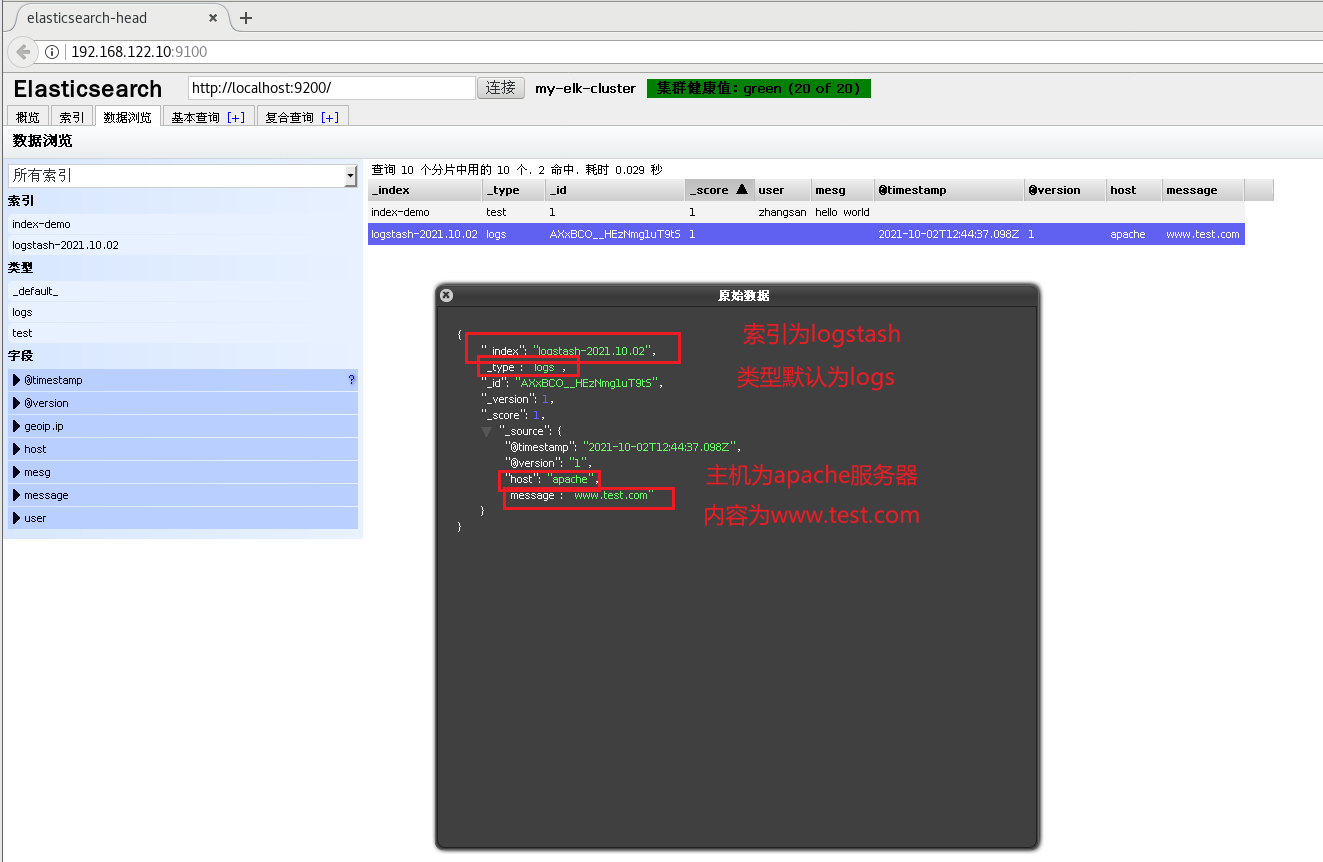

4.5.2.3 输出到ES

使用logstash将嘻嘻写入到ES中

[root@apache opt]# logstash -e 'input { stdin{} } output { elasticsearch { hosts=>["192.168.122.10:9200"] } }'

······

The stdin plugin is now waiting for input:

20:44:06.190 [Api Webserver] INFO logstash.agent - Successfully started Logstash API endpoint {:port=>9600}

www.test.com

#键入内容(标准输出)

结果不在标准输出显示,而是发送至ES,可浏览器访问http://192.168.122.10:9100查看索引和数据

4.6 定义logstash配置文件

logstash配置文件基本由三部分组成:input输入、output输出以及filter过滤(可选,根据需要选择使用)。

格式如下:

input {...}

output {...}

filter {...}

在每个部分中,也可以指定多个访问方式。例如,若要指定两个日志来源文件,则格式如下:

input {

file { path =>"/var/log/messages" type =>"syslog"}

file { path =>"/var/log/httpd/access.log" type =>"apache"}

}

修改logstash配置文件,让其收集系统日志/var/log/messages,并将其输出到ES中。

[root@apache opt]# chmod +r /var/log/messages

#赋予读的权限,让Logstash可以获取到该文件的内容

[root@apache opt]# vim /etc/logstash/conf.d/system.conf

##该文件需自行创建,文件名可自定义

input {

file{

path =>"/var/log/messages"

##指定要收集的日志的位置

type =>"system"

##自定义日志类型标识

start_position =>"beginning"

##表示从开始处收集

}

}

output {

elasticsearch{

##输出到ES

hosts =>["192.168.122.10:9200", "192.168.122.11:9200"]

##指定ES服务器的地址和端口,为避免单机故障,建议写全

index =>"system-%{+YYYY.MM.dd}"

##指定输出到ES的索引格式

}

}

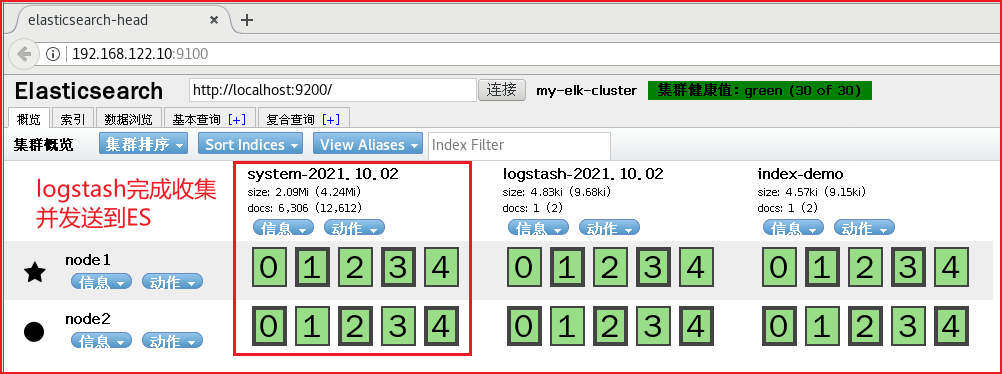

[root@apache opt]# systemctl restart logstash.service

4.7 访问测试

浏览器访问http://192.168.122.10:9100查看索引信息

5. ELK-Kibana部署(在node1节点上操作)

5.1 安装Kibana

[root@node1 elasticsearch-head]# cd /opt

[root@node1 opt]# rz -E

#上传软件包kibana-5.5.1-x86_64.rpm到/opt目录

rz waiting to receive.

[root@node1 opt]# rpm -ivh kibana-5.5.1-x86_64.rpm

5.2 设置Kibana的主配置文件

[root@node1 opt]# cp /etc/kibana/kibana.yml /etc/kibana/kibana.yml.bak

备份配置文件

[root@node1 opt]# vim /etc/kibana/kibana.yml

##2行,取消注释,kibana服务的默认监听端口为5601

server.port: 5601

##7行,取消注释,设置kibana的监听地址,0.0.0.0代表所有地址

server.host: "0.0.0.0"

##21行,取消注释,设置和ES建立连接的地址和端口

elasticsearch.url: "http://192.168.122.10:9200"

##30行,取消注释,设置在ES中添加.kibana索引

kibana.index: ".kibana"

5.3 启动kibana服务

[root@node1 opt]# systemctl start kibana.service

[root@node1 opt]# systemctl enable kibana.service

Created symlink from /etc/systemd/system/multi-user.target.wants/kibana.service to /etc/systemd/system/kibana.service.

[root@node1 opt]# netstat -natp | grep 5601

tcp 0 0 0.0.0.0:5601 0.0.0.0:* LISTEN 82765/node

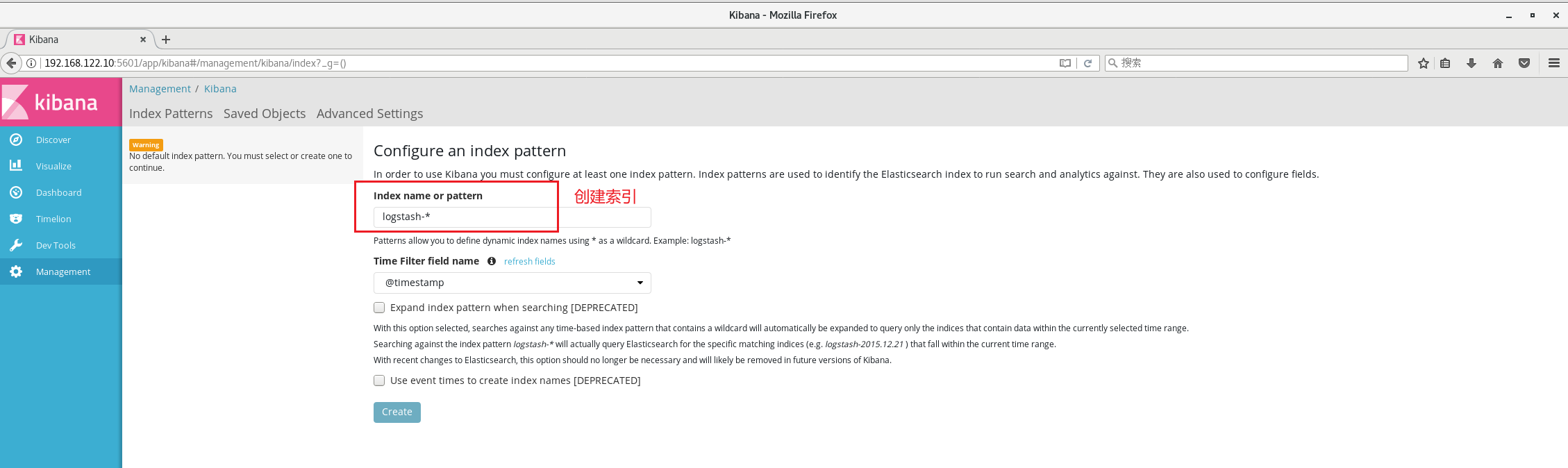

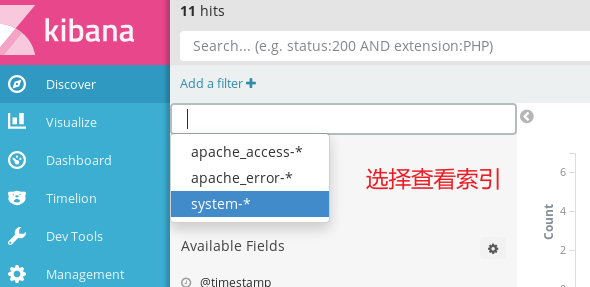

5.4 验证kibana

浏览器访问http://192.168.122.10:5601

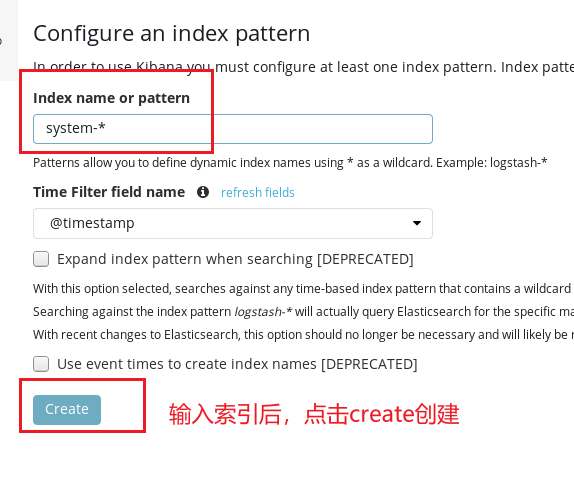

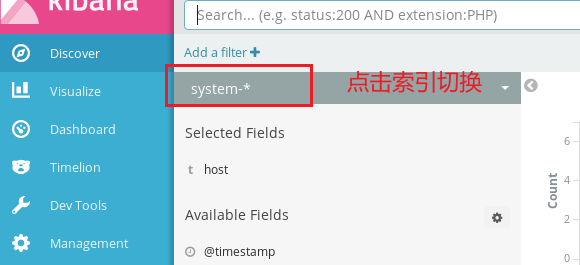

第一次登录需要添加一个ES索引

输入system-*

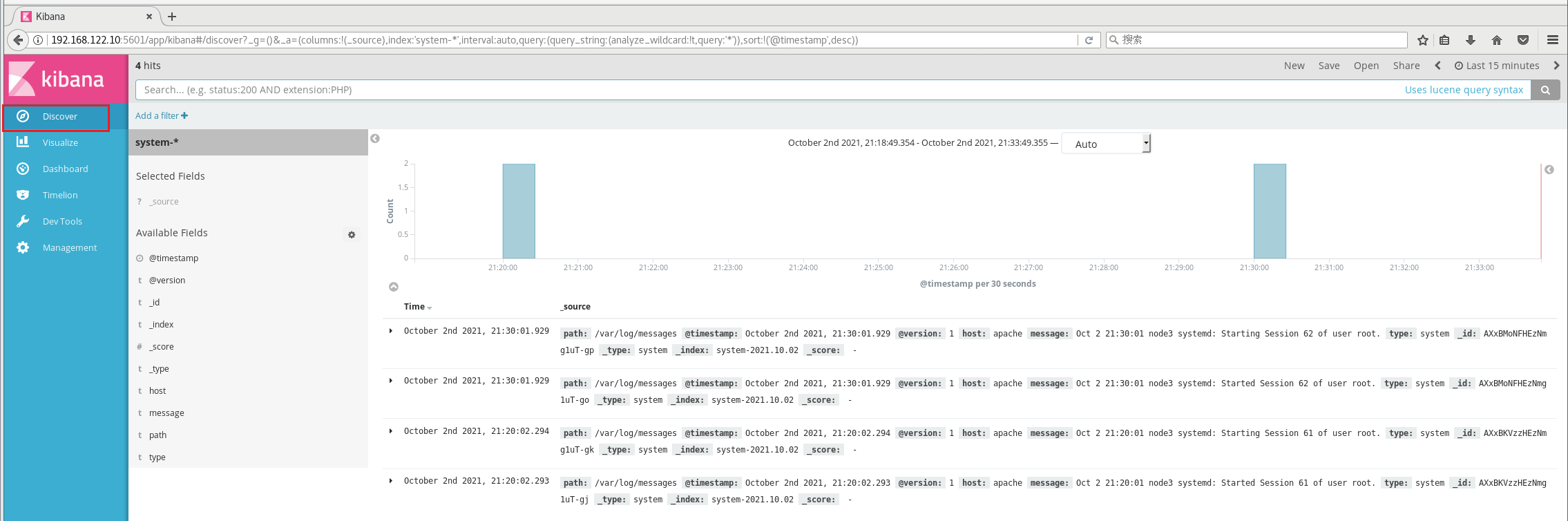

索引添加完成后,点击“Discover”按钮可查看图表信息及日志信息

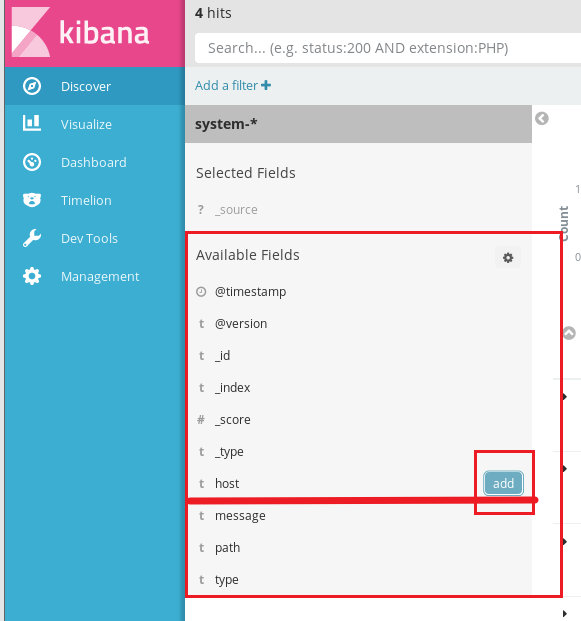

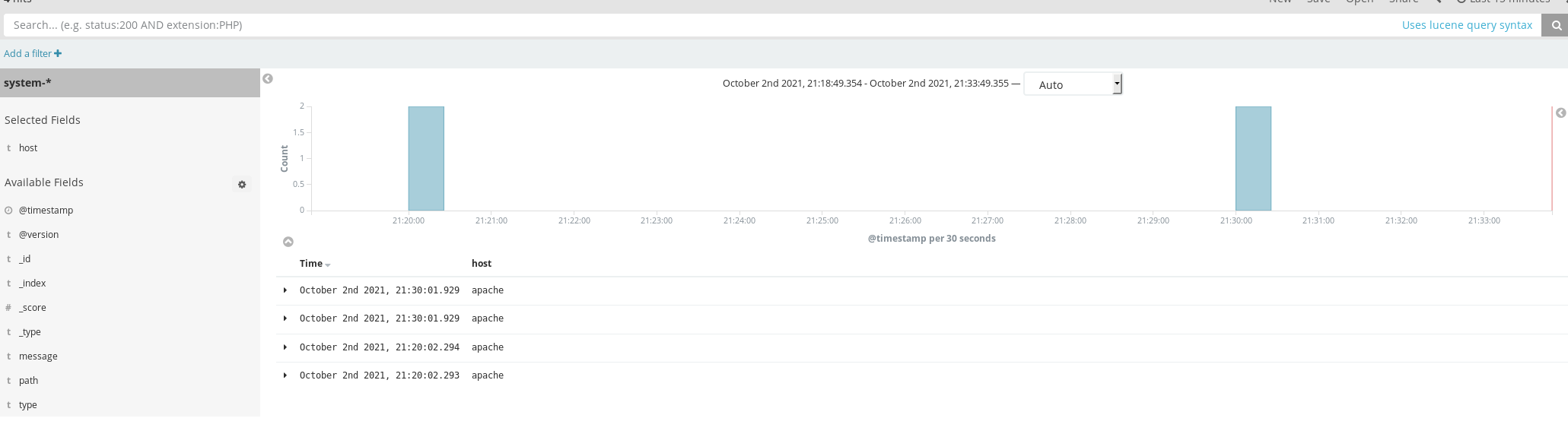

数据展示可以分类显示,例如:在“Available Fileds”中的“host”

5.5 将Apache服务器的日志(访问的、错误的)添加到ES并通过kibana显示

apache服务器

[root@apache opt]# vim /etc/logstash/conf.d/apache_log.conf

input {

file{

path => "/etc/httpd/logs/access_log"

type => "access"

start_position => "beginning"

}

file{

path => "/etc/httpd/logs/error_log"

type => "error"

start_position => "beginning"

}

}

output {

if [type] == "access" {

elasticsearch {

hosts => ["192.168.122.10:9200", "192.168.122.11:9200"]

index => "apache_access-%{+YYYY.MM.dd}"

}

}

if [type] == "error" {

elasticsearch {

hosts => ["192.168.122.10:9200", "192.168.122.11:9200"]

index => "apache_error-%{+YYYY.MM.dd}"

}

}

}

[root@apache opt]# cd /etc/logstash/conf.d/

[root@apache conf.d]# /usr/share/logstash/bin/logstash -f apache_log.conf

······

21:55:40.494 [Api Webserver] INFO logstash.agent - Successfully started Logstash API endpoint {:port=>9601}

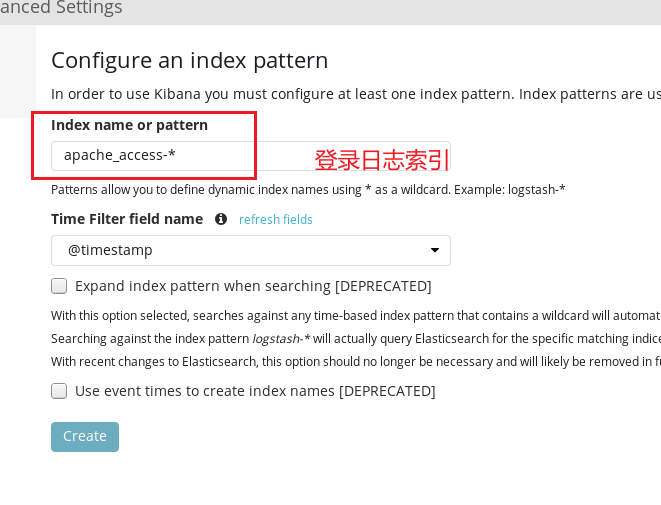

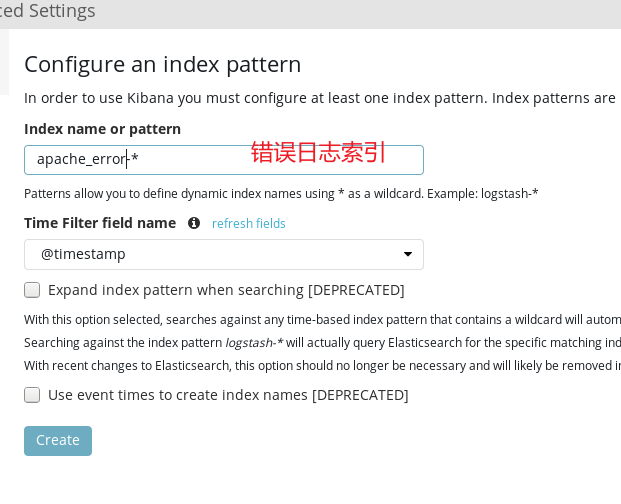

5.6 浏览器访问

浏览器访问http://192.168.122.10:9100查看索引是否创建

浏览器访问http://192.168.122.10:5601登录kibana,添加“apache_access-、*”和“apache_error-*”索引,查看日志信息。

三、ELFK(Filebeat+ELK)

1. Filebeat的作用

由于logstash会大量占用系统的内存资源,一般我们会使用filebeat替换logstash收集日志的功能,组成ELFK架构。

或用fluentd替代logstash组成EFK(elasticsearch/fluentd/kibana),由于fluentd是由Go语言开发的,一般在K8S环境中使用较多。

2. ELFK工作流程

(1)filebeat将日志收集后交由logstash处理

(2)logstash进行过滤、格式化等操作,满足过滤条件的数据将发送给ES

(3)ES对数据进行分片存储,并提供索引功能

(4)kibana对数据进行图形化的web展示,并提供索引接口

3. ELFK的部署

3.1 服务器配置

| 服务器 | 配置 | 主机名 | ip地址 | 主要软件部署 |

|---|---|---|---|---|

| node1节点 | 2C/4G | node1 | 192.168.122.10 | ElasticSearch、Kibana |

| node2节点 | 2C/4G | node2 | 192.168.122.11 | ElasticSearch |

| apache节点 | - | apache | 192.168.122.12 | Logstash、Apache |

| filebeat节点 | - | filebeat | 192.168.122.13 | Filebeat |

| 在ELK的基础上,增加一台filebeat服务器,因此只需再前述ELK部署的前提下进一步操作。 |

3.2 服务器环境

filebeat节点

[root@localhost ~]# hostnamectl set-hostname filebeat

[root@localhost ~]# su

[root@filebeat ~]# systemctl stop firewalld

[root@filebeat ~]# systemctl disable firewalld

[root@filebeat ~]# setenforce 0

3.3 安装filebeat

filebeat节点

[root@filebeat ~]# cd /opt

[root@filebeat opt]# rz -E

rz waiting to receive.

[root@filebeat opt]# tar zxvf filebeat-6.2.4-linux-x86_64.tar.gz

[root@filebeat opt]# mv filebeat-6.2.4-linux-x86_64 /usr/local/filebeat

3.4 修改filebeat主配置文件

filebeat节点

[root@filebeat opt]# cd /usr/local/filebeat/

[root@filebeat filebeat]# cp filebeat.yml filebeat.yml.bak

[root@filebeat filebeat]# vim filebeat.yml

filebeat.prospectors:

##21行,指定log类型,从日志文件中读取消息

- type: log

##24行,开启日志收集功能,默认为false

enabled: true

##28行,指定监控的日志文件

- /var/log/*.log

##29行,添加收集/var/log/messages

- /var/log/messages

##31行,添加以下内容,注意格式

fields:

service_name: filebeat

log_type: log

service_id: 192.168.122.13

#-------------------------- Elasticsearch output ------------------------------

该区域内容全部注释

#----------------------------- Logstash output --------------------------------

##157行,取消注释

output.logstash:

##159行,取消注释,指定logstash的IP和端口号

hosts: ["192.168.122.12:5044"]

[root@filebeat filebeat]# ./filebeat -e -c filebeat.yml

#启动filebeat,-e记录到stderr并禁用syslog /文件输出,-c指定配置文件

3.5 在logstash组件所在节点(apache节点)上新建一个logstash配置文件

[root@apache ~]# cd /etc/logstash/conf.d/

[root@apache conf.d]# vim logstash.conf

input {

beats {

port => "5044"

}

}

output {

elasticsearch {

hosts => ["192.168.122.10:9200", "192.168.122.11:9200"]

index => "%{[fields][service_name]}-%{+YYYY.MM.dd}"

}

stdout {

codec => rubydebug

}

}

[root@apache conf.d]# /usr/share/logstash/bin/logstash -f apache_log.conf

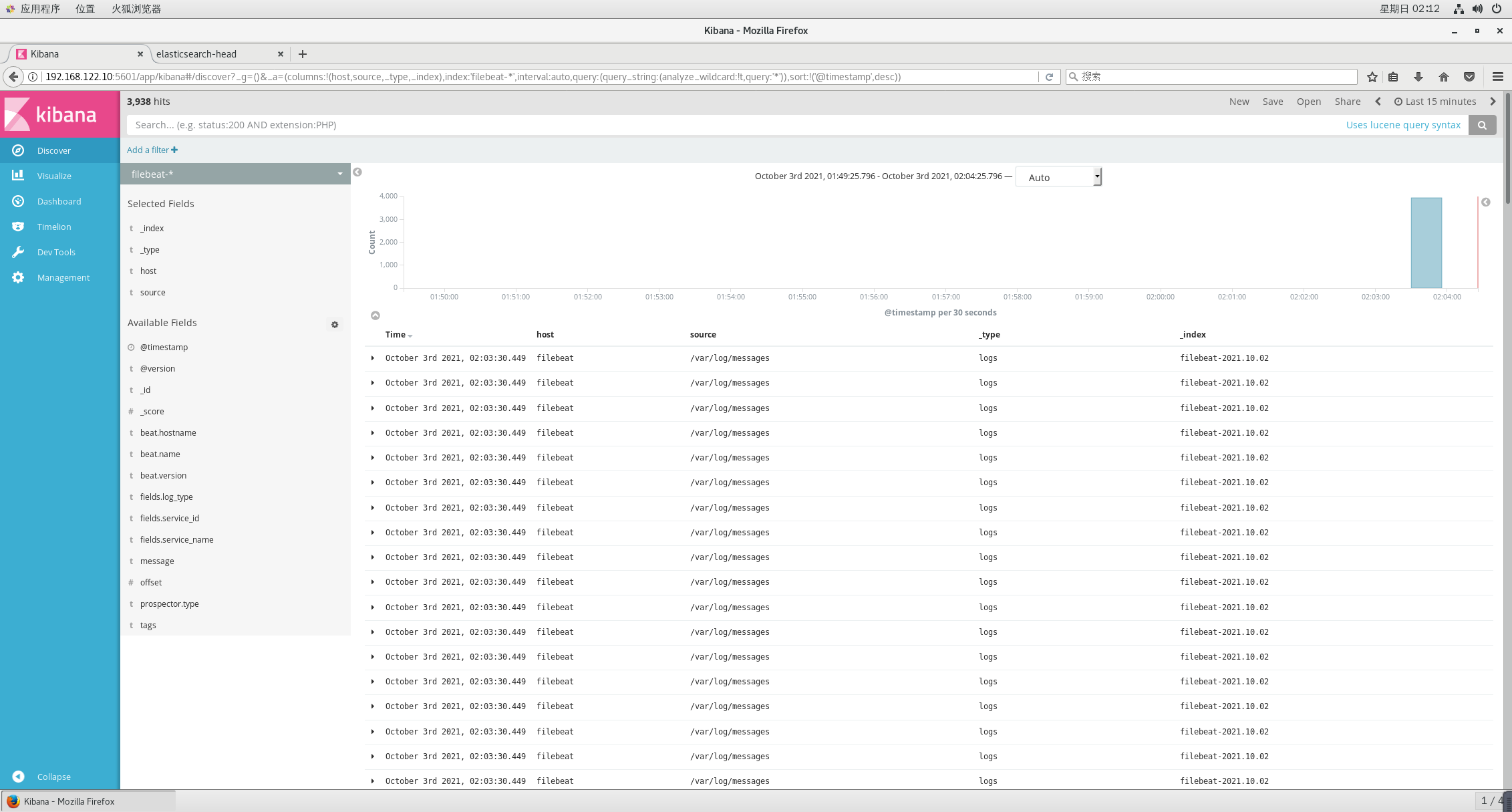

3.6 浏览器验证

浏览器访问http://192.168.122.10:5601登录kibana,

添加“filebeat-*”索引后在“Discover”中查看filebeat日志收集情况。

ELK、ELFK企业级日志分析系统的更多相关文章

- centos7搭建ELK开源实时日志分析系统

Elasticsearch 是个开源分布式搜索引擎它的特点有分布式零配置自动发现索引自动分片索引副本机制 restful 风格接口多数据源自动搜索负载等. Logstash 是一个完全开源的工具他可以 ...

- 项目实战14—ELK 企业内部日志分析系统

一.els.elk 的介绍 1.els,elk els:ElasticSearch,Logstash,Kibana,Beats elk:ElasticSearch,Logstash,Kibana ① ...

- 项目实战14.1—ELK 企业内部日志分析系统

本文收录在Linux运维企业架构实战系列 一.els.elk 的介绍 1.els,elk els:ElasticSearch,Logstash,Kibana,Beats elk:ElasticSear ...

- ELK大流量日志分析系统搭建

1.首先说下EKL到底是什么吧? ELK是Elasticsearch(相当于仓库).Logstash(相当于旷工,挖矿即采集数据).Kibana(将采集的数据展示出来)的简称,这三者是核心套件,但并非 ...

- ELK系列--实时日志分析系统ELK 部署与运行中的问题汇总

前记: 去年测试了ELK,今年测试了Storm,最终因为Storm需要过多开发介入而放弃,选择了ELK.感谢互联网上各路大神,目前总算是正常运行了. logstash+elasticsearch+ki ...

- ELK 企业内部日志分析系统

生产环境配置 亿级规模,建议64G内存+8核CPU ES JVM占用一半内存 生产环境的3节点的集群 https://blog.csdn.net/xuduorui/article/details/79 ...

- Docker笔记(十):使用Docker来搭建一套ELK日志分析系统

一段时间没关注ELK(elasticsearch —— 搜索引擎,可用于存储.索引日志, logstash —— 可用于日志传输.转换,kibana —— WebUI,将日志可视化),发现最新版已到7 ...

- ELK+Kafka集群日志分析系统

ELK+Kafka集群分析系统部署 因为是自己本地写好的word文档复制进来的.格式有些出入还望体谅.如有错误请回复.谢谢! 一. 系统介绍 2 二. 版本说明 3 三. 服务部署 3 1) JDK部 ...

- [原创]ubuntu14.04部署ELK+redis日志分析系统

ubuntu14.04部署ELK+redis日志分析系统 [环境] host1:172.17.0.4 搭建ELK+redis服务 host2:172.17.0.3 搭建logstash+nginx服务 ...

随机推荐

- Ranger-Hdfs插件安装

Ranger-Hdfs插件ranger-0.6.0-hdfs-plugin安装到Hdfs的所有NameNode节点, 其他的DataNode节点不需要安装. 1. 登陆hdfs安装的用户,hdfs/z ...

- Python多线程、线程池及实际运用

我们在写python爬虫的过程中,对于大量数据的抓取总是希望能获得更高的速度和效率,但由于网络请求的延迟.IO的限制,单线程的运行总是不能让人满意.因此有了多线程.异步协程等技术. 下面介绍一下pyt ...

- Sentine熔断降级进阶

sentinel和springCloud整合 减少开发的复杂度,对大部分的主流框架,例如:Web Servlet.Dubbo.Spring Cloud.gRPC.Spring WebFlux.Reac ...

- 【Java】main方法的理解

main方法的理解 main()方法作为程序的入口 main()方法也是一个普通的静态方法 main()方法可以作为我们与控制台交互的方式.(之前:使用Scanner) main方法中的参数args就 ...

- 【C++】类-基础知识

类-基础知识 目录 类-基础知识 1. 语法定义 2. 类的实现 3. 三个基本的函数 3.1 构造函数 功能 形式 调用时机 默认构造函数 3.2 复制构造函数 功能 形式 调用时机 3.3 析构函 ...

- 配置vscode的C++环境Unexpected GDB output from command "-environment-cd

原因 中文字符 换成D盘目录下以后.

- Centos 7 安装LAMP以及在Apache上安装positiveSSL。

简介 LAMP(linux , Apache, mysql , php)是集成动态网站经常使用的一套开源软件,实际包含linux操作系统,Apache web服务器,mysql(mariadb 分支) ...

- 《手把手教你》系列技巧篇(六十)-java+ selenium自动化测试 - 截图三剑客 -中篇(详细教程)

1.简介 前面我们介绍了Selenium中TakeScreenshot类来截图,得到的图片是浏览器窗口内的截图.有时候,只截浏览器窗口内的图是不够的,而且TakeScreenshot截图只针对浏览器的 ...

- vue3源码node的问题

下载vue3源码后,下载依赖时,node的版本需要在10.0.0以上,并且不同的vue3里面的插件的配置对版本依赖还不同,14.0.0以上的版本基本都不支持win7了, win7系统可以安装12.0. ...

- lua之自索引

Father={ a=100, b=200 } function Father:dis() print(self.a,self.b) end Father.__index=Father Son= { ...